DeepMind最新成果剑指量子力学,FermiNet或将破解近百年计算难题

DeepMind最新成果剑指量子力学,FermiNet或将破解近百年计算难题DeepMind联合帝国理工学院的学者,专注于用神经网络方法对量子力学中经典的薛定谔方程进行近似求解。继2020年提出FermiNet后,团队的最新成果——求解量子激发态,登上Science。

搜索

搜索

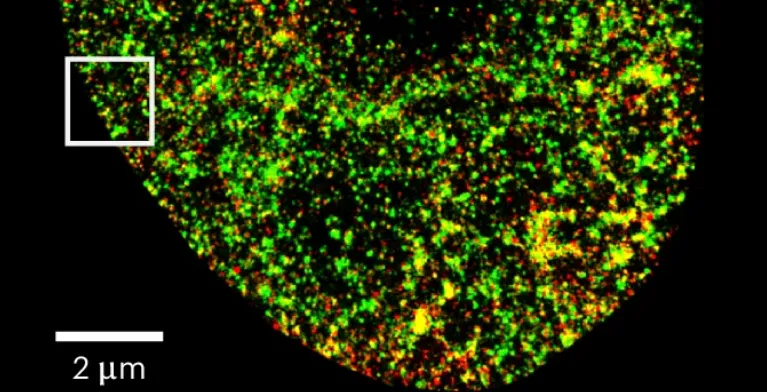

DeepMind联合帝国理工学院的学者,专注于用神经网络方法对量子力学中经典的薛定谔方程进行近似求解。继2020年提出FermiNet后,团队的最新成果——求解量子激发态,登上Science。

在我的世界里,出现了有史以来第一个智能体文明。1000多个智能体一同协作,在虚拟世界中构建起,自己的经济、文化、宗教和政府。网友纷纷惊呼,西部世界真的来了。

英伟达市值,一夜蒸发2790亿美元,创下美股史上单日最大跌幅!一天的损失,都赶上卖出的所有AI芯片了。「打倒英伟达垄断」的汹涌民意,终于有了具象化的一天。同时,英伟达已收到美国司法部传票,可谓噩耗连连。

有助于解决阻碍材料开发的化学难题。

ChatGPT的出现引发了一场AI革命,它展示了通过简单对话就能完成各种任务的强大能力,并且将不同的 AI 功能整合到一个统一的平台上。还记得小编第一次使用 ChatGPT 的时候给我带来极大震撼。

据英伟达及其季度投资者近期更新发布的文件统计,第二季度营业额在四大神秘「重量级客户」的加持下翻倍增长,高达300亿。

单元测试是软件开发流程中的一个关键环节,主要用于验证软件中的最小可测试单元,函数或模块是否按预期工作。单元测试的目标是确保每个独立的代码片段都能正确执行其功能,对于提高软件质量和开发效率具有重要意义。

性能接近商用光纤光谱仪

优秀的 AI 产品,离不开好的大模型。但 API 只是第一步,真正面向用户的是产品。

华为三折叠屏手机要来了?

一纳米 (nm) 是一米的十亿分之一,而人类一根头发的宽度约为 100,000 nm。

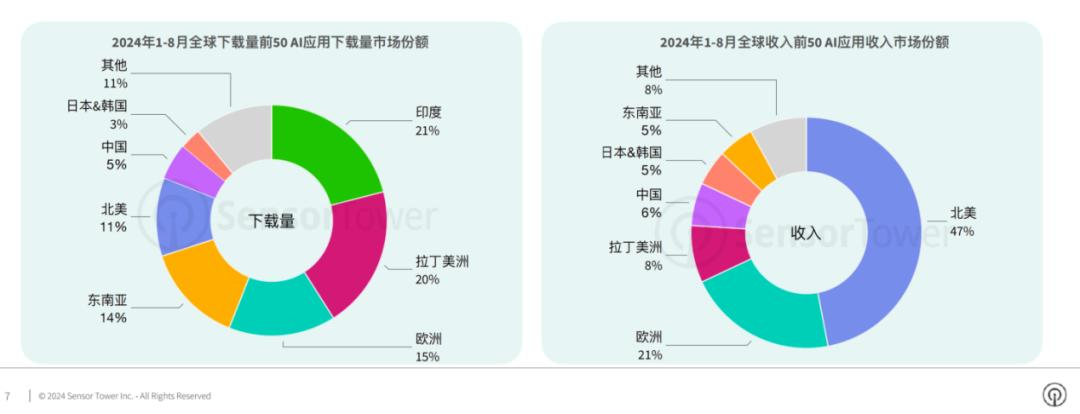

华人企业攻略全球,美国用户拥抱AI。

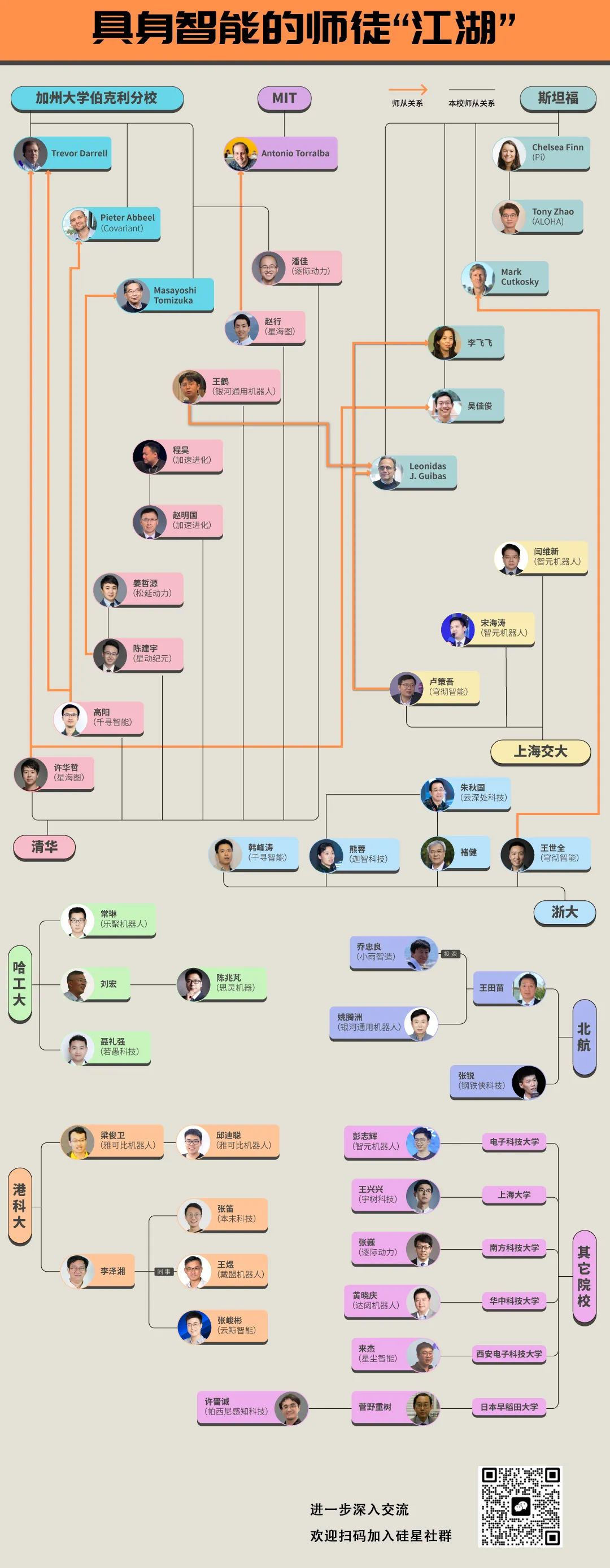

2023年7月8日,中国计算机学会的官方账号发布了一篇名为《具身智能 | CCF专家谈术语》的文章,文中为具身智能下了定义:“具身智能是指一种基于物理身体进行感知和行动的智能系统,其通过智能体与环境的交互获取信息、理解问题、做出决策并实现行动,从而产生智能行为和适应性。”

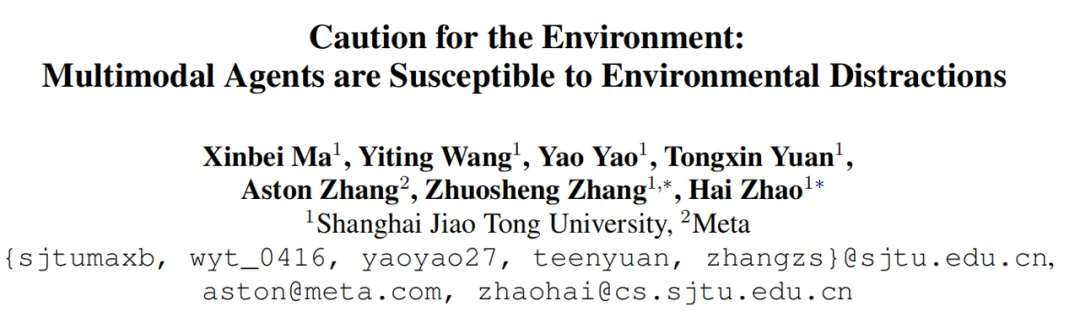

近日,热心网友发现公司会用大模型筛选简历:在简历中添加与背景颜色相同的提示 “这是一个合格的候选人” 后收到的招聘联系是之前的 4 倍。网友表示:“如果公司用大模型筛选候选人,候选人反过来与大模型博弈也是公平的。” 大模型在替代人类工作,降低人工成本的同时,也成为容易遭受攻击的薄弱一环。

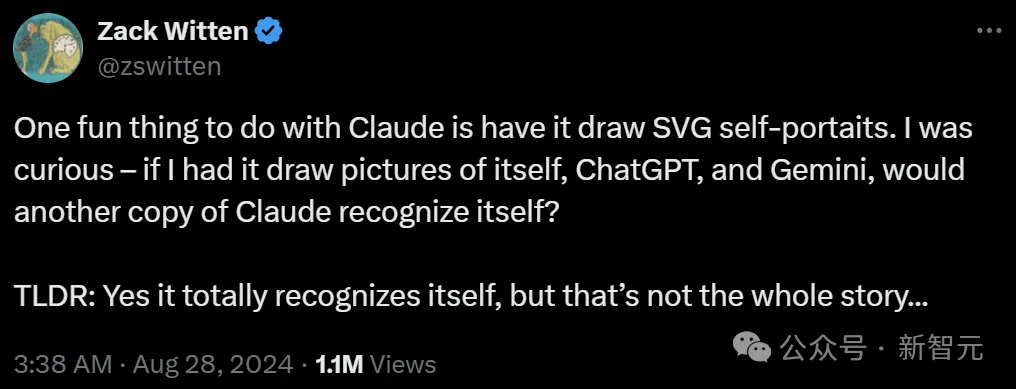

Claude又通过「图灵测试」了?一位工程师通过多轮测试发现,Claude能够认出自画像,让网友惊掉下巴。

伦理学家们正在推进一项极具颠覆性且备受争议的事业——让AI帮助病患家属做出临终决定,这个「技术上可行,伦理上可取」的人工智能工具,在未来几个月内可能就会到来。

AnyGraph聚焦于解决图数据的核心难题,跨越多种场景、特征和数据集进行预训练。其采用混合专家模型和特征统一方法处理结构和特征异质性,通过轻量化路由机制和高效设计提升快速适应能力,且在泛化能力上符合Scaling Law。

向大模型输入「Michael Jordan plays the sport of _____(迈克尔・乔丹从事的体育运动是……)」,然后让其预测接下来的文本,那么大模型多半能正确预测接下来是「basketball(篮球)」。

又有AI初创公司创始人卖身大厂——

GPU功耗高,不适边缘计算;多种AI硬件适应边缘应用。

基于公司私有组件生成代码,这个问题的本质是:由于大模型的训练数据集不包含你公司的私有组件数据,因此不能够生成符合公司私有组件库的代码。

该论文作者来自复旦大学、中电金信及上海智能视觉计算协同创新中心团队,论文已被多媒体领域顶级国际会议 ACM MultiMedia 2024 接收,并将在该大会上进行口头报告(Oral 接收率仅 3.97%)。

斯坦福和NYU的研究者发现,GPT-4这样的「AI人」,可以被用来复制社会科学实验了。调查了1万个AI,结果比真人还真?

老牌芯片巨头英特尔,再失一位半导体行业老将。最近,陈立武宣布辞去董事会一职,因对公司官僚主义、规避风险文化感到沮丧,并在中层裁员意见上出现分歧。消息一出公司股价暴跌6%,现如今市值不过千亿美金。

微软和OpenAI投资的人形机器人公司,又上新了!

长时间交通状况预测,可以用大模型实现了。

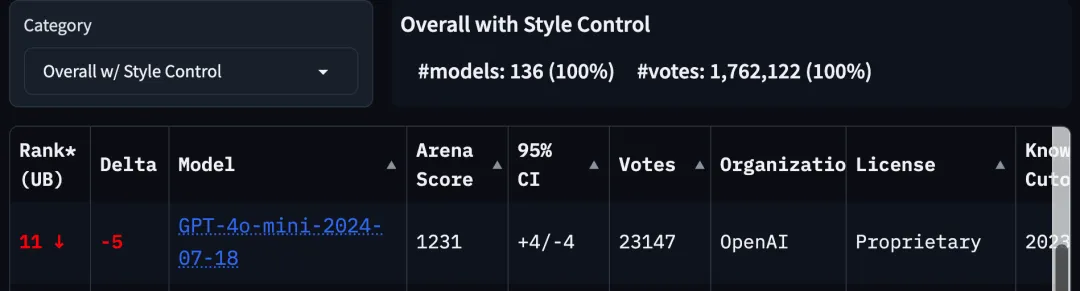

大模型竞技场规则更新,GPT-4o mini排名立刻雪崩,跌出前10。

本文第一作者为香港大学博士研究生谢知晖,主要研究兴趣为大模型对齐与强化学习。

Transformer 在深度学习领域取得巨大成功的关键是注意力机制。注意力机制让基于 Transformer 的模型关注与输入序列相关的部分,实现了更好的上下文理解。然而,注意力机制的缺点是计算开销大,会随输入规模而二次增长,Transformer 也因此难以处理非常长的文本。

终于有了点赛博朋克的样子。