当甄嬛传、让子弹飞全都转英文,会怎样?

小红书经常刷到这种视频,然后英语就这么丝滑地经过我的脑子。

现在,AI就可以搞定!就像这样。

不仅符合原版的音色和情感,还能保证唇形同步。

很好, 以后再不需要看小红书麻烦配音老师来教我英语了(Doge)。

而这次出手的,正好是那个创造诸多魔性视频的B站。真是好你个B站。

他们发布的TTS模型IndexTTS2,在社区引发不少的关注。

网友表示:已经迫不及待地想用它来做搞笑视频了。

它最大的亮点,就在于在实现时长控制的同时,还能再现符合Prompt的情感特征。

它支持两种生成方式。

一种是明确token数量,以精准控制时长。

比如原音频是这样:

要求替换成的文本是只有当科技为本地社群创造价值的时候,才真正有意义。

那么控制它的时长分别为原来的0.75倍、1倍(原速)、1.25倍。效果是这样的。

另一种是无需手动输入,自动生成语音,同时保留输入提示的韵律特征。

比如生气的情感。

指定替换文本:你在我们屋里走路的时候,发现了一条遥远的路,这是不够奇怪的。

此外还支持音频和情绪表达独立控制。

不同的音频提示可以分别作为音色和情绪表达的参考,也可以用描述性的文本也能用来情绪参考,同时保持音色不变。

比如像「我感觉很沮丧」、「巨巨巨巨巨巨难过」、「有点快乐」……这种描述。

「巨巨巨巨巨巨难过」之后,声音就变成了这样。

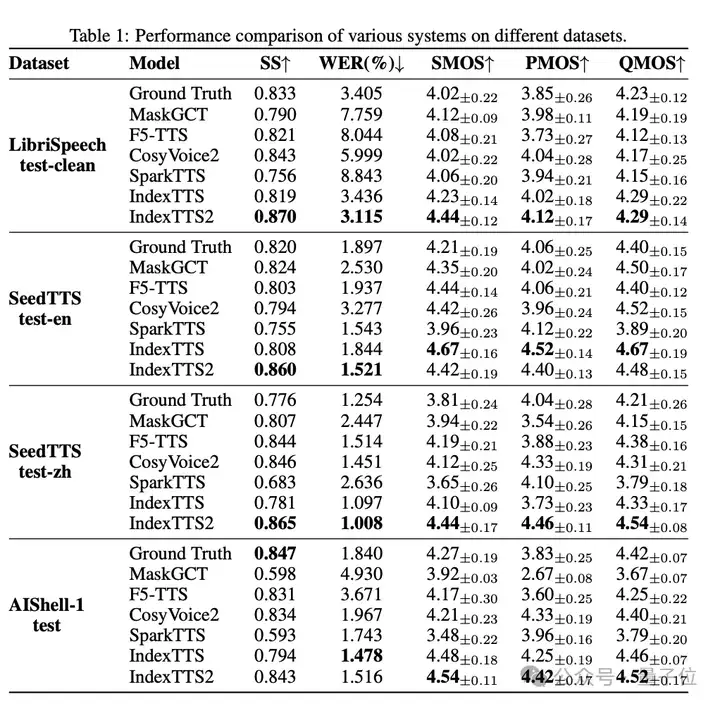

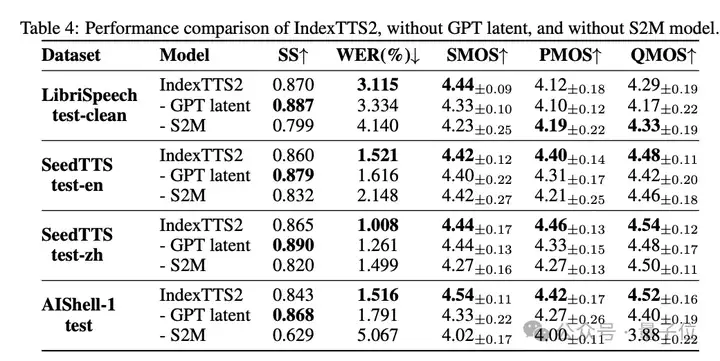

结果他们使用常见测试集,包括 LibriSpeech-test-clean、SeedTTS test-zh、SeedTTS test-en和AIShell-1 test对IndexTTS2模型以及其他代表性模型进行了评估,

可以看到,除了AIShell-1 test测试外,其他评测都实现了SOTA。

在 AIShell-1 测试中,IndexTTS2 在 SS 方面仅落后于Ground Truth 0.004,在WER方面仅比IndexTTS差0.038%。

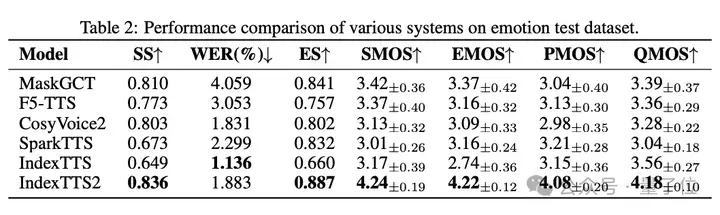

而在情感性能比较上,IndexTTS2也实现了情感表达和文本准确性上面的双重SOTA。字词错误率(WER)仅为1.883%。

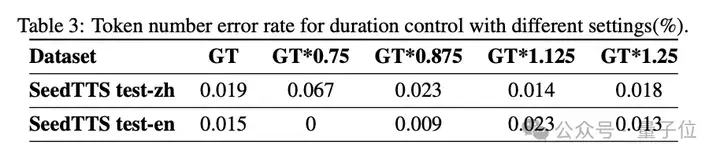

在时长控制的准确性上,可以看到指定市场的Token数错误均小于0.02%。

此外,他们还进行了两组消融实验,以验证各个模块的贡献:删除GPT潜在表征;删除S2M模块。

GPT潜在表征它在语音的发音和清晰度方面发挥了重要作用,删除它会导致所有数据集上指标下降,

用MaskGCT的S2A模块(针对离散声标记)替换S2M模块,结果发现在表明情感保真度和语音准确度都有所下降,以及合成质量上也有所下降。

这意味着,S2M模块大大提高了合成语音的保真度和感知自然度。

文本转语音 (TTS) 模型通常分为自回归系统和非自回归系统。

虽然自回归系统在语音自然度方面表现出一定优势,但其逐个 token 的生成机制使其难以精确控制合成语音的时长。

这在视频配音等需要严格音视频同步的应用中是一个关键限制。

据介绍,IndexTTS2是首个将精确时长控制和自然时长生成相结合的自回归零样本TTS模型。

在这之前,B站团队还曾发布过1.0和1.5版本。

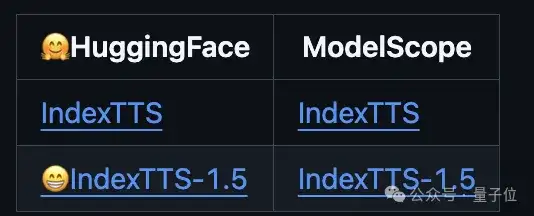

IndexTTS2由三个核心模块组成:

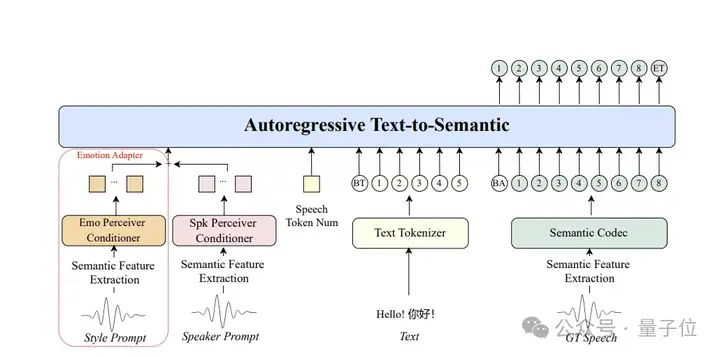

文本到语义(T2S)、语义到语音(S2M)和BigVGANv2 声码器。

T2S使用源文本、风格提示、音色提示以及可选的语音token数字作为输入,生成语义token。

最后,BigVGANv2将旋律谱图转换为目标语音波形。

具体看T2S任务,团队将其表述为自回归语音Token预测任务。

他们采用与传统大语言模型相同的训练方法,即预测下一个Token。不过不同的是,他们引入了两个关键创新:时常控制和情感控制。

情感适配器(红色虚线)用于从风格提示中提取情感特征,然后将其作为文本到语义流程的输入,以重建情感。

在第一阶段,团队使用基于 Conformer 的情绪感知器条件器(emo perceiverconditioner),它用于从风格提示中提取情绪嵌入,专门对情绪数据进行训练。

为了将特定情感信息与说话者的相关属性(如口音、节奏)区分开来,团队还引入了梯度反转层。

在训练过程中,风格提示源于真实语音;在推理过程中,风格提示可被情感参考音频所替代,该音频可能来自不同的说话者。

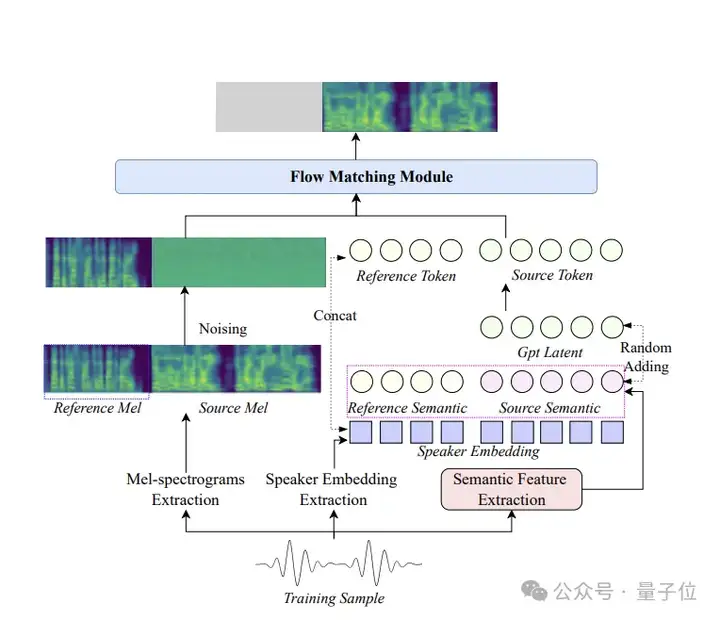

再来看基于流匹配的S2M模块,它结合GPT潜在表征来提升语音稳定性。

这一过程需以音色参考音频为条件,并融合T2S模块生成的语义编码。针对深度情感演绎时易出现的发音含糊问题,本阶段采用双重解决策略:其一是对BERT模型提取的文本表征进行帧级对齐后作为辅助输入;其二是将T2S模块的GPT潜在特征作为补充信息。

不过话说回来,最近B站被曝出正在加速推进视频播客战略。

什么意思呢?

就是用一种「能看」就不用「听」的播客。

与此同时,内部还启动了代号为「代号H」的AI创作工具的同步研发。

没准儿,这个IndexTTS2就是他们代号H中的一环呢。

参考链接:

https://www.reddit.com/r/LocalLLaMA/comments/1lyy39n/indextts2_the_most_realistic_and_expressive/

https://arxiv.org/abs/2506.21619

https://arxiv.org/abs/2502.05512

https://index-tts.github.io/index-tts2.github.io/

https://github.com/index-tts/index-tts2.github.io

文章来自于“量子位”,作者“白交”。

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales