大模型也能“通人情”?

行业首个社交大模型全景解析:既能兼顾社交理解与平台规则,又能洞察理解用户。

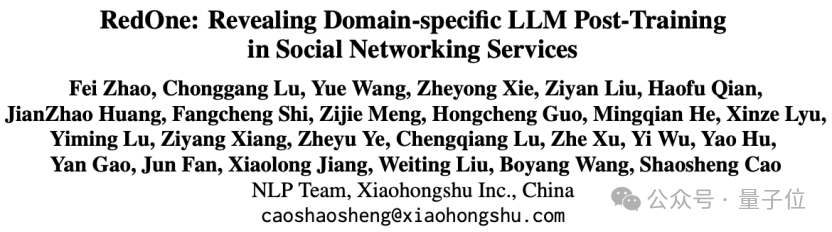

小红书重磅推出RedOne——一款面向SNS(社交网络服务)领域的定制化LLM,旨在突破单一任务基线模型的性能瓶颈,并且构建全面覆盖SNS任务的基座模型。

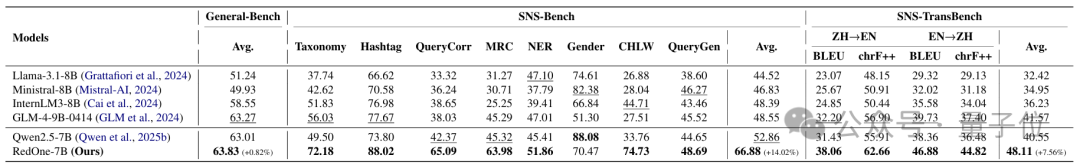

相较于基础模型,RedOne在8个主要的SNS任务上平均提升14.02%,在SNS双语评测基准上提升7.56%。同时,在线上测试中,相较于单任务微调的基线模型,RedOne将有害内容检测(Harmful Content Detection)中的曝光率降低11.23%,将浏览后搜索(Post-view Search)中的点击页面率提升14.95%。

△图1:不同模型在SNS领域上的平均表现

随着在线平台和移动应用的高速发展,SNS成为当前信息传播的核心载体,覆盖着交流沟通、知识分享、情感表达等多元场景。然而,SNS的数据与通用领域的文本语料又呈现出截然不同的特征:

1)高度非规范化:缩写、谐音梗、跨语种表达层出不穷;

2)强上下文依赖:同一句话在不同话题或社群文化中意义迥异;

3)显著情绪化:用户情感张力随热点事件剧烈波动。

因此,多元的场景叠加复杂的数据,不仅带来语言形式的极端多样化、用户角色的频繁切换,还伴随着隐性而微妙的对话规范,使依赖传统自然语言处理(Nature Language Processing, NLP)的平台内容管理和交互质量优化面临前所未有的挑战。

面对上述SNS的治理困境,社区开始尝试引入LLM寻求突破,但大多聚焦于单一任务层面。这一方面导致了同一场景内Data Scaling Law的边际收益呈现递减并逐渐消失的趋势,另一方面难以在多语言、多文化、多任务的真实场景中灵活迁移。

这一现象的根源在于:当前SNS领域专用模型的训练过程无法充分学习多元领域知识,导致性能触顶、泛化失灵,无法满足平台内容治理、交互质量优化等现实中的迫切需求。

因此,研究团队重磅推出RedOne——首款全面覆盖SNS各种场景的定制化LLM。

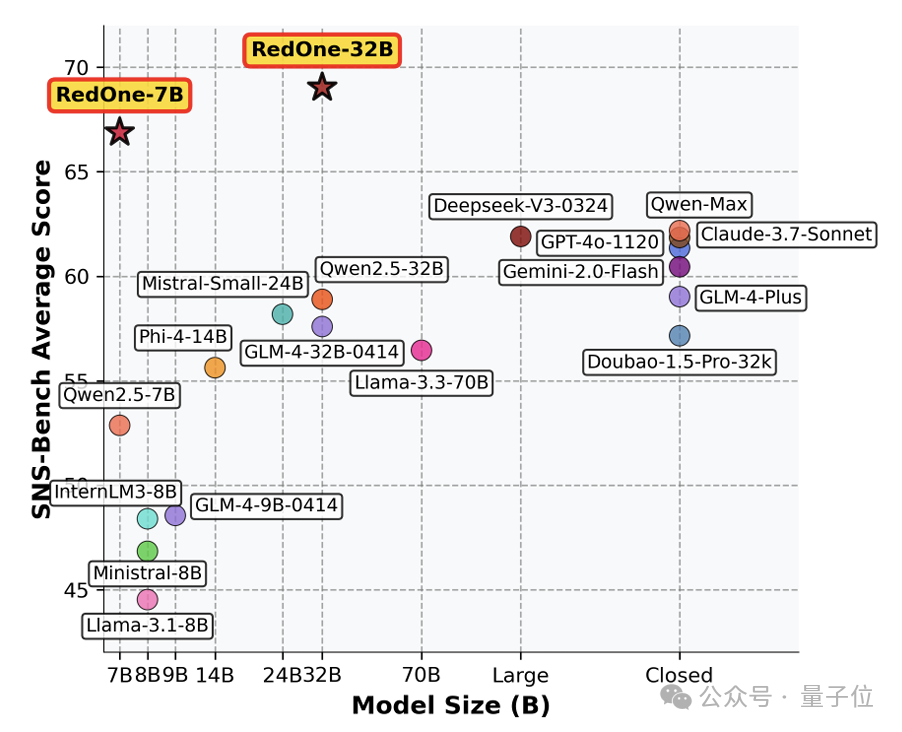

依托超大规模的真实数据,RedOne采用“继续预训练(CPT)→ 监督微调(SFT)→ 偏好优化(PO)”的三阶段训练策略:先注入社交文化知识基础,再强化多元任务能力,最终对齐平台规范和人类偏好,让模型“既懂社交、又懂规则、更懂用户”。

△图2:RedOne的训练框架

为了给LLM注入SNS领域的基础知识,研究人员开展了分为三个子阶段的CPT:数据收集与构建、数据筛选与混合、以及领域继续预训练。

数据收集与构建

研究者从以下两个来源收集所需的数据:

1) 通用高质量数据。他们选择了若干高质量的开源预训练语料库,以保持模型的基本泛化能力,并且为了提高训练效率,他们将所有通用数据统一构建为单句文本格式,并根据预定义的文本长度阈值进行分割和拼接处理。

2) SNS领域数据。他们从社交网络平台和开放网页收集了大规模的训练数据,涵盖了多种社交沟通模式,包括非正式讨论、短评论、讽刺语句、情绪化内容等,并且为了更好地学习预训练数据中的潜在信息,他们结合了用户互动数据来指导训练过程。具体来说,他们将上下文与其对应的用户互动数据进行分组,这样可以自然地聚类语义相关的SNS内容,无需额外的处理。

结合以上两种预料,他们构建了一个包含超过千亿tokens的大规模数据集,为后续的任务处理打下基础。

数据筛选与混合

考虑到数据质量对模型训练至关重要,他们精心设计了一个数据筛选流程,包含面向任务的规则筛选和基于小型LLM的筛选。前者主要识别HTML标签、重复语句等错误内容,后者则关注全文一致性和语气适当性等评价角度。

此外,他们又应用了RegMix方法来识别最优的数据混合分布并筛除不必要的数据。最终,他们构建了一个包含200亿tokens的高质量数据集供训练使用。

领域继续预训练

通过以上的数据收集、构建、筛选与混合,他们得到了一个全面覆盖SNS领域的超大规模高质量数据集,以指导领域继续预训练。具体来说,他们基于Qwen2.5的开源模型继续训练,并使用相同的配置参数,充分发挥其在多个领域的强大能力。

通过这一领域特定的继续预训练过程,他们最终获得了一个能够有效捕捉SNS特有语言模式的模型,同时保持了通用语言建模能力的最小衰减。

为了弥合预训练目标与实际应用需求之间的差距,他们精心设计了以下的SFT任务。

任务定义与数据构建

SFT训练数据对模型在领域任务中的最终指令跟随能力具有重要影响。为此,他们整理了大量的生成内容,包括笔记、评论和互动信息等,以期通过源于真实环境的信号来改善模型的决策行为。

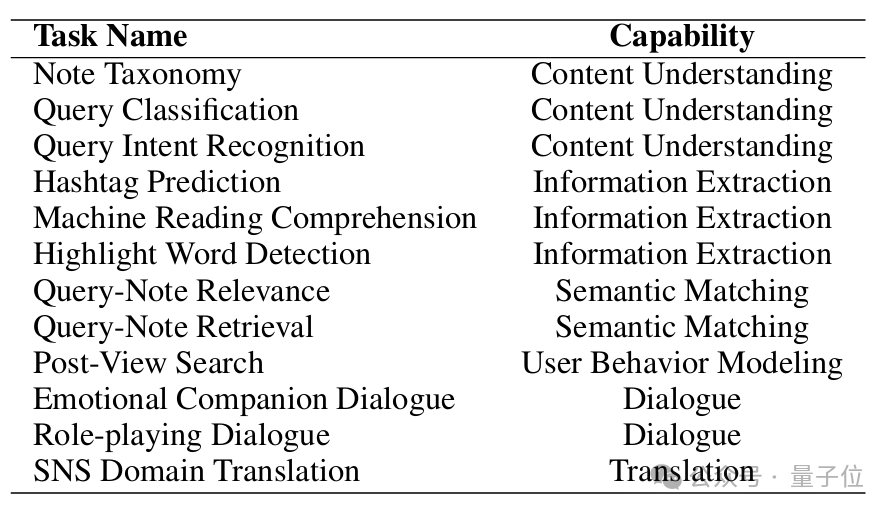

△表1:SNS任务和能力的映射

特别在数据整理过程中,他们着重保留了具有典型SNS特征的语言风格,以确保数据在 SNS 场景中的代表性和实用性。在这之后,他们整合得到SNS应用所需的六项核心能力:内容理解、信息提取、语义匹配、用户行为建模、对话和角色模拟、以及翻译能力,并将每项能力映射到具体任务上,以对齐现实世界中的挑战,如上图所示。

此外,在SFT过程中,他们还引入了开源的通用领域指令数据,以缓解模型的灾难性遗忘,保持良好的泛化能力。

双步训练

在领域特定的SFT中,双步混合微调已被证明能够有效增强领域特定能力。

对于RedOne,他们第一步使用结合大规模通用数据的完整SNS数据集对模型进行训练,使模型能够学习SNS领域内多样化的任务格式,同时保持其通用能力;第二步,他们将SNS领域数据比例提高,进一步精调模型,显著提升其在领域关键任务上的表现。

在SNS场景中,像查询-笔记相关性建模这样的任务常常会生成多个合理但质量差异较大的输出。虽然SFT能够改善指令跟随能力,但它未能充分利用这些候选输出中的隐性偏好信号,导致过拟合和泛化能力不足。

为了克服这一局限,研究人员精心构建了偏好数据集,并通过直接偏好优化(Direct Preference Optimization,DPO)进一步提升模型的领域适应能力。

偏好数据构建

为了更好地与人类偏好对齐并利用数据标签中蕴含的信息,他们根据不同任务类型的特点,采用了不同的偏好对构建策略。具体来说,他们将数据分为两类,并针对每类任务采取不同的策略:

1) 主观任务。对于情感对话和角色扮演等主观任务,他们的主要目标是实现与人类偏好对齐。因此,他们首先邀请领域专家对模型生成的回应进行偏好标注,然后训练与人类偏好能够匹配的判别模型,最后利用这些判别模型扩展特定数据。

2) 客观任务。对于答案明确的客观任务,他们的目标则侧重于提取并利用数据标签中的隐性结构信息。具体来说,他们采用了两种方法:首先利用问题本身包含正确答案和错误选项的内在结构来构建偏好对;其次结合模型生成的答案和真实标签构建偏好对,以针对模型的特定不足进行优化。

通过整合以上的定制化方法,他们系统性地处理了所有数据,构建了能够有效捕捉人类偏好和隐性数据信息的偏好优化数据集,为模型性能的进一步提升打下基础。

直接偏好优化

为了充分利用偏好数据集中的丰富信号,他们采用DPO作为基于偏好的微调算法,使模型能够更好地与平台规则和人类偏好对齐,同时充分挖掘真实标签中蕴含的潜在信息。

△表2:7B规模LLM对比实验

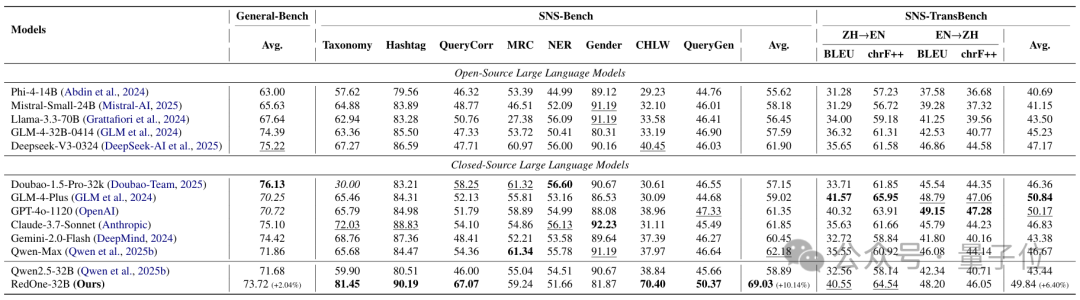

△表3:32B规模LLM对比实验

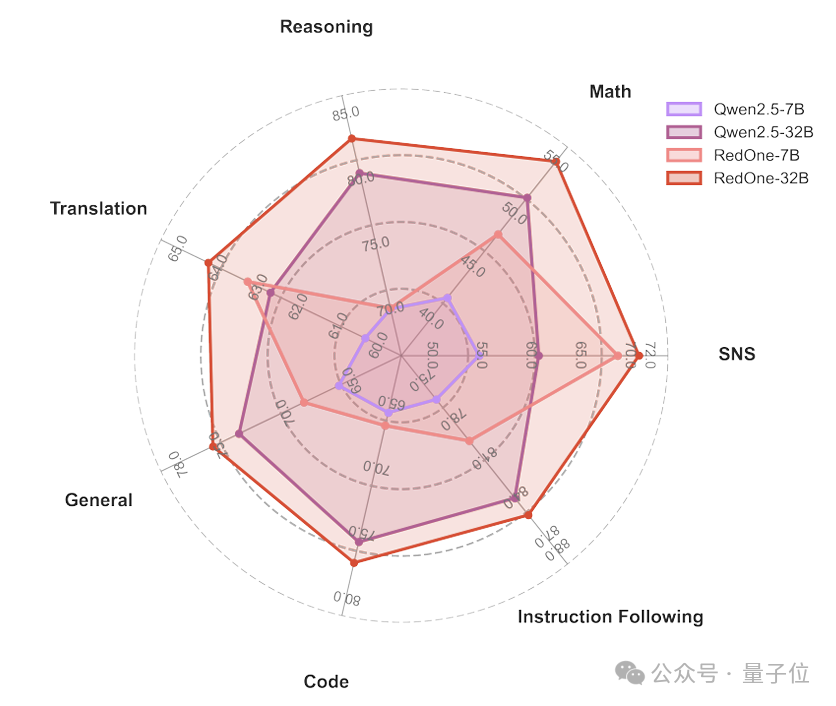

△图3:RedOne与基础模型的对比

他们在多个通用和SNS领域任务上对RedOne和各种开闭源模型进行了全面对比,如表2和表3所示。同时,他们还对比了RedOne与其基座模型(Qwen2.5)在六种通用和SNS任务维度上的表现,如图3所示。

可以看到,RedOne不仅在通用任务中保持优异的表现,甚至在部分任务上超越了其基座模型,而且在SNS领域展现了卓越的效果,甚至在大多数任务中都达到了与更大模型相当的性能。另外,RedOne随着模型规模的增加性能持续提升,表现出了巨大的潜力。

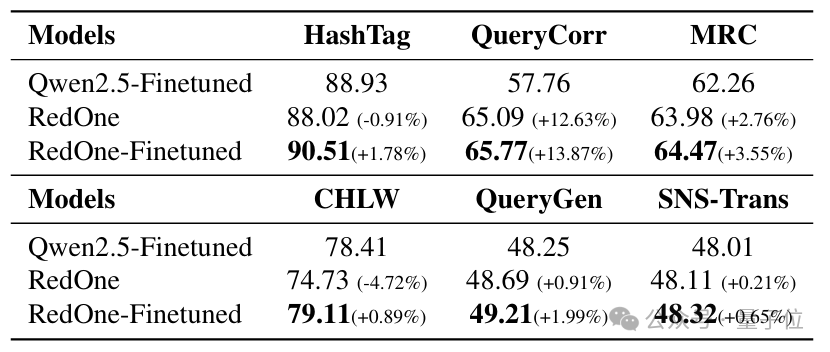

△表4:RedOne与基于任务微调模型的对比

为了进一步探讨基础模型对任务特定微调的影响,并验证RedOne的有效性,他们评估了基于基座模型Qwen2.5-7B和RedOne-7B的任务微调对比结果,如表4所示。

基于RedOne的微调(RedOne-Finetuned)在所有数据集上均超过了基于Qwen2.5的微调(Qwen2.5-Finetuned),表明领域后训练能够为下游任务特定微调提供更强的基础。同时,即使未经微调的RedOne表现也十分强劲,进一步验证了领域适配的优势。

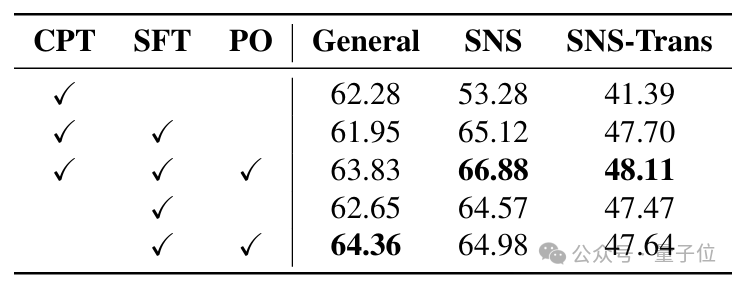

△表5:关于三阶段训练策略的消融实验结果

为量化每个训练阶段的贡献,他们进行了一系列消融实验,结果如表5所示。

引入CPT后,模型在通用任务上的表现仅出现基本可以忽略的下降,却在所有SNS任务上取得大幅提升,证明以领域数据进行CPT可有效注入社交语境知识。在CPT基础上进行SFT,模型在SNS、社交翻译等任务上性能进一步提升,说明精细的任务定义与双步混合微调策略能够有效释放模型在特定领域的潜能。最后引入PO,使模型输出更加契合平台规则与用户偏好,整体性能得到再一步提升,印证了定制偏好数据与DPO算法协同的效果。

综合来看,三阶段训练呈现“层层递进、相互增强”的正向叠加,有力保证了RedOne在通用性能几乎无损的前提下,取得SNS场景的全面领先。

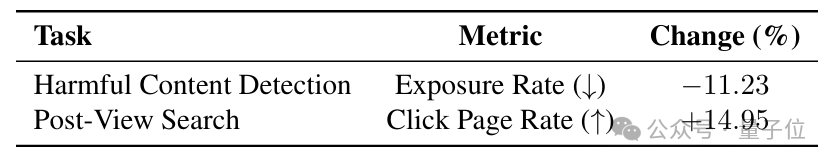

△表6:线上实验的结果

为进一步验证RedOne在真实场景中的应用价值,他们在内部的多个SNS业务线上对其落地,并与当前基于单任务微调的模型进行A/B对照,如表6所示。

结果显示:在有害内容检测中,RedOne将违规笔记曝光率降低11.23%,显著强化了平台的安全屏障;在浏览后搜索中,用户点击页面率提升14.95%,有效增强了笔记阅读后的内容发现与深度互动。

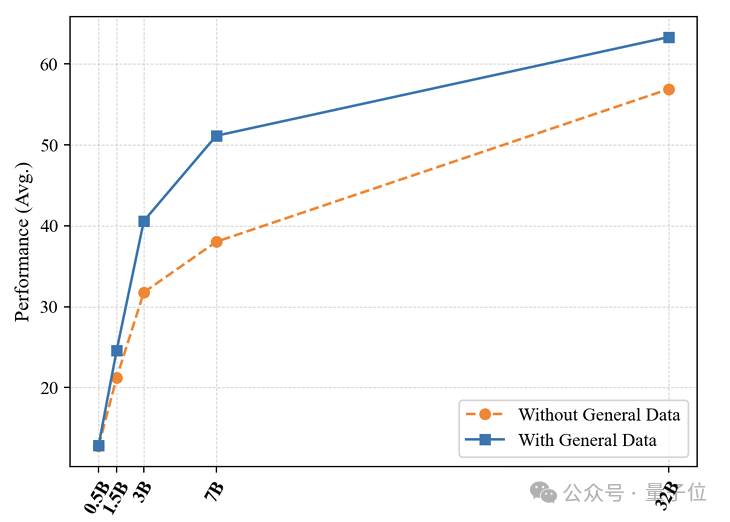

△图4:不同规模模型在OOD任务上的表现

为了评估在领域适配过程中保留通用能力的价值,他们设计了OOD鲁棒性实验,结果如图4所示。

具体来说,他们从SNS Benchmark中选取了Note Taxonomy、Note Hashtag和Note MRC三项任务来构造测试数据,其中第一项原本并不存在于训练集中,后两者在SFT阶段中被刻意移除。然后他们对比了结合通用语料和SNS数据与仅使用SNS数据两种设定下不同规模模型训练后的性能。

可以看到引入通用领域数据能够显著提升模型在OOD任务上的泛化能力,且这一优势随模型规模增大而愈发明显。这表明,在进行特定领域后训练时,适当混合通用知识不仅不会影响专业任务上的表现,反而有助于提升模型的泛化能力。

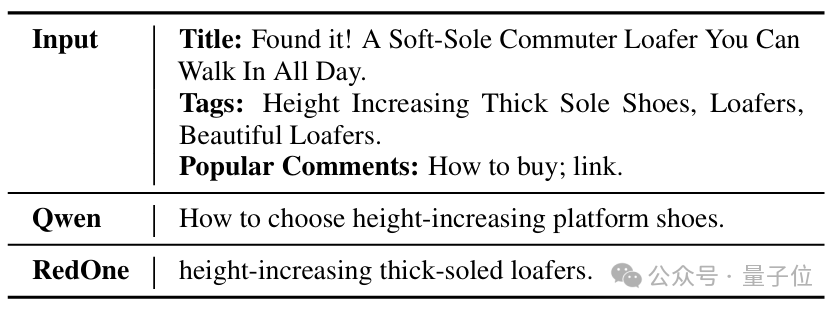

△表7:RedOne和基础模型在SNS任务中的回答示例展示

为直观展示RedOne的用户行为建模能力,他们在浏览后搜索任务上进行了案例研究,如表7所示。

输入的上下文是一条关于“增高乐福鞋”的种草笔记,具有明显的购买意向。Qwen生成了一条宽泛的购物查询,关键词笼统,难以直接定位目标商品。而RedOne则精准锁定了 “增高乐福鞋” 等核心产品词,清晰地反映了用户的需求。

SNS 的治理难和LLM的适配难为现实里如平台内容管理、交互质量优化等应用场景提出了严峻挑战。作为首个全面覆盖SNS领域的定制化LLM,RedOne通过三阶段训练策略,实现了 “懂社交、懂规则、懂用户” 的三重跃迁。

研究人员希望RedOne所采用的方法能够为后续专用垂域LLM的落地提供一定参考,同时助力社交媒体在内容治理与高质量互动的进一步探索,推动构建更可信、可控、可持续的社交网络生态。

论文链接:https://www.arxiv.org/pdf/2507.10605

文章来自于微信公众号“量子位”。