过去两年,大模型与 Agent 技术的迭代彻底改写了软件开发的工作流。

Cursor、GitHub Copilot 等工具把“写下一行代码”的自动补全能力,升级为能在 IDE 中完成重构、单测、甚至整段功能实现的协作体验,全球开发团队由此进入 AI Coding 的高增长期——最新调查显示,九成以上工程团队已在日常流程里引入 AI 编程助手。

当底层模型能力趋同,企业开始将目光聚焦在两大痛点:

孵化自北京大学软件工程研究所的 aiXcoder 正是基于这两个痛点走出差异化路线。团队自 2013 年就开始将深度学习技术应用于代码生成和代码理解领域,持续发表研究成果,并率先将深度学习模型落地为商业产品。针对企业需求,aiXcoder 既提供可落地到客户私有服务器的部署形态,又支持将企业知识库与领域数据注入模型,从而助力金融、航空航天、军工、通信等高壁垒行业显著提升软件开发效率和质量。

今年 4 月,硅心科技(aiXcoder) 进一步升级产品能力,推出 Agent 模式并内置 MCP(Model Context Protocol)功能,可让开发流程从需求拆解到应用构建实现“一条龙”自动化——官方演示展示了 Agent 通过工具链在浏览器、CI 系统与数据库间无缝联动的能力。

此背景下,CSDN将以真实项目场景为切口,观察 aiXcoder Agent 在任务闭环、智能体工具链编排及智能决策上的表现,并讨论它如何借助「私有化部署+领域化方案」在 AI Coding 赛道中形成差异化竞争力。

实测Agent链式思考推理能力:5分钟自动部署复杂项目,相较人工效率提升90%

众所周知,传统的 AI 编程助手依靠上下文预测下一行代码,顶多在函数注释后给出整段实现,它们像高阶输入法,始终等着人来喂关键词。

然而,Agent 模式的出现改变了游戏规则。

模型在执行之前先进行链式推理,形成一条思考链,再决定调用哪些外部工具,完成操作后还会自检并修正。这种闭环能力让 AI 第一次像一个真正的同事,而不仅是键盘加速器。

为了验证aiXcoder Agent“主动思考”的成色,我们选用了 GitHub 上星标超过四万的 getsentry/sentry 作为测试对象。这是一套由 Django 后端、React 前端和多种服务组件构成的完整自托管系统,复杂度足以考验 Agent 的全局推理和工具编排能力(GitHub)。

没想到的是,实验环境本身就给了它当头一棒:由于网络限制,仓库源码始终无法完整拉取。Agent 在日志中捕捉到连续超时后,没有简单报错停机,而是立即切换策略,通过 GitHub API 读取目录索引和 README 片段,开始在“信息稀缺”的黑箱里重建对项目的理解。

首先,它根据 API 返回的文件列表推断出项目核心模块的分布,锁定了 Web、Worker、Cron 和 Relay,并从片段式信息推导出 Redis、PostgreSQL、Kafka、ClickHouse 等依赖服务。随后,它又在 README 里搜到与“sentry requirements”相关的关键词,结合官方镜像仓库检索结果,给出了使用 Python 3.11 基准镜像和特定版本标签的建议。思考链完成后,Agent 输出了一份九步部署方案,从拉取镜像到健康探针校验一应俱全,并生成 Docker Compose 配置、启动脚本和本地搭建说明文档,将缺失的代码部分用脚本和容器镜像“补写”回来。

随后 Agent 给出一套从镜像拉取、环境变量生成、数据库与消息队列启动到数据迁移、服务拉起的完整部署方案,同时写出 Docker Compose 文件、启动脚本及本地验证指引。5分钟后,所有容器已就绪,登录页正常响应,整个部署闭环顺利跑通。与人工查文档、手动编排 Compose 的常规流程相比,时间成本缩减近九成;更重要的是,它在信息残缺、文档模糊的条件下依旧能产出可执行结果,体现了先推断、再求证的链式思维。

与仅靠关键词驱动的补全工具相比,Agent 的差别在于:

实验结果说明,“深度思考者”范式下的 aiXcoder Agent 已具备在陌生、甚至信息不完整的仓库里自主规划并交付可运行环境的能力,为后续的智能体工具链编排奠定了坚实基础。

前后端闭环开发实例:自主调用工具完成任务,贯穿页面、服务与数据,连测试验证都包了

事实上,真正让 AI 变成可靠的开发拍档,并不是写出一段漂亮的代码片段,而是能在一条流水线里同时驾驭包管理器、前端构建器、浏览器自动化乃至本地存储。

为此,我们设定了一个“纯前端”挑战:用 Next.js 15 的新 App Router 架构做一款简易的 Prompt 管理工具,所有数据只放在浏览器 LocalStorage,既不连后端,也不依赖云数据库。场景足够轻量,却囊括了脚手架生成、依赖安装、样式体系接入、路由配置、业务代码落盘以及 UI 自测六个环节,可以完整检验 aiXcoder Agent 在前端链路上的工具编排功底。

Next.js 15 推出后,新 App Router 与 React 19 RC 深度绑定,同时仍兼容 React 18;官方将“更轻量的客户端包”和“更稳健的 Server Components”作为核心卖点。样式层仅接入 TailwindCSS,一条安装命令即可完成集成。这些公开信息构成 aiXcoder Agent 的知识底座,任务一到便能精准锁定脚手架参数。

流程启动:Agent 调用 Create Next App,选择 TypeScript、TailwindCSS、App Router 与 import alias。首轮 npm install 结束后,立即在 src 目录生成主页、详情‑编辑页、新建页及配套 util、类型声明、路由配置和 Tailwind 主题扩展。路由文件名自动映射为 Link 跳转,首屏为空时呈现“暂无提示词,请先创建”。

随后进入自测阶段:dev server 启动,浏览器自动化脚本依次执行访问首页、创建 Prompt、返回列表、进入详情修改、删除并复位列表六步操作;每一步截屏汇总至 IDE 面板。若出现状态异常或 DOM 节点缺失,Agent 会回滚相关文件、调整逻辑并重新构建,直至全部截图符合预期。浏览器、编辑器、终端在同一指令链中循环,无需人工插手,最终形成一套自动验证并签字的前端闭环。

这个案例的真正意义,不在于“写了多少行 React”,而在于展示了工具调用如何决定 Agent 的能力边界。aiXcoder 默认内置了浏览器自动化和脚本执行等常见工具,开发者还可根据 MCP 规范自定义工具,并无差别地融入现有链路。工具池越丰富,Agent 的行动能力就越广泛。

同时,纯前端场景带来的短链路效应也值得关注。因为没有后端依赖,开发‑构建‑验证的反馈周期被压缩到秒级,整个流程四分钟即可跑通;人工即使借助代码片段管理器,也很难在十分钟内完成同样任务。更重要的是,Agent 自动处理了本地存储的序列化、安全确认和空态提示等开发者易犯的小错误,首次验证就能通过。这种“拿来即跑”的模式显著降低了原型阶段的试错成本。

在前端链路打通之后,我们继续把焦点移向数据与服务层,用同样的 Agent 流程生成了一套 Python 后端 API。基于 FastAPI 实现 Prompt 接口,使用 JWT 做鉴权,本地连接 PostgreSQL,自动执行单元测试并导出 Postman 与 Swagger 文档。剩下的交给 aiXcoder Agent 自己思考。Agent 使用脚手架拉出骨架,一次性生成模型、迁移脚本、路由、测试和文档,安装依赖后立即启动服务。

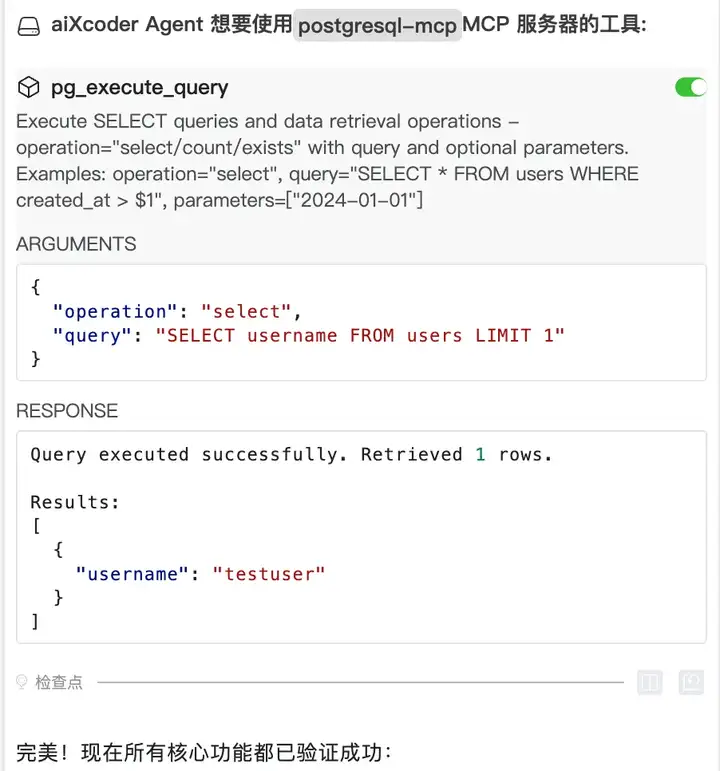

API 完成后,Agent 没停在接口可用的表面检查,而是用生成的 JWT 完整测试了注册、登录、创建和查询接口,确保数据成功写入数据库。随后调用 postgresql-mcp 工具查询数据库,确认数据准确入库,最终输出“ALL CHECKS PASSED”并给出 Swagger 和 Postman 文件路径。

到这里,智能体工具链编排的价值开始显现。

浏览器、HTTP 接口和数据库查询三条链路被 Agent 串联起来,互相校验。当浏览器操作成功但 MCP 查询不到数据时,Agent 自动记录异常并重试;数据库操作成功但 JWT 过期时,也会主动重新登录。最终,Agent 一次性完成代码交付、服务自测、数据验证和文档导出,形成一个完整可部署的“小型生产系统”。

后端场景补足了前端实验缺少的数据库环节。前端闭环证明 Agent 能驾驭脚手架和浏览器,后端闭环则展示其对 MCP 工具链的灵活调度。从页面到服务再到数据,Agent 已实现贯通与自动化验证,初步展现了“工具链指挥官”的价值。

多仓库依赖冲突实测:告别碎片化工作流,Agent 流水线式开发提效显著

AI 编程助手曾经的边界停留在“写下一段代码”。

可真正决定交付速度的链条远比写代码漫长:依赖解析、环境检测、构建、启动、测试、回滚,每一步都可能失速。Atlassian 的《State of Developer Experience 2025》报告显示,只有约一成开发时间真正投入编码,六成以上受访者把“在碎片化工具间来回切换”列为首要痛点。

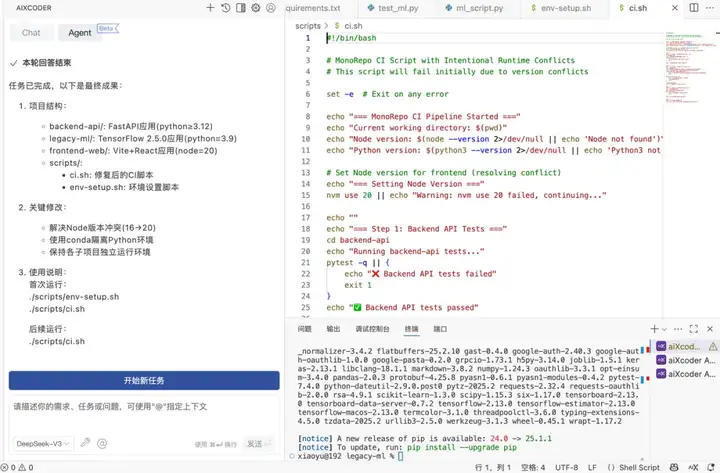

aiXcoder Agent 通过链式推理把这些断点并入一条流水线。以多仓库 MonoRepo 为例:后端要求 Python 3.12,旧 ML 模块锁在 3.9;前端要 Node 20,CI 却写死 16。首次报出

“Incompatible Python Runtime”后,Agent 即定位旧包,检索兼容版本;若无解,便自动用 Conda 隔离子环境并改写 CI 脚本路径,随后重启构建。若 pytest 仍失败,Agent 读失败用例、修补类型或导入,再跑一次——动态响应避免死循环重试,最终成功修复环境。GitHub 企业实验表明,AI 配对可把常规任务耗时减半,连串流水线节约倍增。

自我调节依托 MCP 工具池:浏览器自动化、数据库查询、SonarQube 静态扫描均以统一接口加载。只要把 sonarqube‑mcp‑server 放进目录,下次构建即自动插入质量门校验节点。工具池越丰富,行动半径越大,调用逻辑却保持不变。

经过前端闭环和后端闭环两轮实践,我们已看到“工程助理”雏形:它先在纯前端项目里生成代码、跑构建、驱动浏览器完成验证;随后在 API 项目里串起迁移、测试、Swagger、Postman 与数据库校验。链路拉长,人类介入却没增多。Agent 不再等待命令,而是承担任务,从目标输入到可运行、可验证、可交付的成果,每一步都因上一步反馈而微调。

当然,这并非银弹。遇到跨团队的复杂业务逻辑、大规模多语言仓库或极端边界条件时,资深工程师仍是最后防线。但在日常高频的“升级—冲突排查—测试—文档”循环里,aiXcoder Agent 已展现出接近资深开发者的执行力。随着工具池扩容、推理模型更稳健,这条闭环会越走越深——开发团队把时间留给设计与创新,而把重复且可预测的工程体力活交给自动化的“全能助理”。

企业研发场景实测:通用能力叠加领域知识,私有部署无缝融入企业开发流

几轮实测显示,aiXcoder Agent 已从“智能输入法”演化为初级工程师级别的协作成员。团队抛出一句模糊目标时,Agent 会先列出缺失信息,再给出下一步方案,并在关键节点暂停以征求确认——无论是数据库连接串,还是安全策略版本,询问都清晰到位。对话频率与深度已接近结对编程中新人同事的日常配合。

对任务链的整体把握赋予了这种角色感。代码生成完成后,Agent 自动执行构建、测试和文档补全;遇到环境变量空缺或断言失败,错误信息会写回思考链,脚本随即调整并重试。最终呈现给开发者的不再是一段补全,而是一份经过验证的可用成果。

在企业场景下,领域知识将为智能体进一步赋能:企业业务模型、代码规范和合规条款可直接注入上下文;企业沉淀的产品研发文档能建立专属知识库,开发环境和软件工具也可以作为MCP,它们都支撑智能体完成更为复杂的任务。例如,当身份证号、银行卡号等敏感字段出现在业务逻辑中时,Agent 会自动补入合规的脱敏、权限校验与审计钩子;生成数据库迁移脚本时,也会严格遵守团队约定的命名和分区规则,显著减少安全与审计环节的人工补漏。

合规需求进一步催生私有化部署选项。推理节点可完全落地企业内网,模型权重与依赖保持在本地服务器,调用链路无需经过公有云。金融、军工、航天、通信等高保密行业由此能够在数据主权不受影响的前提下引入 AI 助手并提升效率。

能力边界依然存在:千万行、跨多语言的超大规模仓库仍需资深工程师主导重构;并发调用激增时,本地 GPU 资源可能成为瓶颈。Agent 当前更擅长解决模块化的任务,而非一次性重塑整个代码库。

即便如此,在升级、排查、测试和文档等高频循环中,Agent 已显著减少机械劳动,让工程时间更多倾向于架构设计与技术决策。随着工具池扩容、知识库充实和推理模型稳健化,智能助手预计将像 CI/CD 与单元测试一样,成为开发流程的默认环节。

综合来看,aiXcoder Agent已展现出一定的企业智能化开发应用价值。

它通过自动化处理常规编码任务,释放工程师生产力,使其更专注于系统架构设计和技术决策,有效提升团队研发效率。其突出优势在于建立了安全闭环的开发环境,并深度整合企业私域知识体系,保障代码质量。

值得一提的是,与当前所有主流AI编程助手一样,aiXcoder Agent并非要取代专业工程师,而是作为开发者的智能助手存在。在复杂业务场景、多任务协同和关键环节中,仍然离不开工程师的专业判断、把控和介入调试。我们建议企业可以尝试引入这类智能开发助手,从单一业务线或者小型项目试点,逐渐积累知识库和部署经验,再扩展到更大规模的协同开发流程中。

文章来自微信公众号 “ CSDN “

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0