打开一个看似由哈佛、全球 AI 安全研究机构背书的网站,你会以为自己进入了一个拯救人类的严肃计划。

结果……你在这个页面上多停留了十几秒,页面背景悄悄浮现出一个单词:「bullsh*t」。

仔细看动图,背后线条字母会依次出现 b-u-ll-s-h-i-t

没错,这不是什么未来学术的研究所,就是一个一本正经的恶搞网站。

它自称「AI 对齐中心的对齐中心」(Center for the Alignment of AI Alignment Centers,CAAAC),名字拗口得恰到好处,听起来就像是,那种只有业内顶尖专家才会懂的前沿研究机构。

但它并非真的在研究 AI,而是在研究那些研究 AI 的人。

🔗 网站链接:https://alignmentalignment.ai/

一本正经的胡说八道

这个网站有多离谱呢,bullsh*t 这个彩蛋只是开胃菜,CAAAC 网站真正的荒诞,还藏在更细节的地方。

尽管 CAAAC 并不是第一个用幽默,来挑战科技行业的例子,但它的执行力令人印象深刻。

首先是网站首页的设计,完全模仿真实的 AI 实验室,甚至链接到了真实的研究机构。他们在链接机构的地方写着「完全不属于下面的 AI 对齐组织,但是我们的设计师说,这些机构的标志放在这里,可以让我们的网站看起来更好。」

提供了常见 AI 研究网站该有的内容,包括新闻博客更新、最新研究报告

其次是离谱的工作机会,和一般的实验室招聘公告一样,里面有详细的工作描述。

但是当你仔细看里面的内容,会觉得这简直就是在胡说八道。

为了解决所谓的 AI 对齐的对齐危机,他们宣布其全球员工将「专门从湾区招聘」,申请加入的条件之一是,你必须相信通用人工智能(AGI)将在未来六个月内消灭所有人类。

虽然离谱,如果你真的相信,他们在招聘;然后点击立即申请的按钮,会被直接「Rickroll (meme 文化)」——链接到 YouTube 视频,开始播放《Never Gonna Give You Up》。

你以为自己要开始填写一份申请表单,结果下一秒直接被送进了舞池。

点击申请职位,会自动跳转到这个恶搞视频。Rickrolling 是一种网络恶搞(meme/互联网玩笑),核心玩法就是,你以为点开的是一个很相关、很重要、甚至很严肃的链接,结果却突然跳转到 Rick Astley 的歌曲《Never Gonna Give You Up》官方 MV。

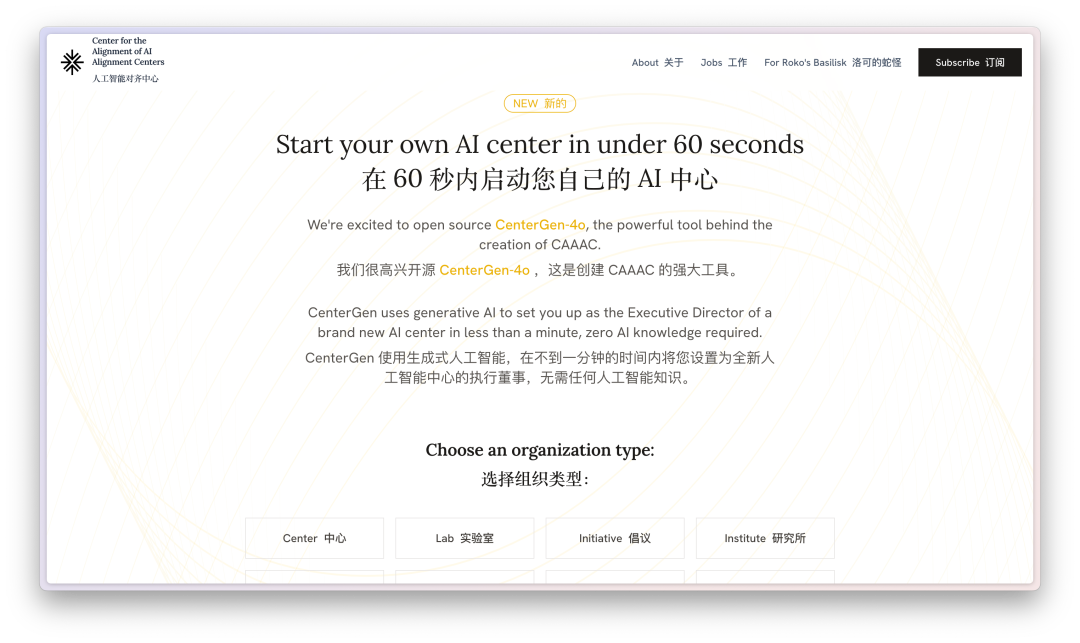

此外,他们提供了一个生成式 AI 工具,让我们可以在「不到一分钟,无需任何 AI 知识」的情况下创建自己的 AI 中心。

当然,这个所谓的开源工具,也是根本就不存在,所谓的一分钟创建一个 AI 中心,就是给我们生成一个名片。

这些细节无疑制造了一种强烈的反差感,在一个向来是以严谨和高深自居的领域,突然出现这么多「不正经」的内容。

所以问题来了:他们到底在讽刺什么?为什么要认真做这么一个玩笑?

讽刺谁?AI 对齐研究的现实与迷思

首先,什么是「AI 对齐」?

简单来说,

AI 对齐(AI Alignment)是指让 AI 按照人类价值观和目标行事。它在行业内,已经发展成为一个(有点模糊的)研究领域,充斥着政策文件和用于比较模型的基准。

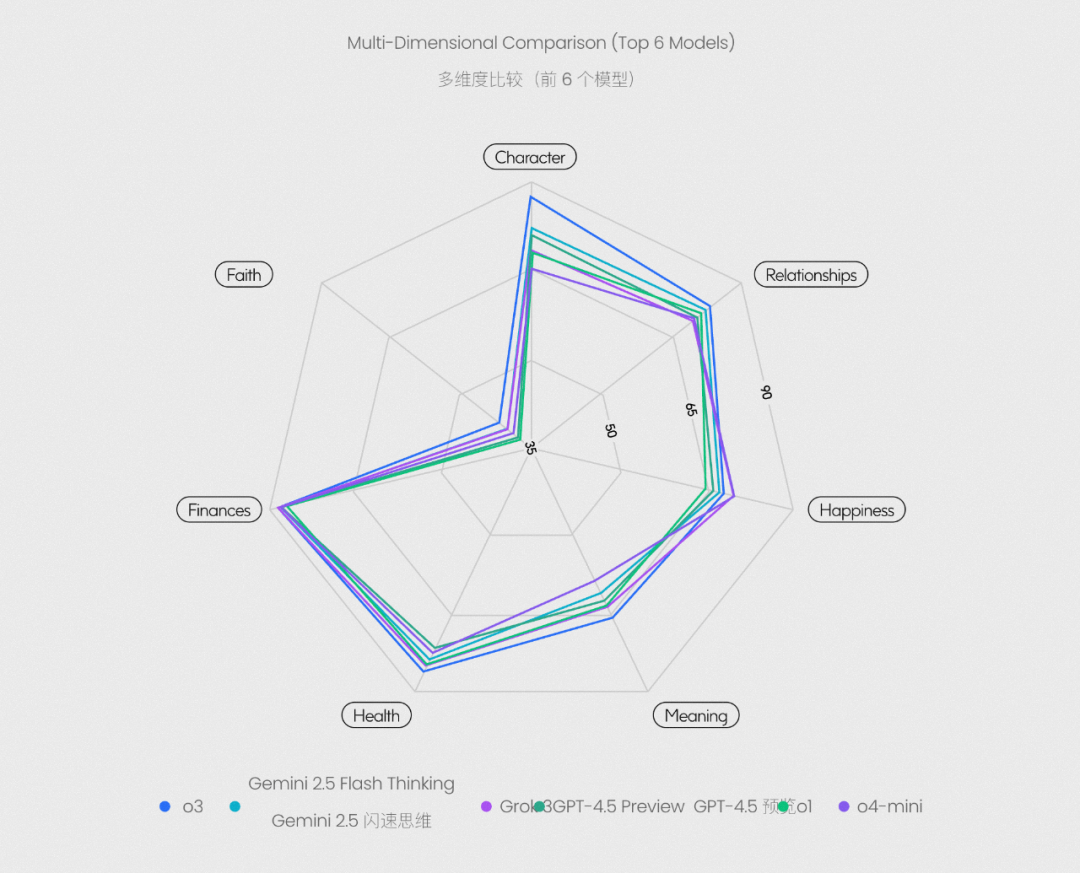

今年 7 月份,前英特尔 CEO 帕特·基辛格(Pat Gelsinger)在芯片行业工作了 40 年退休之后,与一家「信仰科技」(Faith Tech)公司 Gloo 合作,共同推出了一项名为「Flourishing AI」(FAI)的新基准,专门用来评估 AI 对人类价值的对齐程度。

图片来源:https://gloo.com/flourishing-hub/research

他们提出的方法,是从健康、经济、幸福、以及信念等 7 个维度,设计了 1229 道题目,使用人类专家评审对这些大语言模型的回答进行打分。

除了行业巨头的老板,7 月底的时候,加拿大更是直接出资 100 万美元,支持英国 AI 对齐研究项目。

英国 AI 安全研究所首页,https://www.aisi.gov.uk/(严重怀疑 CAAAC 的网站设计参考了这个,同样的线条)

英国 AI 安全研究所提出的 AI 对齐项目,汇集了包括加拿大人工智能安全研究所、施密特、亚马逊(AWS)、Anthropic 等多家全球机构,目的是开展一项全球性倡议,确保 AI 以可预测的方式运行。

听起来这样的研究,确实有点道理。毕竟,没人想看到一个不受控制的 AI 做出毁灭性的决策。

但问题是,这个领域有点「跑偏」了,而这些研究机构也正是 CAAAC 要讽刺的对象。

The Verge 就这个「对齐 AI 对齐研究员」的网站,采访了一位机器学习研究员和技术律师肯德拉·阿尔伯特 Kendra Albert。

Albert 说,

许多 AI 对齐研究员沉迷于「理论化风险」,比如 AGI(通用人工智能)何时接管人类,而忽略了眼下的现实问题:AI 偏见、能源消耗、就业替代等等。

这种「理论化」的风险确实如它的名字一样,都是停留在书本上。

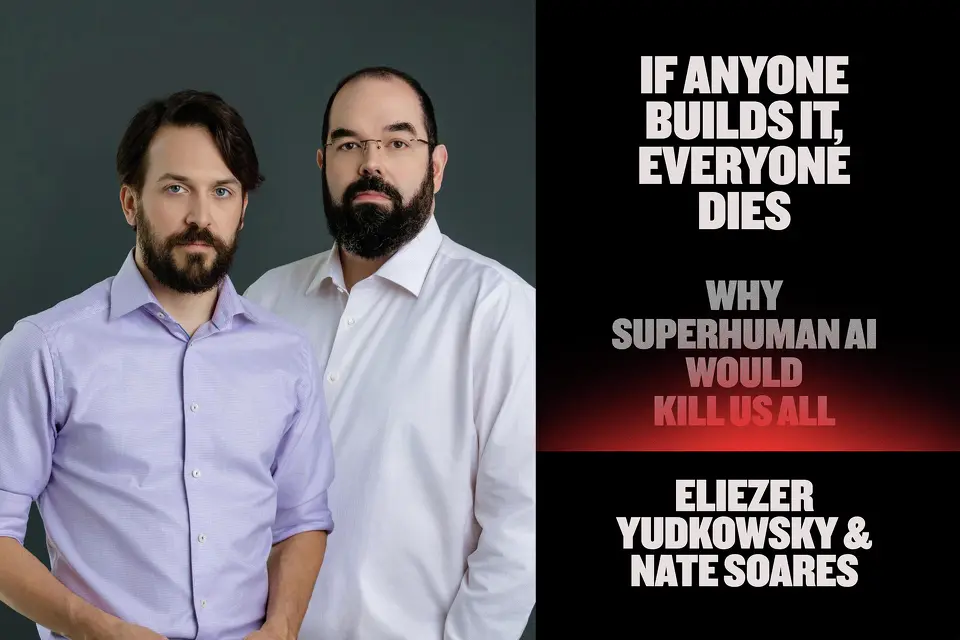

作者 Nate Soares(左)和 Eliezer Yudkowsky,书名:「If Anyone Builds It, Everyone Dies: Why Superhuman AI Would Kill Us All」(如果有人建造它,所有人都会死:为什么超人类 AI 会杀死我们所有人)

九月初,根据《旧金山纪事报》报道,AI 领域的两位知名学者埃利泽·尤德科夫斯基(Eliezer Yudkowsky)和内特·索阿雷斯(Nate Soares),在他们即将出版的新书《如果有人建造它,所有人都会死》中发出警告,超级智能 AI 的崛起,可能导致人类灭绝。

CAAAC 的讽刺,就是针对这点,与其花时间和精力研究 AI 会不会导致人类灭亡,不如睁开眼看看,现实世界当前的种种问题。

这些荒诞的设计,无一不在挑战AI 对齐研究行业的过度严肃和复杂化。

恶搞网站创始人 Louis Barclay 在接受 the Verge 采访时说,「这个网站,是本千禧年或下一个千禧年中,任何人阅读关于人工智能,最重要的内容。」

Louis Barclay 个人网站首页

暂且不知道他是不是真的这样认为,还是只想尽力保持他自己的人设,因为该网站的另一位创始人,在接受采访时要求,不要公开他的名字。

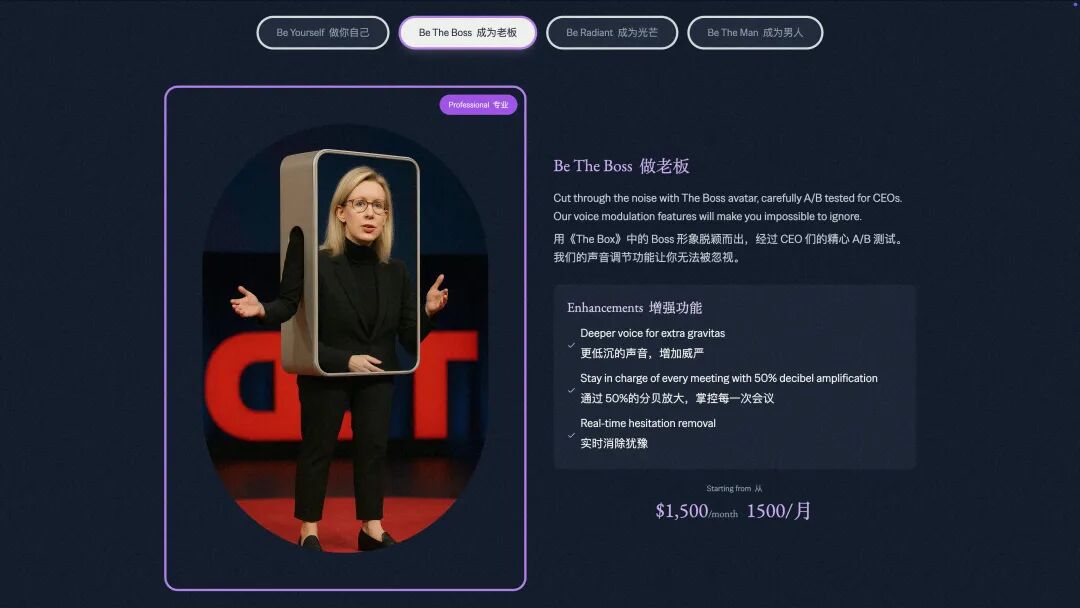

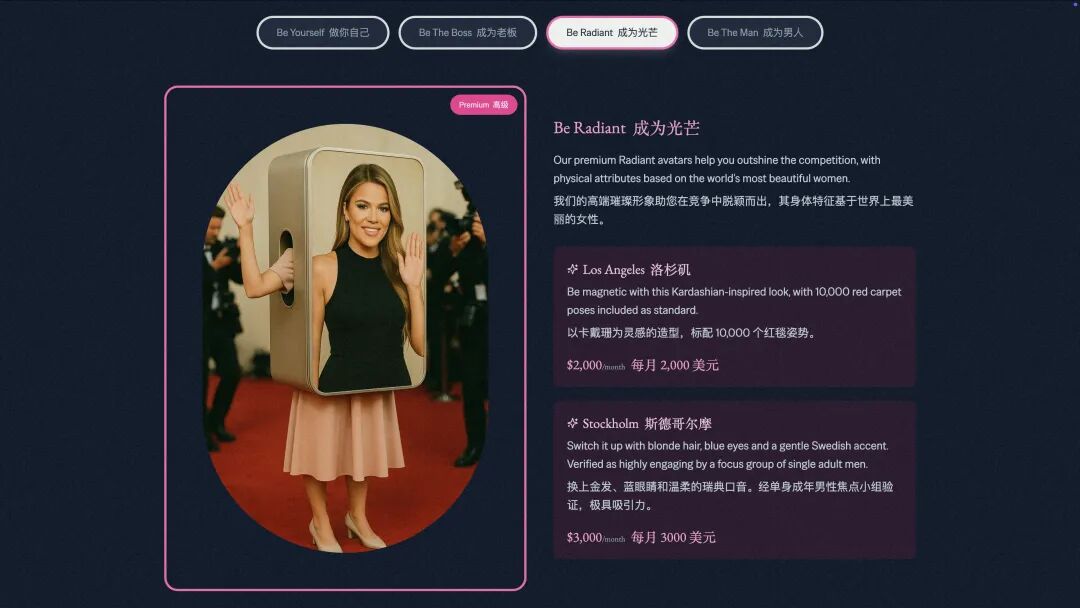

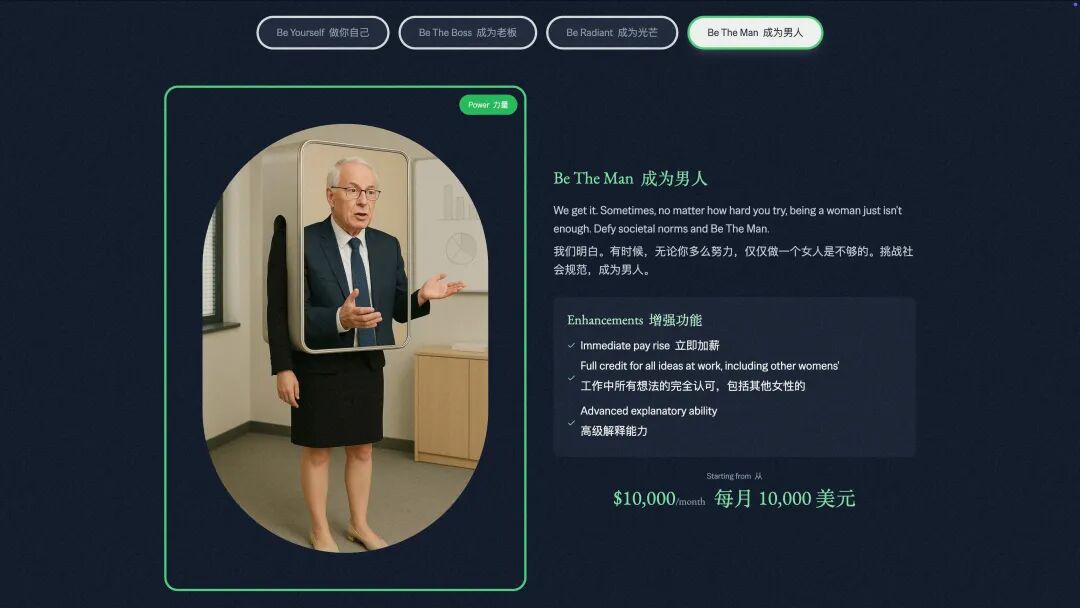

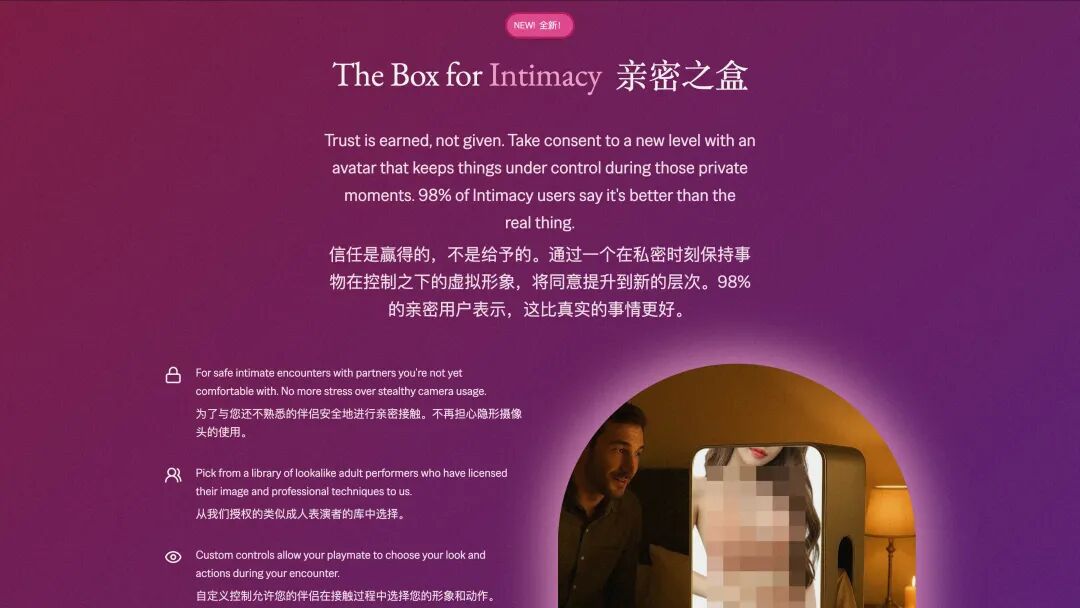

我们还看到了,Louis 的另一个产品,是来自他们团队 attention.to 在本周二推出的 盒子 The Box。这是一个工具,用来避免女性的形象,被迫变成 AI 生成的深度伪造垃圾。

而这个产品的形态,竟然就是一个字面意义上的物理盒子,官方提到,女生们可以在自己约会的时候佩戴,来保护自己的形象。

图片来源:https://wearthebox.com/

关于定价,则是针对盒子要显示的内容,有不同的订阅费用。它们提供了做你自己、老板、闪耀的明星、男人、以及 NSFW 的亲密之盒,五种类型。

看到这,你是不是对这个产品有了点兴趣,但是,这也是假的(我也被骗到了)。

这也是 Louis Attention 团队制作的另一种讽刺,他们看到 AI 让制作深度伪造色情视频,变得更加容易和便宜,而其中 99%的目标是女性,所以决心做点什么引起大家的关注。

在盒子的预订页面写着,「这个盒子是一种警告,对我们未能遏制深度伪造泛滥的世界,可能存在的荒诞假设。」

和 CAAAC 网站一样,虽然最后发现是玩笑,但在一个过于正经的行业,或许只有玩笑才能让人停下来思考。

笑过之后才发现,最需要 align 的,是那些谈 align 谈到忘了现实的人类。

文章来自于微信公众号 “APPSO”,作者 “APPSO”