在大型语言模型(LLM)的浪潮下,多模态 AI 取得了飞速发展,尤其是在视觉语言(LVLM)领域,已经形成了成熟的研究范式。然而,与之形成鲜明对比的是,大型语音语言模型(LSLM)的发展却显得零散且步调缓慢。

该领域长期被碎片化的架构、不透明的训练数据和缺失的评估标准所困扰,导致研究之间难以进行公平比较,严重阻碍了技术的可复现性和社区的系统性进步。许多研究虽然发布了模型权重,但其赖以成功的关键 —— 训练数据和配置细节 —— 却常常被 “雪藏” 起来。

为了打破这一僵局,北京深度逻辑智能科技有限公司推出了 LLaSO—— 首个完全开放、端到端的语音语言模型研究框架。

LLaSO 旨在为整个社区提供一个统一、透明且可复现的基础设施,其贡献是 “全家桶” 式的,包含了一整套开源的数据、基准和模型,希望以此加速 LSLM 领域的社区驱动式创新。

相比视觉语言模型(LVLM)领域已形成 CLIP 编码器 + LLaVA 范式的成熟生态,LSLM 研究面临四大核心挑战:

1. 架构路径分化严重

当前 LSLM 架构主要包括外部特征融合、跨模态注意力机制、隐式对齐等多种技术方案,缺乏如 LVLM 领域般的统一范式。不同研究团队采用差异化架构,导致技术进展难以积累和比较。

2. 训练数据严重私有化

主流 LSLM 如 Qwen-Audio、Kimi-Audio 等均依赖私有数据训练,数据规模、质量、构成等关键信息不透明。这使得:

3. 任务覆盖局限性明显

现有数据集主要聚焦语义理解任务,对语音中的副语言学信息(paralinguistic information)如情感、口音、韵律、说话人特征等覆盖不足,限制了模型的全面语音理解能力。

4. 交互模态单一化

大多数 LSLM 仅支持 "文本指令 + 音频输入" 的单一交互模式,缺乏对 "音频指令 + 文本输入" 和纯音频交互等复杂模态组合的系统性支持。

LLaSO 框架:三大核心组件构建完整生态

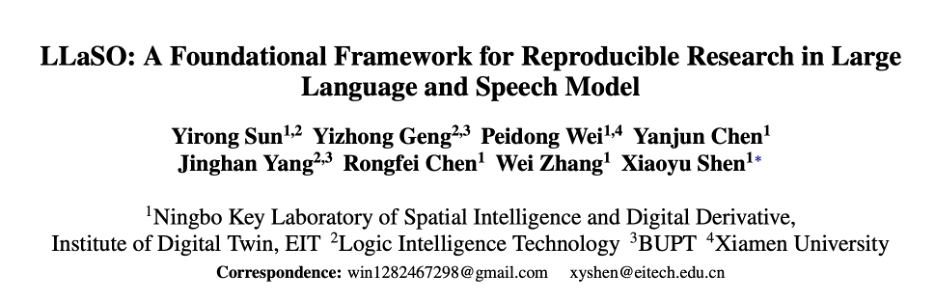

图一:llaso 语料库的制作流程

LLaSO 框架通过三个核心开源组件解决上述挑战:

LLaSO-Align:大规模语音 - 文本对齐数据集

LLaSO-Instruct:多任务指令微调数据集

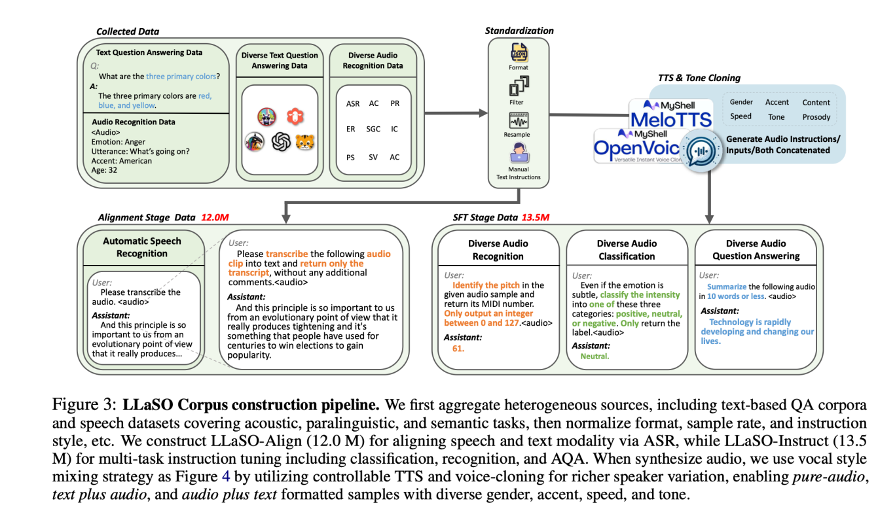

图二:LLaSO 语料库的任务组成

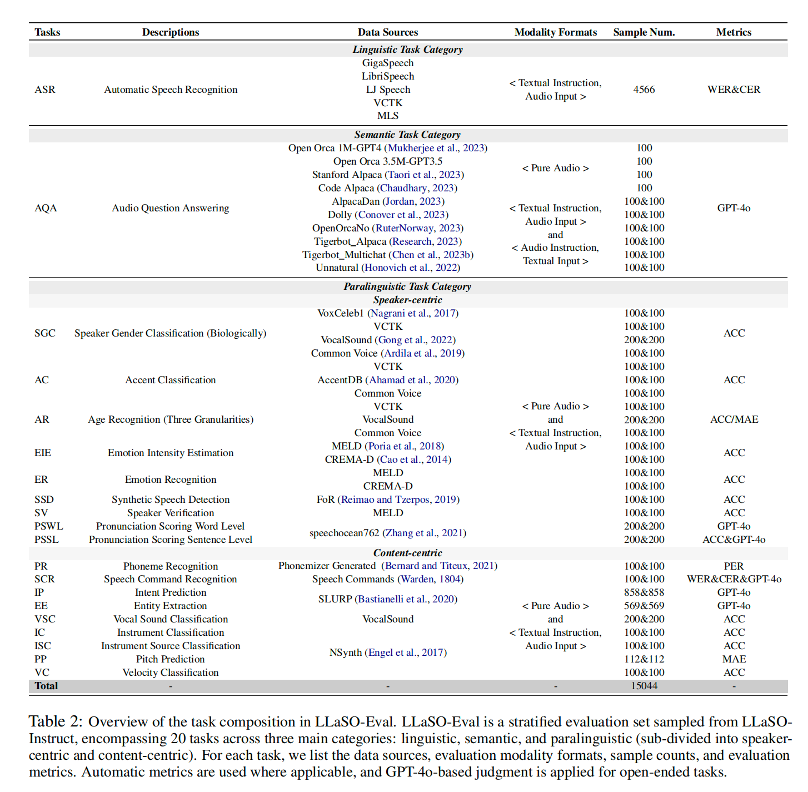

LLaSO-Eval:标准化评估基准

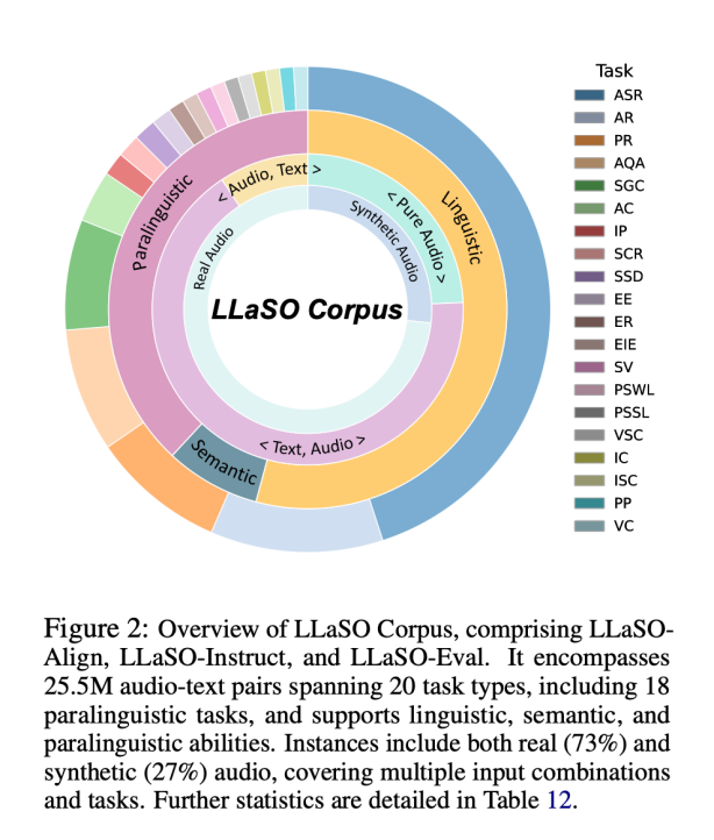

图三:LLaSO-Base 在 LLaSO-Eval 基准测试上的表现结果

这三大组件共同构成了一个完整的训练、微调和评估流水线,为 LSLM 研究提供了前所未有的开放性和便利性。

为验证框架有效性,逻辑智能团队基于 LLaSO 数据训练了 38 亿参数的参考模型 LLaSO-Base。

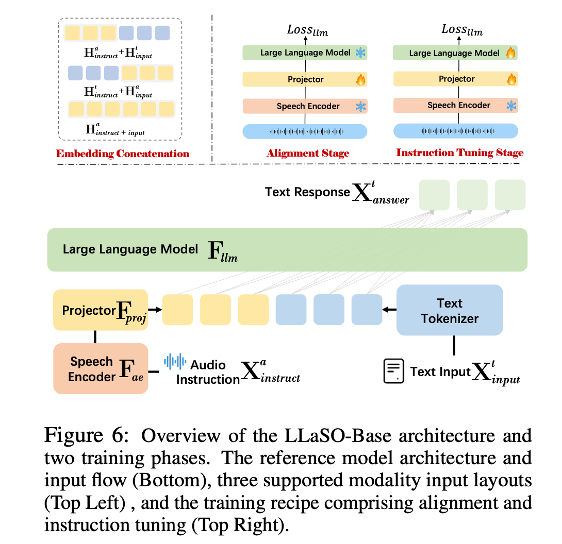

模型架构设计

采用经典三阶段架构:

两阶段训练策略

图四:LLaSO 模型架构示意图

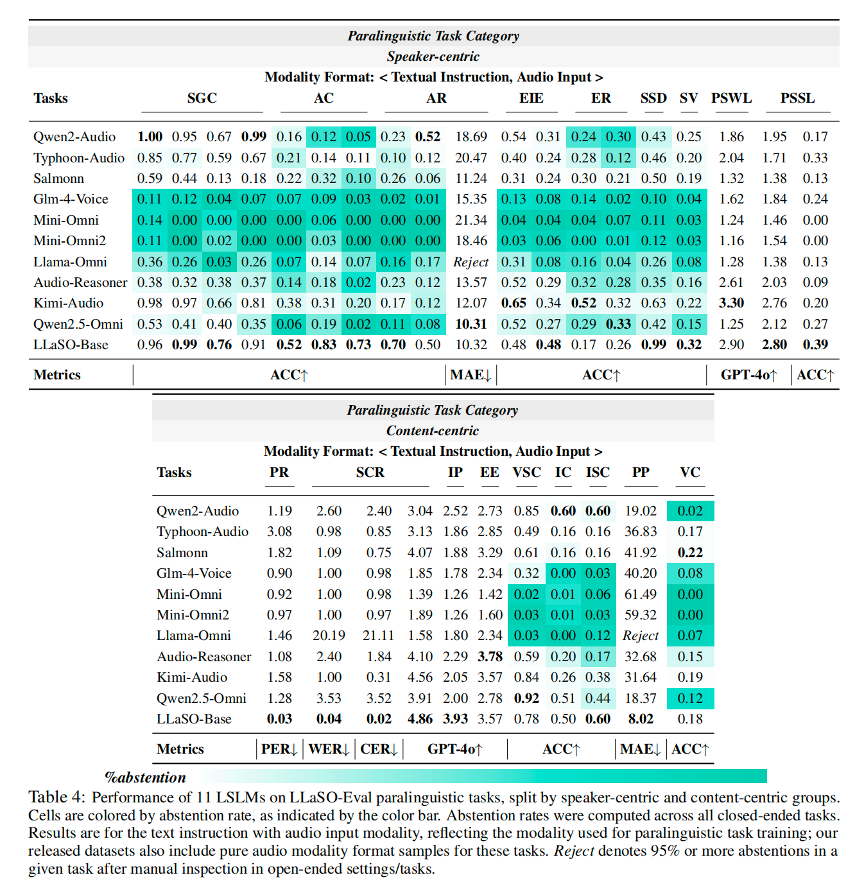

我们在一系列严格设计的实验中,将 LLaSO-Base 与多个业界领先的语音语言模型(LSLMs)进行了直接对比。所有实验均在我们构建的标准化评估基准 LLaSO-Eval 上完成,确保了比较的公平性和结果的可复现性。

实验设置与评估基准

为确保评估的全面性,我们选取了 10 个主流的语音语言模型作为基准,包括 Qwen2-Audio、Typhoon-Audio、Salmonn、GLM-4-Voice、Mini-Omni、Kimi-Audio 等。所有模型的评估均在统一的 LLaSO-Eval 测试集上进行。

图五:详细描述了 LLaSO-Eval 评估基准的构成。

该基准包含 15,044 个样本,覆盖了 20 种不同任务。这些任务被系统地划分为三大类别,以实现对模型能力的深度剖析:

评估指标说明

我们的评估体系采用了多种指标,以确保对模型各方面性能的精确衡量 :

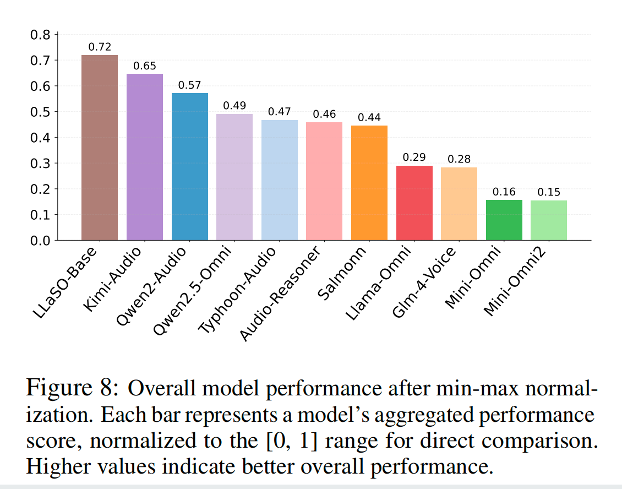

总体性能对比:LLaSO-Base 表现全面领先

图六: 直观地展示了所有模型在 LLaSO-Eval 上的总体性能得分(经过归一化处理)。

从图中可以清晰地看到,LLaSO-Base 取得了 0.72 的最高分,位列第一 。这一成绩显著优于其他所有竞争模型,例如表现次之的 Kimi-Audio (0.65) 和 Qwen2-Audio (0.57) 。这一结果强有力地证明了 LLaSO-Base 的综合实力。研究发现,像 LLaSO-Base 这样在更多样化的任务上进行训练的模型,其综合性能远超那些主要针对 AQA 等少数任务进行优化的模型(如 Llama-Omni 和 Mini-Omni)。这凸显了我们所提倡的广泛任务覆盖训练策略的有效性。

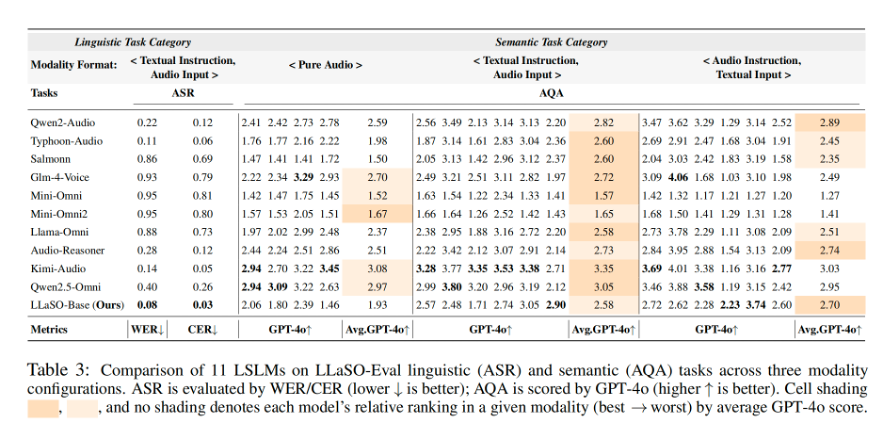

详细任务性能分析

图七: 深入比较了各模型在语言学 (ASR) 和语义 (AQA) 任务上的具体表现 。

LLaSO-Base 的得分 (2.70) 展现了更强的模态适应性,超过了多数模型。

图八:呈现了在 18 个细分的副语言学任务上的对比结果,这是对模型能否理解 “弦外之音” 的终极考验。

在这些更复杂的任务上,LLaSO-Base 几乎在所有任务上都取得了顶尖或接近顶尖的成绩。

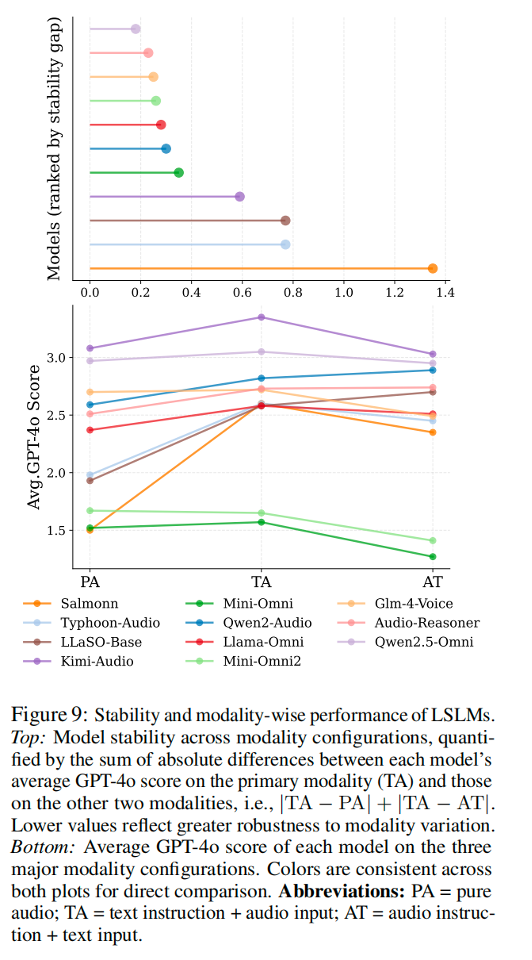

模态泛化与任务覆盖度分析

图九:模型在不同输入模态下的性能稳定性

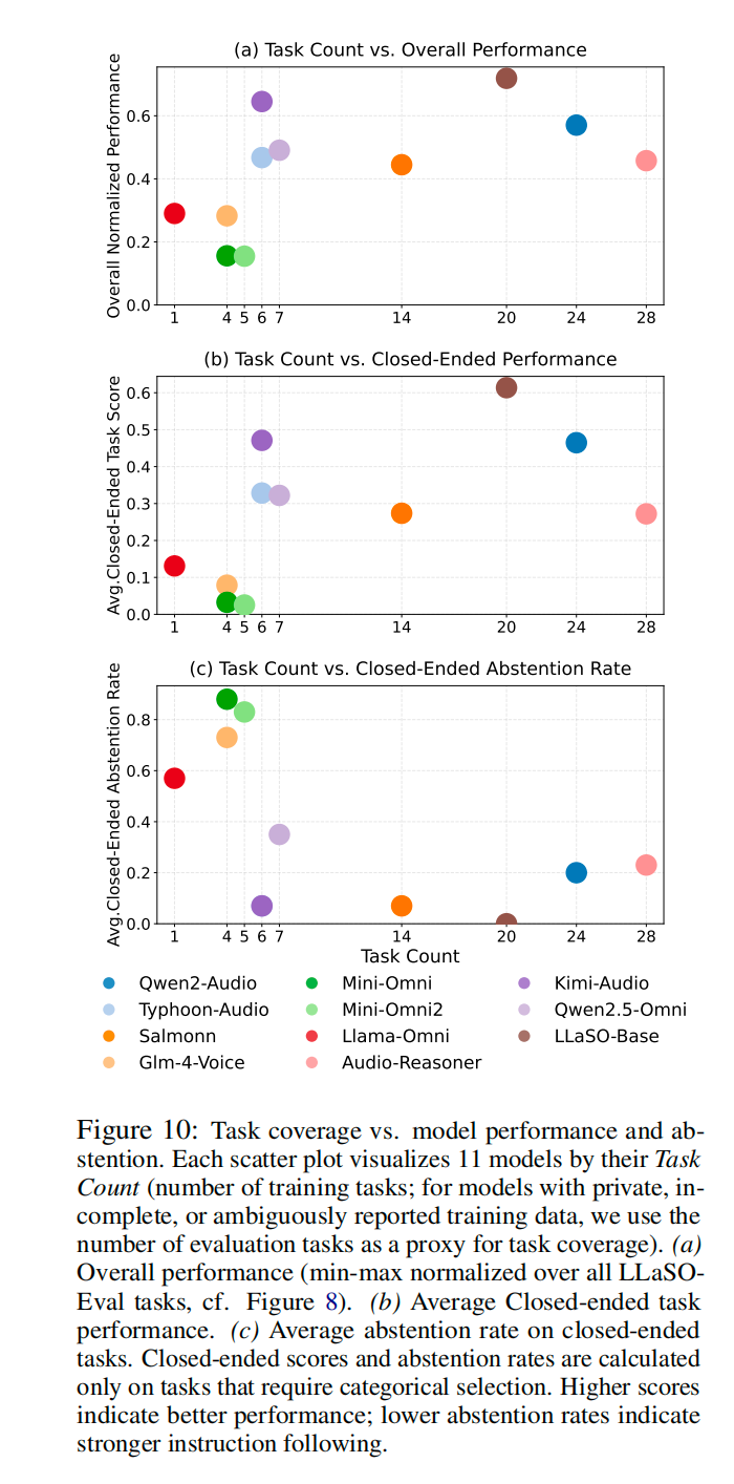

图十:模型训练正相关关系

LLaSO-Base 经过 20 个任务的训练,其总体性能和指令遵循能力(低拒绝回答率)均处于领先地位 。而那些训练任务较少的模型,性能普遍偏低,且更容易 “拒绝” 回答,这进一步验证了 LLaSO 框架设计理念的正确性与前瞻性。

对学术研究的推动作用

1. 可复现性保障:完整开放的训练数据和代码实现

2. 公平比较基础:统一评估基准消除 evaluation bias

3. 研究门槛降低:研究者可专注于算法创新而非数据收集

4. 技术积累加速:基于统一框架的增量改进更易实现

对工业应用的促进效应

1. 开发成本降低:相比私有数据方案节省数千万数据构建成本

2. 技术风险可控:开源方案的透明性降低技术选型风险

3. 定制化便利:开放架构支持针对性的领域 adaptation

4. 生态建设基础:为 LSLM 生态标准化提供参考实现

当前局限性

1. 模型规模:38 亿参数相比 GPT-4 级别模型仍有性能 gap

2. 多语言支持:主要针对英文和中文,其他语言覆盖有限

3. 实时性能:大模型推理延迟对实时应用仍有挑战

4. 长音频处理:对超长音频序列的处理效率有待优化

发展方向

1. 模型 scaling:探索更大规模模型的性能上限

2. 效率优化:模型压缩、量化等技术降低部署门槛

3. 多模态扩展:集成视觉信息实现 Audio-Visual-Language understanding

4. 领域适应:针对医疗、教育、客服等垂直领域的专用优化

LLaSO 作为全球首个完全开源的 LSLM 研究框架,通过提供大规模数据、统一基准和参考实现,为语音语言模型研究建立了透明、可复现的技术基础设施。其开源策略不仅降低了研究门槛,更重要的是为 LSLM 领域建立了统一的技术标准,有望推动该领域从 "各自为战" 向 "协同创新" 转变。

随着框架的广泛采用和社区贡献,LLaSO 有望成为 LSLM 研究的 "ImageNet 时刻",为构建真正理解人类语音 nuance 的 AI 系统奠定坚实基础。

文章来自于微信公众号 “机器之心”,作者 “机器之心”

【开源免费】Whisper是由openai出品的语音转录大模型,它可以应用在会议记录,视频字幕生成,采访内容整理,语音笔记转文字等各种需要将声音转出文字等场景中。

项目地址:https://github.com/openai/whisper

在线使用:https://huggingface.co/spaces/sanchit-gandhi/whisper-jax

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales