如今,我们已经可以利用AI来预测和设计蛋白质,从而开发新的药物、酶和生物材料。

同样的变革,正在发生在基因领域。

9月17日,Arc Institute报告了他们如何利用Evo 1和Evo 2构建了全球首个AI生成的基因组,设计了多款能消灭细菌的病毒,是生成基因组学(Generative genomics)的重要里程碑。

Evo通讯作者、斯坦福大学计算生物学家Brian Hie对此表示:“生成式基因设计时代到来了!”

生成基因组学融合了生成式AI与基因组学,科学家可以利用AI来理解和分析基因序列、预测序列特性并设计新的序列,这使得生物学从描述性领域迈向更具预测性、更具工程性的领域,从而推动医学、合成生物等领域的发展。

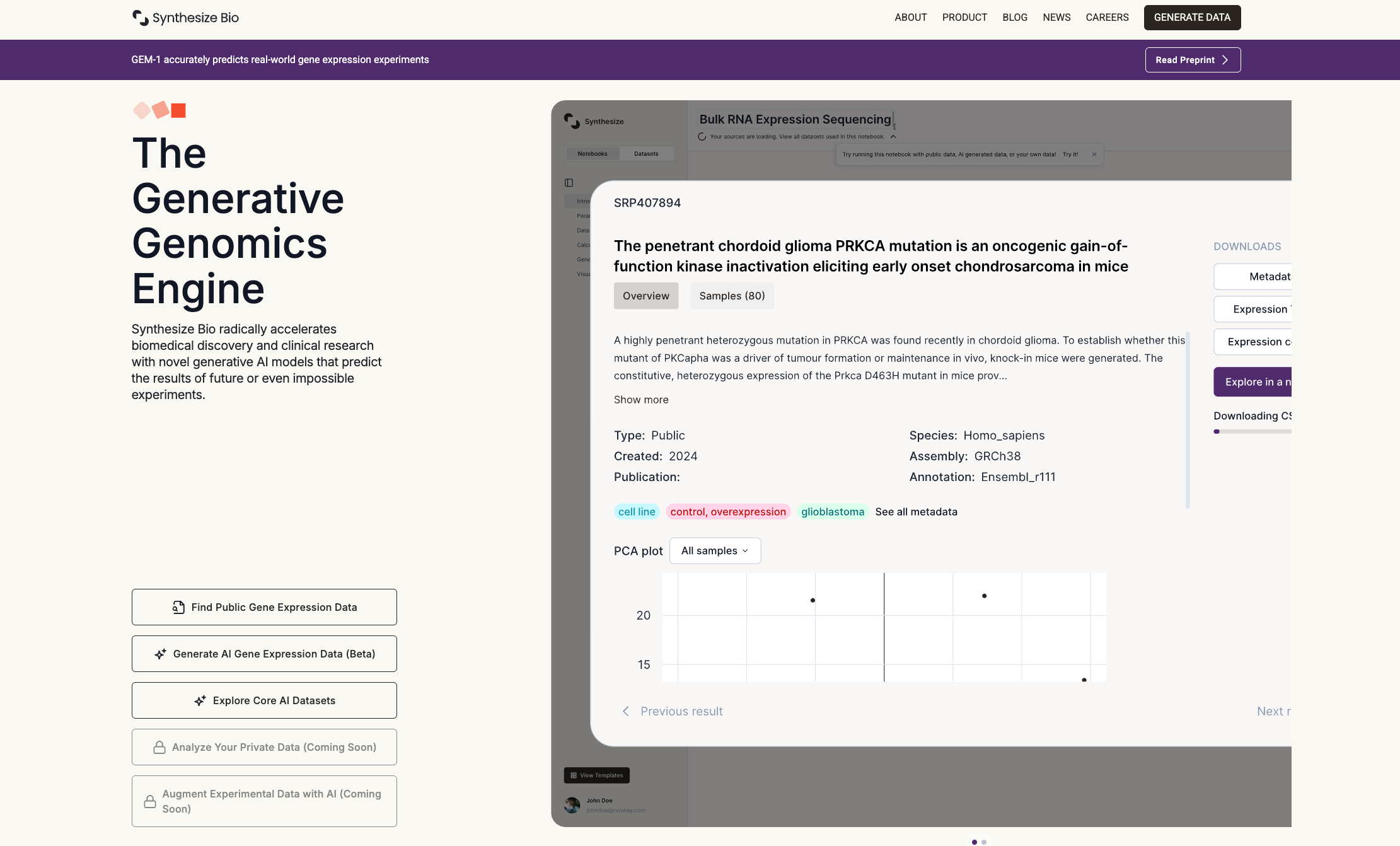

瞄准这一前沿领域,已有相关公司成立,近日Synthesize Bio宣布完成1000万美元种子轮融资,以加速生成基因组学模型的开发。

Synthesize Bio已推出GEM-1,这是一个专为生成基因组学设计的基础模型,其基于迄今为止最完善的RNA测序数据集进行训练,使用者通过描述实验设计,就能获得接近真实实验的模拟数据。

其重要意义在于,研究人员将能以极低的成本和周期,高精度地预测实验结果、验证科学假设,从而大幅加速药物研发、疾病机制探索和精准治疗方案的制定。

Synthesize Bio由弗雷德·哈金森癌症研究中心转化数据科学综合研究中心主任Rob Bradley和弗雷德·哈金森癌症研究中心首席数据官Jeff Leek共同创立。

Jeff Leek在RNA信息学领域做了大量开创性工作,他领导收集、规范化和合并来自世界各地研究人员的各种RNA数据,最终构建了目前最大的集成数据集。GEM-1正是建立在该数据基础之上。

近日,两位创始人参加了一档访谈节目,分享了他们的最新观点:

以下为访谈原文:

主持人:让我们从头说起吧,Synthesize Bio的创立故事是怎样的?请你回顾一下创立这家公司的初衷,以及我们今天进行这次对话的原因。

Jeff:我和Rob认识很久了。我们一起做学术同事大概有20年了,一直关注着彼此的科研成果。大约三年前我搬回西雅图,作为学术带头人,我们经常在走廊里碰面。我们俩都想建立一个生物学的基础模型。我们开始讨论这个问题,当时我们有足够的信息和想法,觉得或许可以尝试一下。

于是我们开始思考这个问题,然后立即给投资人发了邮件,说:“我们需要马上和你们谈谈。” 因为我们觉得这是一个时机,恰逢其时,有合适的数据来实现它,也有合适的技术来实现它。我和Rob都非常兴奋,想要尝试一些新东西,大胆尝试一些很酷的东西。

主持人:也许可以提升一下高度。如今,人工智能和生物技术正经历着寒武纪大爆发。正如你所指出的,在蛋白质设计等领域已经取得了一些惊人的进步。这一领域已获得诺贝尔奖,许多公司现在都在利用它开发药物,或者合作开发药物。但你在Synthesize Bio做的事情却与众不同。我很好奇为什么要做这种与众不同的事情,以及您如何看待它与更广泛的生态系统的契合。

Jeff:我们着手做这个项目时,并没有想过要解决某个特定的生物学问题。从一开始,我们的目标就是尝试构建一个能够像大语言模型一样支持多种应用的模型。

我们与众多同行的不同之处在于,我们正努力构建一个基础广泛、应用广泛的基础模型。因此,无论目标制药公司关注的是癌症、神经疾病还是心血管疾病,我们的模型都能在所有这些领域发挥作用,加速药物研发领域的大部分(如果不是全部的话)科学研究。因此,我们很高兴能将它交到人们手中,并见证他们如何在各种不同的环境中尝试和使用它。

Rob:我认为,从计算机科学和机器学习领域的文献来看,有很多理由可以证明,对尽可能多样化的训练数据集进行建模才能获得最佳效果。在语言模型上,这一点已经非常明确。长期以来,人们开发了非常专注的机器学习模型,并取得了进展。但事实证明,获取尽可能庞大的文本语料库,然后将其输入模型,让模型对其进行学习,这种方式才是更有效的。

主持人:是啊,惨痛的教训。

Jeff:如果你一直在研究某个非常具体的应用,而这时基础模型出现了,并且在所有这些具体应用上都表现得更好,这确实非常具有挑战性。

Rob:这太令人难以置信了,对吧?我认为很少有人能预测到这一点。例如,如果你的目标是帮助人们处理法律合同,也许你最好的做法是从对整个互联网的建模开始。

Jeff:这种做法能成为解决方案,这一点并不直观。我认为对我们来说,可能也是同样的情况。如果你非常关心某个特定人类大脑中某个特定基因的情况,目前还不清楚,对迄今为止收集的所有基因表达数据进行建模是否是解决该问题的正确方法。

Rob:没错。我的意思是,在我的职业生涯中,我构建过各种机器学习模型来解决我所面对的高度特定的科学问题。其中一些模型是有用的,一些则不然。但我可以说,没有任何一个模型让我感叹:“我终于能做以前做不到的事了。”

主持人:你能解释一下,这如何契合我们对生物学的理解,以及我们高中时学过的“中心法则”吗?

Jeff:回想一下你的高中生物知识——大致上,你体内所有细胞的DNA序列都是相同的。但DNA序列中有一些小片段编码着被称为基因的物质。这些基因被转录成RNA,而我们可以对这些RNA进行定量测量。你的心脏细胞之所以不同于脑细胞,是因为这些基因表达的丰度不同,而这些表达最终会被翻译成蛋白质,在细胞内执行各种功能。

而RNA比蛋白质更容易测量,因此这类分子的测量数据非常丰富。所以,当我们思考这个想法时,我们真正关注的是:目前在哪些领域有能力生成足够规模的训练数据,从而让我们构建一个能广泛应用于不同场景的基础模型?对我们而言,这个领域就是RNA。

而且,幸运的是,我们两人都在这一科学领域拥有丰富的经验,我们的职业生涯也都是围绕这个领域展开的。因此,我们最初就聚焦于此。但RNA分子的好处在于它的动态性:它会对环境刺激产生反应,会对药物产生反应,甚至会对当天的饮食产生反应。因此,通过RNA,我们实际上可以获得生物学状态的读数。所以,如果我们能够对它建模,如果我们能生成看起来像真实人类数据的数据,我们就能真正窥见这些人类体内正在发生的生物学过程。

主持人:完全正确。就像是实时的生物学?

Jeff:是的,正是如此。

主持人:所以你们正在构建的这个RNA模型,它如何融入你们日常的实验中?以及最终,它如何帮助你们解开想要探究的生物学问题?

Rob:我认为,将它与其他AI模型做类比会很有帮助。目前,我们对大语言模型已经相当熟悉了,对吧?这些是生成式AI模型,意思是,你要求它们做某事,它们就会为你生成一些东西。比如大语言模型,你给它一个提示(prompt),要求它做某事,它就会生成一大段文本。这非常有用,因为很多人就是通过这种方式进行交流的,我们每天都在写大量的文本。

所以我们希望为生物学做类似的事情。科学家、生物学家大部分时间在做什么?我们生成数据,然后分析数据,再进行实验。我们可能会运行一个临床试验,获得数据后再进行分析。因此,我们想建立一个模型,其作用类似于大语言模型,但针对的是生物学家每天实际做的事情:生成数据以进行实验,并用这些数据来指导下一个实验。

主持人:那么,在构建这个平台时,你们是如何思考需要解决的问题的?在Synthesize Bio这个新世界里,哪些现在做不到的事情将变得可能?

Rob:我回想一下我自己的科研经历——作为一个在电脑前、在实验台前工作,管理实验室的人,我和像我这样的人,总是面临一个困境:我们必须在数据不足的情况下做出决策。有时是因为我们没有时间获取数据,有时是因为成本太高而无法实现,但很多时候是因为那些数据根本无法获取。

举个例子,假设有人正在开发一种治疗神经退行性疾病的药物,这种药物作用于大脑中的细胞。你根本不可能直接观察到病人服药后,其大脑细胞内发生了什么。但我们又需要这些信息来做决策。因此,科学家们不断面临这种不可能的任务:我们必须决定是否继续推进药物开发,但我们偏偏无法获得所需的数据。所以我们想构建一个模型,让我们能够“获得”这些数据。

主持人:我倒是很喜欢我的脑组织能一直待在我的脑子里。

Jeff:那正是它该待的地方,没错。

Rob:即使存在伦理挑战,你可能也不愿意参与这种实验。

Jeff:但这并不意味着这些信息不重要。理解药物如何发挥作用,这恰恰是至关重要的一环。我们想做的很多实验都是如此。举我自己的经历为例:我分析过的第一批数据来自一项研究,该研究将患者随机分配,一组注射内毒素,另一组注射生理盐水。内毒素是一种非常可怕的东西,一旦注射,人会病得很重。因此,受试者被随机分配,只能等待自己是进入对照组还是“生病组”。

但这项研究只能在极少数人身上进行。他们试图研究钝性创伤的基因组学,这非常困难,因为你不可能让人去经历车祸。所以,我们只能在非常小的规模上进行,只有少数几个人被随机分配接受这种非常糟糕的干预。但如果你能在模型中进行这个实验,而不是在人体上进行,我们就可以对数百人、数千人进行模拟。

你将不再受实验的限制。同样,如果你能“采集”人的大脑样本,能“采集”他们身体的所有组织,你就能更全面地了解疾病、创伤或治疗发生时体内的情况。而且,你可以以传统实验室实验难以企及的规模和速度来完成这一切。

主持人:所以我认为,正如你所说,这正在解决一些不可能的问题——这些是无法获取的样本,是不道德的实验。你们有没有某个灵光乍现的时刻,突然意识到:“等等,我想我实际上可以模拟这些事情。虽然这对我来说并不直观,但也许真的可行。”

Rob:这是个很重要的问题,也是我们思考了很久的。我们都是科学家,我认为科学家花了数十年时间被训练得……

主持人:天生就持怀疑态度?

Rob:非常怀疑,非常严谨。所以,我们一开始真正思考的,并不是“如何构建出最好的模型”,而是“如果我们有一个模型,我们该如何测试它是否有效?有哪些方法可以评估它是否在做有用的事?它产生的数据是否有意义,是否对我们这样的人真正有用?” 我们甚至玩了一个游戏,这是Jeff的想法,一个绝妙的主意:我们开始用模型来模拟一个实验。

我们让模型为某个实验生成数据,然后将这些数据与实验室进行的平行实验的数据放在一起。比如,一边是科学家在培养皿中进行细胞实验的真实数据,另一边是我们的AI模型进行的“相同”实验(当然,AI只需要几秒或几分钟,而不是几周或几个月)。然后,杰夫会把这些数据发给我,问:“你能分辨出哪个是实验室数据,哪个是AI生成的数据吗?” 一开始很长一段时间,我一眼就能看出哪个是AI数据。但后来,有那么一个时刻,我无法分辨了。

Jeff:公司内部流传着一个故事,这其实是一种“强化学习,Rob反馈”。Rob是辨别哪组数据来自AI、哪组来自实验室最厉害的人之一。当我们的模型能骗过Rob时,我们就意识到:“好吧,我们可能真的成功了。这些数据看起来真的和实验数据一样,几乎无法区分。”

一个非常重要的点是:当你评估机器学习模型时,通常会用整体的度量标准,比如总体准确率、均方根误差等。但当你评估一个生物基础模型时,关注点在于特定环境、特定情境下的单个基因。因此,你衡量误差的方式不是在整体层面,而是像“在这种条件下,这个特定组织中的这个特定受体”是否表现正确。所以,我们会关注Rob研究领域内非常具体的区域,让他去检查那些在特定情境下应该开启或关闭的基因。如果你对这些很了解,如果模型没有准确描述整个分布情况,你很快就能察觉出来。

Rob:我认为这一点非常重要,它既是挑战,也是机遇,对吧?挑战在于,为了构建AI模型、训练它、进行推理等,你需要这些聚合统计量来描述模型在多大程度上重现了数据的整体形态。这是训练和评估模型的方式。但与此同时,正如Jeff所说,生物学的大部分,甚至几乎所有生物学,都是关于高度具体的事物的。

我是一个RNA生物学家,但我真正了解的其实只有几个基因,我知道这些基因如何相互作用,它们产生的蛋白质又如何与另外几个蛋白质相互作用,这就是我的专业领域。大多数其他生物学家也是如此,药物也是如此。理想情况下,药物通常只作用于少数几个特定靶点。医生治疗病人也是如此,他们专注于特定领域。

因此,我们必须将这两个目标结合起来:既要有一个能代表整个生物学形态、基因表达数据以及人们做过的所有实验的整体表征,又要确保我们捕捉到了所有细微的细节。因为,我可以告诉你,作为一名科学家,如果有人拿着一个机器学习模型来找我,说:“这个模型很好地代表了所有数据,看我的统计指标多漂亮”,而我一看我最熟悉的那个基因,发现模型似乎完全不理解这个基因在做什么,那么这个模型对我来说就毫无用处。

主持人:这正是我第一次拿到你们发来的模型时做的。我心想:“我要试试我最熟悉的那些实验。”

Jeff:我记得那次,你发回来的正是你最专业的领域。

主持人:就是这些基因,我想看看它们的表现。

Rob:完全正确。这有点像,如果你有一个大语言模型,它生成的文本看起来整体不错,但总有四个词它总是拼错。作为语言的使用者,我们一定会注意到,并且会一直盯着这个错误看。

主持人:所以我想再回到数据的问题上,但在此之前,我必须问:为什么成立一家公司?你们俩都是教授,这本来是你们的本行,你们可以在实验室里做出来,发几篇惊艳的论文,为什么非要以公司的形式来做?

Jeff:这要回到我最初发给投资人的那封邮件。这个想法太酷了,我们想立刻开始行动。我们不想等待。我的意思是,作为一名学术研究人员有很多很棒的地方,但要在很短的时间内抓住一个重大的、颠覆性的想法并迅速推进,现有的学术体系很难做到。所以我们想快速行动,想做大,而成立公司似乎是实现这一目标的最佳方式。我觉得这正是我们选择这条路的主要原因。你觉得呢?

Rob:我完全同意。速度和规模。我们发了那封邮件,进行了一些交谈,然后立刻就开始行动了。我们马上就在做事了。而这正是这件事所需要的。我认为第二点是规模。我们想建立一些东西。就像Jeff提到的,我们在职业生涯中做过很多事情,都非常棒,但我们想做一件能影响大量科学家、甚至可能是整个生物学领域所有科学家的事情。为了做到这一点,我们需要规模。我们不想只建模几个基因表达实验,我们想建模所有我们能接触到的实验。

主持人:是的。我觉得这和我们在科技领域看到的情况很相似,存在一个关键的时机。那么,你们认为在生物学领域,是否也有一个特定的转折点?这个问题可以分为两部分:生命科学和生物制药领域已经经历了属于自己的“ChatGPT时刻”了吗?还是说这个时刻即将到来?我们这个领域是否真正迎来了那个“顿悟”(AHA)时刻?

Jeff:我想把这两个问题一起回答。我认为,从某种意义上说,我们还没有真正迎来属于自己的“ChatGPT时刻”,因为目前还没有很多这样的模型被部署到任何人都可以使用、访问并在此基础上构建应用的程度。即使有些人正在构建类似基础模型的东西,他们也往往是在单个公司内部完成,而不会与其他团队分享。因此,除了一个领域之外,其他领域都很少出现任何人都能使用的基础模型。这个例外是蛋白质领域,感觉那里已经出现了一些进展,比如蛋白质结构预测和蛋白质设计。

我们的一些同事就在这个领域工作,他们的研究方式类似,基于公开的数据集,然后在上面构建模型。我们已经看到,当这些模型被公开后,引起了巨大的兴趣爆炸。因此,我们认为,在生物学的下游应用中,比如在蛋白质等药物靶点识别之后的环节,同样的事情也是可能的。我们非常期待能为此做出贡献。而且我认为,那个时刻正在到来,因为现在有大量的数据集合可供使用,这些数据得到了联邦政府和许多其他组织的支持,现在有机会抓住机遇,去做类似于大语言模型所做的事情。这正是我们解决这个问题的思路。

Rob:我认为,与大语言模型的类比甚至可以更进一步。我现在觉得大语言模型最鼓舞人心的地方,不仅仅是它们能很好地完成我擅长的事情。没错,它们能写文本,这对我很有用,但它们还能做我做不到、也永远做不到的事情。它们能瞬间在任意两种语言之间翻译,编程速度远超任何人类。它们能做到一些目前完全超越人类能力、甚至在我们理解的人类能力范围内可能永远无法企及的事情。

类比到生物学,让我同样感到鼓舞的是——蛋白质结构问题在很大程度上已经被解决,这已经很了不起了。但真正让我感到振奋的是蛋白质设计,创造出以前从未存在、自然界中也不存在的全新蛋白质。我认为,我们可以在生物学的其他领域做到同样的事情。这正是我们在这里为基因表达领域所努力的方向。

主持人:这又回到了数据问题——生物学没有像互联网那样可以随意“爬取”的数据源。虽然有很多论文,但它们很杂乱。你认为这个领域在数据方面需要朝什么方向发展?为什么你认为有足够的数据来构建你们在Synthesize Bio所做的东西?在过去一年多的时间里,你们构建生物学生成模型的数据基础是什么?

Jeff:我认为,选择正确的分子在这里至关重要。在中心法则所涉及的分子中,基因表达数据是被测量条件最多、研究背景最广泛的分子之一。因此,这个领域确实存在一个巨大的机遇:我们可以利用整个领域在各种不同情境下对人体进行测量并记录其RNA数据的事实。虽然没有一个现成的“互联网”可以爬取,但确实存在大量已有的实验数据。

然而,最大的挑战在于,这些数据来自他人,是他人完成的实验。它们没有经过标准化处理,无法直接整合到一个统一的框架中协同工作。因此,将所有这些数据集整合在一起,并将其处理成可以用于训练模型的格式,需要大量的智力劳动和工程工作。我们正是利用了团队整合大量数据集的能力,以及他们在综合和标准化元数据方面的专业知识,使得这些实验的描述在成千上万的人类实验中保持一致和统一,从而构建出能够理解不同条件下、不同组织中、不同治疗方案下基因表达情境表征的模型。

Rob:在这里,我们真的要特别感谢Jeff。他可能没有预见到这些数据能用于训练生成式AI模型,但他很早就看到了创建统一、标准化数据集的重要性和潜力。

Jeff:我的实验室一直在做这件事,虽然我们刚开始时并没有意识到这些数据会成为训练集。我们进行数据标准化和综合主要是为了可重复性,为了帮助科学家更好地工作。这项工作可以说是我们构建原型的基础,它基于我在学术环境中开发的数据。

最终,我们的团队在这些数据的基础上取得了巨大的进展,尤其是在实验描述的标准化和协调方面。但没错,这正是我们产生“顿悟”(AHA moment)的原因之一:我们早已在学术背景下思考这些大规模的数据集合了。

Rob:在构建这个大型专有数据集的过程中,有一件很有趣的事:我们拥有成对的基因表达实验数据,以及我们精心整理的元数据,通过这些数据,我们能看到一些意想不到的东西。我们注意到,相当大比例的实验与我们的模型在训练数据中见过的实验非常相似。具体来说,如果你们不介意我深入一点细节的话——我们想验证我们的模型,于是我们想:“好吧,我们想预测未来的基因表达实验,那就用这个来验证它。”

所以我们选定了一个日期作为训练数据的截止点,所有在此日期之前产生的公开数据我们都用于训练,而在此之后由科学家产生并存入公共档案的数据,我们称为验证集或测试集。我们从未看过这些数据,对我们的模型来说,这些是完全独立的“未来”实验。我们可以讨论我们的模型在这些数据上的表现如何,我认为表现非常好,甚至让我们所有人都感到惊讶,真的非常惊人。

但我想说的是关于元数据的一点。一件非常有趣的事是,因为我们自己创建了所有元数据,我们可以对跨实验的统计数据进行聚合分析。一个有趣的发现是,在我们的训练数据截止日期之后进行的所有未来实验中,大约95%的实验要么处于我们见过的生物情境中(比如原代组织或细胞系),要么涉及我们见过的特定化学扰动(比如小分子药物或生物化合物),或基因敲低(比如用CRISPR对基因进行扰动)等。关键在于,95%的未来实验都处于与我们训练数据非常接近的领域,我们有充分的理由相信,我们的模型不仅可能表现良好,而且应该表现得极其出色。

主持人:那么,你能否举一个具体的例子,说明你或你实验室的成员,或者生物制药生态系统中的某个人会如何使用这个模型?我认为,举一个具体的例子对大家会很有帮助。

Jeff:就我的实验室而言,我的背景是生物统计学,我是在那里获得博士学位的,所以我经常帮助人们设计研究,无论是临床试验、临床前研究,还是一般的科研项目。在所有这些研究中,你都需要确定样本量、目标人群、采样方式等等。有大量问题需要解决,而通常,你只能凭猜测。你试图估算可能的情况,但你在很多假设上都在赌博。而现在,我们不必再做这些假设了。我们可以从各种不同的情境中生成数据,然后选择能最大化成功概率的设计方案。因此,我认为这将极大地加速那些需要预先设计研究的项目。我们现在可以在实际进行研究之前,就“预览”研究的结果,而这是以前无法做到的。所以这真的非常令人兴奋。

Rob:我们开发的模型不仅允许你指定一个实验并生成相应的结果数据,还能将某个实验室或临床样本的数据输入进去,然后模拟如果对它进行修改会发生什么。举个具体的例子,比如你可以输入一个实验描述:“某种特定癌症用某种感兴趣的药物治疗”,然后我们的模型可以模拟出基因表达的结果——这是我们之前讨论过的功能。而我们现在新实现的技术细节是:我们还可以向模型提供这个样本在没有用药时的状态信息。

这非常有趣,因为这些信息可能来自一位癌症患者的活检样本。我们正试图确定最佳的治疗方案,于是我们可以把这些信息输入模型,然后模型就能给出针对该患者、高度个性化的药物效果预测。我认为这才是真正具有变革性的。众所周知,许多学术机构和公司都在努力推进精准医疗,这些努力至关重要且令人振奋。但我觉得我们的贡献在于,我们拥有这个庞大的模型,它几乎可以模拟任何情况,同时还能将结果定制到“一个人”、“一个样本”的级别。

Jeff:我认为这恰恰体现了我们一贯采取的方法:我们想要构建的是大型的基础模型,它能让你应对各种不同的应用场景。我们刚才谈到的两个应用,在科学家看来,它们可能相距甚远,属于完全不同的学术领域,你会去咨询完全不同的人群。但我们的底层基础模型却能够支持这两种应用,以及许多其他的应用。

我最期待的是,某个研究生深夜苦思如何解决他的研究难题时,尝试用我们的工具,并因此推动了整个之前毫无头绪的领域的进展。我们还不知道所有这些应用会是什么,但对我来说,这正是最激动人心的地方:当然,我们可以提出自己的想法,但我更期待看到其他人能用它创造出什么。

主持人:说到这个,让我们快进10年。你设想一下,当你们正在构建的这种工具被每一位科学家掌握,人人都能使用时,未来的实验室会是什么样子?你认为这将在哪些方面改变游戏规则?它不仅会影响日常科研,对整个生物制药生态系统会产生怎样的影响?

Rob:对我而言,我所期待并希望参与构建的未来,是所谓的“生成式基因组学”与湿实验、临床试验之间实现无缝融合。我认为,这些不同领域之间需要持续不断地交换想法和数据。我希望在10年内——或者如果我们推进得够快,也许两三年内——一位科学家就能用他们的电脑,花一个小时用我们的模型模拟一次药物筛选实验。

然后利用这个结果,选择要在湿实验中进行测试的细胞系。拿到实验结果后,再用AI模型来判断:“好吧,我们其实还需要从另一个系统获取数据……” 如此循环往复,形成不同信息源和数据之间的持续互动。

Jeff:我的实验室主要是计算型的,不像Rob那样有湿实验平台。所以对我来说,最大的意义在于赋能。它能让所有和我一起工作的学生、博士后和研究员都获得强大的能力。我们通常需要和像Rob这样的人合作才能生成数据,有时这是做某种实验的唯一途径,但有时我们有一些创新的想法,却找不到合适的合作者。现在,他们可以借助这个工具,去追求那些原本因缺乏合适合作者或资金而无法实现的“疯狂”想法。

第二点我经常思考的是,我们在科研上做了多少“赌注”。我们必须在人力、资源上押注,而这些押注往往基于非常有限的信息。你读了一些文献,知道你的朋友在做什么,然后你就赌下一个想法是对的,实验会成功。作为一个与许多不同实验室合作过的人,我亲眼目睹了多少这样的“赌注”最终失败,这对科学本身的速度,以及对从事这些项目的研究人员的职业生涯和生活都造成了巨大影响。

因此,我非常兴奋的是,我们能提高每个科研“赌注”的成功率。让研究者能提前看到一点结果,做出更好的决策。即使我们只将成功率提高15%、20%或30%,这也意味着为整个领域节省了大量的资源和时间。

Rob:我们的愿景是,我们正在构建的东西可以在整个研究链条和药物开发的价值链中被使用。我们刚才举的例子大多是基础研究或转化研究,但我希望我们的模型也能在临床环境中同样有用。早些时候我提到,科学家们常常要做一些艰难的决定:你手头有一定数据,这些数据不足以得出结论,但你必须做出决定。一个很好的例子就是临床试验。一期临床试验的目的是测试药物安全性,仅此而已。

然而,如果你能从中获得任何关于疗效的信息,那将非常有价值。于是人们就陷入一种困境:他们使用一个本没有足够统计效力来得出疗效结论的试验,只能“看天意”地寻找疗效信号,以此来决定是否继续推进。这是一个非常重要的决定,因为如果你选择了这个项目,很可能就会放弃另一个。这不仅仅关乎这一种药物,而是关乎你所有的“投篮机会”。

我们正在积极研究这一点:把我们的模型拿出来,以一个小规模一期试验(比如只有12名患者)的结果作为条件,然后推断出如果进行一个数百名患者的、完全具备统计效力的试验,结果会是什么样。当然,这不能替代一个耗资一亿美元的试验,但它提供的信息比你之前多得多。

Jeff:而且还更便宜。

Rob:确实便宜得多。这能帮助你做出更好的决策。

Jeff:如果你要下1亿美元的赌注,你肯定希望在下注前掌握一些信息吧?

Rob:没错!这能让你更有信心地决定是放弃这个项目,还是加大投入。

主持人:非常感谢你们今天抽出时间。最后留给你们一分钟。人们可以去哪里了解更多关于Synthesize Bio的信息,获取你们的模型,开始成为一个能被基础模型赋能的科学家?

Jeff:大家可以上 Synthesize.bio这个网站,通过我们的网络平台直接访问模型。我们也提供API接口,方便大家在R和Python环境中使用——这也是很多计算生物学家的工作环境。他们今天就可以去访问这些模型,也可以阅读我们关于GEM-1模型的预印本论文,了解我们是如何严谨地评估结果的,确保我们始终以怀疑精神对待科学。

Rob:我想再强调一下,我们真心希望尽可能多的人使用我们的模型。目前我们正在免费提供,无论你在何处、从事何种工作,任何人都可以试用我们的模型,看看它们在哪些方面表现良好,并告诉我们哪些地方还有不足。

因为我们这个模型的酷炫之处在于,它几乎可以用于生物医学研究的任何领域。我们仍在探索,究竟在哪些领域会产生最具变革性的影响。就像大语言模型一样,五年前,我不会告诉你LLM会彻底改变编程,我想没人会这么说。我们也在摸索,我们的模型将在哪些领域带来速度和科研能力的最大提升。

主持人:太棒了!我超级兴奋。我认为我们还处在非常早期的阶段,所以我非常期待看到它将走向何方。正如我所说,属于生物学的“ChatGPT时刻”还没到来,但我相信这将对未来药物开发产生深远影响。再次感谢两位今天的分享

【免费】cursor-auto-free是一个能够让你无限免费使用cursor的项目。该项目通过cloudflare进行托管实现,请参考教程进行配置。

视频教程:https://www.bilibili.com/video/BV1WTKge6E7u/

项目地址:https://github.com/chengazhen/cursor-auto-free?tab=readme-ov-file

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0