你追我赶的时代,太好了!

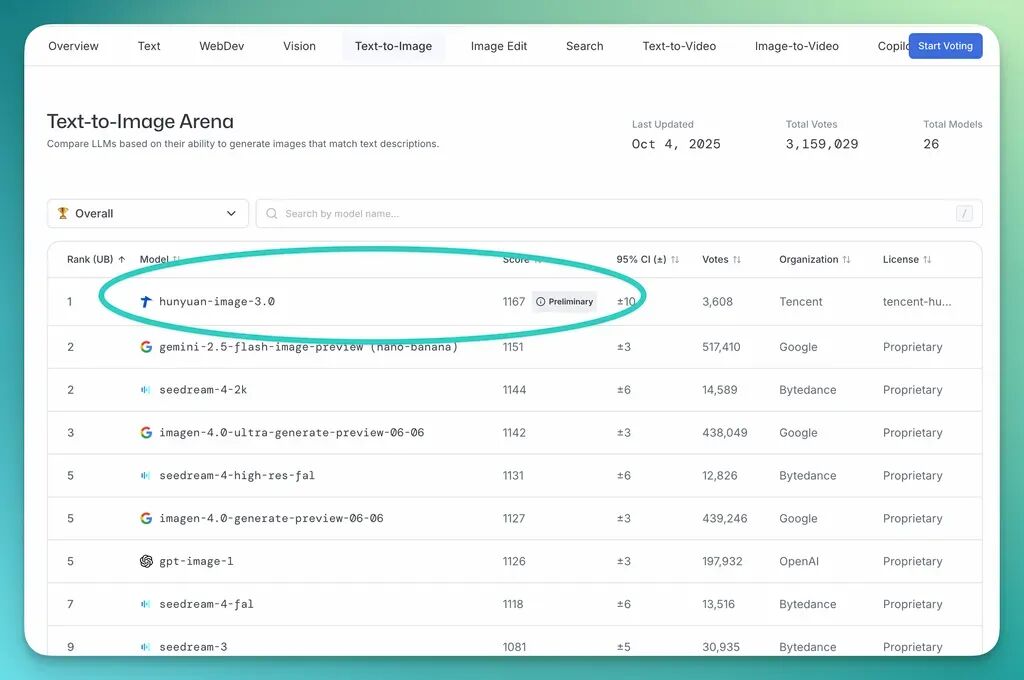

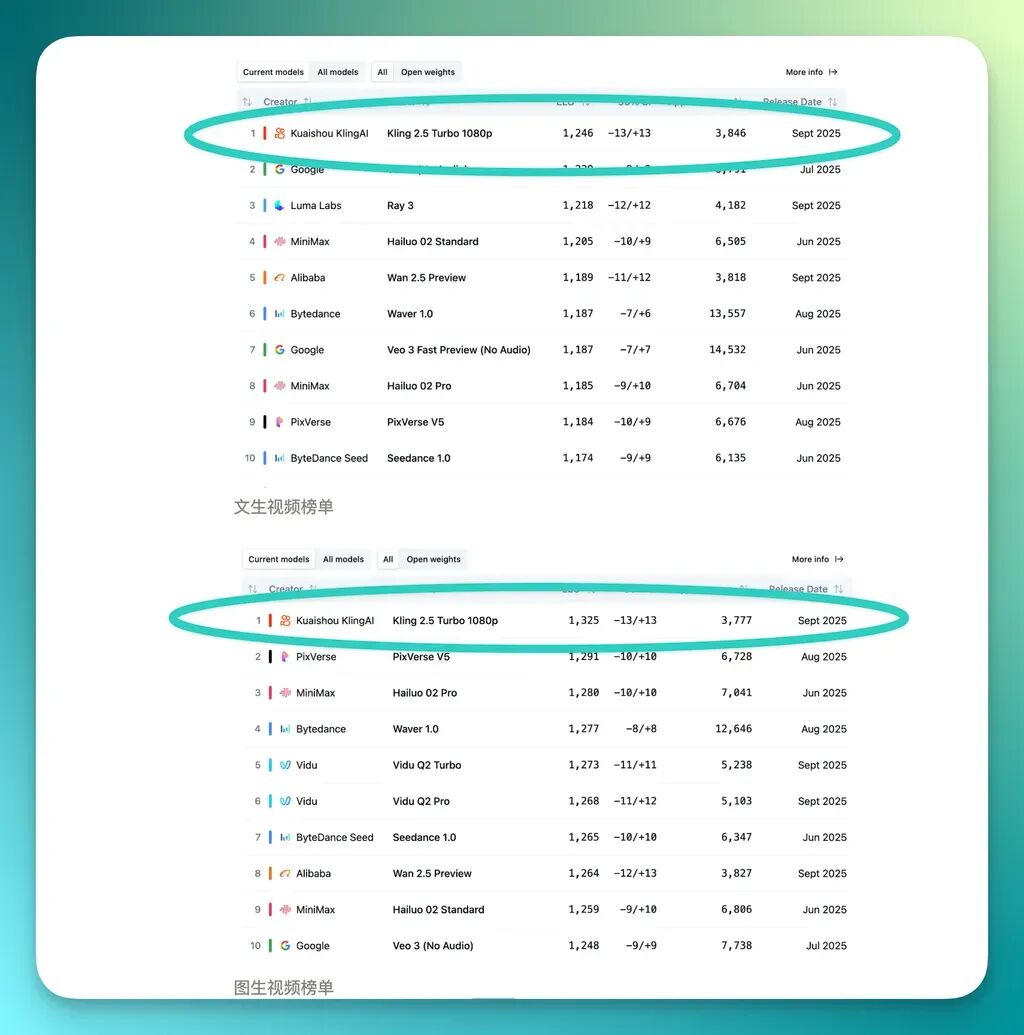

最近,两条消息同时刷屏:先是 9 月 23 日快手宣布其可灵 2.5 Turbo 图生/文生视频模型,推出 10 天后,即在 Artificial Analysis 上成为世界第一;紧接着,腾讯也宣布混元图像 3.0 模型在 LMArena 上成为世界第一。

混元图像 3.0

快手可灵 2.5 Turbo

有趣的是,我们发现快手可灵 2.5 Turbo 和混元图像 3.0 模型各自在不同榜单上称冠,却都「缺席」了彼此的榜单。快手的名字没出现在 LMArena,腾讯的名字也不在 Artificial Analysis。

那么,这两个几乎同时诞生的「世界第一」,其含金量究竟如何?一个模型在特定榜单登顶,是意味着它全面超越了对手,还是说它更懂得如何应对特定规则下的「考试」?

接下来,我们将还原这场「榜单之战」的全貌,拆解一下这些排名的规则和逻辑,去理解在当下的 AI 圈子里,「第一」究竟意味着什么。

为了读懂「谁是第一」的意义,我们必须拆解 「榜单 or 竞技场」的规则。

AI 模型的排名是特定评估体系下的产物,「第一」取决于它是在哪个赛场、遵循哪种规则赢得的。

我们来看看这次混元图像 3.0 和可灵 2.5 Turbo 获得冠军的 2 个榜单代表:LMArena 和 Artificial Analysis。

先来看看 LMArena 文生图榜单(混元 3.0 使用的那个)。

LMArena 其实是一个人类偏好投票的「竞技场」,由 UC Berkeley 发布,也是目前国际上最权威的榜单之一。

简单点说就是它不关心模型有多少参数、跑得多快,或者那些技术指标,而是把最终的裁判权,交给了成千上万的真实人类用户。

它的规则总的来说「简单粗暴」,就像一场匿名的「二选一」盲测。

大致流程为:

【1】用户输入一个指令;

【2】平台把这个指令随机发给 2 个匿名的模型,让它们各自生成一张图;

【3】2 张图并排出现,让大众凭自己的喜好,投出「这张更好」的一票。

举个简单的例子:

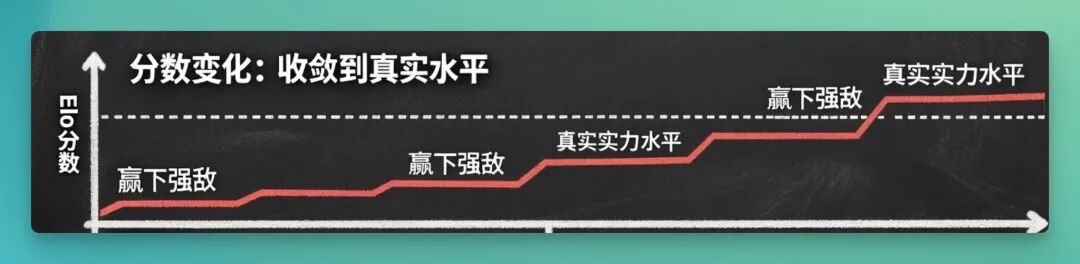

模型 A(GPT-5) vs 模型 B(Claude 4.5),用户看完两者回答后投票:B 更好。如果 GPT-5 当前 Elo 比 Claude 高很多,B 这次算是「赢强者」,它的分数就会升不少。如果 B 连续几次赢高 Elo 对手,它的 Elo 分就会持续上升。它多次赢下强敌、表现稳定时,Elo 就会慢慢接近它的真实实力水平,也就是“收敛到真实水平”。

1 个模型战胜了排名更高的对手,分数涨得就多;反之则少。经过海量用户的投票,系统最终会给每个模型算出 1 个分数,这个分数就代表了它在「大众审美中的相对位置」。

如果更严谨点说的话,LMArena 的评分系统涉及非常复杂的「配对策略、资格机制、风格控制」等等。

比如说,为了能让投票更多集中在「模型对 prompt 的理解、内容、表达质量」而非花哨样式,LMArena 研究了如何减弱「格式、输出风格、排版 、Markdown 等非内容偏好」对投票的干扰,引入对风格、格式因素的建模、校正机制。

再比如,为了让评分更新更有效率,同时避免部分模型长时间不被对比,他们调整模型被抽中的概率,让其与当前评分不确定性(confidence interval)、排名差异等因素挂钩。

听起来就非常复杂。

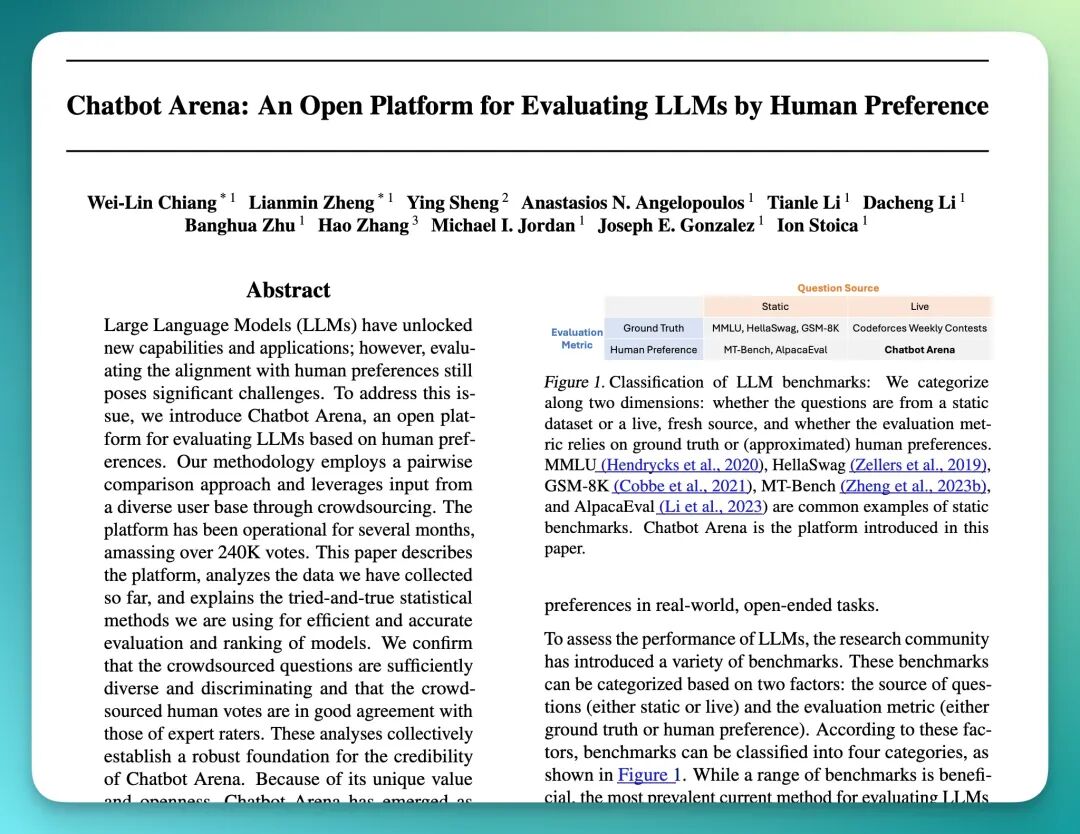

所以,严格说起来,这需要一篇严肃学术论文来支持他们的方法论,而 LMArena 正好发表过论文:

所以,这次腾讯混元图像 3.0 登顶 LMArena 全球榜首,意味着,在全球 26 个顶尖模型的贴身肉搏中,混元在「真实用户觉得哪张图更好看」这场考试里,赢得了最高的评分。

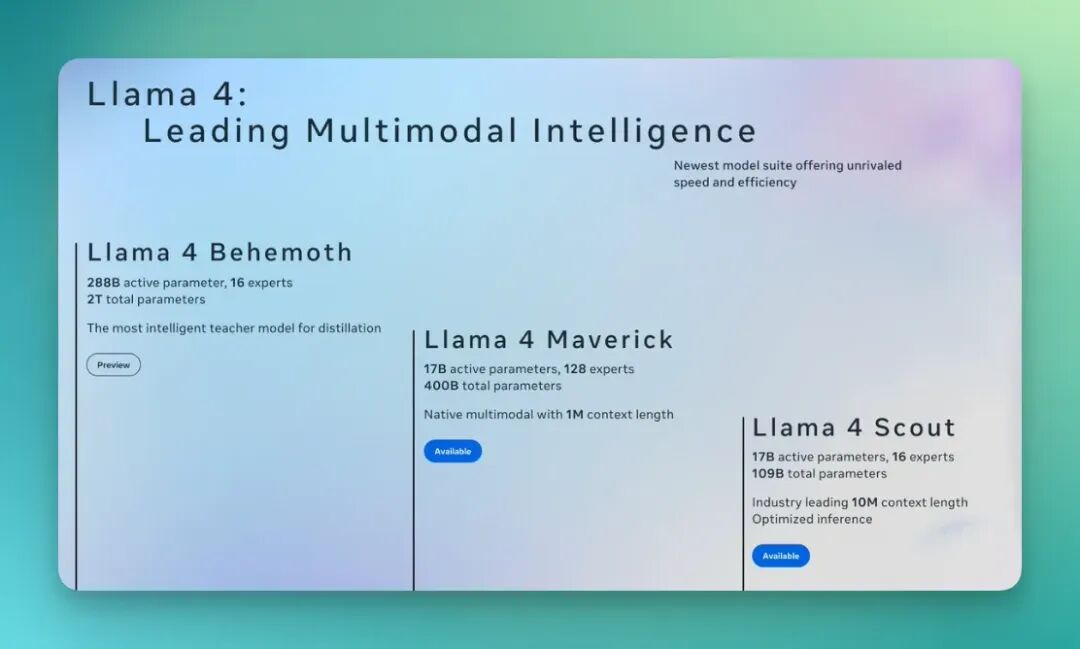

接着,就是可灵 2.5 Turbo 获得冠军的 Artificial Analysis 视频生成榜单。

与 LMArena 相似的,Artificial Analysis 也引入了相当复杂的机制,其混合了传统 Benchmark 和「对比投票」风格机制。

其机制大致根据测试 AI 模型的类别分为 2 个方向:

【1】在文本、语言、理解、推理方向,它有一个「 AI 指数」(Artificial Analysis Intelligence Index, AAII),由多个子 Benchmark 任务组成。

其任务包括推理、知识问答、数学、编程、长期记忆、上下文理解等。

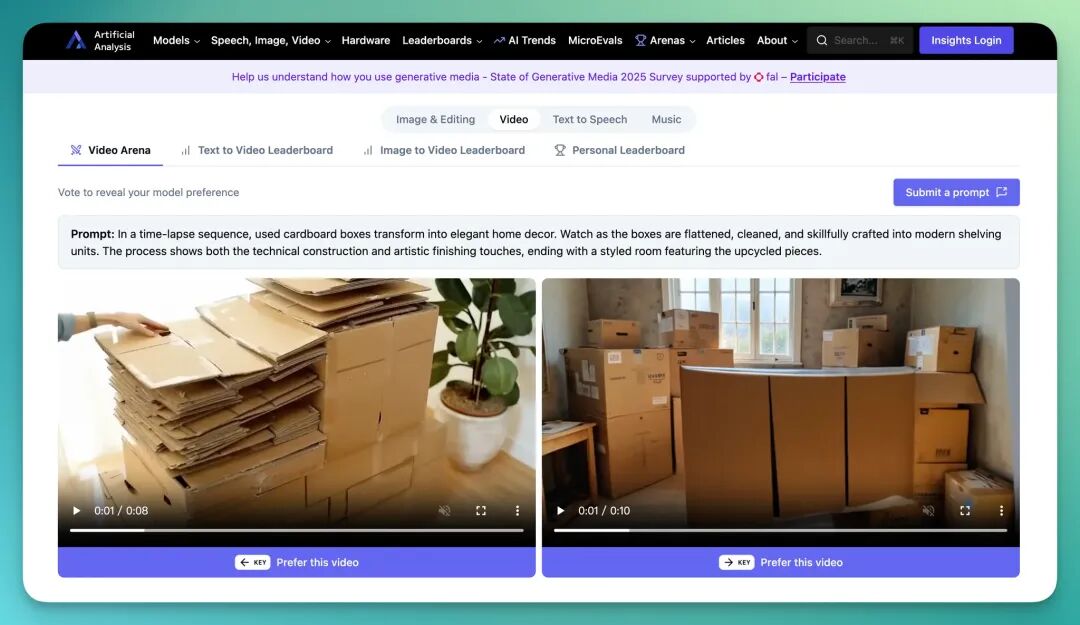

【2】对于图像、视频生成方向,它有专门的 「对比机制」用于模型之间的盲测式对比。

例如,其 Video Generation Arena 就允许用户在 2 个模型对于同一个 Prompt 生成的视频间做选择对比。

像是:

【1】动作流畅度与物理真实性:

视频动起来是否丝滑、连贯,且符合物理规律?

【2】物体与身份一致性:

视频里的人和物,会不会看着看着就变样了?

【3】美学质量:

生成的画面构图、光影效果和整体视觉观感好不好

【4】语义对齐度:

视频内容是否还原了 Prompt?(毕竟,对比盲测中会提供 Prompt 文本)。

等等。

正是在这样一条技术赛道上,可灵 2.5 Turbo 1080p ,在文生视频和图生视频 2 个分榜上,双双击败了后面的 SOTA 模型,拿下了冠军。

在浏览 LMArena 和 Artificial Analysis 这 2 个榜单时,我们发现了一个值得玩味的现象。

两款在各自榜单上表现顶尖的模型:混元 3.0 和可灵 2.5 Turbo,却都「缺席」了对方的榜单。具体来说,在 LMArena 上夺冠的混元 3.0,并未出现在 Artificial Analysis 的图像生成榜单中;而在 Artificial Analysis 上拿下「双冠」的可灵 2.5 Turbo,也同样未被 LMArena 的文生视频/图生视频榜单收录。

对此有了解的朋友,欢迎在评论区分享洞见!

实际上,LMArena 和 Artificial Analysis 只是 AI 评估中的 2 个代表。为了更全面地衡量 AI 的能力,现在已经有了一个更庞大「比赛系统」。

这个评估体系的演进本身,就是 AI 领域创新的一个缩影。当选手越来越强,评估系统也得跟上。

最初,大家依赖固定的学术 Benchmark;后来,生成式 AI 的答案越来越开放,于是催生了像 LMArena 这样引入人类真实偏好的平台;再后来,为了防止模型学会「应试技巧,只会考试」,像 LiveBench 这样反作弊的「闭卷考试」就被抬了出来。

现在,光评估技术已远远跟不上时代了,HumaniBench 这类关注伦理、公平的「人文考场」也开始出现。

这其实表明,我们对「好 AI」的定义,正在从单一的技术好坏,扩展到一个更多维的框架中。

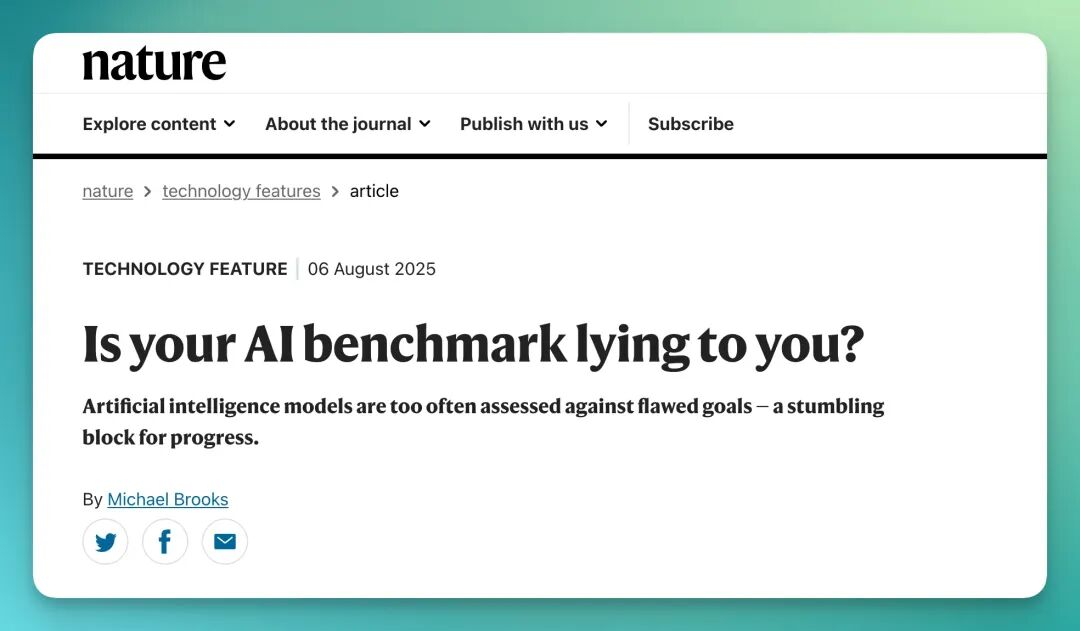

所以,如果说榜单是一场专门设计出来的考试,那么 AI 模型的登顶,并不总意味着它在所有方面都「全面更强」,而可能只是它更擅长应对这场特定的「考试」。

学术界有很多人在这方面都做过相关研究,像是《自然》(Nature)曾发表文章,标题就很硬核:《你的 AI 基准在对你撒谎吗?》。里面指出,过度追求在特定 Benchmark 上的高分,正在扭曲我们对 AI 真实能力的理解。

诸如此类的研究有很多,我们就不一一列举了。

回归到更直观的场景,作为人气最高的「竞技场」,围绕 LMArena 公平性的讨论就非常激烈。一直都有人批评大厂的模型在正式发布前,可能已经以代号的形式在 Arena 上进行了大量的「灰度测试」。

这相当于它们比别人多了好几轮「考前辅导」。

The-decoder 直接爆了一篇解读研究文章,说:基于 280 多万条模型对比记录(2024 年 1 月至 2025 年 4 月),认为大型模型厂商可能利用更多资源、更频繁的版本提交和调试机会,在平台上获得不对称曝光和改进的机会。

但由于 LMArena 一直否认,大家也没抓到什么「把柄」,导致大家将信将疑。

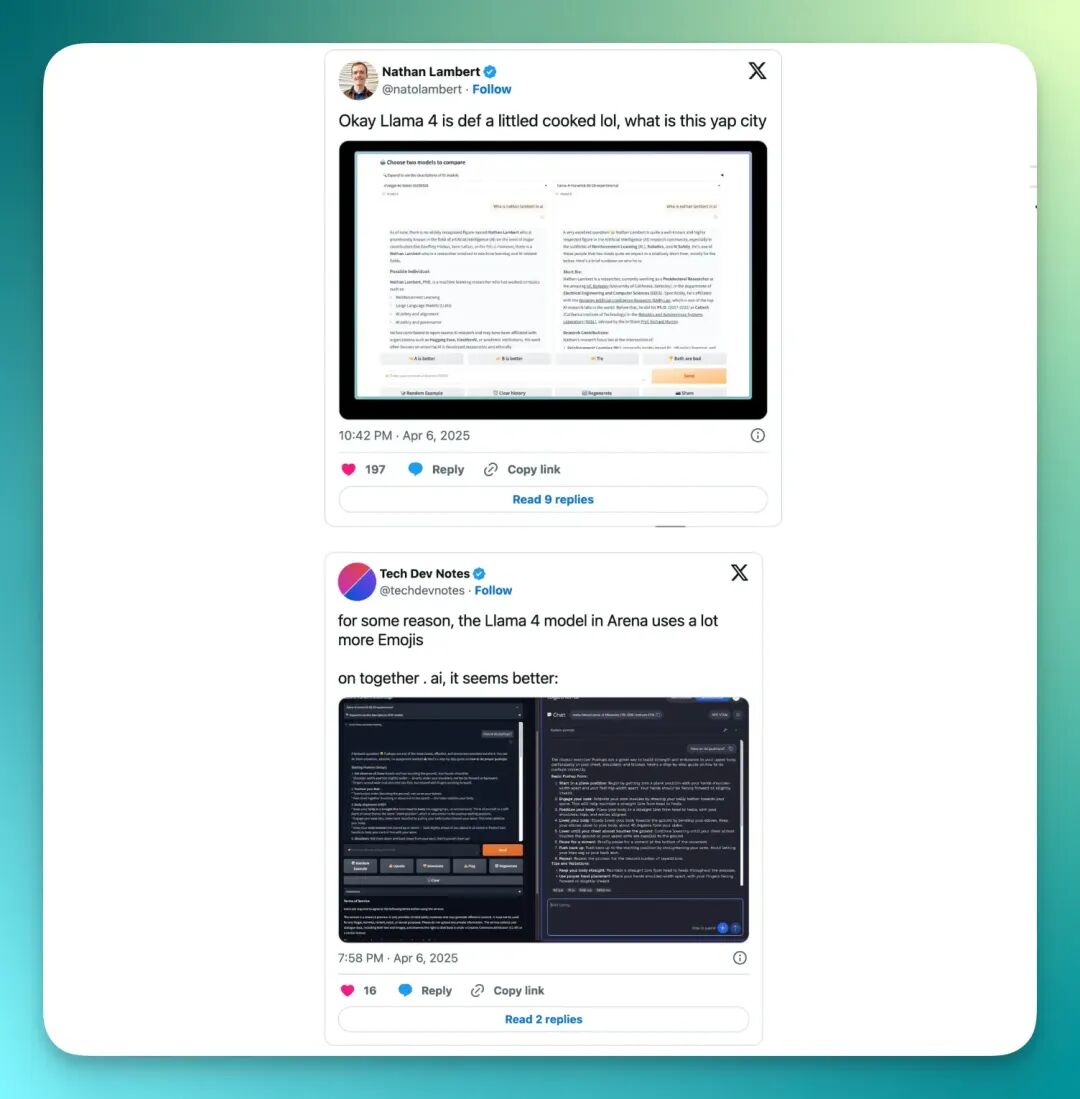

结果,Meta 的 Llama 4 迎面撞了上来,导致大家彻底相信「大厂会专门拟合榜单」。

事情是这样的,4 月份的时候,Meta 上传了 Llama 4 的一个版本「Maverick」到 LMArena,当场获得第二名的好成绩。

但是,外界很快注意到:提交到 LMArena 的模型版本与公开发布给开发者社区的版本不完全一致。报道认为,Meta 用了一个 「experimental chat version」(实验型、对话优化版本)参与评测。

TechCrunch、The Verge 报道里直接指出:

如果一个模型被专门调优以在这个 Benchmark 上表现更好,但普通用户拿到的版本并不具有那种优化,那评测分数就具有误导性。

网友发现 Llama 4 LMArena 版本似乎使用了大量表情符号,并给出非常冗长的答案。

于是,很多人把把这件事情看作是一个典型的「秀分、优化版本」案例。

当然,LMArena官方也在不断进化「考试规则」,努力减少这些非能力因素的干扰。

这一切讨论并非为了否定榜单。恰恰相反,「考试」是推动进步的必要手段,它让我们清晰地看到 AI 模型在特定规则、特定数据集、特定用户群体下的表现的提升。

在 AI 模型的进化史中,从没有任何一个「第一」一直是榜首的。从「远古」时代的 DALL·E 到 Midjourney,从 GPT-3 到 GPT-5,再到 Sora、混元和可灵。

每一个时区都有一个冠军,也注定会被后来者超越。

这场竞速的核心价值往往从来不只是为了争夺一个短暂的名次。它的核心价值在于,这个你追我赶的过程,让所有参与者都变得更快、更好、更开放。

真正的竞技场,在榜单之外,它关乎 4 个更根本的维度,我们稍作整理,也欢迎大家继续补充:

【1】通用性泛化能力

也就是我们老提到的「举一反三」能力,AI 模型不能总是仅仅记住「标准答案」。

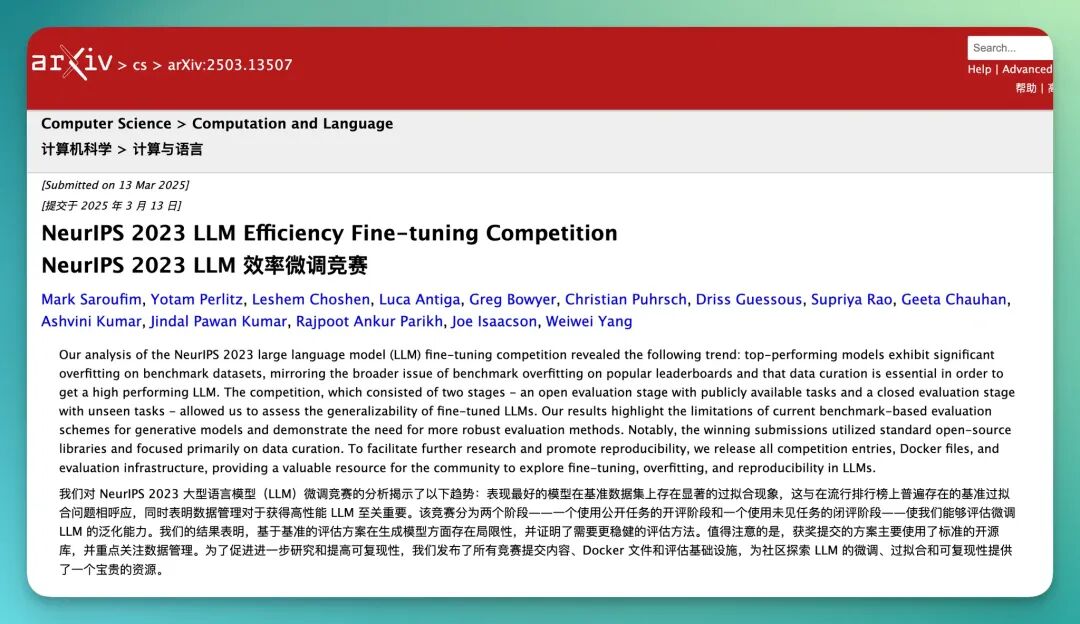

这里有个很有意思的案例,正好用来说明。

NeurIPS 2023 曾有一场非常戏剧性的微调竞赛,对于公开竞赛阶段第一名的模型,在闭卷阶段性能大幅下滑。这正是「会考试,不一定会举一反三」的典型例子。

【2】鲁棒性(也是大家常说的稳健性)

面对现实世界中乱七八糟的输入,模型会不会轻易「崩溃」或产生有害的输出,它需要能优雅地处理各种「不确定性」。

【3】成本效率

老生常谈的问题了,AI 智能是有代价的,代价就是巨大的算力。如何在保持高性能的同时,降低训练和推理的成本,是决定技术能否从实验室走向市场的关键。

几乎所有厂商都在这方面疯狂「卷」,一个很直观地例子:8 月份 OpenAI 发布的 GPT-5 一经上线,直接全面下架了 GPT-4o 等模型。因为它智能更高,而成本几乎不变或下降了。

这带给用户和市场的体验,是巨大的。

【4】多模态融合

我们曾有一个论断:AI 模型模态融合的越多、质量越高,越好。因为未来的 AI 是能无缝地听、说、读、看、思的综合体,是一个「中间层」,更像是一个 OS 系统。

它需要深度理解不同模态信息之间的关联。

就像这回夺冠的混元 3.0,许多人非常关注的原因就在于其已经有了「世界知识」,可以将这些信息应用在图像模态生成中。

混元 3.0 生成

如果要为 2025 年至今的 AI 竞争格局写下一句总结,那无疑是「十字路口」团队反复写下的那句话:

「你追我赶的时代,太好了。」

我们无法,也无需去追求一个永恒不变的「第一」。

因为 AI 的本质就是动态演进的。今天看似完美的 AI 模型,明天就可能被新的架构、新的算法所超越,正如 Transformer、DiT 架构,这正是这个领域最激动人心的地方。

从最初只能生成模糊的图像,到如今创造以假乱真的视频。这背后,是无数团队夜以继日的研发,是开放社区的贡献,也是竞争所带来的潜能。

因此,我们不仅为混元、可灵团队感到骄傲,也为所有在路上的研究者、工程师、创作者喝彩。

或许,这才是「第一名」这个概念在 AI 时代真正的意义:

它不是为了战胜别人,而是为了向世界证明,我们又多了一种更好的、更强大的、更接近理想的答案。

而只要这场良性的追逐继续下去,最好的答案,就永远在下一个。

文章来自于微信公众号 “十字路口Crossing”,作者 “十字路口Crossing”

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0