2025年末,谷歌通过Kaggle平台,以前所未有的力度,连续推出了两个为期五天的线上强化课程。这不仅仅是两次普通的线上分享,更像是一场由谷歌顶级机器学习(ML)研究员和工程师亲自引领的、深入探索生成式AI及其前沿应用——AI Agents(人工智能代理)的集训。

第一个课程 “5-Day GenAI Course” 是一个自定进度的综合性课程,与2025年3月31日至4月4推出的,全面覆盖了从大型语言模型(LLM)的基石技术到高级应用和运维(MLOps)的全链路知识。

https://www.kaggle.com/learn-guide/5-day-genai [1]

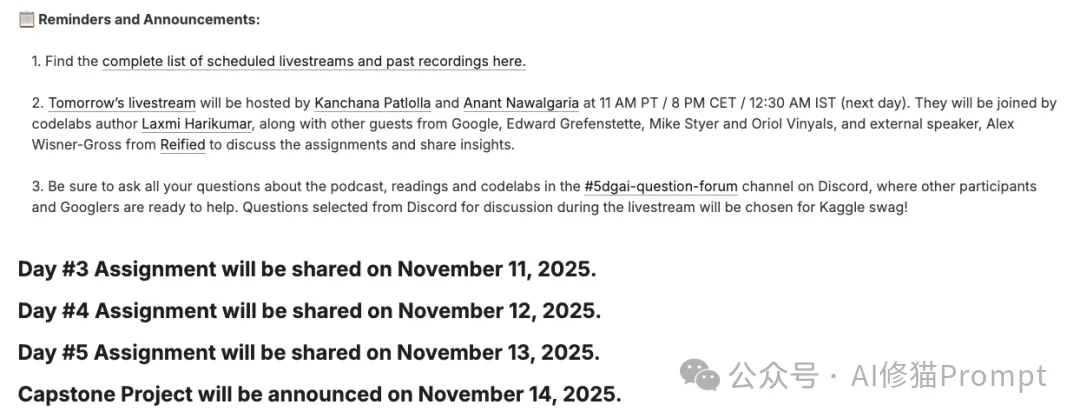

第二个课程 “5-Day AI Agents Intensive Course” 则更加聚焦于未来,于 2025年11月10日至11月14日 期间,带领开发者深入探索AI Agents的构建、评估与部署。

https://www.kaggle.com/learn-guide/5-day-agents [2]

对于任何希望在AI领域从入门到精通的开发者、研究人员或是技术爱好者来说,这都是一个不容错过的机会。课程内容从LLM的基石,到构建能够与真实世界交互、解决复杂问题的AI Agents,层层递进,干货满满。

谷歌为这两个课程配备了超过9份详尽的白皮书,随着后续三天的课程应该还有至少3份pdf文件。每一份都由内部专家撰写,深入剖析了从模型原理到运维实践的方方面面。这些白皮书不再是高高在上的理论陈述,而是与Kaggle上的Codelab动手实验、由NotebookLM生成的总结播客(音频)以及专家直播紧密结合的实战手册。

那么,这两个五日课程究竟涵盖了哪些硬核内容?那9+N份被反复提及的白皮书又藏着哪些宝藏?本文是一份非常准确的报告,可以成为您阅读这些材料入门指南。

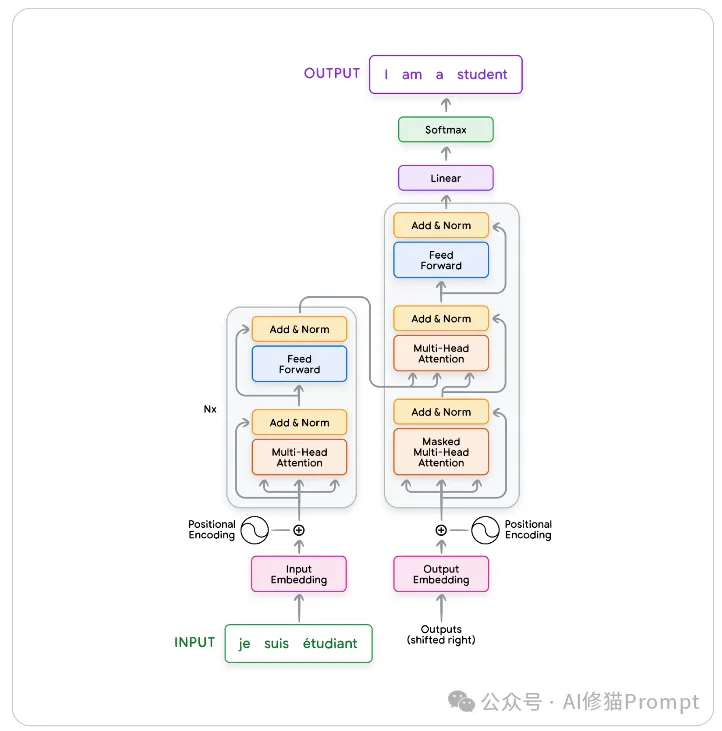

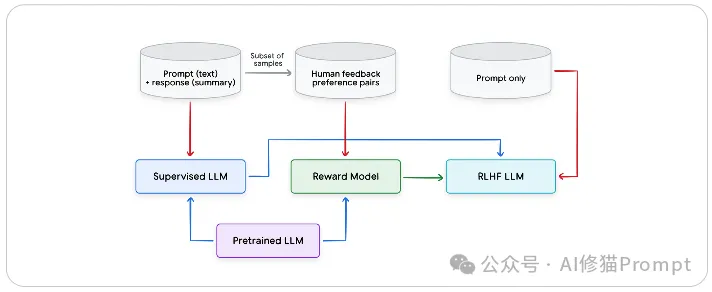

欢迎来到第一天的学习!今天,您将探索大型语言模型(LLM)的演进历程,深入理解其背后的核心技术,并掌握与LLM高效互动的艺术——提示工程。

这份白皮书是您进入生成式AI世界的第一站,它将详细拆解构成现代LLM的技术基石,让您对“黑箱”之内有清晰的认知。

核心内容概览:

如果说LLM是一辆性能强悍的赛车,那么提示(Prompt)就是方向盘和油门。掌握提示工程,意味着您能精准地驾驭模型,使其按照您的意图行驶,发挥最大潜能。

核心内容概览:

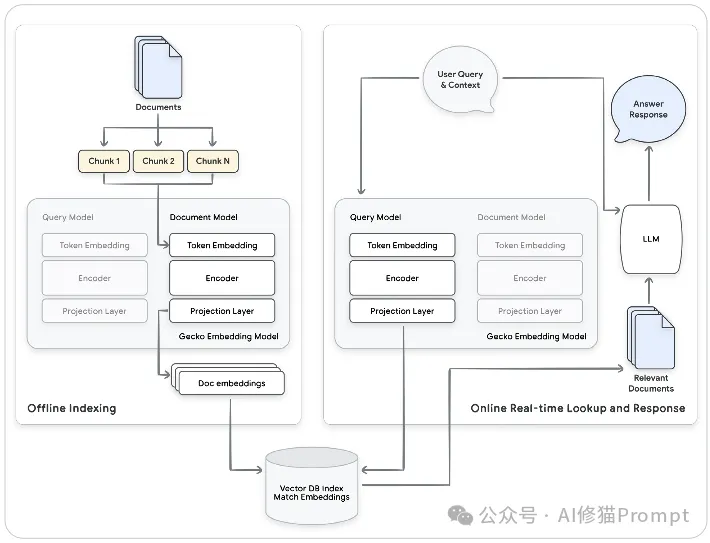

第二天,您将学习如何利用嵌入(Embeddings)和向量数据库,将您的私有数据或实时信息引入LLM应用,这也是构建强大的检索增强生成(RAG)系统的关键。

数据是AI的燃料,而嵌入(Embeddings)则是将文本、图像、音频等多样化的数据,转化为AI能够理解和处理的通用语言——高维向量。这份文档将带您深入探索数据表示的艺术。

核心内容概览:

第三天,您将学习构建复杂的AI代理,理解其核心组件、开发流程以及更高级的多代理协作架构。

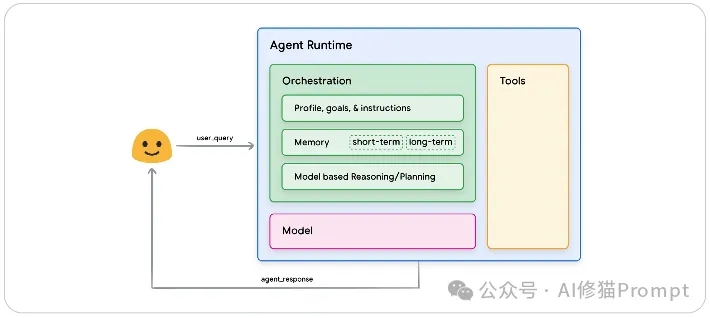

AI代理是生成式AI的下一个前沿。它不再仅仅是一个被动的问答机器,而是一个能够理解目标、制定计划、并调用工具自主完成复杂任务的智能体。

核心内容概览:

这份文档将带您深入多代理世界,并探讨如何将代理应用投入生产环境,确保其质量、可靠性和效率。

核心内容概览:

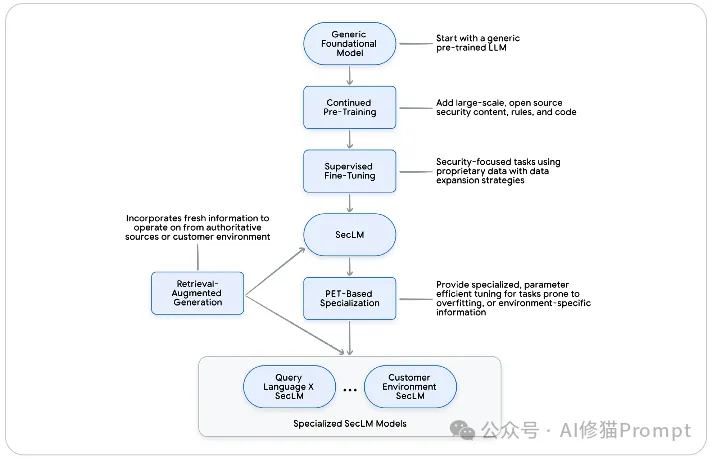

第四天,您将深入了解如何创建和应用专为特定行业(如网络安全、医疗健康)打造的LLM,并学习如何使用您自己的数据对Gemini模型进行微调。

通用大模型虽然强大,但在需要深度专业知识和极高准确性的垂直领域,经过“精装修”的领域模型往往能发挥出更大的价值。

核心内容概览:

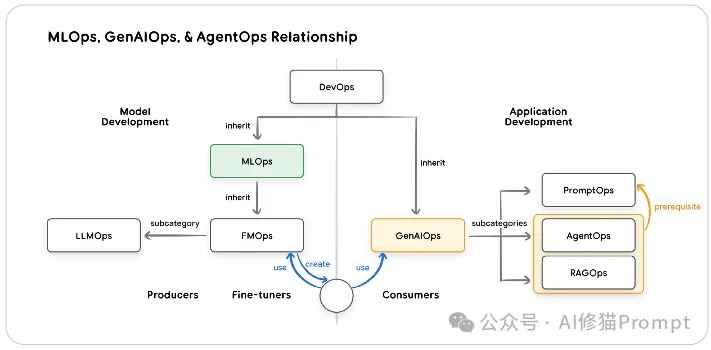

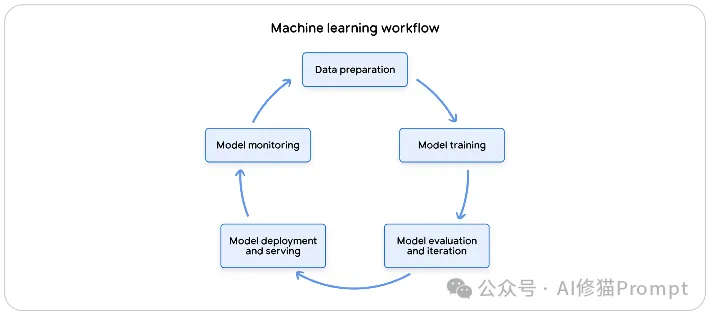

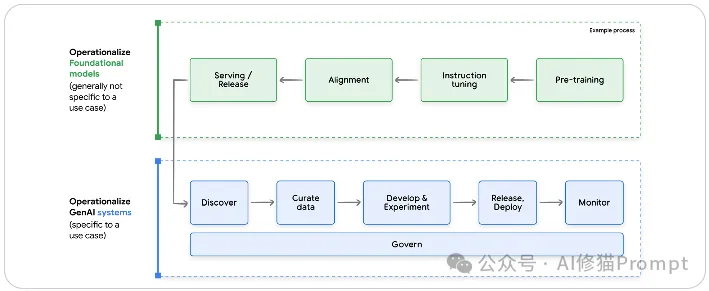

第五天,您将学习如何将传统的MLOps实践应用于生成式AI,并利用Vertex AI的强大工具来运维和管理您的GenAI应用。

从一个Jupyter Notebook中的实验到一个稳定、可靠、可扩展的生产级应用,中间隔着一整套系统化的工程最佳实践。这份文档是您将GenAI项目成功落地投产的终极行动指南。

核心内容概览:

课程时间:2025年11月10日 - 2025年11月14日

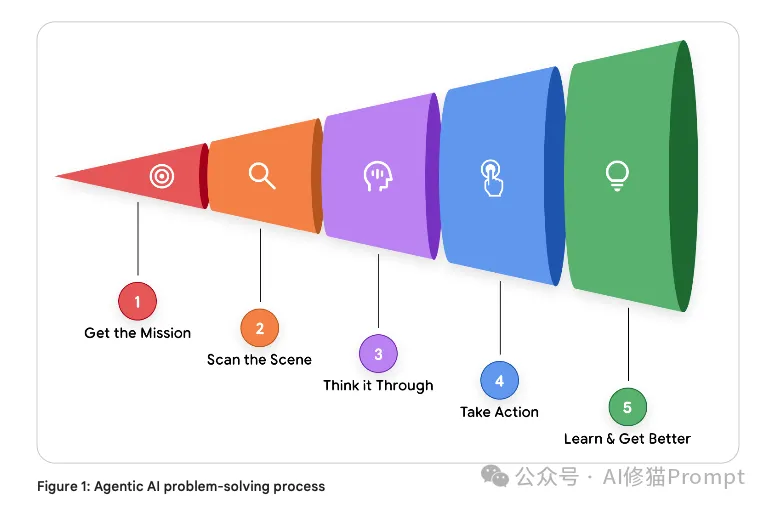

这个为期五天的强化课程,旨在帮助开发者探索AI代理的基础和实践应用,学习其核心组件——模型、工具、编排、内存和评估,并最终将代理从原型推向生产。

这本白皮书介绍了AI代理,提出了代理能力的分类法,强调了AgentOps对于可靠性和治理的重要性,并讨论了通过身份和约束策略实现代理互操作性和安全性的重要性。

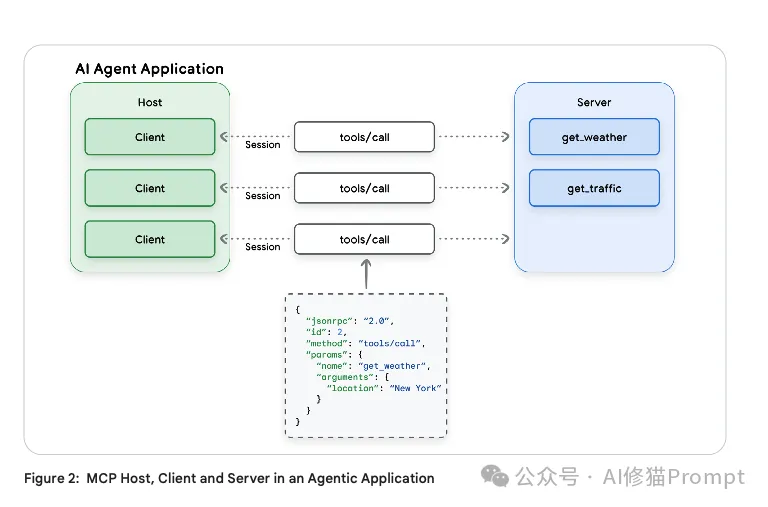

今天的白皮书聚焦于外部工具,这些工具允许代理执行其训练数据之外的操作或检索实时数据,并介绍了设计有效工具的最佳实践。您还将了解模型上下文协议(MCP),重点介绍其架构组件、通信层、风险和企业准备度差距。

Tool定义,但也涵盖了Resources, Prompts, Sampling, Elicitation等其他能力,尽管后者目前支持度有限。

最后,希望这篇文章能让你掌握生成式AI的核心技术,更能具备将其应用于实际问题、创造真实价值的工程能力。所有资料我将在群里分享,欢迎来聊。

[1]: https://www.kaggle.com/learn-guide/5-day-genai

[2]: https://www.kaggle.com/learn-guide/5-day-agents

文章来自于“Al修猫Prompt”,作者“Al修猫Prompt”。

【开源免费】OWL是一个完全开源免费的通用智能体项目。它可以远程开Ubuntu容器、自动挂载数据、做规划、执行任务,堪称「云端超级打工人」而且做到了开源界GAIA性能天花板,达到了57.7%,超越Huggingface 提出的Open Deep Research 55.15%的表现。

项目地址:GitHub:https://github.com/camel-ai/owl

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales