复杂的简历,AI也能读懂了。

阿里巴巴集团研究团队,开发出了一套基于布局感知的简历解析框架。

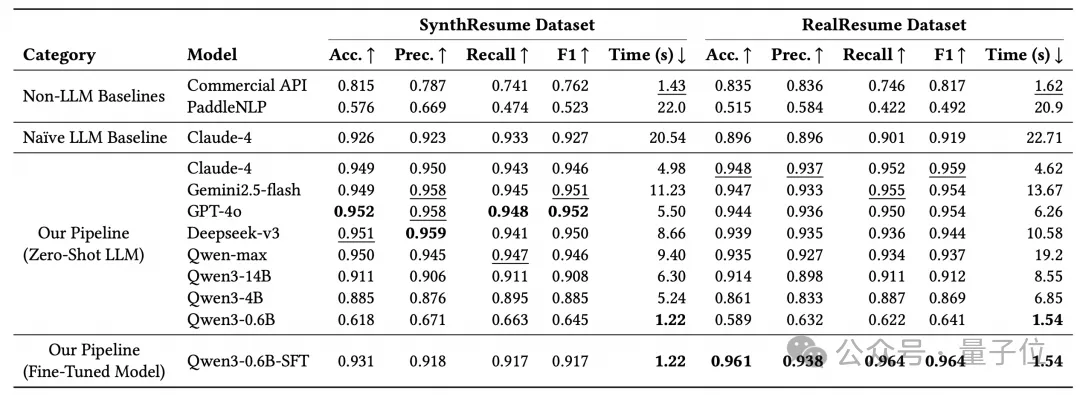

该框架在简历解析任务上的准确率逼近Claude-4等业界顶尖大模型,处理整份简历仅需1-2秒。

而且这项创新直击自动化简历解析的三大痛点——版面格式多样、大模型成本高昂及响应速度慢,为智能招聘树立了新的效率与精度标杆。

该技术框架的论文《Layout-Aware Parsing Meets Efficient LLMs: A Unified, Scalable Framework for Resume Information Extraction and Evaluation》已发布。

长久以来,自动化简历筛选一直是企业招聘的痛点。

面对多栏、图文混排等五花八门的简历格式,基于规则的NER实体识别和传统AI模型常常“束手无策”。

而直接使用强大的通用大语言模型,又面临着响应延迟高、计算成本昂贵的困境,难以满足大规模、高实时的工业级应用需求。

阿里巴巴的这项研究直面以上挑战,提出了一个创新解决方案。

传统模型按部就班地阅读文本,遇到简历的复杂布局时,模型使用传统方法需要进行文档理解,链路会带来大量耗时。

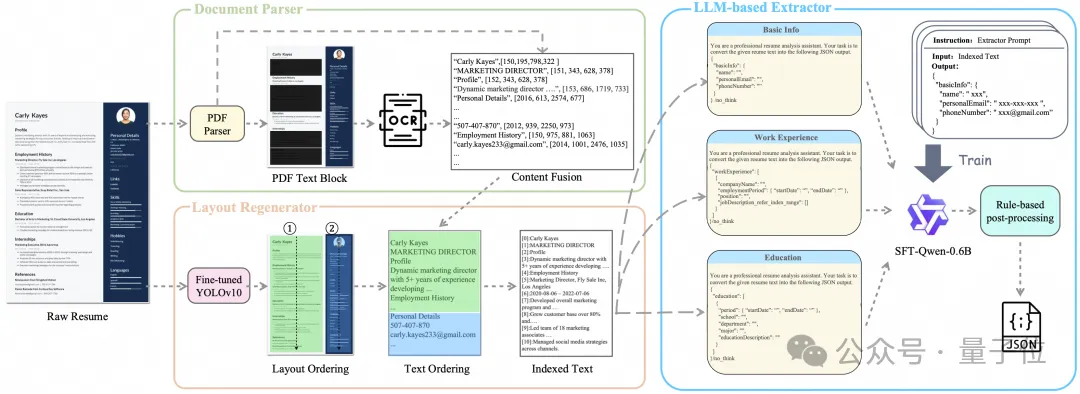

而阿里的新框架首先引入了一个“布局感知解析器”。

它如同人类的眼睛一样,能够看懂简历的整体结构,无论是左边的个人信息栏,还是右边的工作经历,都能被识别并分割成独立的逻辑区块。

随后,系统会将这些区块按照人类的阅读习惯重新排列组合,形成一个清晰、有序、带索引的文本。这一步骤解决了布局混乱带来的解析难题,为后续的精准信息提取奠定了坚实基础。

在解决了布局问题后,真正的优势在于其高效的LLM提取策略。

研究团队没有选择动用庞大的百亿或千亿参数模型,而是创新性地对一个仅有0.6B参数的小模型(Qwen3-0.6B)进行了微调。

通过专门构建的包含数万份简历的指令数据集进行训练,这个小模型学会了精准地从文本中提取关键信息。

更关键的是,团队采用了“并行任务分解”和“索引指针”机制。

系统会将提取任务(如基本信息、工作经历、教育背景)拆分,让模型并行处理,大大缩短了响应时间。

在提取大段描述性文字时,模型不再逐字生成,而是直接返回文本所在的“行号范围”(索引),系统再根据行号从原始文本中精确回填。

这不仅将生成token的数量降到最低,节约了成本,更保证了内容的100%保真,杜绝了模型“自由发挥”或信息“幻觉”的可能。

实验结果令人瞩目:在包含大量真实复杂简历的RealResume数据集上,这个微调后的0.6B模型F1-score(综合衡量准确率的指标)达到了0.964。而其处理一份简历的平均耗时仅为1.54秒,远快于Claude-4的4.62秒,实现了3-4倍的速度提升。

目前,该技术框架已在阿里巴巴集团内部的HR系统中全面部署。

在线上服务中,整个系统展现出强大的实时处理能力,吞吐量可达每分钟240-300份简历,平均响应延迟低于2秒,10s内成功解析率达到100%。

这项研究证明了,通过创新的系统设计和模型优化,可以在不牺牲准确率的前提下,大幅降低大模型技术的使用门槛和成本。

GitHub地址

https://github.com/alibaba/SmartResume

论文地址

https://arxiv.org/abs/2510.09722

Demo地址

https://modelscope.cn/studios/Alibaba-EI/SmartResumeDemo

ModelScope地址:

https://modelscope.cn/models/Alibaba-EI/SmartResume

HuggingFace地址:

https://huggingface.co/Alibaba-EI/SmartResume

文章来自于“量子位”,作者“阿里巴巴”。