Deep-Live-Cam 是一款开源的实时换脸与视频深度伪造(deepfake)工具,只需要一张人脸图片,就能在本地电脑上对摄像头画面或视频进行实时换脸。 支持 Windows / Linux / macOS,多种硬件加速(CPU / CUDA / CoreML / DirectML / OpenVINO),并内置不良内容检测与合规提示,定位是服务 AI 生成媒体行业的高效生产力工具。

官方定位很明确:

在 Deep-Live-Cam 出现之前,很多人对 deepfake 的印象是:

对于内容创作者、主播、短视频团队来说,典型痛点包括:

Deep-Live-Cam 则是用几句简单的话戳中这些痛点:

于是我们看到的,就是一个三步搞定、效果惊人、门槛又不高的实时换脸工具——这也是它能在 GitHub 短时间冲到 7 万多 Star 的原因之一。

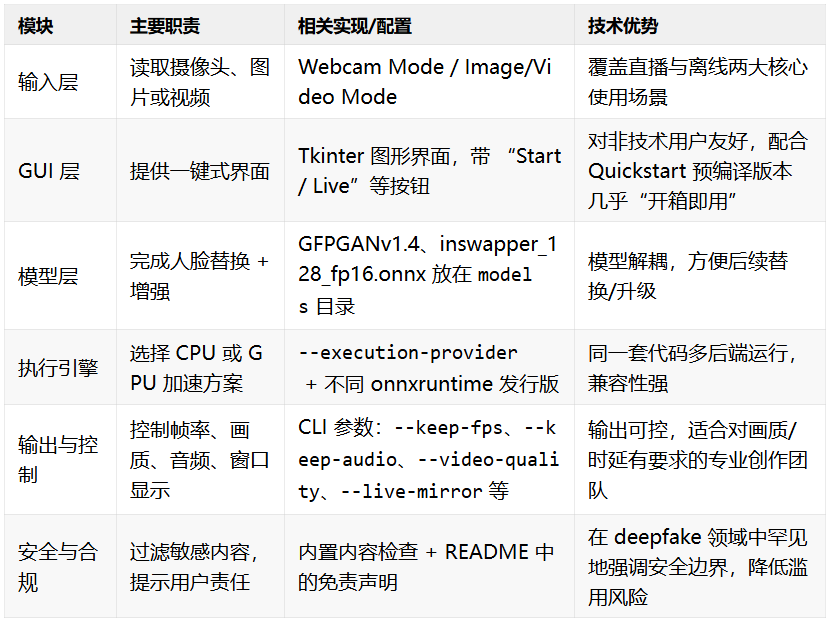

Deep-Live-Cam 的 README 和相关 fork 中,已经把它的核心能力描述得很清楚。结合官方说明,我们可以提炼出 8 个特别值得关注的功能特性:

Deep-Live-Cam 最大的亮点,就是只需一张人脸图片,就能对目标视频或摄像头画面做实时换脸,而不需要复杂的训练过程。

对创作者的直接价值是:从“我有一张角色图”到“我可以让这个角色说话做表情”,时间成本被压缩到几分钟。

README 中单独强调了一个叫 Mouth Mask 的功能:

这一点很关键——很多换脸工具的破绽就出在嘴上,而 Mouth Mask 在视觉上等于给了你一层“真实性增幅”。

在命令行参数中,Deep-Live-Cam 提供了:

--many-faces:对画面中的每一张脸都进行处理;--map-faces:把指定来源人脸映射到目标中的特定人脸上。这意味着你可以:

配合 Multi-Language fork 中详细展示的 “Face Mapping” 流程图和 GIF 示例,可以做出非常复杂的多角色换脸效果。

Deep-Live-Cam 的使用方式很清晰,README 把它拆成两大模式:

1.Image/Video Mode

python run.py2.Webcam Mode

python run.py;这两种模式覆盖了绝大多数实际使用场景:做视频、做直播、录制教学、录制短内容等。

在安装说明中,Deep-Live-Cam 为不同硬件准备了详细的加速方案:

python run.py;onnxruntime-gpu==1.21.0;python run.py --execution-provider cuda

onnxruntime-silicon、onnxruntime-coreml 的版本;python3.10 run.py --execution-provider coreml

python run.py --execution-provider directml

python run.py --execution-provider openvino

对于普通用户来说,只需要记住一句话:

能跑 Python 的地方,基本都能跑 Deep-Live-Cam,差别只是跑得快不快。

在“Command Line Arguments” 中,Deep-Live-Cam 暴露了大量参数来精细控制输出:

--keep-fps:保持原视频帧率;--keep-audio:保留原视频音轨;--video-encoder {libx264, libx265, libvpx-vp9}:选择编码器;--video-quality [0-51]:设置输出质量(越低越清晰);--keep-frames:保留中间帧,方便调试或后期合成。对于做商业项目或精修视频的团队,这些参数可以让 Deep-Live-Cam 更好地融入现有的剪辑流程。

在 CLI 参数以及 Multi-Language fork 的说明中,还能看到一些非常细节但实用的功能:

--live-mirror:把预览画面做镜像处理,呈现出类似前置摄像头的效果;--live-resizable / Resizable Preview:预览窗口可以自由拖拽大小,不影响实际渲染;--max-memory:限制最大内存使用,避免占满整机。这些细节对直播用户很重要:你可以边开 OBS、边看 bullet screen、边调预览窗口大小,不用担心整个系统卡死。

Deep-Live-Cam 在 README 中用了大段篇幅强调自己的使用边界和伦理立场:

这也给所有想要使用 Deep-Live-Cam 的团队一个明确信号:

这是一款偏“生产力”的工具,不是鼓励违规操作的“黑科技”。

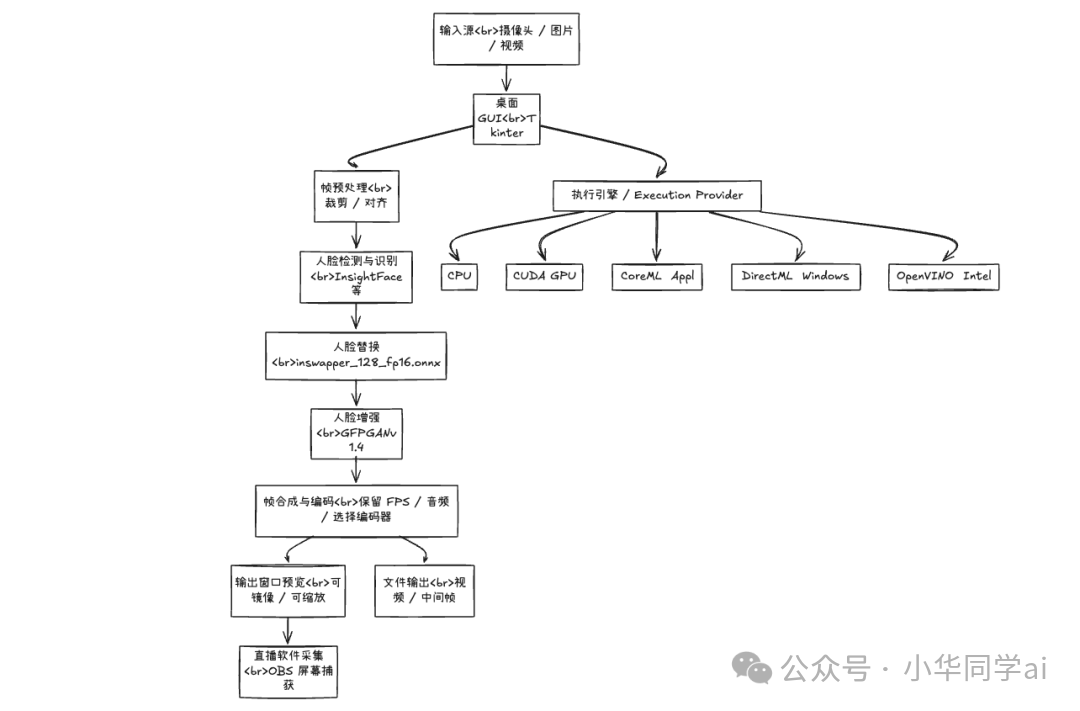

说明:具体实现细节在源码中,但整体流程可以概括为:输入 → 检测 → 换脸 → 增强 → 编码 → 预览/保存,并根据硬件选择不同的执行引擎。

梗图 / Meme 示例

基于官方 README、官网用例以及媒体报道,我们可以归纳出一批正向、实际可落地的场景:

⚠️ 需要再次强调的是:严禁用于诈骗、冒充真实身份、侵犯他人肖像权/隐私权的行为。 项目本身已经明确写出这些红线,实际使用时一定要遵守所在地区的法律法规。

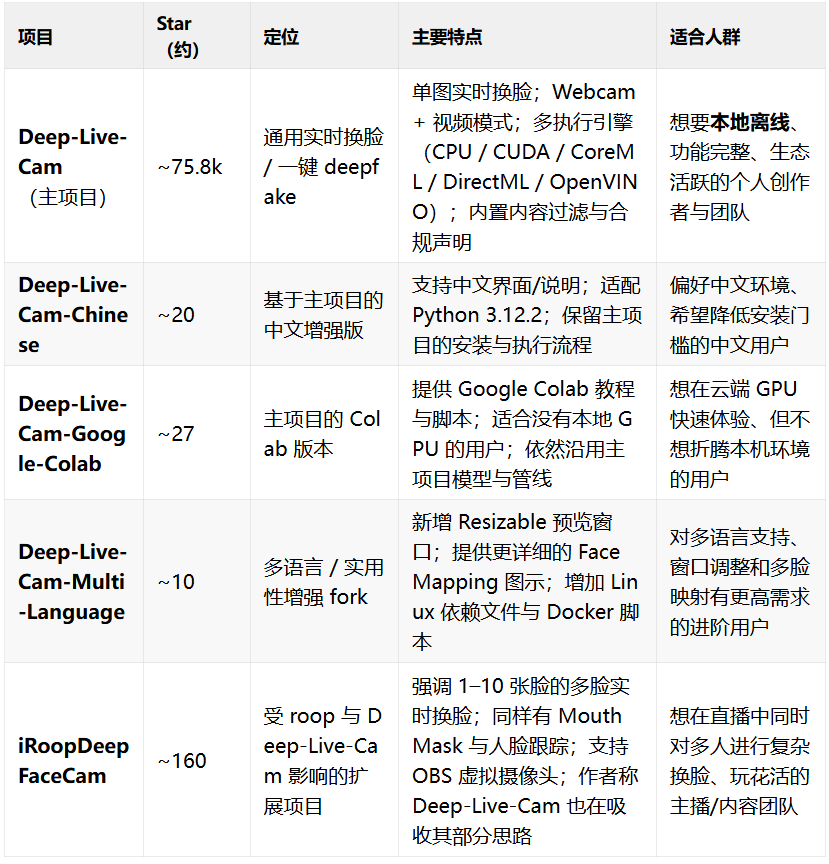

在 GitHub “ai-webcam”“deepfake-webcam”等话题下,有不少与 Deep-Live-Cam 同类型的项目。这里选取几个典型项目进行对比:

从这张表可以看出:

而对多数想要“快速上手 + 本地可控 + 生态活跃”的用户来说,直接使用主项目 Deep-Live-Cam 再按需搭配这些同类项目,是一个较优解。

如果你符合下面至少一条,很值得把 Deep-Live-Cam 拉到你的工具箱里:

Deep-Live-Cam 把“单图换脸 + 实时预览 + 多平台加速”这一条路打通了,同时又在 README 和官网中不断强调合规、伦理与安全边界。如果你在合法合规的前提下去使用它,它更像是一款提升创作效率的 AI 摄像机,而不是一把“玩火”的工具。

https://github.com/hacksider/Deep-Live-Cam

文章来自于“小华同学ai”,作者 “小华”。

【开源免费】Deep-Live-Cam是一个只需一张图片即可实现实时换脸和一键视频深度伪造的AI项目。

项目地址:https://github.com/hacksider/Deep-Live-Cam

【开源免费】Fay开源数字人框架是一个AI数字人项目,该项目可以帮你实现“线上线下的数字人销售员”,

“一个人机交互的数字人助理”或者是一个一个可以自主决策、主动联系管理员的智能体数字人。

项目地址:https://github.com/xszyou/Fay

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales