沉默后爆发?

深夜,Meta 有了重大更新,接连上线 SAM 3D、SAM 3(Segment Anything Model,SAM)。

其中,SAM 3D 是 SAM 系列的最新成员,它将人们对图像的 3D 理解带入通俗易懂的世界,其包含两个模型:

这两个模型都具备强大且稳定的 SOTA(业界领先)性能,能够将静态的 2D 图像转化为细致的 3D 重建结果。

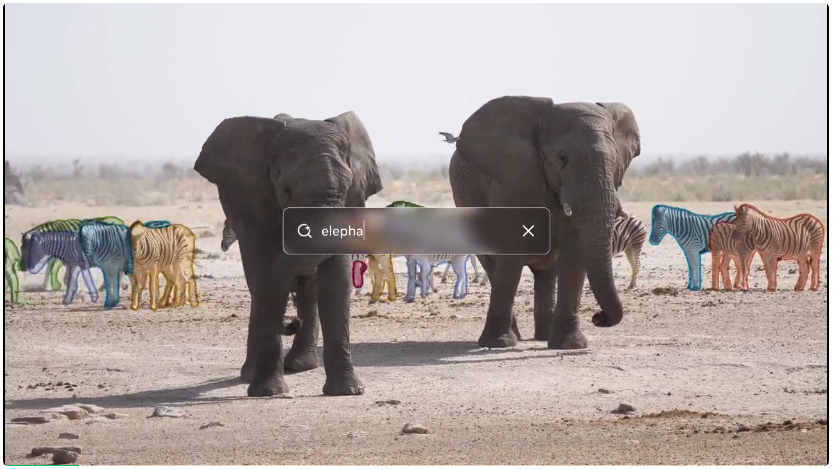

SAM 3 可通过文本、示例和视觉提示,对图像和视频中的物体进行检测、分割与跟踪。

作为本次发布的一部分,Meta 同步开放了 SAM 3D、SAM 3 的模型权重与推理代码。

此外,Meta 还推出了一个全新平台 Segment Anything Playground,通过该平台,用户能轻松体验 SAM 3D、SAM 3 的能力。

接下来,我们一一来介绍 SAM 3D、SAM 3。

SAM 3D Objects:从一张静态照片到可操控的 3D 场景对象

SAM 3D Objects 提出了一种全新的技术路径,用于在单张自然图像中实现稳健、真实感强的 3D 重建与物体姿态估计。它能够从日常照片中重建物体的细致 3D 形状、纹理和场景布局。

对于自然图像来说,小物体、侧视角、遮挡等情况十分常见,仅依赖像素往往不足以完成重建,而 SAM 3D Objects 能利用识别能力与上下文信息来弥补纯视觉像素的缺失。

借助 SAM 3D Objects,用户只需从一张图片开始,选择任意物体,就可以快速生成带姿态信息的 3D 模型。

以往的 3D 模型受到数据限制极大。与文本或图像等模态相比,高质量 3D 真值数据的数量要少几个数量级,并且现有数据主要是孤立的、合成的 3D 资产。这使得传统模型虽然能生成质量不错的单个 3D 物体,但在 3D 重建方面却局限于合成或摆拍场景,例如:

这种基于大规模孤立 3D 资产训练的方式虽然是一个良好的起点,但若要超越这些简化场景,实现真实世界中日常复杂环境的 3D 重建,就需要全新的方法。

SAM 3D Objects 背后的核心创新来自两个方面:

众所周知,构建 3D 真值数据需要高度专业的技能,主要依赖经验丰富的 3D 艺术家。因此,3D 数据采集往往更慢、成本更高。

然而,Meta 观察到:验证或排序 3D 网格(mesh)的难度远低于从零创建一个网格。

基于这一点,Meta 构建了一个可扩展的数据引擎,让标注人员对模型生成的多个 3D 候选结果进行评分,而把最困难的样例再交给专业 3D 艺术家处理,以弥补数据盲区。

借助这一数据引擎,Meta 首次在真实世界图像上,总计标注了近 100 万张图像,生成了约 314 万个 3D 网格。

与此同时,Meta 还借鉴了近期 LLM 的训练范式,将基于合成数据的学习重新定义为 3D 的预训练阶段。

为了让模型能够有效处理真实世界图像,还必须加入一个后训练阶段,用来进行对齐,以弥补模拟环境与真实环境之间的鸿沟。

数据引擎正是支撑这一后训练阶段的核心,它持续提供高质量的数据来驱动对齐过程。

反过来,当模型的稳健性和输出质量不断提升时,又会增强数据引擎生成数据的能力,从而形成一个正向反馈闭环,不断循环迭代。

这种数据引擎与后训练阶段的紧密耦合,将会吸收更广泛的人类专业知识,将模型能力引导到单一方法所无法达到的水平。

Meta 还与专业艺术家合作,构建了一个种类多样的 SAM 3D Artist Objects(SA-3DAO)数据集,其在性能上显著超越现有方法。

SAM 3D Body:稳健、精准且可交互的 3D 人体重建

SAM 3D Body 旨在解决从单张图像中获得准确的人体三维姿态与形体重建这一长期挑战,即使图像中存在不寻常的姿势、遮挡、多人同时出现等复杂情况,它仍能保持高质量表现。

SAM 3D Body 是一个可提示模型,支持可交互输入,例如:

借此,用户可以直接引导与控制模型的预测结果,从而提升精度与可控性。

该模型基于 Meta 全新的开源 3D 网格格式 Meta Momentum Human Rig(MHR),这种格式通过将骨骼结构与软组织形体分离建模,提供了更强的可解释性。

在架构上,SAM 3D Body 构建于 Transformer 编码器 — 解码器架构之上,用于预测 MHR 网格参数:

为了训练模型,Meta 还构建了一个包含约 800 万张图像的高质量训练数据集,使其能够应对遮挡、罕见姿态和各种服装,并在多个 3D 基准测试中均超越了以往的模型。

在计算机视觉中,将语言与图像或视频中的具体视觉元素精准对应是一项重大挑战。

现有模型虽然能轻松分割像人这样常见的类别,但在面对更细致、更具体的请求时就会遇到困难,例如:那把红色条纹的雨伞。

SAM 3 通过引入可提示概念分割(promptable concept segmentation) 克服了这些限制:模型能够根据文本提示或示例图像提示,找到并分割某个概念的所有实例。

为了评估模型在大词汇量情况下的检测与分割能力,Meta 还构建了 SA-Co(Segment Anything with Concepts)基准。与以往基准相比,SA-Co 涵盖了规模更大的概念词汇,挑战性显著提高。

模型架构

SAM 3 模型架构建立在 Meta 以往许多 AI 进展之上。SAM 3 中的文本和图像编码器来自 Meta 在今年 4 月开源的 Meta Perception Encoder,这一模型能够帮助构建更高级的计算机视觉系统,用于图像识别、目标检测等日常任务。相比以往编码器选择,Meta Perception Encoder 在性能上取得了显著跃升。

SAM 3 的检测模块基于 DETR,这是首个使用 transformer 进行目标检测的模型。SAM 2 中使用的 memory bank 和 memory encoder 则成为 SAM 3 中跟踪模块(Tracker)的基础。此外,Meta 还使用了多个开源组件,包括数据集、基准和模型改进,以推动研究进一步发展。

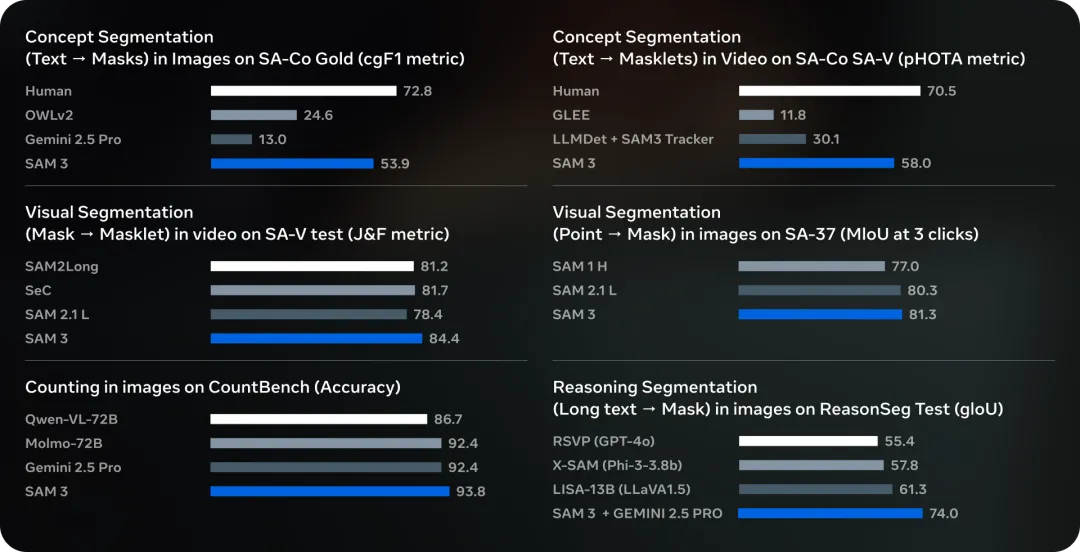

SAM 3 在图像(SA-Co Gold 子集)和视频(SA-Co Video)上的概念分割性能取得了跨越式提升。与现有模型相比,SAM 3 将 cgF1 分数(衡量模型识别与定位概念的能力)提升了两倍。SAM 3 优于基础模型(如 Gemini 2.5 Pro)以及强大的专业模型(如 GLEE)。

此外,SAM 3 在 H200 GPU 上对单张包含超过 100 个检测目标的图像,仅需 30 毫秒即可完成推理。在视频中,推理延迟随目标数量线性增长,在约五个并发目标的情况下仍可保持近实时表现。

了解更多内容,请参考:

https://ai.meta.com/blog/segment-anything-model-3/

https://ai.meta.com/blog/sam-3d/

文章来自于“机器之心”,作者“机器之心编辑部”。