科研人不容易。

3年投稿6次全被拒,每次等反馈要半年??

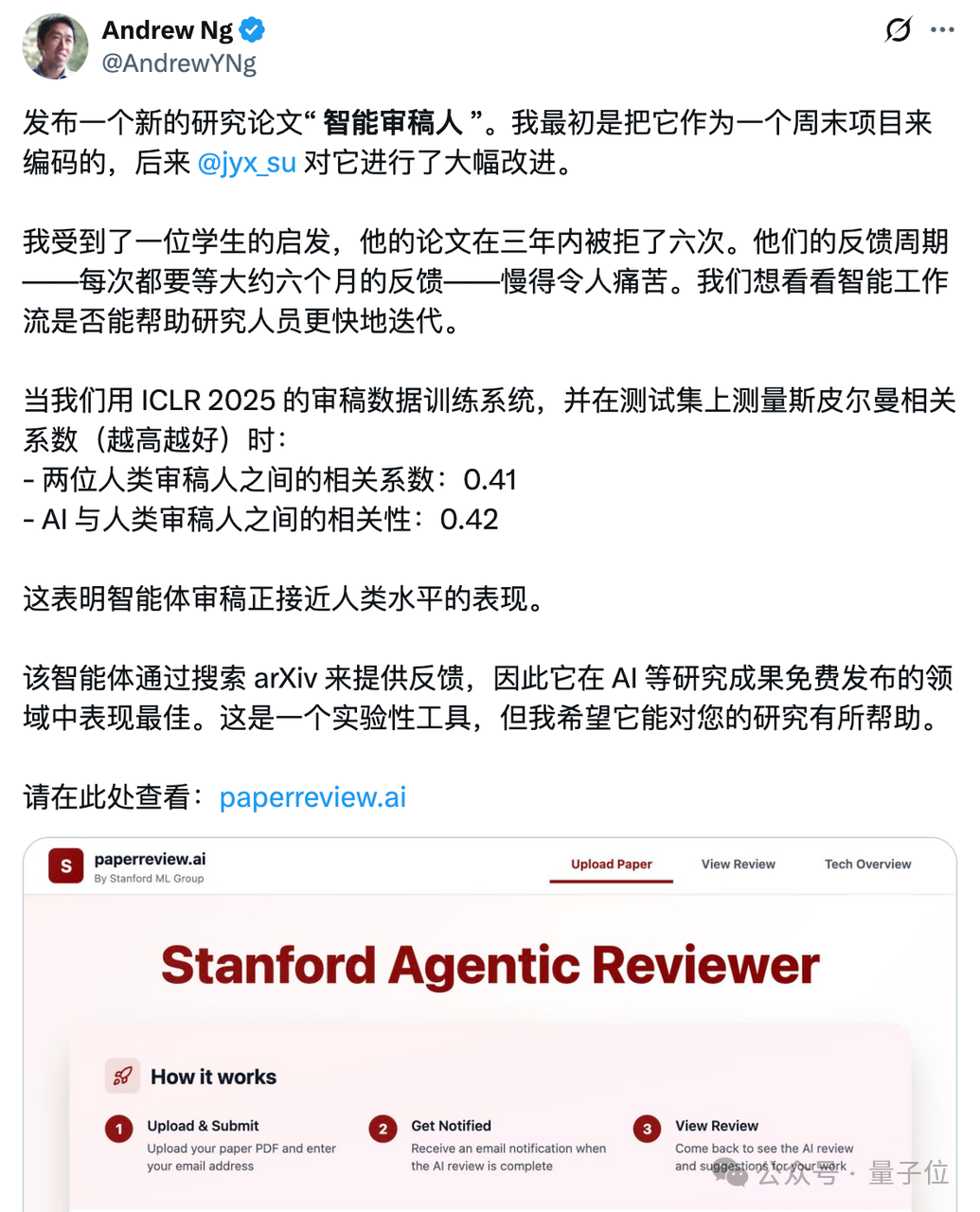

机器学习大佬吴恩达听说这位学生的“水逆”遭遇后,亲手搓了个免费的AI论文评审智能体出来。

通过在ICLR 2025审稿数据上训练系统,并在测试集中对比发现,该AI审稿系统与人类审稿的相关系数达0.42,和人与人审稿间的0.41相近甚至还高一点。

也就是说,AI评审的判断已经和人类之间相互评审的一致性相当了。

对此,有网友表示:与其等6个月被拒,还不如几分钟内就被拒!

毕竟早拒早改早提交(doge)。

而且传统评审每轮反馈要等上数月,可收到的评论大都聚焦在“评判论文值不值得发表”上,却很少给出如何修改的具体建议。

而吴恩达的这款AI论文评审智能体,恰恰精准戳中这个痛点!

首先说一下它的“审稿”流程。

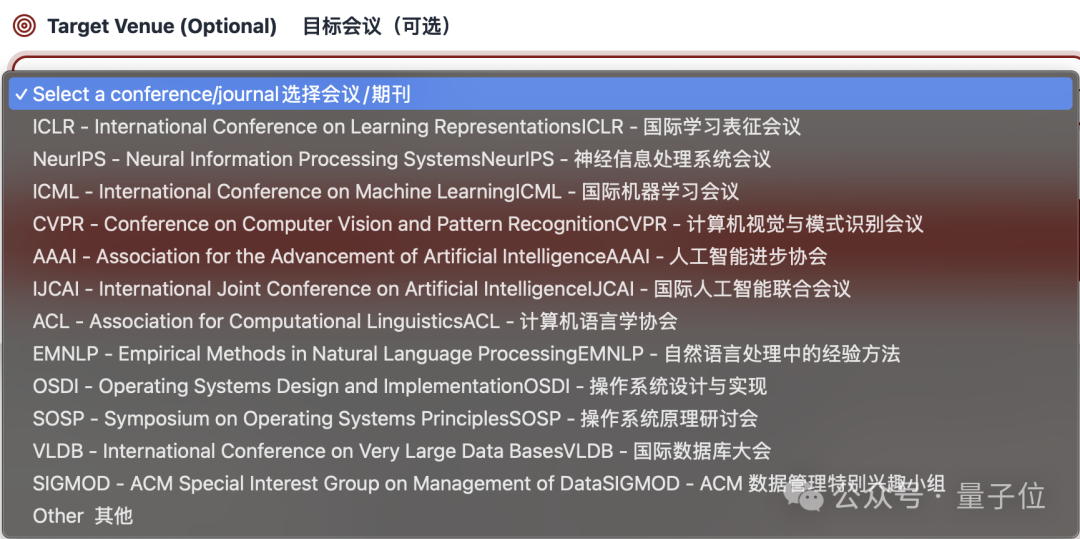

当你提交论文时,可以选你投的是哪个期刊/会议,系统就会根据那个会议的评审风格来判断。

它会把你提交的PDF转成Markdown,确认这是学术论文后,自动提炼出一些关键词,比如你实验用了什么标准、你的题目和哪些现有论文类似。

然后用搜索工具去arXiv上找最新的相关研究,接着挑出最相关的论文进行总结,之后结合原文和这些总结,按模版给出完整的评审意见,同时提一些具体的、能操作的修改建议。

为了让这个系统更实用,团队还训练它模仿ICLR 2025的评审给论文打1-10分。

具体是先从原创性、研究问题重要性、结论是否有依据等7个维度打分,再用模型算出最终分数。

测试发现,AI和人类审稿人的评分相关性是0.42,人类之间的相关性才0.41,说明这个AI快赶上人类水平了……

不过预测论文能不能被录用时,人类评分的准确率有0.84,还是比AI的0.75高一些。

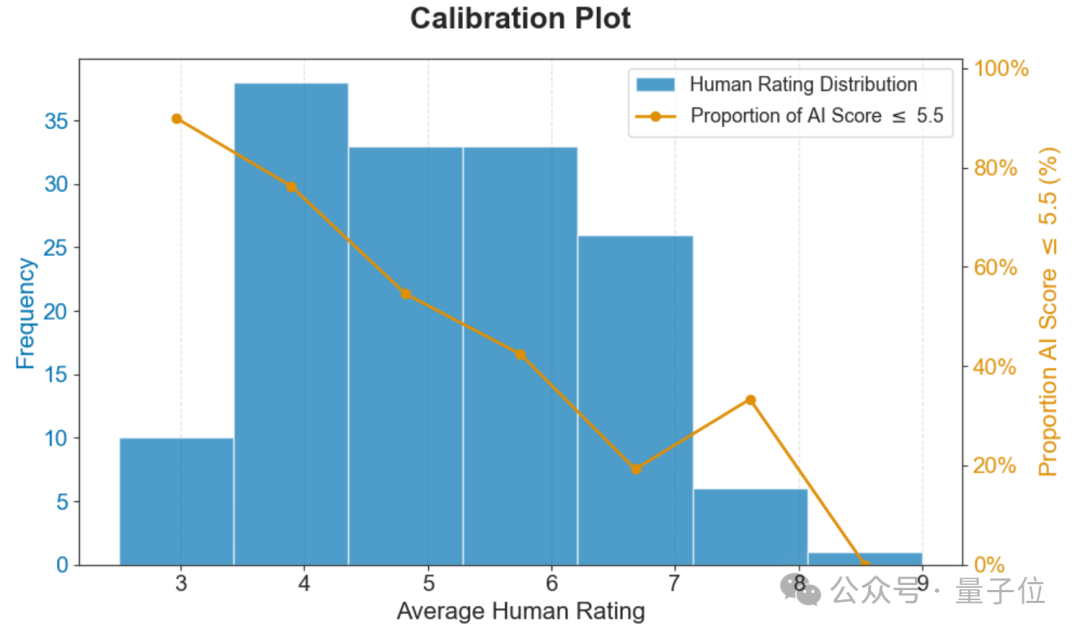

下面这张图片是AI和人类评审的校准图。

其中蓝色柱子展示了人类评分的分布情况,能看到人类评分在4、5、6、7分区间较为集中。

橙色折线则代表在对应人类评分区间内,AI评分≤5.5的比例,从图中可知,随着人类评分的升高,AI评分≤5.5的比例逐渐下降。

总结来说就是,AI评分≤5.5的比例随人类评分升高而显著降低,说明AI评分在一定程度上能与人类评分的趋势保持一致。

也就是说,这个AI评审真能在一定程度上反映你的论文中稿几率。

当然了,AI审稿主要参考arXiv上的内容,最终的结果可能会有误差。并且,虽然AI审稿快,但也不是立马能拿到结果。

实际上我们也上传了一篇论文,但目前的结果是稍等稍等稍等……

好消息是,我没有被AI几分钟就拒稿(doge)。

根据吴恩达的说法,这个AI论文自动评审智能体是斯坦福大学博士Yixing Jiang进行改进的。

他还曾在谷歌DeepMind实习过7个月。

对于这个免费审稿系统,有需要科研er们可以体验一波,说不定就“中稿”了~

体验地址:https://paperreview.ai/

参考链接:

[1]https://x.com/AndrewYNg/status/1993001922773893273?s=20

文章来自于“量子位”,作者 “闻乐”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md