DeepSeek-V3.2很强很火爆,但随着讨论的深入,还是有bug被发现了。

并且是个老问题:浪费token。

△图源:x@Hangslin

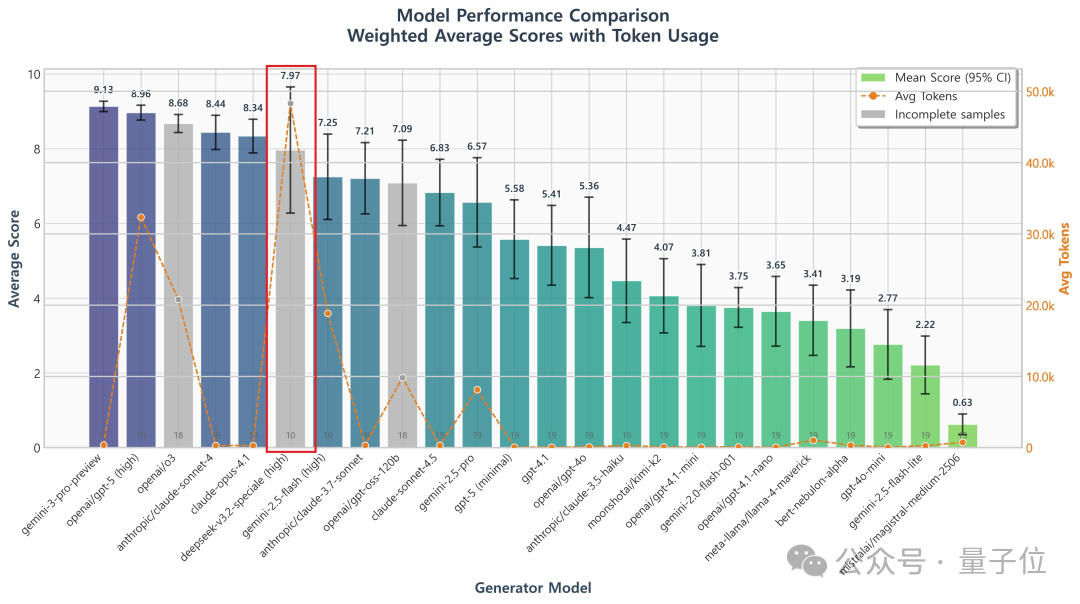

不少网友都提到,DeepSeek-V3.2的长思考增强版Speciale,确确实实以开源之姿又给闭源TOP们上了压力,但问题也很明显:

在面对复杂任务时,消耗的token数偏多,甚至可能会出现“又长又错”的答案。

比如,同样解决一个问题,Gemini只用了2万个token,而Speciale需要花费7.7万个。

这是怎么一回事?

有研究者指出,这其实是自DeepSeek-R1-Zero以来,DeepSeek系列模型一直存在的一个“bug”。

简单来说,问题出在了GRPO算法上。

来自Sea AI Lab和新加坡国立大学等研究机构的学者认为,GRPO存在两个“隐藏偏见”。

GRPO计算奖励时,会把“答案长度”算进去 ,导致短的错误答案被罚得更重。

结果就是:模型会故意生成“又长又错”的答案,看起来像是在“认真推理”,其实是在“凑字数躲惩罚”。

GRPO会根据“同一批题的得分标准差”调整权重。比如一道题所有人都做对(标准差小),或所有人都做错(标准差也小),这道题会被当成 “重点” 反复训练;而中等难度、有人对有人错的题(标准差大),反而被忽略。但实际训练中,中等难度的题才是提升能力的关键。

这项研究的核心作者Zichen Liu指出,DeepSeek-V3.2已经通过新的优势值计算方式,修正了“难度偏见”(如下图红框所示)。

但仍然保留了有偏的长度规范项(如下图蓝框所示)。也就是说,“长度偏见”依然存在。

实际上,这个问题DeepSeek官方报告亦有提及。

技术报告中,DeepSeek研究人员坦承,token效率对于DeepSeek-V3.2而言,仍然是个挑战:通常情况下,本次上新的两个模型需要生成更长的轨迹,才能达到Gemini-3.0-Pro的输出质量。

而DeepSeek-V3.2-Speciale本身,也是特意放宽了RL的长度限制,允许模型生成极长思维链,使得模型能够通过大量消耗token来进行深度的自我修正和探索。

可以说走的是一条“在超长上下文下持续扩展强化学习”的路线。

考虑到从百万token的输出成本来看,DeepSeek-V3.2价格仅为GPT-5的1/24,似乎也尚可接受。

另外,也有网友指出,DeepSeek的128K上下文已经很久没动了。这与GPU资源有限也不无关系。

你是否也已经用上DeepSeek-V3.2了?体验如何,欢迎在评论区与我们分享~

参考链接:

[1]https://x.com/zzlccc/status/1995770284385992798[2]https://api-docs.deepseek.com/news/news251201

文章来自于微信公众号 “量子位”,作者 “量子位”