6位前DeepMind成员以元系统重塑大模型调用方式,该系统推出的Gemini 3 Pro优化技术在ARC-AGI-2上以54%的成绩夺得榜首,而成本仅为此前最优方法的一半。

最近,6名前Google DeepMind研究员、工程师又搞大事了。

他们的新初创公司Poetiq没去研发更大、更聪明的模型,而是搭建了一个元系统,该系统可以让前沿大模型自动生成解决特定任务的策略和模型组合。

这样不仅解决了前沿模型难以单独解决复杂真实世界问题的痛点,还将整体推理成本降低了一半。

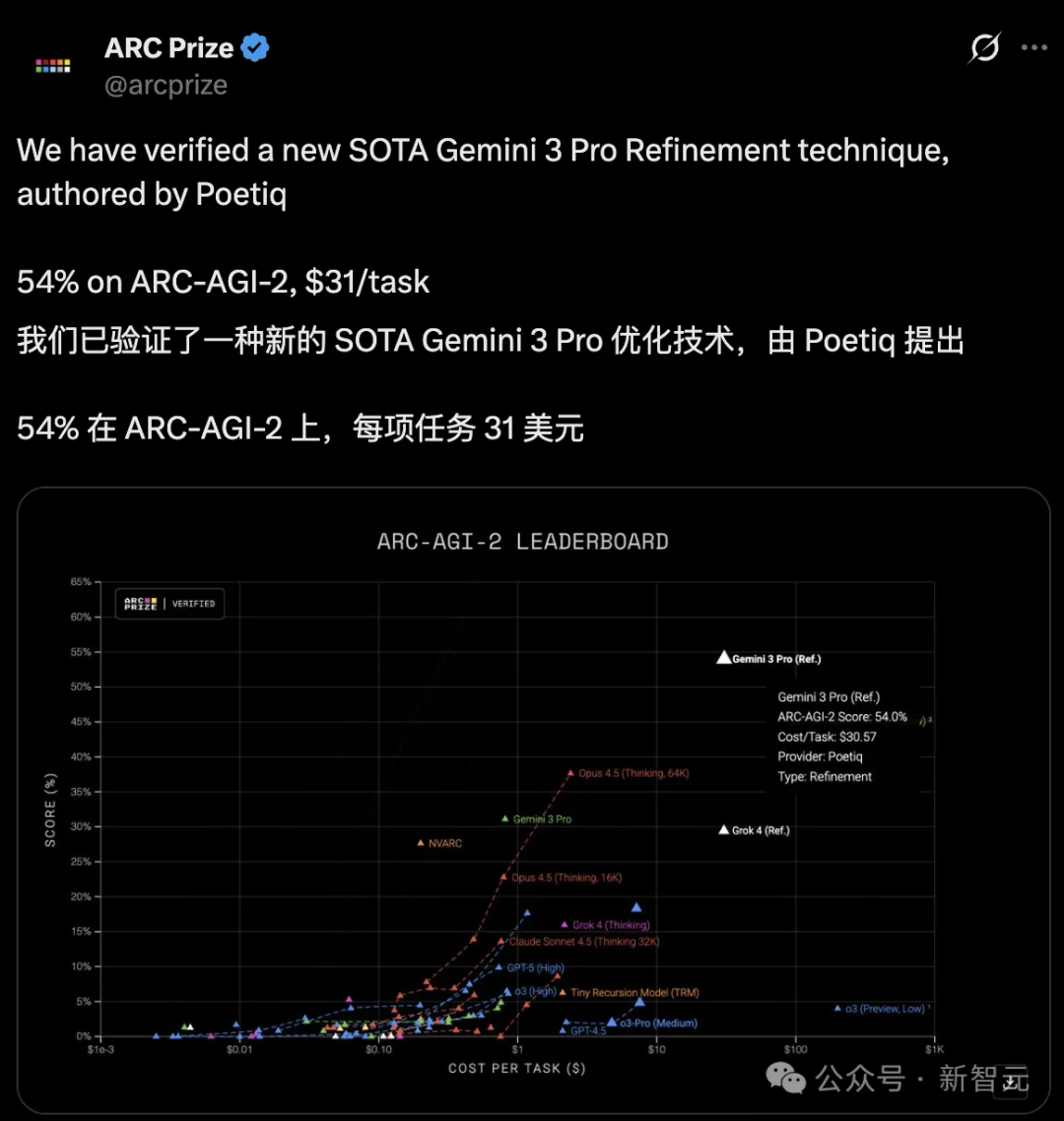

12月8日,ARC Prize官宣验证了该团队的成果。

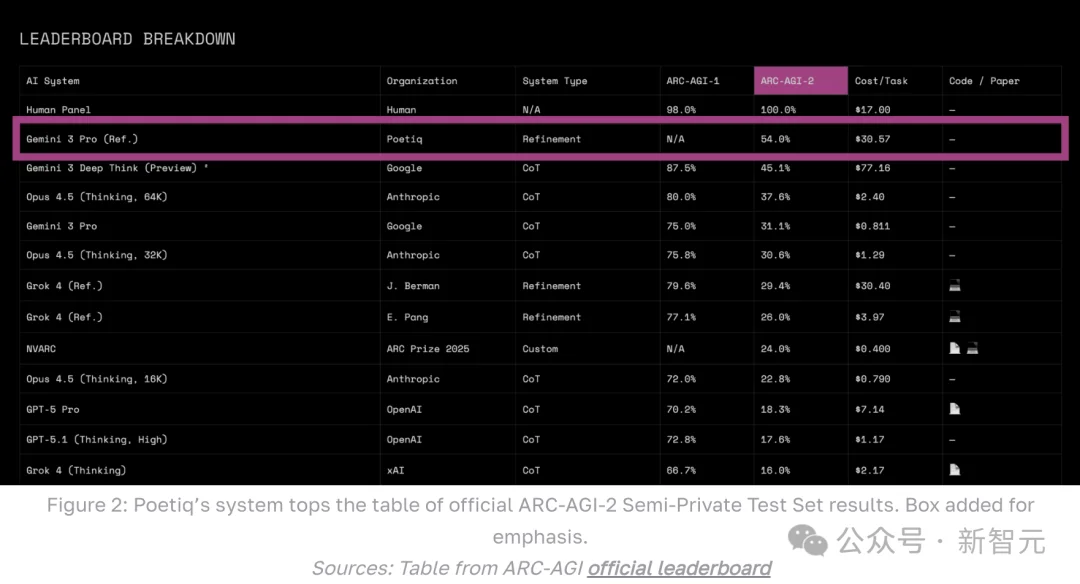

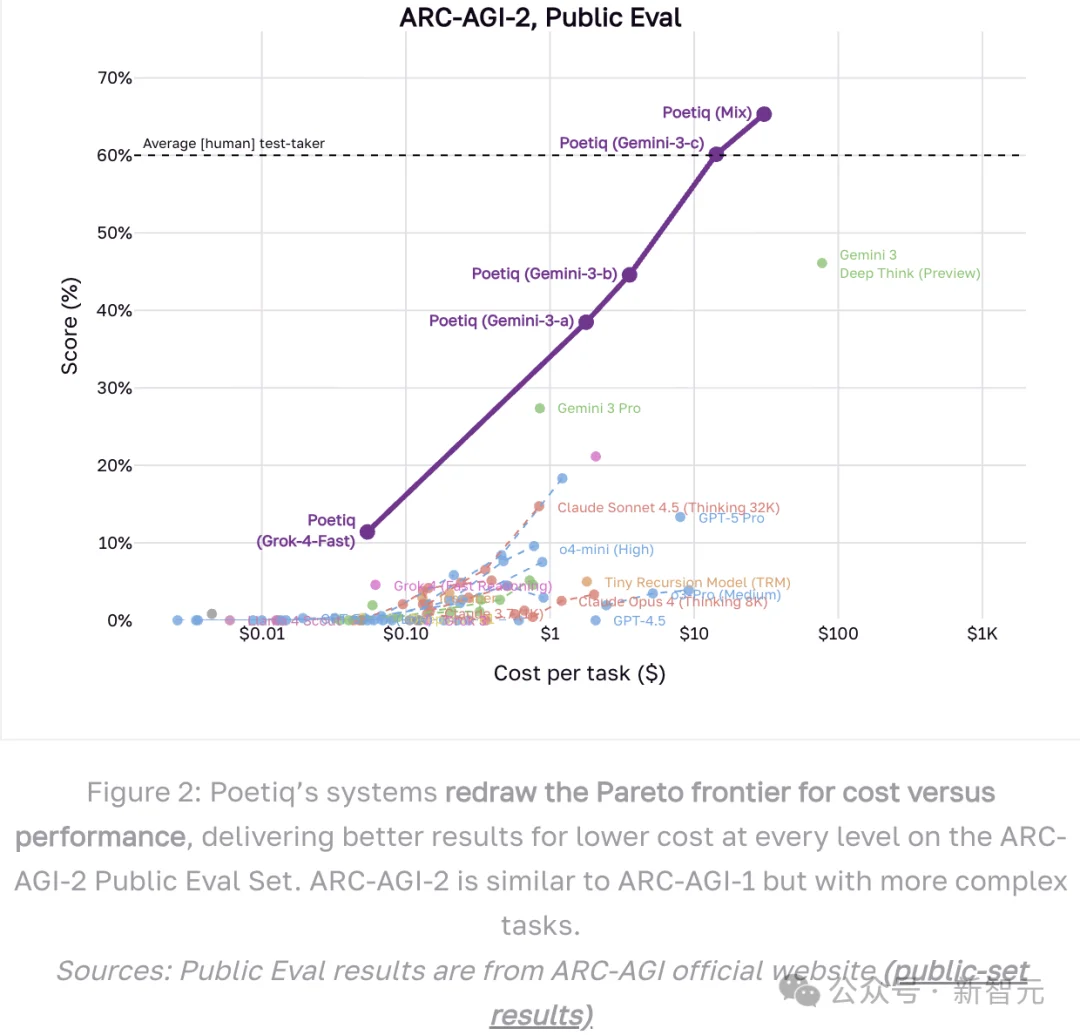

由Poetiq推出的Gemini 3 Pro优化技术,在ARC-AGI-2 leaderboard上创下新SOTA,得分高达54%,每任务计算成本仅31美元。

这一突破远超此前模型的最优表现,在leaderboard上力压群雄。

Poetiq初创团队均来自Google DeepMind

Poetiq是一个精干且高度技术型的团队,由6名来自Google DeepMind的研究员与工程师组成。

该创始团队成员一共拥有53年的专业经验,他们在Poetiq的目标是「以更优的推理,铺就通过安全超级智能的最快路径」。

12月5日,这家成立不到一年的公司自豪地宣布:

「Poetiq系统已经大幅超越现有方法,并树立了新的行业最佳表现。」

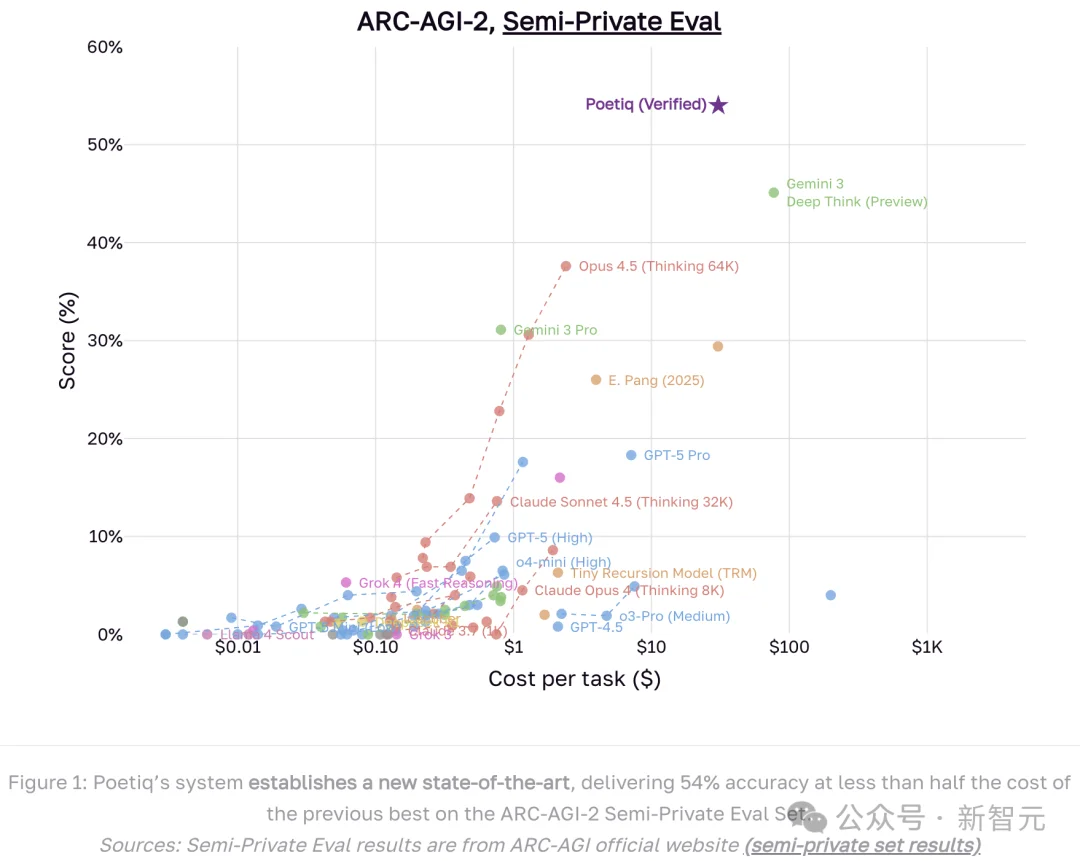

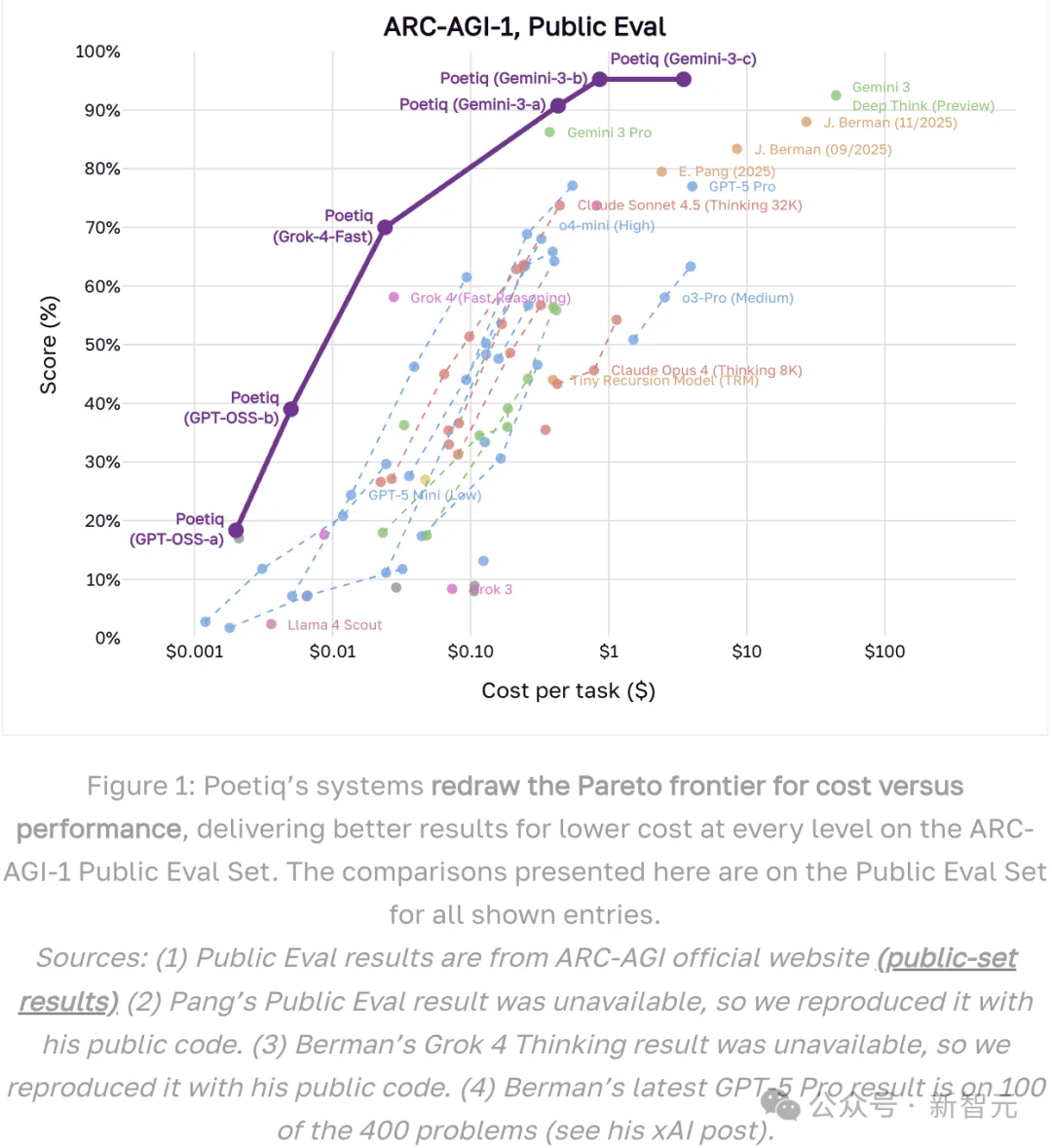

如上图所示,Poetiq系统在ARC-AGI-2半私有评估集上创下新纪录。

11月20日,Poetiq已经公布了自己在ARC-AGI-2上的强劲表现,此次ARC Prize对Poetiq公布的成绩进行了官方验证。

Poetiq开发的一套纯Gemini配置参与了ARC Prize的官方评估。

该系统以每题30.57美元的成本取得了54%的成绩,打破了此前Gemini 3 Deep Think创下的每题成本77.16美元、45%的最佳成绩。

Poetiq团队表示,在ARC-AGI-2公共数据集上,Poetiq系统建立了全新的帕累托前沿,不仅超越以往成果,还进一步推动了成本效益推理的边界。

Poetiq团队将这一成绩,归结为它的元系统。

Poetiq的方法是在任意模型之上构建智能。

其元系统旨在利用任何现成的前沿模型,自动生成能解决特定任务的完整系统,无需构建甚至不需要微调自己的大前沿模型。

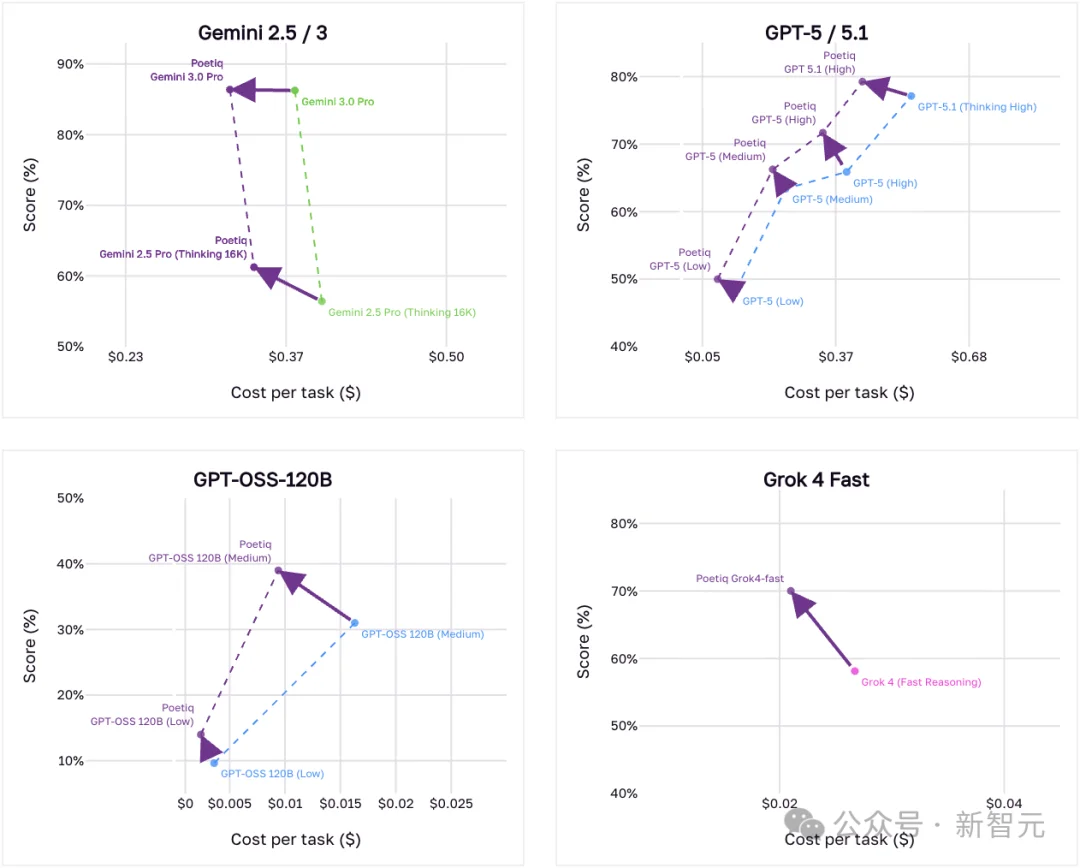

这也是为什么Poetiq能在Gemini 3与GPT-5.1发布后数小时内,就将它们快速接入并取得SOTA表现的原因。

如上图所示,Poetiq元系统在ARC-AGI-1和ARC-AGI-2上不仅全面刷新了以往成绩,也再次推进了低成本推理的边界。

以上这些方案虽然各自都能独立运行,但它们共同的底层是Poetiq灵活的元系统。

这个元系统的核心优势之一即能自动选择模型组合与策略,甚至会自行判断何时要写代码、又该由哪个模型负责写代码。

Poetiq的递归、自我改进系统完全不依赖特定大模型,在接入最新模型时也能充分展现其能力。

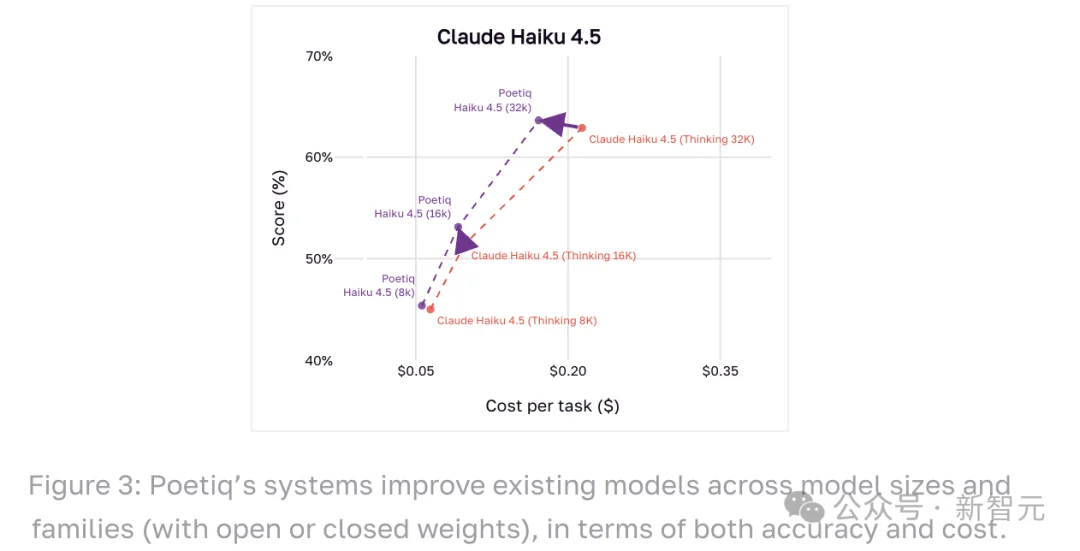

为了进一步展示Poetiq元系统的能力,研究人员将其应用到多个来自Google DeepMind、OpenAI、Anthropic和xAI的最新模型上。

每一次,Poetiq都实现了「更高准确率+更低成本」的组合。

上图中展示了12个模型(包括ChatGPT、Claude Haiku、Gemini、Grok 4、GPT-OSS)在ARC-AGI-1上经过Poetiq处理后的表现。

Poetiq是如何做到的?秘诀其实只有一句话:

从上到下,全靠大语言模型。

Poetiq使用大模型来构建系统、改进系统、也让系统本身运行起来。

正是这种灵活、强大且递归的系统架构,让Poetiq能快速取得如此一系列SOTA成果。

Poetiq选择开源的具体配置,主要为了展示2个重要理念:

系统在一个循环式的解题流程中运行:它不会只问一次,而是先让大模型生成一个可能的答案(有时包括代码),根据反馈进行分析,然后再继续利用模型改进答案。

这种多步骤、自我完善的方式,让系统能逐步构建并打磨最终解答。

系统会自主检查自己的进展,决定什么时候信息足够、结果可靠,从而自动结束流程。

这种自我监控机制能有效避免浪费算力,让整体成本更低。

Poetiq认为ARC-AGI是验证自身核心理念的理想测试场。

大模型蕴含了大量人类知识,但在复杂推理任务上经常出现不稳定的情况。

一个原因是模型表现高度依赖提示词,而其随机性会让知识提取变得不够可靠,从而使推理步骤难以预测。

真正的挑战在于:如何发现一种推理策略,既能找出需要的信息,又能在找到信息时顺利将其组合起来,并智能判断下一步该做什么。

Poetiq的核心目标,就是为了让这一过程能够自动化并不断优化。

Poetiq所构建的系统并不预设推理策略,而是让模型自主发现最适配的推理方式,并能在现实限制(预算、Token或算力)内工作。

这将释放生成式AI在复杂推理方面的真正潜力。

Poetiq的系统能在短时间内适配任务特性与模型特性,而ARC-AGI测试的是模型抽象推理、归纳、逻辑、生成策略能力,这和Poetiq系统的优势也是相互匹配的。

为了使Poetiq的元系统能够随着每次解决新任务而持续进化,任务的多样性也非常关键。

为此,Poetiq的团队正在让系统攻克更多基准任务,涵盖多种推理与检索需求。

此外,Poetiq系统的优点是擅长与其他系统协作。

该系统可以用来优化现有大型系统内部的AI组件。

如果能够在不修改模型本身的前提下,利用前沿模型中丰富的世界知识来解决长时序任务,如果能让底层知识提取机制更适配大模型,也许就不需要进行模型调优,这些正是Poetiq下一步努力的方向之一。

参考资料:

https://poetiq.ai/posts/arcagi_verified/%20

https://x.com/arcprize/status/1997743855203148038?s=20

文章来自于“新智元”,作者 “元宇”。

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0