第一次见到「爱学」前,王佳佳(化名)害怕和老师互动。

这个来自安徽阜阳的初三女生,性格内向,在课堂上几乎从不举手。题不会,不敢问,宁愿空着;一被老师点名,就紧张到大脑一片空白。久而久之,数学和英语成了她最不愿面对的两门课。

直到有一天,她开始反复和一个「不会不耐烦」的对象对话。一句没听懂,就一直追问,直到彻底弄清楚。对方有表情,会根据她的反应实时调整讲解节奏,也会在她犹豫、走神时主动追问,把她拉回来。

慢慢地,王佳佳敢开口了,学习也变得主动。最近一次数学随堂考试,她考了 103 分,比上一次整整提高了 40 分。

「爱学」所承载的并不是一位真人老师,而是一个真人级 AI 导师。

2025 年初,成立不到两年的首批 AI 原生应用企业与爱为舞率先落地了国内首个真人级 AI 一对一导师产品「爱学」。App 上线不到一年,已经被超过百万名学员真实使用。

单次课可能持续 1—2 小时,没有任何真人介入,完课率却高达 92.4%。单个学员的最长学习时长已达到 9000 分钟。

在 AI 课堂中,单次课的答题正确率也从 59.1% 提升至 83.2%。

学员小苹果学英语,进步明显。

放眼当前的 AI 教育市场,大模型似乎成了基础设施,但真正意义上的突破,却迟迟没有出现。大量产品仍停留在「舒适区」——

把 LLM 「套进」学习机或 App ,当作一个更聪明的聊天机器人来用。它擅长预测下一个 token,却没能走进教学本身。

最常见的使用方式是被大量用于搜题、批改。用户卡题了,点一下 AI,答案瞬间生成。所谓「讲解」,只是堆叠冗长而晦涩的推理链,对低龄用户来说如同天书。好一点的情况,会调用提前录制好的人类视频,但交互为零。

例如,一个常见的语法题:My sister plans _____ (meet)her teacher after school tomorrow. 这里的 meet 应该填什么形式?

很多 AI 的回答只是就着答案做解释(尤其像 AI 拍搜):

1.答案:to meet

a.核心原因:固定搭配+非谓语动词用法

b.动词plan的固定搭配规则:plan + to do sth.,即计划做某事

2.语法逻辑解析:

a.plan作为谓语动词,后面需要接“宾语”来表示“计划的内容”

b.英语中,动词原形(meet)不能直接做宾语,需要通过不定式(to+动词原形)构成不定式短语(to meet her teacher),才能充当plan的宾语,表示“计划的具体动作”

更常见的是打着「AI 课程」旗号的产品,本质仍是录播,AI 交互浅到几乎可以忽略。这些产品解决了「有教」的一部分,却仍难以触及「会教」,更别提「因材施教」。

要将 AI 真正引入教育,必须在「教学」这件事上下功夫。与爱为舞认为,新一代 AI 教育范式应该因材施教、授人以渔。这套判断,来自一支典型的「互联网大厂 × 头部教育」跨界团队。公司创始人兼 CEO 张怀亭,曾担任百度商业化系统「凤巢」核心负责人、高途联合创始人。创始人兼 COO 刘威,曾任高途集团副总裁、高途课堂总经理。

就拿前面那道英语题来说,为什么是 to meet,而不是其他形式?

「授人以渔」的 AI ,不会一上来就告诉你答案是 to meet。它会先判断学员卡在哪一层,是不是没搞懂非谓语动词?

随后,通过追问与对比引导学员自己发现:plan 表达的是尚未发生的计划动作,英语里通常用 to do 来承载这种未来意图。

再通过举一反三让学员理解共性规律。当遇到 plan / decide / hope / want 这类动词时,不必死背搭配,也能判断该如何表达。

近两年,AI Agent 概念大热,市场上也出现了一对一 AI 导师的雏形,但仍局限在英语、数学等单一学科 。相比之下,「爱学」已实现全年龄段覆盖、「多学科 + 长课时」深度陪伴。

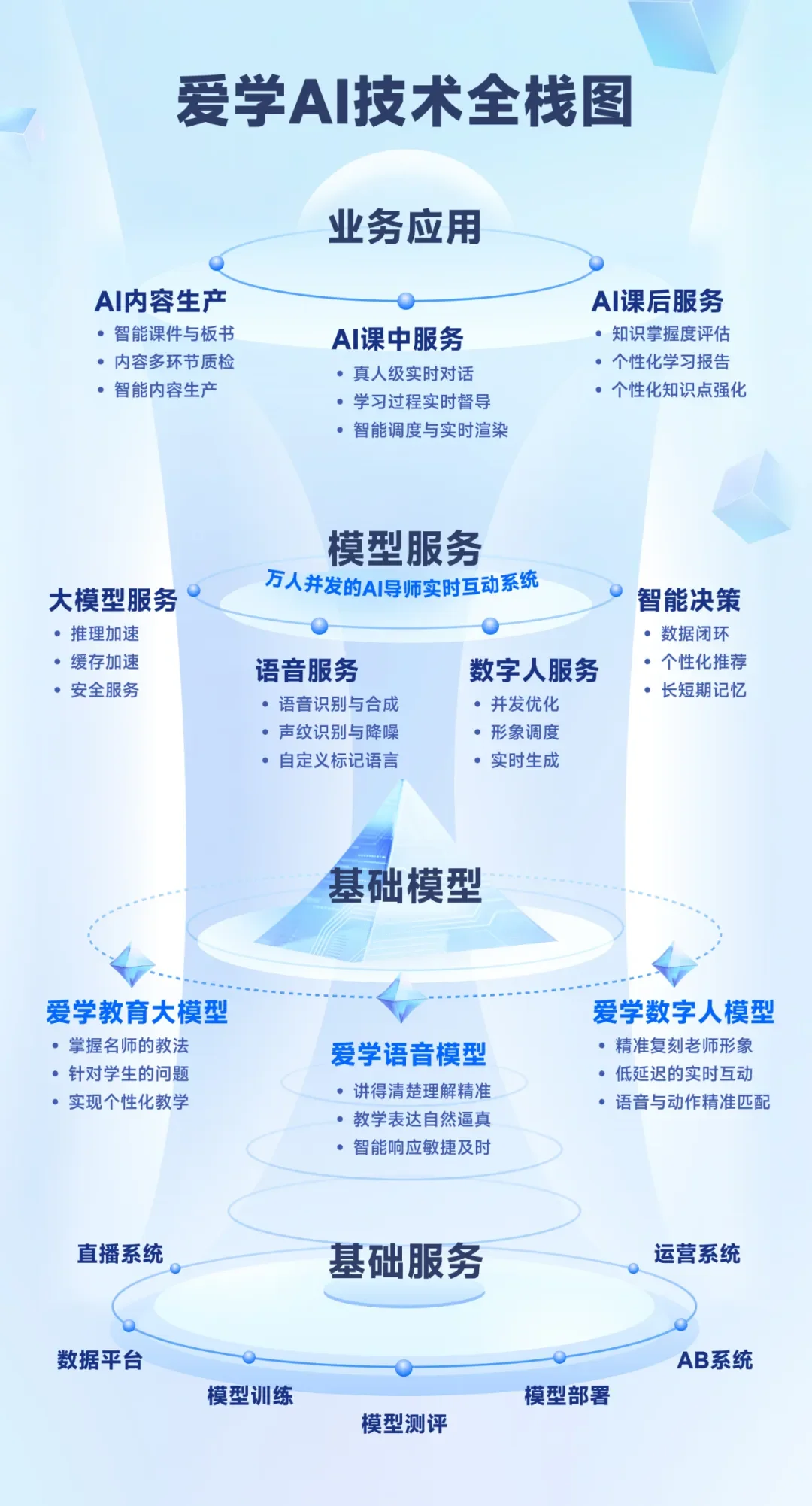

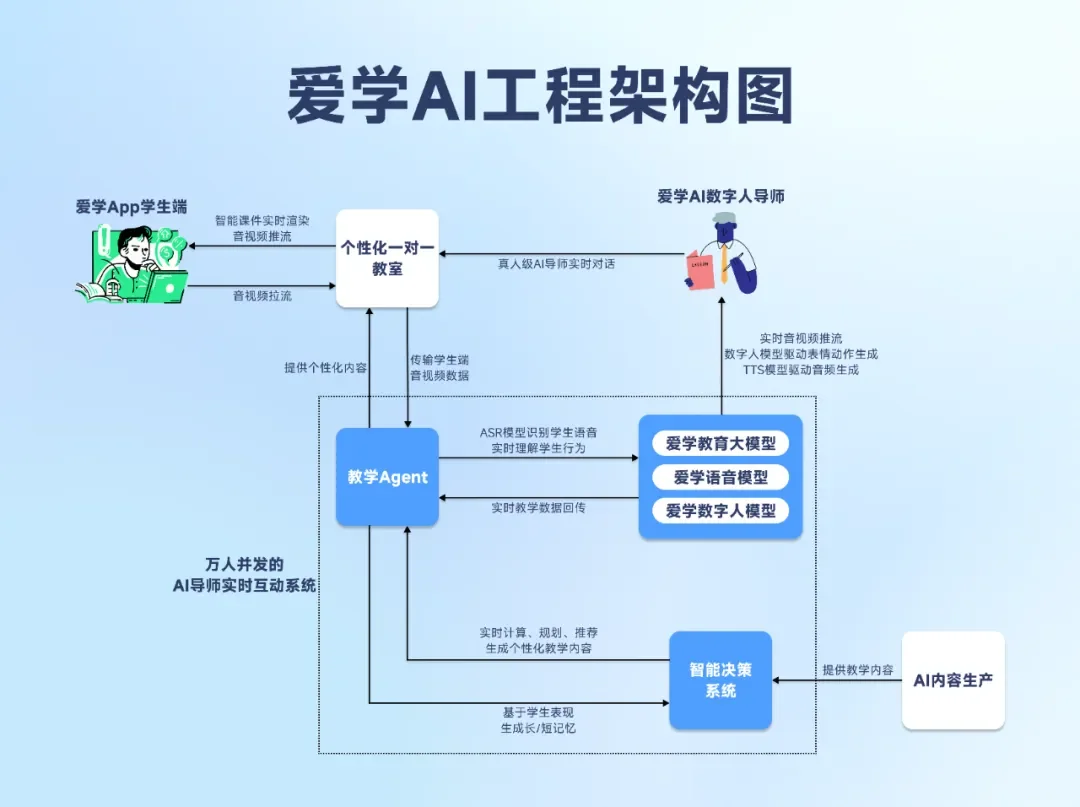

而支撑这一跨代产品的,是自研的国内首个 AI 原生教育框架——一个打通了「数字人 + 语音 + 大模型 + 工程」的全栈技术体系 。与爱为舞也因此成为国内首个在教育场景下打通全栈技术能力的公司。

那么,一个好的 AI 导师是如何炼出来的?

「爱学」背后的全栈技术能力。

为了打造一个真正「会教」的 AI 导师,与爱为舞自研了三大基础模型体系——从感知的「皮囊」,到负责决策的「灵魂」——完整覆盖 AI 教学的核心能力闭环。

与爱为舞认为,一个优秀的AI导师需要具备上面四个方面的核心能力。

其中,爱学教育大模型,第一次让 AI 拥有了真正的「教学之魂」,更是与竞对拉开身位的关键赛点。

与市面上仍停留在预测下一个 token 的对话系统不同,「爱学」从一开始就被设计成一套实时教学决策系统——

「一对一教学」不再只是问答交互,而被抽象为一个持续演化的马尔科夫决策过程(MDP),一次教学就是一场目标明确的博弈。

因此,AI 导师每一次讲解、每一次追问、每一次纠错,都不是「接一句话」,而是在当前学员状态下做出的最优教学决策。

数学课上,学员和AI导师一问一答,互动学习。

为了让模型真正具备「师魂」,与爱为舞设计了两个进化阶段:

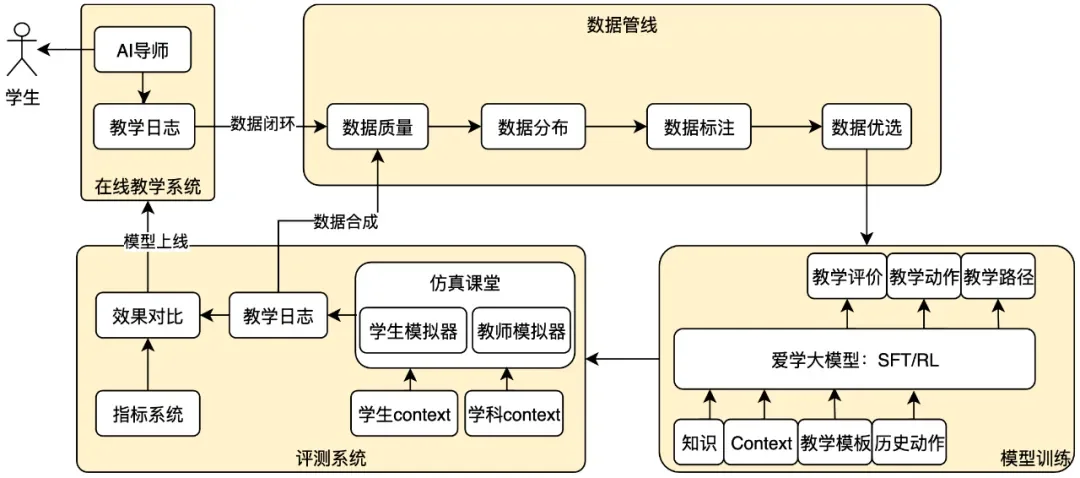

AI 导师是如何炼成的?这是在真实课堂 + 仿真课堂中持续进化的完整数据闭环与训练体系。

如果说模型架构决定了「导师素质」的上限,那么数据工程则构成了能力的下限。

与爱为舞没有简单堆砌题库或对话语料,而是先搭建了一套可运行的 AI 教学环境,让数据在真实教学逻辑中自然生长。数据被系统性地拆解为三层核心要素。

三者共同构成一套「可运行的数字课堂」,也为后续模型训练提供了区别于传统题库与对话数据的核心养料:不仅知道教什么、怎么教,更知道该如何根据学员状态去教。

为补齐真实数据的稀缺与长尾问题,研发团队进一步引入了类似 AlphaGo 的自博弈机制:让「学员模拟器」与「AI 导师」在虚拟课堂中反复对弈,自生成千万级训练样本。

真实课堂每周数万小时的数据持续回流,驱动 SFT 与 RL 的高速迭代,形成一套稳定运转的数据飞轮。

最终,具备教学判断力的 AI 导师,得以在教学目标、教学路径、课堂交互与作业巩固上,实现真正意义上的个性化学习。

AI 导师从四个方面实现「个性化」施教:教学目标、路径、交互与作业巩固。

与爱为舞依靠真实的教学互动数据,通过数据飞轮,推动算法以周为单位迭代。目前已更新 20 多个版本,建立了业界首个在线一对一 AI 教学 Agent,全方位提升了教学效果。

1、持续优化互动频次,每节课 AI 导师都能与学员进行几十次的一对一互动,牢牢抓住学员的注意力。

2、持续优化互动质量,学员在一对一互动中的有效回答率提升到 95% 以上,说明学员的注意力得到显著提升。

3、持续优化个性化教学质量,通过个性化教学目标和个性化教学路径,将学员做题的准确率从不足 60% 提升到 83% ,部分课程正确率超过 95%,说明学员在集中精力学习之后,确实掌握了相关知识点。

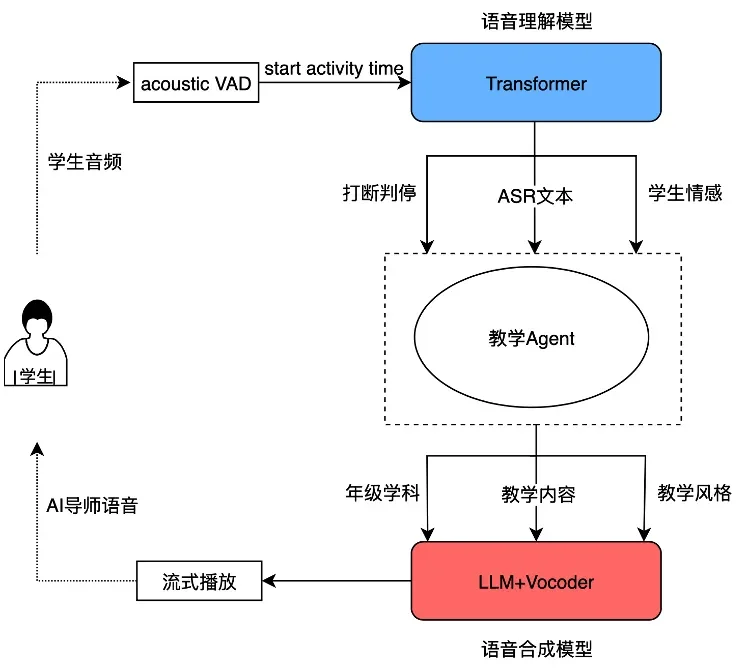

在打磨「师魂」的同时,与爱为舞也在感知层完成了一次彻底重构。

原因并不复杂:教学本质上是一种高频互动行为,语音是所有交互的第一道门槛。老师听得准、反应快,学员才愿意继续说下去。

传统 ASR 只会「听写」,至于这句话是在教几何还是教英语,一概不知。于是,因环境嘈杂或学员口音,「four」被听成「for」,「D答案」被听成「第一答案」,「有理数」被听成「有礼数」也就不足为奇。

与爱为舞不再把 ASR 当作「听写」工具,而是把它升级为「课堂参与者」。自研多模态语音理解模型,在解码最底层引入教学语境约束,让「听」从一开始就带着教学目的。约束来自三方面:

由于上下文信息直接参与解码路径计算,模型在第一时间就能排除那些在纯语音层面「听起来合理」,但在教学逻辑上完全荒谬的候选结果,ASR 准确率从行业最好开放能力约 80% 左右提升至 95%+。

除了「听懂」,AI 导师说话得有人味儿。因此,TTS 也被重做了一番。

自研流式 TTS 大模型将首字延迟压到 300ms 以内,通过语义/声学双 Speech Token + 强化学习联合优化,让语音能随语境动态调整节奏、重音与情绪——讲诗词会留白,讲推导会干净利落,甚至能用少样本快速对齐「名师腔」。

让我们一起听听下面这段音频,猜猜是真人还是 AI。

听出来了吗?下面揭晓答案:短短 18 秒的音频,混合了 3 段真人音频和 3 段 AI ,是不是完全听不出来?

更关键的是,AI 导师还能被随时打断。通过全双工语音交互,结合流式语义 VAD 与打断拒识模型,实现真正意义上的边说边听,说话过程中即可识别学员插话,打断识别准确率 90%+。

在课堂里,声音与「人」必须严格同步。多数数字人 Demo,十几秒足够惊艳,但一旦拉长到 40 多分钟课堂,就会迅速滑向「恐怖片」:

穿模、口型错位、动作僵硬、抖动、表情漂移、声音输出和其唇部动作之间存在明显延迟……

能稳稳 hold 住一整堂课的 AI 导师,对数字人技术提出了近乎苛刻的要求——极致的实时互动能力,以及长期一致性。围绕这些目标,与爱为舞的数字人系统开启了一次从 1.0 到 6.0 的疯狂进化。

一旦 AI 导师出现卡顿,学习心流就会瞬间崩溃。为了把实时性做到极致,他们先在架构上做了彻底解耦——引入 NeRF 与 3D Gaussian Splatting 建模,构建实时驱动框架,将口型、表情、身体动作分离建模;音频不再只是驱动嘴巴,而是在毫秒级联动微表情与姿态变化,让反应真正贴合课堂节奏。

再把性能推到百 FPS 级:系统不再「生成完再播放」,而是云端实时「存活」并持续输出;并实现无需训练的秒级生成,仅凭音频输入即可秒级生成高质量视频,内容生产从「提前制作」走向「实时发生」。

在「一致性」上,核心策略只有一个:锁定人格稳定性。

通过构建跨 ID 动作驱动体系,名师动作可稳定迁移;高精度骨骼提取保证复杂姿态下也不穿模、不崩坏,内容生产效率提升 5 倍。

基于真人动作捕捉与骨架识别,将手势与姿态精准映射到虚拟导师,实现自然同步的数字人教学演示。

最新 6.0 架构进一步把语音、文本、动作、情绪与人物 ID 融合进统一多模态模型调度,即便 45 分钟情绪持续变化,外观一致性与动作分布依然自然如初,音素级口型同步也终于告别「永远对不上的嘴型」。

如果说,「师魂」决定教学逻辑,「皮囊」负责感知,那么,能规模化交付的底线只有两个字:不崩。这意味着高并发、低延迟。

现实很残酷。传统方案一旦冲到万人并发,端到端延迟往往直接飙到 3 秒以上,交互体验断崖式下滑。而与爱为舞从零搭建的这套「 AI 课堂操作系统」,硬是把 ASR、教学决策、内容生成、TTS、数字人驱动到音视频推流的整条长链路,压缩到了 1.0–1.6 秒——万人同时在线,依然做到即问即答。

「爱学」如何真正跑起来?背后一整套工程系统,万人并发下还能实时上课的端到端 AI 教学架构图。

为了把时间一分一秒抠出来,他们做了几项工程改造。

第一刀,砍在 ASR上。通过ASR 预判 + 并行执行,语音识别链路延迟被压到 100ms 级。

第二刀,打断意图秒识。基于历史先验的意图识别,判断学员是不是要插话、追问、纠错。整条打断链路,1.6 秒内闭环,不会让 AI 导师「慢半拍」。

第三刀,落在缓存体系,把「每问必算」改成「能不算就不算」。用 Prefill Cache 消灭重复计算,用语义 Cache 复用专家答案,真正把响应时间压到人感知不到的区间。

如果说延迟是体验底线,那成本就是商业底线。

数字人渲染,是典型的 GPU 吞噬型任务。如果一张 GPU 只能服务一两名学员,万人并发意味着服务器成本直接失控。

为此,他们一方面通过GPU 显存全共享,榨干单张 GPU 承载极限。另一方面,通过统一调度「大脑」而非模型堆叠,在万人并发下,对不同形象、不同语音素材进行毫秒级自动分配。

真正难的,其实在运营阶段。当系统跑起来,一万个学员就有一万个进度。学习路径高度碎片化,请求分布不可预测——这是任何 AI 教育系统的「噩梦」。

与爱为舞决定拆解「复杂性」——把教学拆成乐高积木一样的零件,原本「随心所欲」的交互,被重构为「按剧本执行」的自动化指令,复杂调度变得可预测、可收敛。

为对抗「意外中断」,系统还引入可重入(Re-entrant)机制,保证 AI 导师不会「断片儿」,随时恢复状态,陪你学。

在过去不到一年的时间里,像王佳佳这样的变化,并不只发生在安徽阜阳的一间书房。它出现在佳木斯的清晨,也出现在三沙的落日里。有人甚至死磕同一节课12 次、交互 585 次,从「不知道」走到「全部知道」。真人级 AI 导师正在为天南地北的孩子,持续规划各自独一无二的学习路径。

这不只是一次产品能力的展示,更是一种新范式的显形:AI 以导师的身份,进入真实、复杂、对结果高度敏感的学习现场,并稳定发挥作用。它也为中国AI Agent 的规模化落地,定义了一套清晰的范式,甚至走在了世界前列。

当知识的获取不再是刷题、排名与淘汰的赛跑,而是一段被理解、被引导、被尊重的旅程——学习这件事,永远值得投入,也永远值得期待。

文章来自于“机器之心”,作者“吴昕”。

【开源免费】Fay开源数字人框架是一个AI数字人项目,该项目可以帮你实现“线上线下的数字人销售员”,

“一个人机交互的数字人助理”或者是一个一个可以自主决策、主动联系管理员的智能体数字人。

项目地址:https://github.com/xszyou/Fay

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales