2026 年即将到来,AI 的发展也已经进入了一个新的阶段:我们已经取得了惊人成就,却同时面临进一步增长的瓶颈。

新加坡国立大学(NUS)的尤洋教授近期发表了一篇深度分析:《智能增长的瓶颈》。

原文链接:https://zhuanlan.zhihu.com/p/1989100535295538013

在这篇分析文章中,尤洋教授从技术本质出发,直指智能增长的核心矛盾,为我们揭示了 AGI(通用人工智能)的可能路径。

✅ 智能增长的本质不是架构变革,而是算力如何转化为智能:AI 的核心智能来自于预训练及其 Loss 结构(例如 GPT 的 Next-Token Prediction)。这些机制更像是把算力转化为智能的方法,而非智能本身。

✅ 现有智能增长遇到瓶颈的根源:当前范式(Transformer + 超大算力)在面对进一步增长时, 难以充分消化不断增长的算力资源,这导致了所谓 “预训练红利递减”。

✅ 算力并不是无限扩展就能解决问题:即使算力指数级增长,如果现有算法无法有效利用这些计算资源,智能提升仍将受限。

✅ 未来方向不在于工程优化,而是底层范式突破:文章探讨了更高精度计算、更高阶优化器、更灵活的 Loss 设计、超大规模训练策略等潜在突破点。

✅ AI 未来仍然乐观:智能增长瓶颈虽强,但仍有可能通过更好的算力利用方式被克服。预训练可能才刚刚开始,大模型智能仍有巨大的发展空间。

AGI 的未来将如何发展?让我们拭目以待。

尤洋教授,《智能增长的瓶颈》作者

以下为其分享原文:

2026 年已至。在 ChatGPT 诞生三年多后的今天,关于我们的智能水平是否令人满意,以及未来是否还能强劲增长,笔者想分享一些个人的看法。如有谬误,恳请大家指正。

为了能深入探讨智能的本质,本文将不涉及产品易用性、成本等商业化或落地问题,因为这些本质上与智能突破本身无关。

什么是智能?其实目前并没有一个明确的定义。

从最近图灵奖得主 Yann LeCun 和诺贝尔奖得主 Demis Hassabis 关于 AGI 的争论中,我感受到即便是世界上最顶尖的专家也无法准确定义智能。

个人感觉,AGI 很难定义,其标准也会随着时代的变化而变化。我依然记得十几年前,普通人对人脸识别技术感到不可思议。如果把今天的 ChatGPT 拿到 2006 年,相信那时候的很多人会毫不怀疑地认为我们已经实现了 AGI。

我觉得智能的核心是预测和创作。

我认为如果达到以下这种状态,那么就离 AGI 不远了:

今天,我们显然还没实现这些。未来能否实现,取决于我们能否克服智能发展的瓶颈。

今天,我们经常听到一些关于智能发展遇到瓶颈,或者预训练红利已尽的观点。何为瓶颈?我们先探讨一下智能从何而来。

过去 10 年,AI 大模型的技术本质,是把电力能源通过计算过程转化为可复用的智能。技术的好坏取决于这个转化效率的高低。类似的表述,我也听月之暗面的朋友提及过。

今天模型的智能本身,最主要还是来自预训练(往往是自监督方法),仅有少量来自微调或强化学习。

为什么?先算一笔浅显的经济账:因为预训练消耗的算力最多,消耗的能源也最多。

当然,预训练、微调、强化学习本质上都是在计算梯度以更新参数。如果有合适的海量数据和 Loss 函数,未来在预训练阶段采用 SFT(监督微调)或特殊的强化学习方法也有可能。

从智能增长的角度,我们甚至不用刻意区分预训练、SFT 和强化学习。它们的区别主要在于更新参数的次数与规模。从计算本质上看:预训练、微调、强化学习(比如 GRPO)都是在计算梯度的类似物,并用它来更新参数。

那么,能源从何而来呢?这就是 GPU 或算力。英伟达在这点上做了最大的贡献。虽然英伟达有很多先进的技术,比如更强的 Tensor Cores、Transformer Engine、互联技术(NVLink / 网络化 NVLink)、软件栈等,但我先试图用一句话说清楚英伟达过去几年在技术上做的最重要的事情,即其 GPU 设计的核心思路。

简而言之,英伟达过去几年最重要的路线是:在同样的物理空间里堆更多 HBM(高带宽内存)。

HBM 虽然带宽很高,但依然是计算核心之外的内存(Off-chip from logic die),与计算核心存在不可忽略的物理距离。为了掩盖内存访问延迟,GPU 只能依赖超大的 Batch Size(批处理量)和大规模并行来处理数据。英伟达 GPU 本质上就是一台并行计算机。

因此,英伟达对算法层和软件层的要求非常明确:必须提供足够大的 Batch Size 或并行度。

面对英伟达的要求,很多研究团队都提出了自己的方案。比如 RNN、Transformer、卷积序列模型(CNN for Sequence)等等。甚至有人尝试用 SVM 来处理大规模序列数据。

那为什么 Transformer 率先脱颖而出?因为 Transformer 也是一台并行计算机。

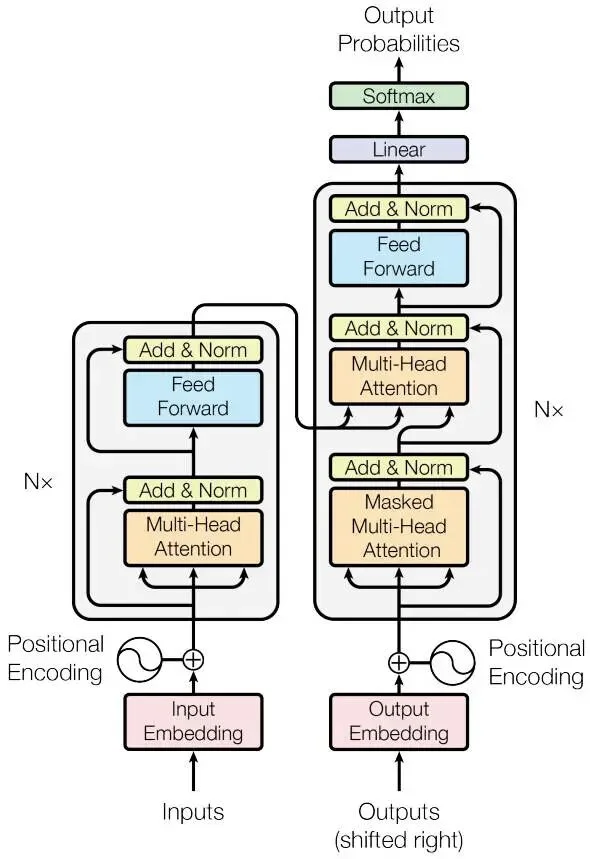

原初的 Transformer 架构

这里我引用一下 Ilya Sutskever 的一句话:“Transformers: parallel computers in disguise”,直白的意思是:Transformer 本质上是一个被神经网络外壳包裹起来的并行计算机。这也是 Transformer 最先能够显现智能的核心原因,因为它的并行计算特性完美匹配了 GPU 的并行计算单元。

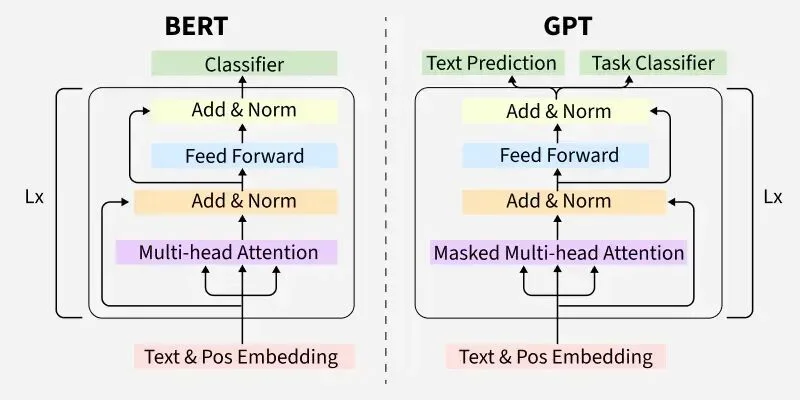

同时,OpenAI 完美地实现了 Next-Token Prediction 这个 Loss 函数,它给了 AI 大模型近乎无限的训练数据。理论上 BERT 的 Loss 函数(完形填空和 Next Sentence Prediction)也可以提供近乎无限的数据,但在实践中,Next-Token Prediction 的效果明显更好。

我推测,这个 Loss 函数最小化了人类的干预 —— 它不是人为设计的,而是大自然在进化过程中赋予人脑的逻辑。并且,Next-Token Prediction 其实是预测未来,而 BERT 的完形填空其实是把过去的信息和现在的信息串联起来。这就好比让一个足球专家根据历史数据和当天的比赛结果去解释合理性,几乎所有专家都能做到;但是,如果让专家去预测每一场比赛的精准比分,他们会经常出错。这再次说明了,预测 (Prediction) 是智能的核心能力体现,难度远高于解释 (Explanation)。

其实我挺佩服 OpenAI 团队能够坚持下来的勇气。2018 年时,BERT 在媒体上的影响力几乎完全碾压了 GPT,且当时 OpenAI 的 AI 研发团队体量跟 Google 比起来微不足道。很佩服他们没有放弃 Next-Token Prediction,也没有转向类 BERT 的训练方式。真理往往需要时间去检验。

BERT 对比 GPT

同时,以 Transformer 为核心的方案收获了 “一箭双雕” 的双重优势:

就这样,我们见证了 GPT-1、BERT、GPT-2、GPT-3、ChatGPT、Gemini 一步一步把智能提升到了今天的高度。

到这里,大家大概也清楚为什么 AI 模型的智能增长会遇到瓶颈了 —— 因为我们现在的范式无法充分消化持续增长的算力。

假定一次模型训练和微调消耗的浮点数计算次数(即程序员面试中的计算复杂度的具体值)从 10ⁿ 变成 10ⁿ⁺³ 时,我们是否获得了一个显著更好的模型?

其实,很多时候我们把 “效率优化技术” 和 “智能提升技术” 混淆了。比如,明天我提出一个新的架构,实验发现达到跟 GPT-5 类似的效果,只需要 20% 的参数量或计算量。这其实更多是落地或商业化问题;智能的终极问题是:使用同样的浮点数计算次数(而非 Token 量),能否获得一个更好的模型。浮点数计算次数,才是算力最基本、最本质的计量单位。

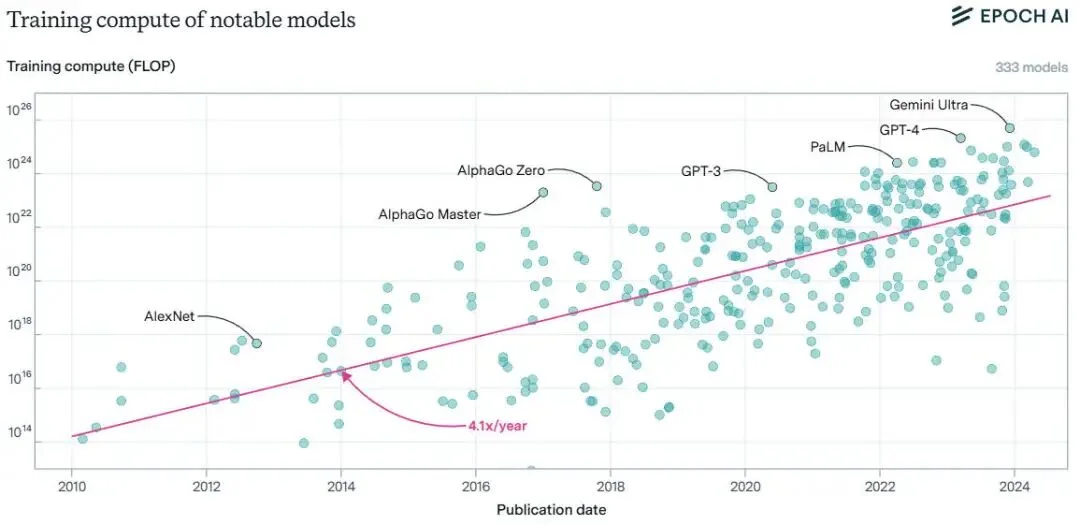

首先从硬件层来看,我们需要持续产生更大的绝对算力,这不一定局限于单位芯片上的算力提升。

前沿规模机器学习模型训练所用计算量的趋势,图源:Epoch AI

即便单位芯片上的算力没有大幅度提升,我们通过集群的方式也能构建更大的绝对算力。这里需要平衡的是:聚集芯片带来的性能增长,要高于 “芯片或服务器之间通信增长带来的负担”。

所以,具体的硬指标就是:增长或至少维持住 “计算开销/通信开销” 这个比值。这是整个 AI 基础设施层最核心的技术目标。要想实现这个目标,我们需要扩展性更好的并行计算技术,无论是软件还是硬件。

在更上层的探索中,我们需要让 AI 模型在单位时间内 “吃下” 更多能源,并真正将其转化为智能。个人感觉大概有以下几点方向:

有些技术对大规模落地 AI 非常重要,比如低精度训练、剪枝、量化、蒸馏、PD 分离等推理优化技术。但是,在一个 “算力转智能” 极端有效的情况下,这些技术跟提升智能上限无关。笔者对这些技术的贡献者非常尊重,它们在实际落地中至关重要,只是与本文探讨的主题无关。

智能增长归根到底还是算力利用问题。假定算力无限大,比如一个集群的算力达到今天的万亿倍,可能我们会发现更简单的模型结构比 Transformer 和 Next-Token Prediction 的扩展性更好。从 SVM 到 CNN、LSTM、BERT、GPT、MoE:我们始终在寻找能更高效利用算力且具备更好扩展性的方法。这个过程中,核心原因是问题的规模在不断扩大。

我们在 AI 时代到来之前便已实现天气预报,然而至今仍未能攻克地震预报,尽管两者本质上都是针对地球数据的研究。究其原因,地下结构涉及比大气更加错综复杂、且变量规模呈指数级庞大的动态多模态数据。这种传统计算模式难以驾驭的高维复杂性,恰恰是未来 AI 技术大有可为的机遇所在。

所以,我有信心我们未来会不断找到更高效的算力使用方式。虽然过程中可能会有很多困难和低潮,但大趋势不可阻挡。

最后,借用 Richard Sutton 教授的一句话收尾:人工智能 70 年的研究留给我们最大的经验教训是,依托计算能力的通用方法才是最终的赢家,且具备压倒性的优势。

文章来自于“机器之心”,作者 “机器之心”。