10B参数拥有媲美千亿级模型的多模态推理实力。

智东西1月20日报道,今日下午,阶跃星辰开源多模态模型Step3-VL-10B。该模型参数量为10B,在视觉感知、逻辑推理、数学竞赛以及通用对话等一系列基准测试中均达到同规模SOTA水平。

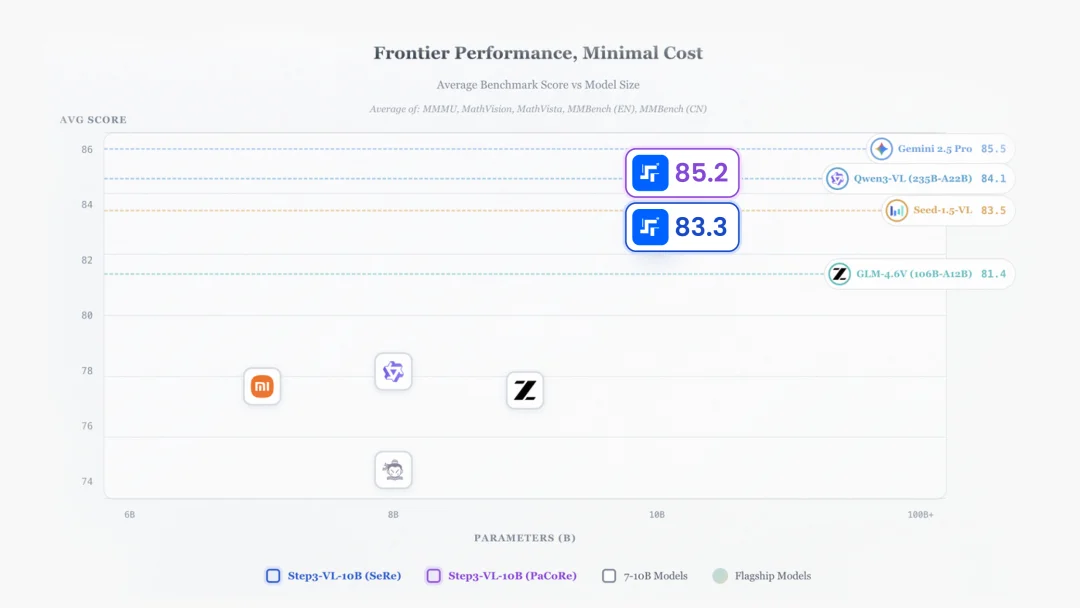

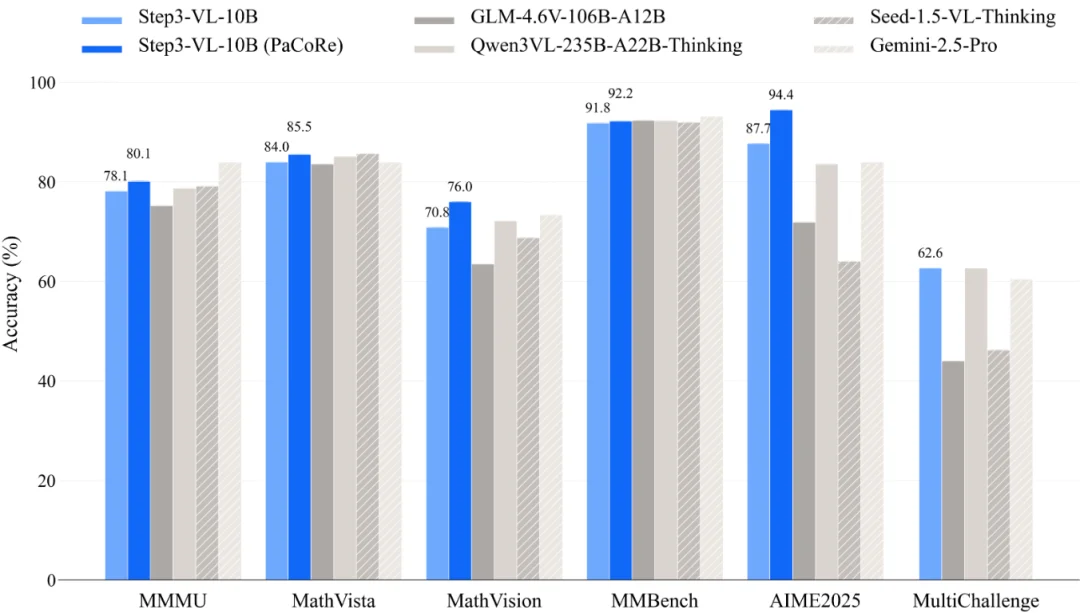

阶跃星辰的多项测评显示,Step3-VL-10B的性能可以媲美甚至超越规模大10-20倍的开源模型,如GLM-4.6V 106B-A12B、Qwen3-VL-Thinking 235B-A22B以及闭源旗舰模型,如Gemini 2.5 Pro、Seed-1.5-VL。

这一轻量级模型的性能表现,也意味着手机、电脑、工业嵌入式设备可以运行GUI操作、复杂文档解析、高精度计数等复杂多模态推理任务。

从技术层面看,Step3-VL-10B的性能突破得益于三个关键设计,分别是高质量多模态语料库上进行统一预训练、缩放多模态强化学习、并行协调推理机制。

目前,阶跃星辰已开源Step3-VL-10B系列的Base模型和Thinking模型。

Hugging Face开源地址:

https://huggingface.co/collections/stepfun-ai/step3-vl-10b

ModelScope开源地址:

https://modelscope.cn/collections/stepfun-ai/Step3-VL-10B

体验地址:

https://huggingface.co/spaces/stepfun-ai/Step3-VL-10B

技术报告链接:

https://arxiv.org/pdf/2601.09668

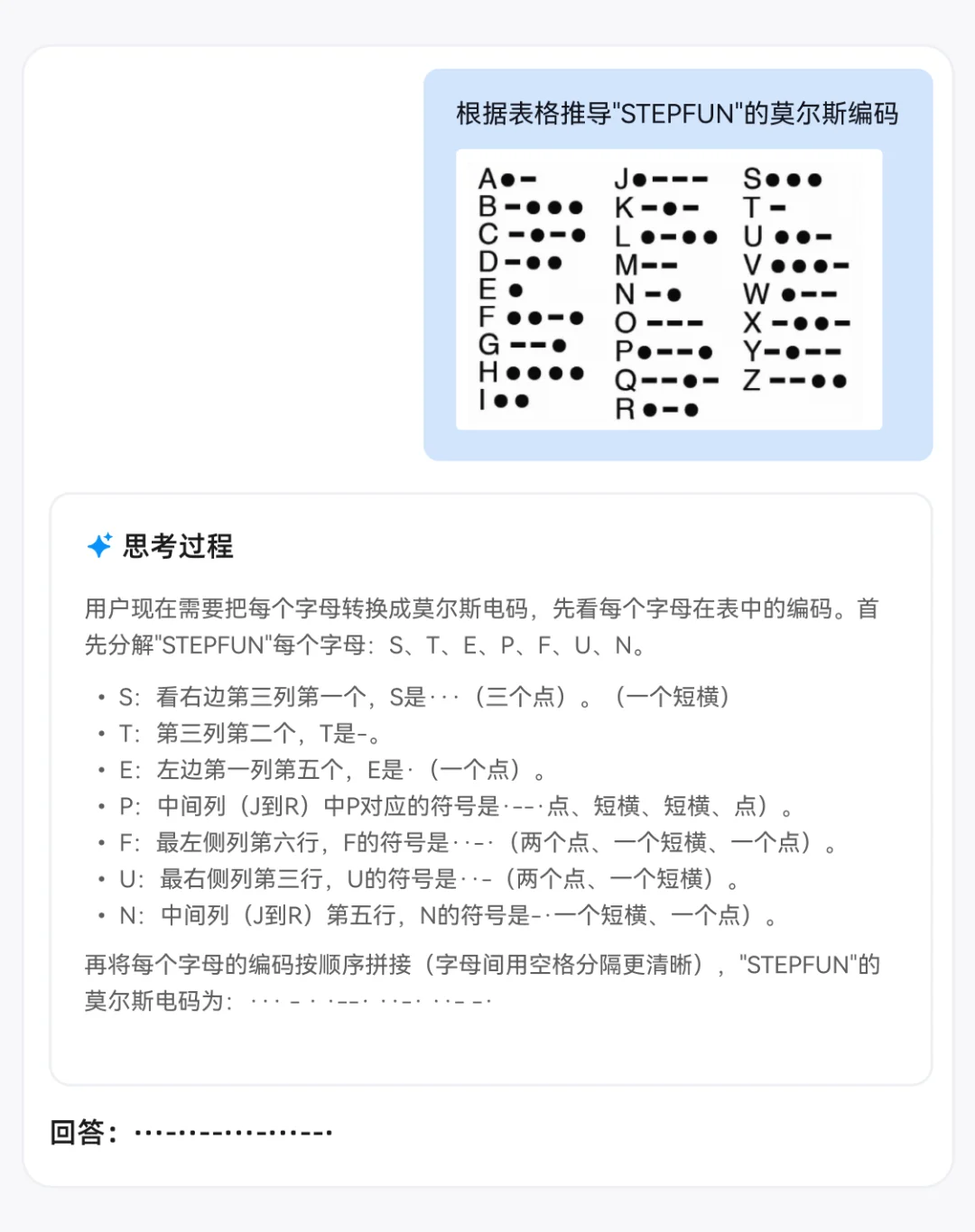

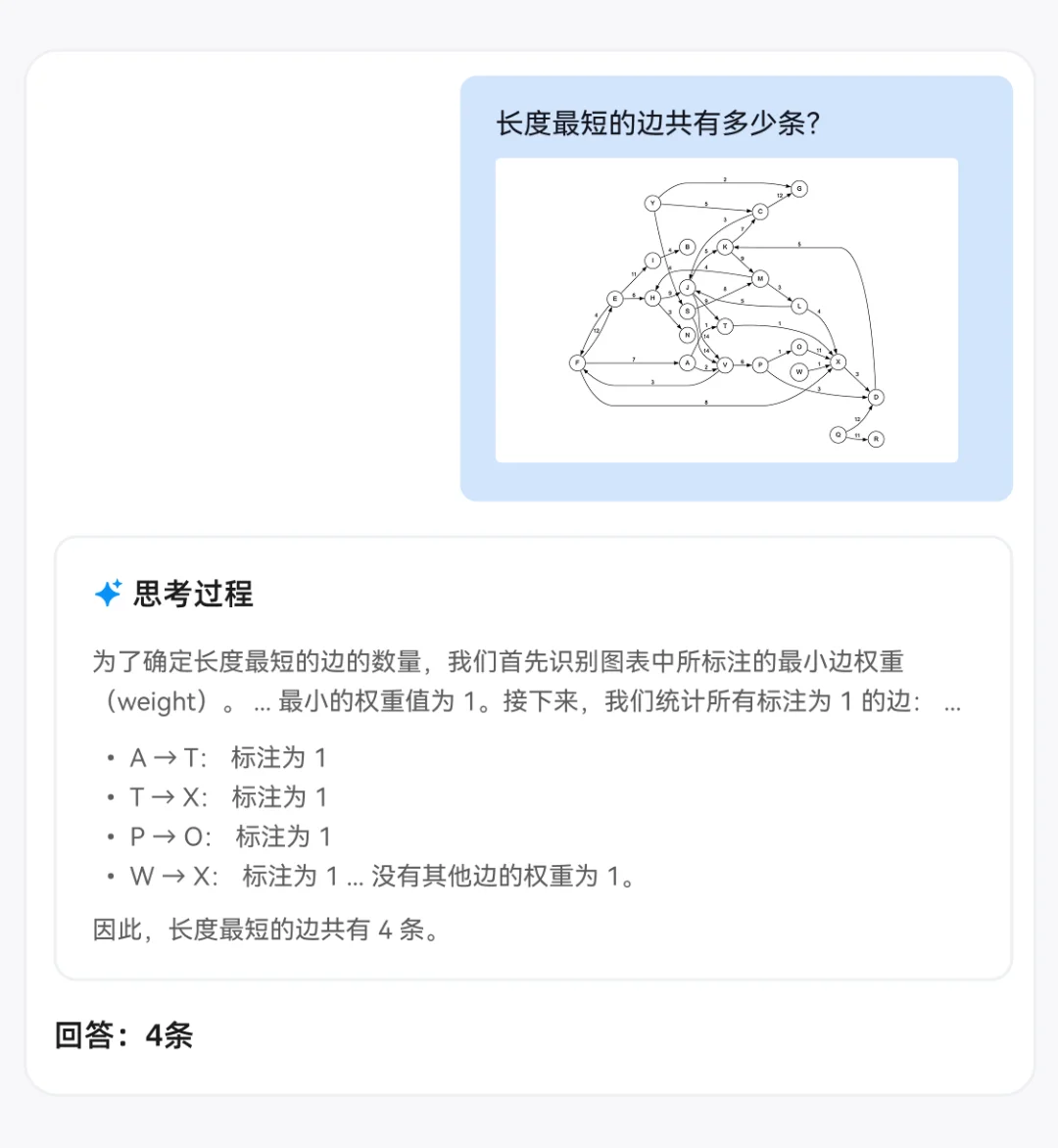

阶跃星辰在官方公众号里放出了Step3-VL-10B在多模推理能力方面的真实案例。

首先是关于摩尔斯编码的推理,可以看到模型的思考过程思路清晰,先拆解字母再逐个查表,最后拼接,流程正确,并且对大部分字母如S、T、E、F、U、N的定位和编码描述准确。

其次是GUI感知能力,模型需要识别标签页中以章节开头.tex结尾的文件标签,可以看到其思考过程采用了识别标签、排除非目标、统计数量的步骤进行了准确分析,并有效规避了干扰选项。

第三个是关于图推理的案例,模型需要在连线非常复杂的图片中准确识别中长度最短的线有几条,从思考过程可以看到,其先确认了最小权重的边长度是1,然后再统计所有权重为1的边。

Step3-VL-10B具备三大核心亮点:

视觉感知精度更高:在同参数量级中展现出顶尖的识别与感知精度,研究人员为其引入PaCoRe(并行协调推理)机制,模型在复杂计数、高精度OCR及空间拓扑理解等高难度任务上的可靠性提升。

深层逻辑推演与长程推理:得益于规模化强化学习(RL)的持续迭代,Step3-VL-10B在10B规模上能应对竞赛级数学难题、真实编程环境、视觉逻辑谜题。

端侧Agent交互:基于海量GUI(图形用户界面)专用预训练数据,模型能够精准识别并操作复杂界面。

具体来看,在多模态推理能力上,Step3-VL-10B在部分测试集上超越了GLM-4.6V、Qwen3-VL等模型,其性能优于10倍至20倍大的模型。

数学能力方面,该模型在AIME 25/24等数学竞赛测试题上得分超过94分,这意味着其在逻辑严密性上甚至优于许多千亿级模型。

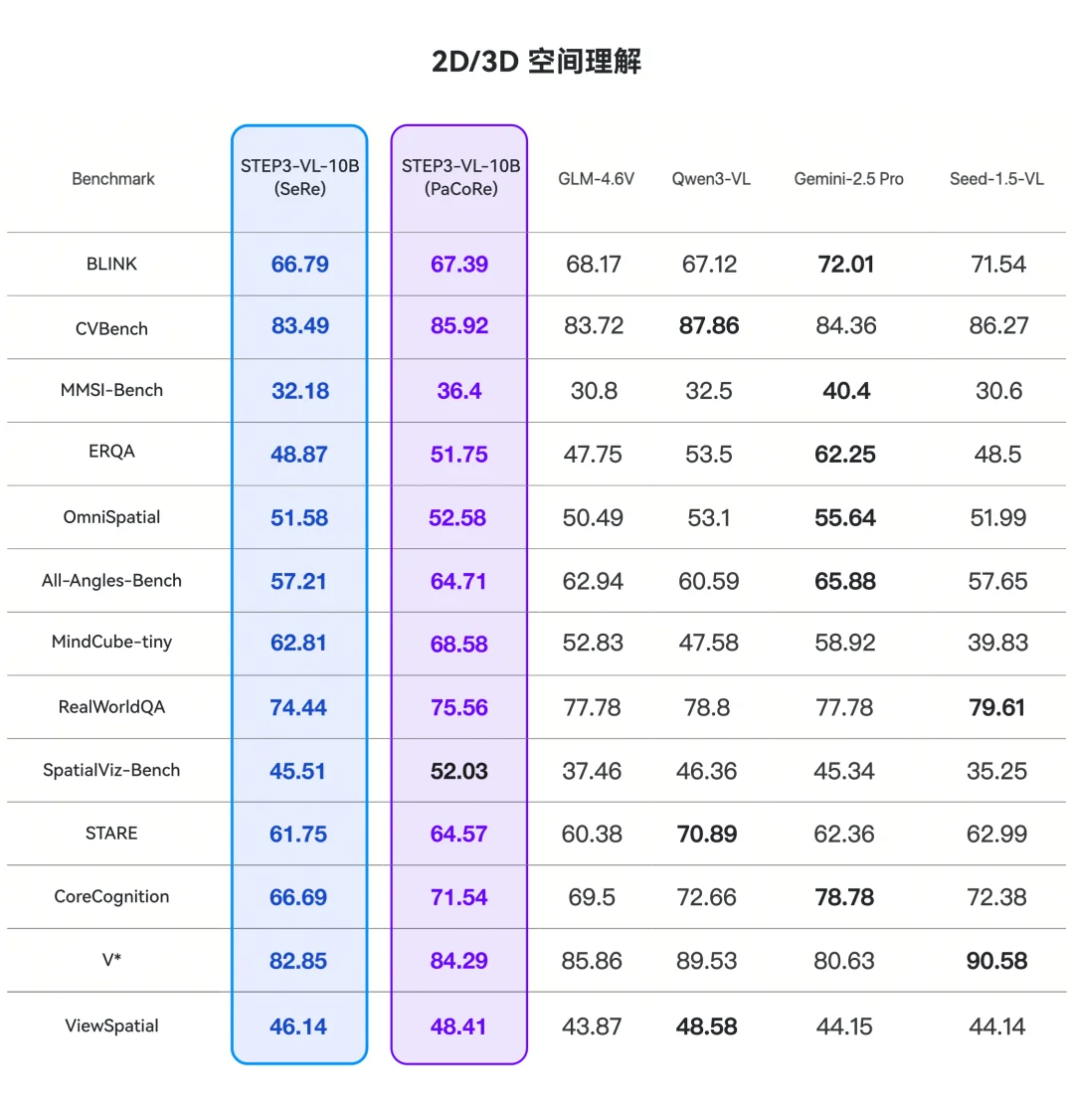

2D、3D空间推理能力上,模型在BLINK上表现出66.79%的涌现式空间意识,在All-Angles-Bench上达到57.21%,意味着该模型在具身智能应用方面具有强大的潜力。

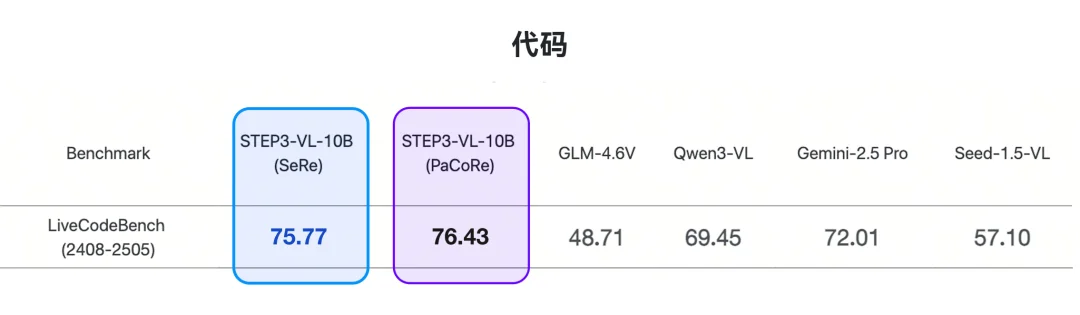

最后是编程能力,在真实、动态编程环境下,Step3-VL-10B超越GLM-4.6V、Qwen3-VL等模型。

此外,该模型的开源主页显示,研究人员在Qwen3VL-8B相关的基准测试中出现了不准确数据,例如AIME、HMMT、LCB,目前正在修复。这些错误是由于其在大规模评估过程中max_tokens设置错误造成,他们将重新运行测试,并在下一版技术报告中提供修正后的数据。

03.

从感知到推理双提升

三大关键设计加持

该模型的论文提到,Step3-VL-10B的性能突破得益于三个关键设计:

一是在高质量多模态语料库上进行统一预训练:研究人员采用单阶段、完全解冻的训练策略,在1.2T token的多模态语料库上进行训练,重点关注两大基础能力:推理和感知,例如通用知识和教育中心任务等推理能力,定位、计数、OCR和GUI交互等感知能力。

通过联合优化感知编码器和Qwen3-8B解码器,STEP3-VL-10B建立了内在的视觉-语言协同效应。

二是缩放多模态强化学习:通过一个严格的后训练流程解锁了前沿能力,该流程包括两阶段监督微调(SFT)以及超过1400次的强化学习迭代,结合可验证奖励(RLVR)和人类反馈(RLHF)。

三是并行协调推理机制:研究人员采用并行协调推理(PaCoRe),支持推理阶段的动态算力扩展。通过并行探索多个感知假设并进行多维证据聚合,该机制显著提升了模型在竞赛级数学、复杂OCR识别、精准物体计数及空间拓扑推理中的准确度。

阶跃星辰的官方公众号提到,得益于“三位一体”架构,Step3-VL-10B证明智能水平并不完全取决于参数规模。这也意味着:世界一流的多模态能力有望以更低成本、更少算力获得;与此同时,过去主要集中在云端超级智能将逐步向端侧下沉,推动终端走向“主动理解与可执行交互”。

从Step3-VL-10B的实测可以看出,该模型凭借10B轻量化参数体量,通过高质量多模态语料统一预训练、千余次强化学习迭代及并行协调推理机制,实现了对超大规模模型的跨级性能追赶。

并且具体到GUI交互、精准计数、竞赛级数学推理等任务,该模型也展现出较大应用潜力,未来有望降低在工业质检、本地文档分析、基层医疗辅助等场景的部署门槛。

文章来自于“智东西”,作者 “程茜”。

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner