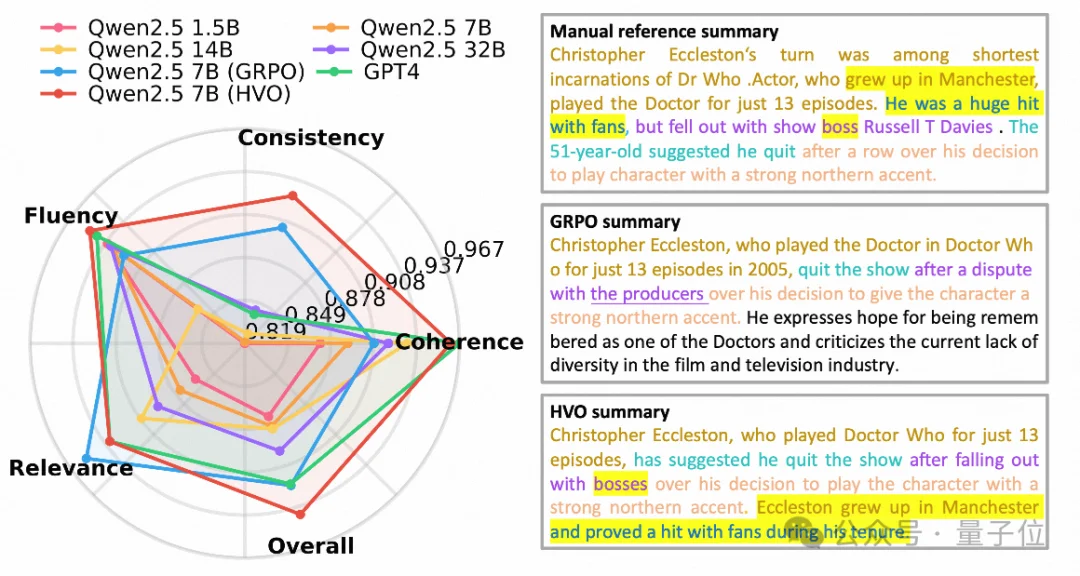

文本摘要作为自然语言处理(NLP)的核心任务,其质量评估通常需要兼顾一致性(Consistency)、连贯性(Coherence)、流畅性(Fluency)和相关性(Relevance)等多个维度。

然而,在实际优化过程中,开发者往往面临”拆东墙补西墙”的窘境:提升了相关性,一致性可能随之下降。如何让模型在多个目标之间达成完美的”帕累托最优”(Pareto optimal)?

近日,Li Auto团队一项被ICASSP 2026接收的研究提出了HyperVolume Optimization(HVO)。这是一种全新的多目标强化学习(MORL)策略,它基于GRPO框架,无需SFT或冷启动,就能让7B参数的模型在摘要任务上展现出媲美GPT-4的性能,且生成内容更加简洁。

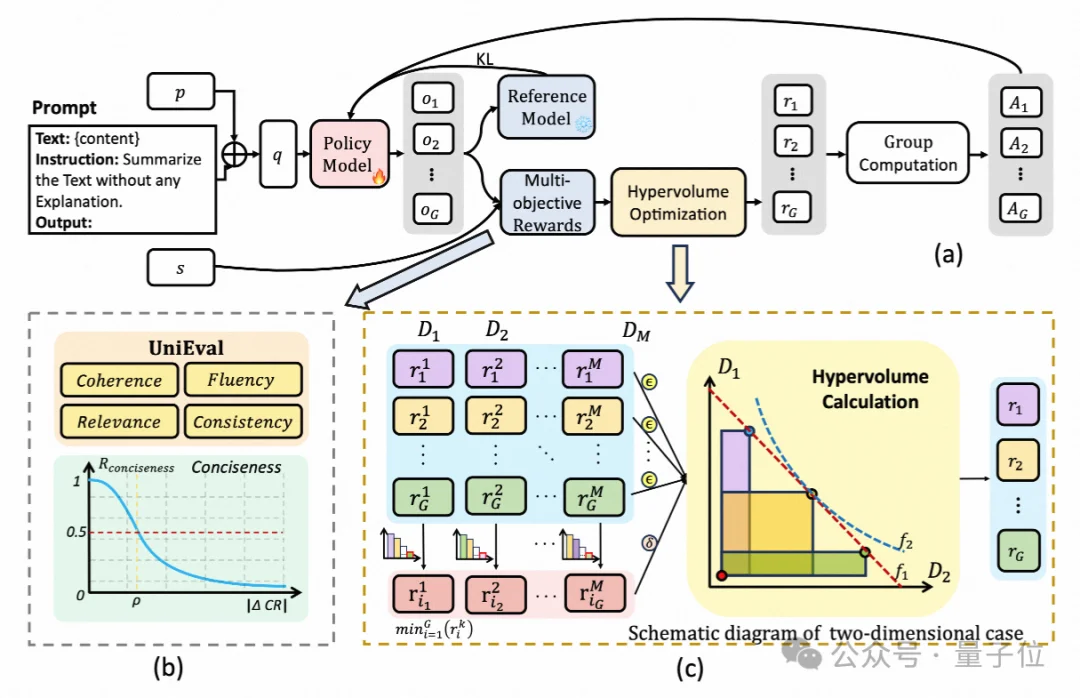

文本摘要生成是自然语言处理(NLP)中的一项核心且具有挑战性的任务。为了全面评估生成摘要的质量,研究人员通常会考察多个维度,例如连贯性、一致性、流畅性和相关性。然而,同时优化这些维度的目标具有挑战性,因为在一个维度上的改进可能会导致其他维度的妥协,从而产生不平衡的摘要。

目前的文本摘要研究多依赖单一奖励信号,难以整合多维度指标。即便采用多维度奖励,通常也只是简单地将各项得分进行加权线性组合(Weighted Linear Combination)。

这种传统做法存在明显局限:

1. 人工依赖:需要繁琐的手动配置权重

2. 目标冲突:无法有效处理目标间的相互依赖,容易导致优化结果不完整或严重失衡

此前虽有MDO等方法尝试通过梯度投影缓解冲突,但因计算成本过高,难以集成到大语言模型(LLM)中。

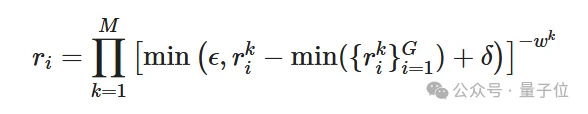

为了解决上述问题,研究者将多目标优化中的超体积(Hypervolume)概念引入到了强化学习的奖励结构中。

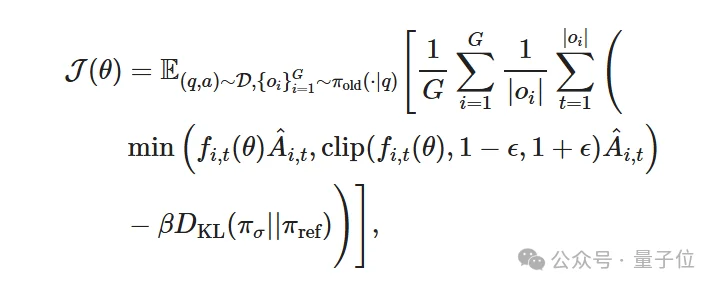

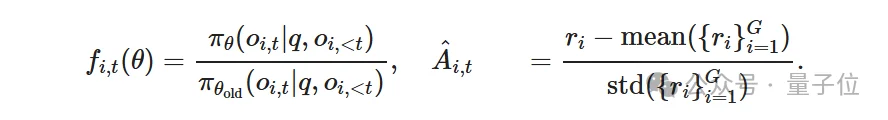

借鉴了类似DeepSeek-R1-Zero的训练范式,HVO直接在基础模型上应用组相对策略优化(GRPO),无需经过监督微调(SFT)。

其中:

HVO利用超体积方法,在强化学习过程中动态调整不同得分组之间的权重,引导模型逐步逼近帕累托前沿。

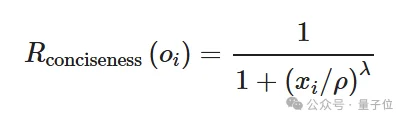

为解决GRPO训练中常见的稳定性不足和”长度坍缩”问题,HVO提出了一种新的长度约束奖励(Rconciseness),通过控制压缩比确保模型在简洁的同时保持稳定收敛。

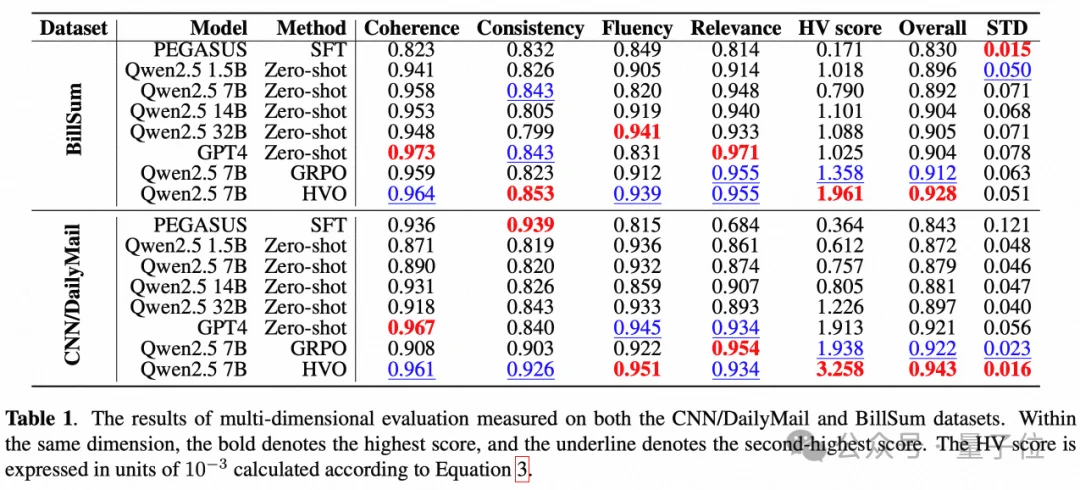

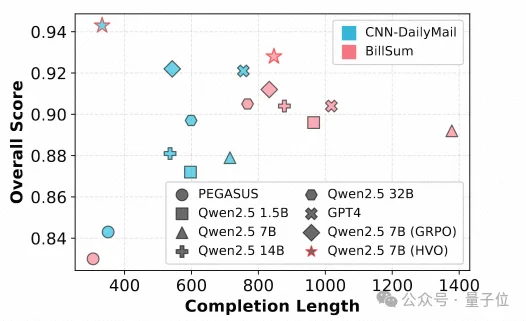

研究团队在CNN/DailyMail(新闻类)和BillSum(法律类)两大基准数据集上对HVO进行了验证。实验基座采用Qwen 2.5-7B-Instruct。

在多维度评估工具UniEval的测试中,经过HVO增强的7B模型表现惊人:

2. 更均衡的雷达图表现

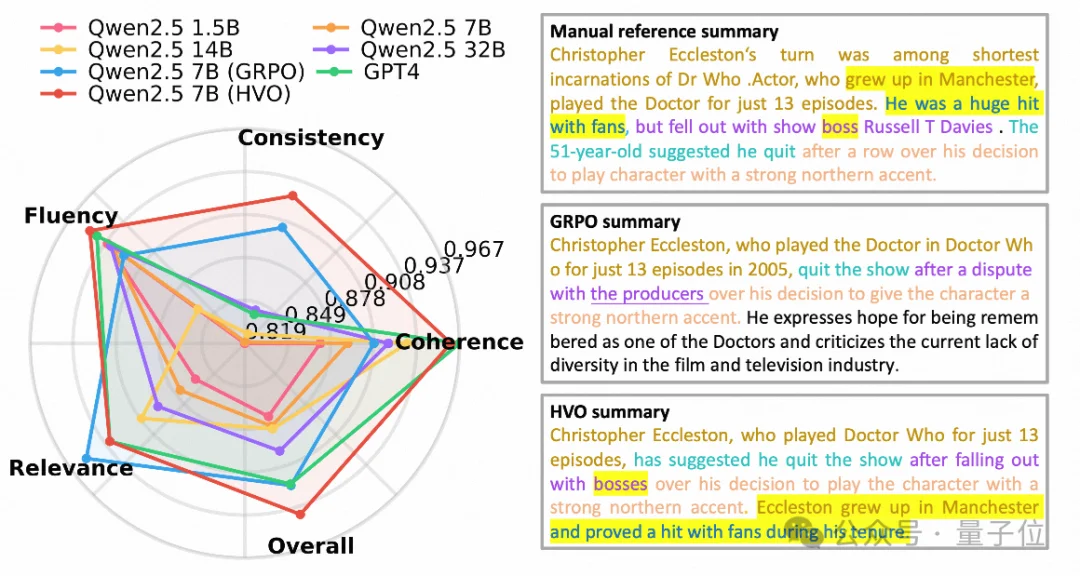

对比GRPO发现,GRPO在训练早期会过度追求流畅性和相关性,从而限制了一致性的提升。而HVO能够均匀地优化各项指标,在雷达图上展现出更饱满、更稳定的覆盖区域。

散点图分析显示,HVO在保持最高总分的同时,生成的摘要长度更短,展现了极佳的简洁性(Conciseness)。

本文介绍了超体积优化强化学习方法(HVO),这是一种用于文本摘要的多目标强化学习框架,可在高维目标空间中直接优化超体积指标。通过平衡多个评估指标,HVO实现了更稳定、更高效地向帕累托前沿逼近的轨迹。

在CNN/DailyMail和BillSum上的实验表明,HVO取得了最先进的超体积和整体分数,优于现有方法,且可与GPT-4相媲美,无需监督微调或冷启动初始化。

这些结果证实了HVO在处理复杂权衡和生成高质量摘要方面的有效性,为多目标文本摘要提供了一个稳健的解决方案。它证明了通过科学的优化策略,较小规模的开源模型完全有潜力在特定任务上对标顶尖闭源大模型。

研究团队表示,未来将探索:

论文标题:

Hypervolume Optimization via Multi-Objective Reinforcement Learning for Balanced Text Summarization

论文地址:

https://arxiv.org/abs/2510.19325

代码仓库:

https://github.com/ai4business-LiAuto/HVO ⭐ 已开源

收录会议:

ICASSP 2026

文章来自于微信公众号 “量子位”,作者: “量子位”

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner