微软用一个671B的“推理中枢”,把广告系统的脏活累活都管了,性能还全面碾压一众前辈。

在工业级广告推荐系统中,普遍正面临一个吊诡的现状:在通用大语言模型(LLM)的推理能力已经登峰造极的同时,为了追求毫秒级的响应,通常无法直接把LLM用到线上而是在离线端堆积了成百上千个“小模型”——有的管相关性标注,有的管用户画像,等等。

这种“模型森林”范式正逐渐成为进化的阻碍。模型间知识割裂、运维成本高昂、决策过程黑盒化。

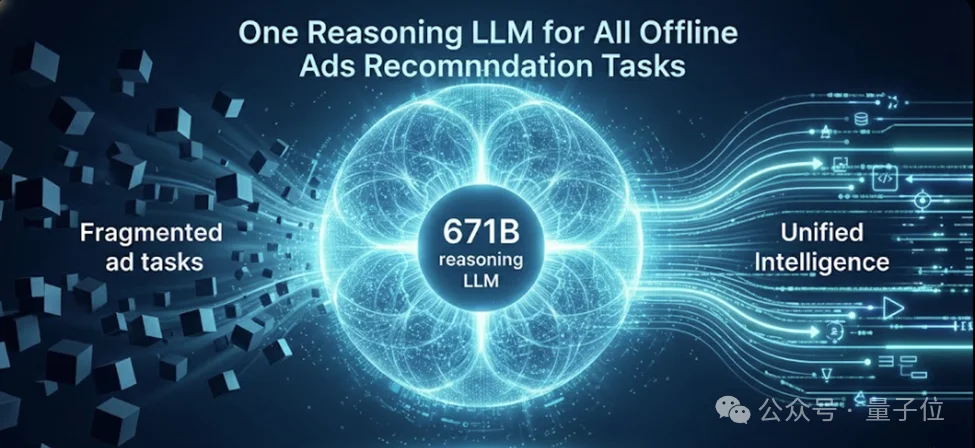

近日,微软Bing Ads与DKI团队发表论文《AdNanny: One Reasoning LLM for All Offline Ads Recommendation Tasks》,宣布基于DeepSeek-R1 671B打造了统一的离线推理中枢AdNanny,用单一模型承载所有离线任务。这标志着从维护一系列任务特定模型,转向部署一个统一的、推理中心化的基础模型,从而以更高性能和更低成本为整个广告生态系统提供离线智能。

在现代广告推荐技术栈中,依赖大量离线任务支撑,如:query-ad相关性标注、用户画像生成、关键词扩写、创意优化……这些离线任务通常用来为在线模型提供特征、数据和标签,工程师们为每个子任务都微调专属的BERT或小型LLM。这种“一任务一模型”的体系存在很多痛点,如:

知识孤岛:尽管任务间共享广告领域知识共享底层语义,但在碎片化模型下,知识被重复学习,重复造轮子,效率极低。

性能瓶颈:受限于成本,各任务专属模型通常规模较小,面对长尾流量和复杂语义时,容易出现“理解偏差”。而且决策往往是黑盒的,输出不提供解释。当模型判断错误时,算法工程师无法溯源,人工审核也无从下手。

维护成本高企:每个模型需独立数据管道、训练流程、部署和监控体系,工程负担沉重。

AdNanny的核心愿景是:打造一个全能推理大脑,它不再是只为某个子任务服务的工具,而是整个离线生态的智能中枢。

AdNanny强大的根基在于它改变了数据的形态。论文提出,要让模型从单纯的“记忆标签映射”转变为“理解决策逻辑”。为此,团队构建了一个三阶段的自动化数据工厂,将数百万条广告数据转化为带有推理过程的高质量语料:

1. 推理生成:引入教师模型针对广告样本生成“思维链”(CoT)。例如,在判断“扫地机器人”与“智能家电”的相关性时,模型必须写出:“扫地机器人属于智能家居范畴,满足用户的自动化清洁需求,因此具有高语义相关性。”

2. 黄金集验证:利用人类专家标注的小规模高精数据,对生成的推理路径进行交叉比对,剔除存在“幻觉”或逻辑断裂的样本,监督推理生成的准确性以及时调整生成策略。

3. 拒绝采样:只有当模型生成的推理逻辑能准确导向正确标签时,该样本才会被收录。这种方法确保了AdNanny学习到的是正确的因果关系,而非虚假的统计关联。

通过将“推理过程”显性化,AdNanny成功让不同任务在逻辑层面上汇合。

参与训练的各个任务数据量差异极大,样本难度不均,优化目标各异,如何让一个671B的巨兽同时处理多个任务?AdNanny引入了两套关键机制:

在海量多任务训练中,简单任务和样本往往会过早收敛,无法从中学习到有效知识,而且有的任务数据量巨大可能会主导整个训练过程,导致样本量小的任务被忽视。AdNanny采用了动态权重调整策略:

实例级:如果某个样本的困惑度下降缓慢,说明模型对其理解尚浅,系统会自动增加该样本的训练权重。

任务级:根据各个任务在验证集上的表现,动态平衡采样比例,防止“相关性标注”这类大数据量任务淹没“广告创意生成”等高价值小任务。

这是AdNanny落地生产的关键。团队意识到,语言层面的“合理”不代表业务层面的“有效”。

因此,他们在微调阶段引入了强化学习:奖励函数直接以下游的业务指标(如Recall@K、在线CTR预估值的变化量)作为Reward。这种对齐方式强迫模型生成的推理和特征必须对最终的广告点击和转化产生正向贡献。

AdNanny团队基于Megatron框架进行了深度定制,实现了极高的算力利用率。

采用31路流水线并行+8路专家并行+8路数据并行的混合方案,在248块GPU上实现负载均衡。其中而对于频繁调用的“共享专家(Shared Experts)”,则采取全复制策略。

这意味着最关键的通用知识在每个GPU上触手可及,极大地减少了全量交换(All-to-All)带来的网络瓶颈。同时,为了解决大规模训练中的通信死锁问题,团队为首节点设计了“空桩优化器”(Stub Optimizer)。

通过FP8量化推理,AdNanny在保持高精度的前提下,推理成本大幅压缩。在Bing Ads实际测算中,AdNanny替代多个小模型后,整体离线算力成本反而下降了约50%。

验证结果令人振奋:在Query-Ad相关性判断、Ad-User匹配、查询生成等多个核心任务上,AdNanny的表现均大幅超过了此前微调过的专属模型。其真正的社会学/工程学价值在于:

由于模型具备推理能力,原本需要人工标注的大量模糊样本,现在可以由AdNanny提供可信的初审理由,人工只需对推理逻辑进行抽检。

告别了数十套独立的数据模型Pipeline和监控体系,系统变得清晰简洁易维护。

AdNanny的机构脱离了对“算力奇迹”的简单依赖,基于对工业AI路径的深刻反思做出了新的尝试。

其启发性在于:面对复杂的工业场景,最好的方案往往不是更多的补丁,而是更深邃的逻辑。正如原论文结语所言,AdNanny并不是要取代在线推荐模型,而是要成为整个离线系统的“灵魂引擎”。在广告领域之外,这种“以一个推理大模型统一所有碎片化任务”的思路,必将在搜索、电商、乃至金融决策领域掀起新的波澜。

那么,这种“中枢化”的模型架构,是会最终导致大量广告算法工程师的危机?还是会把大家从琐碎的调参中解放出来呢?

论文链接:

https://arxiv.org/pdf/2602.01563v1

文章来自于微信公众号 "量子位",作者 "量子位"

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner