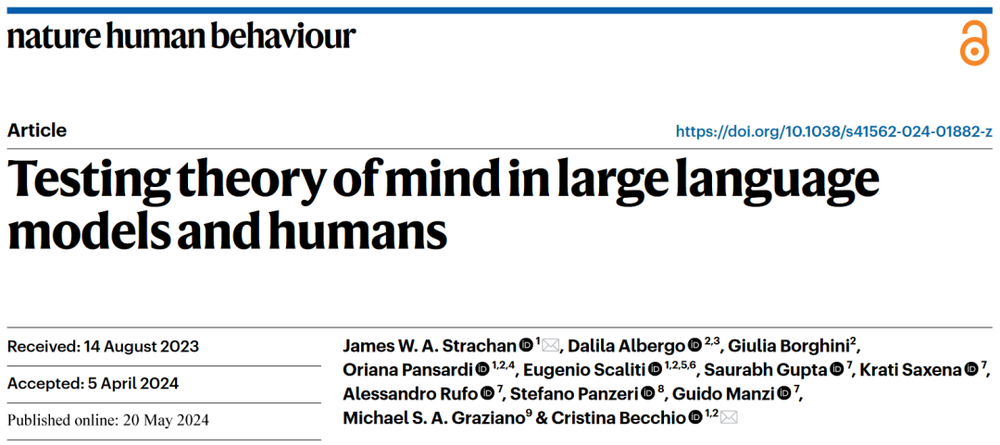

AI大模型会“读心”吗?

AI大模型会“读心”吗?请想象这样一个场景。你坐在公交车上靠窗的位置,这时你的朋友突然对你说:“今天好像有点热”。你会怎么回应?大多数人的做法应该是立即打开窗户,因为他们巧妙地理解了朋友的言外之意:他是在礼貌地请求自己打开窗户,而不是单纯因为无聊而谈论天气。

请想象这样一个场景。你坐在公交车上靠窗的位置,这时你的朋友突然对你说:“今天好像有点热”。你会怎么回应?大多数人的做法应该是立即打开窗户,因为他们巧妙地理解了朋友的言外之意:他是在礼貌地请求自己打开窗户,而不是单纯因为无聊而谈论天气。

天津大学与南京大学联合团队在CVPR 2024上发表了LPSNet项目,提出了一种端到端的无透镜成像下的3D人体姿态和形状估计框架,通过多尺度无透镜特征解码器和双头辅助监督机制,直接从编码后的无透镜成像数据中提取特征并提高姿态估计的准确度。

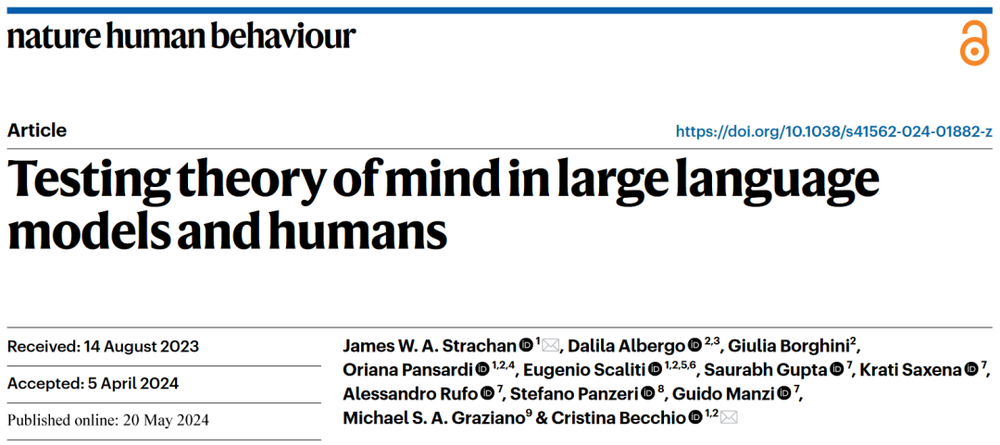

最近,OpenAI的一位前员工发表了一篇165页的超长博文,对AI发展的未来做出了一系列预测。文章的核心观点可以概括成一句话:人类很可能在2027年实现AGI。

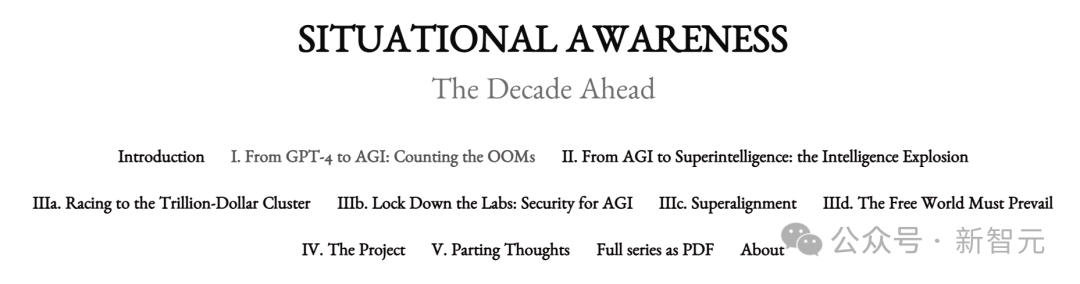

本文介绍了KAN网络算法的原理和优势,探讨了其在深度学习领域可能引发的范式转变。 • ⚡ KAN网络将可学习的激活函数从神经元移到了神经网络的边上,表现出更高的准确性和更少的参数量 • ???? KAN在数学和物理领域的实验中展现了卓越性能,提供了一种新的科学发现的路径 • ???? KAN具有更快的神经缩放定律和可解释性,为AI领域带来了新的探索可能性

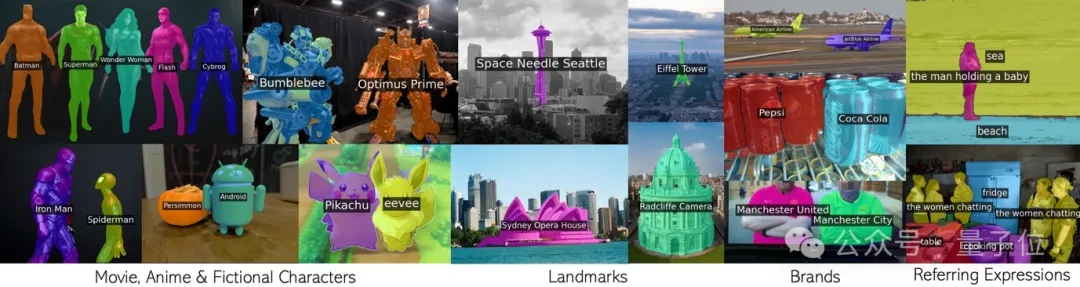

循环调用CLIP,无需额外训练就有效分割无数概念。 包括电影动漫人物,地标,品牌,和普通类别在内的任意短语。

北航的研究团队,用扩散模型“复刻”了一个地球? 在全球的任意位置,模型都能生成多种分辨率的遥感图像,创造出丰富多样的“平行场景”。 而且地形、气候、植被等复杂的地理特征,也全都考虑到了。

过去十年间,基于随机梯度下降(SGD)的深度学习模型在许多领域都取得了极大的成功。与此同时各式各样的 SGD 替代品也如雨后春笋般涌现。在这些众多替代品中,Adam 及其变种最受追捧。无论是 SGD,还是 Adam,亦或是其他优化器,最核心的超参数非 Learning rate 莫属。因此如何调整好 Leanring rate 是炼丹师们从一开始就必学的技能。

OpenAI前员工Leopold Aschenbrenner,之前在超级对齐(Superalignment)部门,可是能和Ilya大佬共事的。

大模型的下一个突破方向是什么?斯坦福大学教授吴恩达的答案是AI智能体工作流。

本文从技术角度介绍推荐系统发展,以及AI大模型在搜索推荐领域落地的前沿技术。

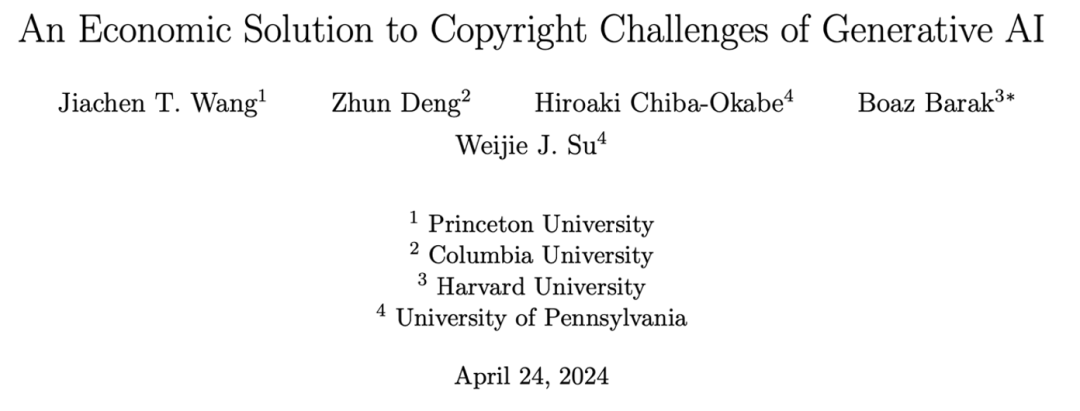

就算是 OpenAI 在舆论场也无法逃过版权保护的呼声。

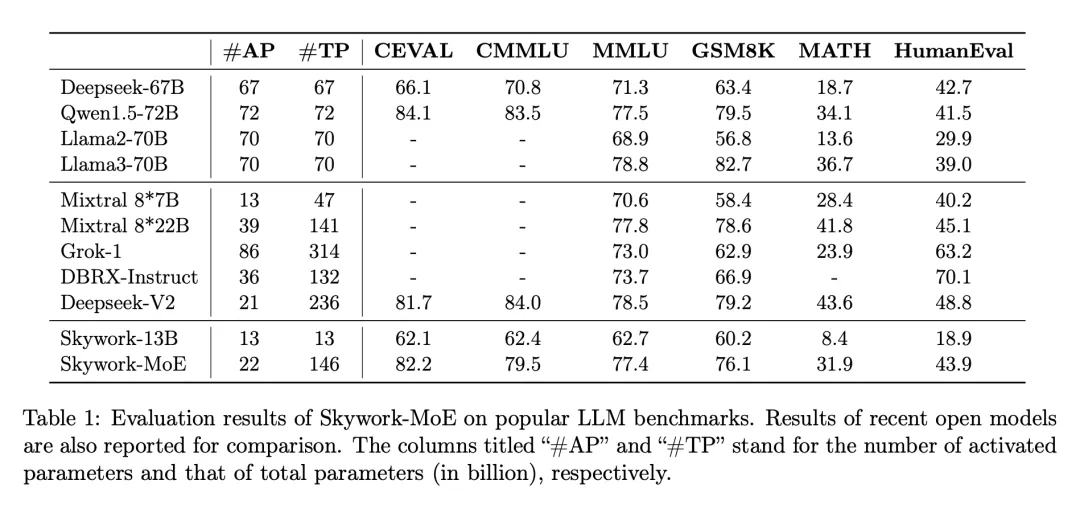

在大模型浪潮中,训练和部署最先进的密集 LLM 在计算需求和相关成本上带来了巨大挑战,尤其是在数百亿或数千亿参数的规模上。为了应对这些挑战,稀疏模型,如专家混合模型(MoE),已经变得越来越重要。这些模型通过将计算分配给各种专门的子模型或「专家」,提供了一种经济上更可行的替代方案,有可能以极低的资源需求达到甚至超过密集型模型的性能。

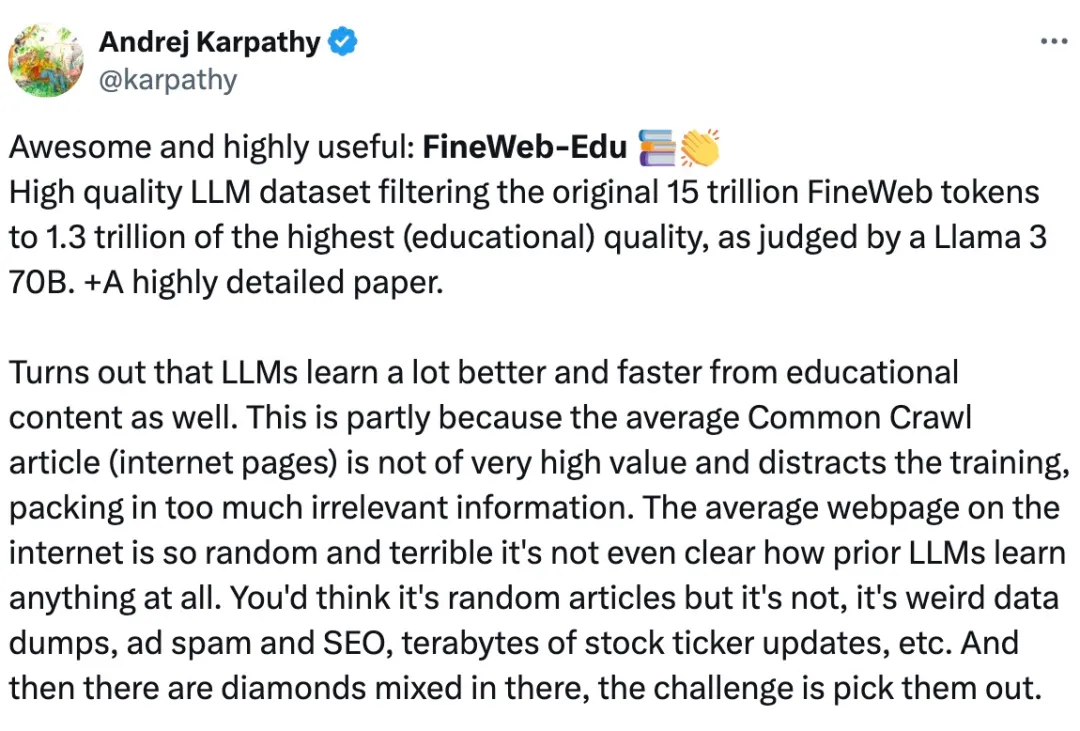

众所周知,对于 Llama3、GPT-4 或 Mixtral 等高性能大语言模型来说,构建高质量的网络规模数据集是非常重要的。然而,即使是最先进的开源 LLM 的预训练数据集也不公开,人们对其创建过程知之甚少。

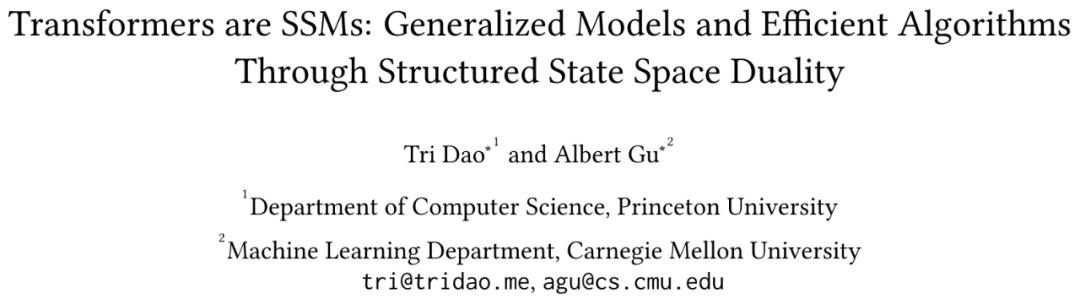

自 2017 年被提出以来,Transformer 已经成为 AI 大模型的主流架构,一直稳居语言建模方面 C 位。

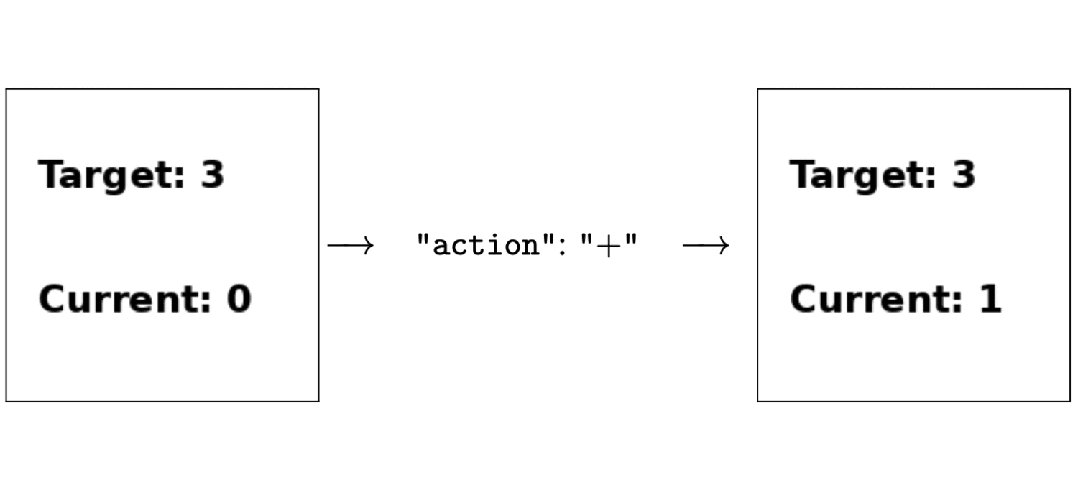

只用强化学习来微调,无需人类反馈,就能让多模态大模型学会做决策!

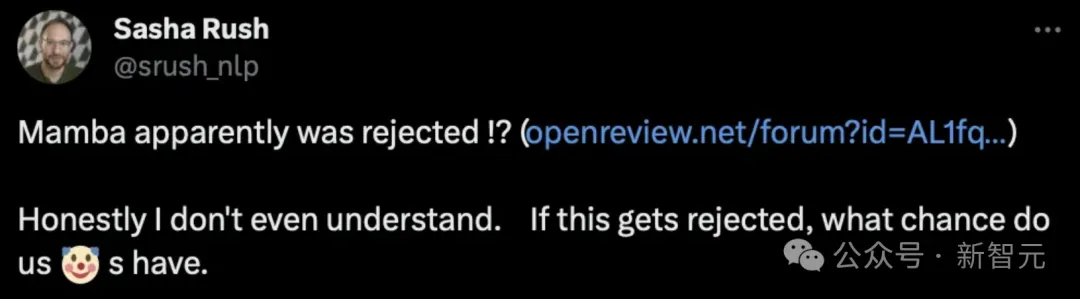

Transformer挑战者、新架构Mamba,刚刚更新了第二代:

华南理工大学和香港大学的研究人员在ICML 2024上提出了一个简单而通用的时空提示调整框架FlashST,通过轻量级的时空提示网络和分布映射机制,使预训练模型能够适应不同的下游数据集特征,显著提高了模型在多种交通预测场景中的泛化能力。

在复杂的物理世界中,人型机器人的全身控制一直是个难题,现有的强化学习做出的效果有时会比较抽象。近日,LeCun参与的一项工作给出了基于数据驱动的全新解决方案。

微软发布首个大规模大气基础模型Aurora,可被用于预测和减轻极端天气影响,模型拥有超高的准确率和效率,与如今数值预报系统界的SOTA相比,它的计算速度提高了约5000倍。

在开源社区引起「海啸」的Mamba架构,再次卷土重来!这次,Mamba-2顺利拿下ICML。通过统一SSM和注意力机制,Transformer和SSM直接成了「一家亲」,Mamba-2这是要一统江湖了?

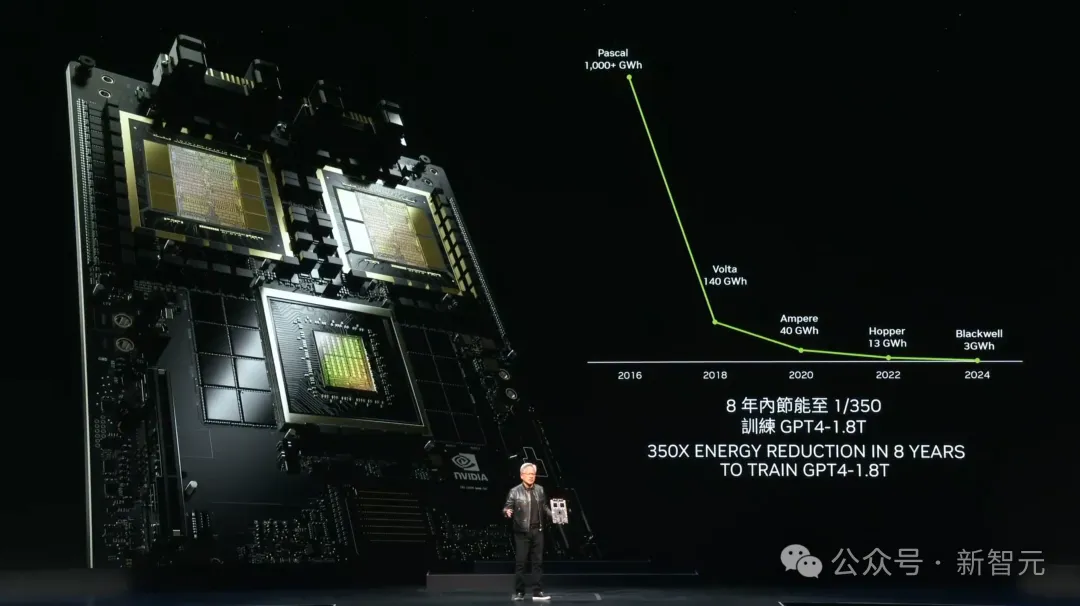

6 月 2 日,英伟达创始人黄仁勋在 Computex 2024(2024 台北国际电脑展)上发表主题演讲,分享了人工智能时代如何助推全球新产业革命,并且展示了最新的 Blackwell 芯片和后续的一系列更新节奏。

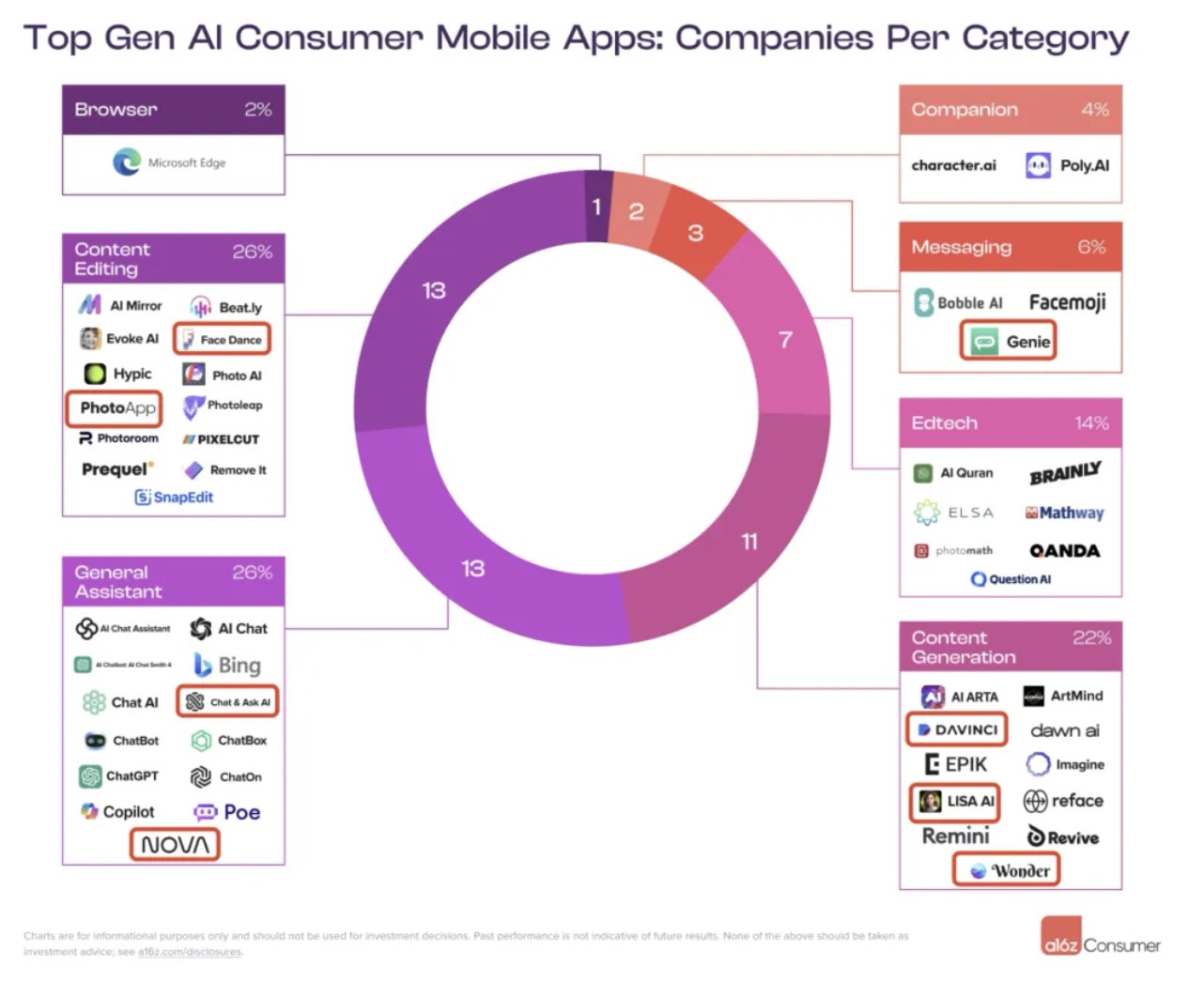

在 a16z 给出的按照 MAU 排名的全球 Top50 AI App 榜单中,来自土耳其的 Codeway 和 HubX 两个公司各有三款产品进入了 Top50 当中,除了这 6 款产品,还有 Genie 和 Lisa AI 两款产品也是由土耳其开发者推出的。单论上榜数量,美国开发者排在第一,土耳其敢称第二。

合理选择存储,助推生成式AI应用。麦肯锡研究报告显示,到2030年前,生成式AI有望为全球经济贡献7万亿美元的价值。

一般而言,训练神经网络耗费的计算量越大,其性能就越好。在扩大计算规模时,必须要做个决定:是增多模型参数量还是提升数据集大小 —— 必须在固定的计算预算下权衡此两项因素。

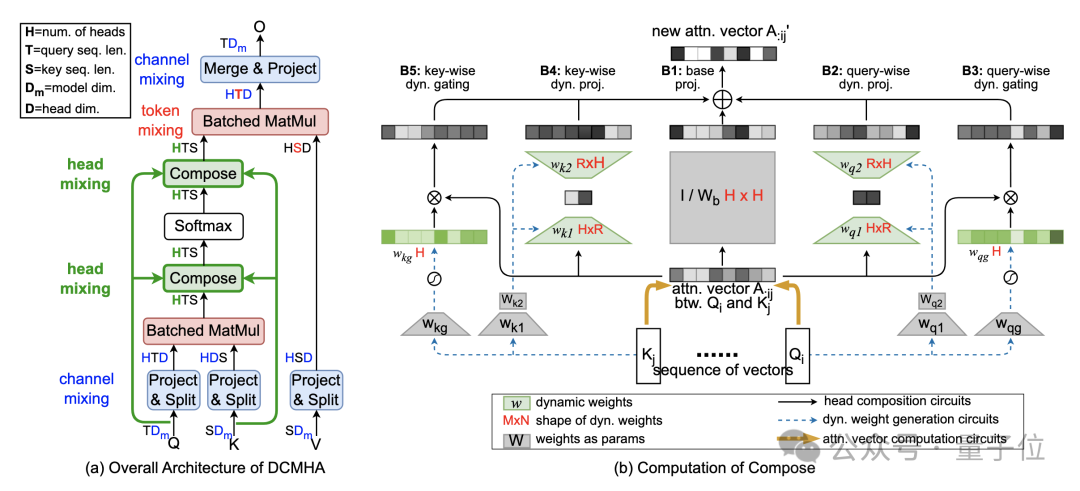

如何突破 Transformer 的 Attention 机制?中国科学院大学与鹏城国家实验室提出基于热传导的视觉表征模型 vHeat。将图片特征块视为热源,并通过预测热传导率、以物理学热传导原理提取图像特征。相比于基于Attention机制的视觉模型, vHeat 同时兼顾了:计算复杂度(1.5次方)、全局感受野、物理可解释性。

英伟达是今天生成式AI浪潮里最大的赢家,而黄仁勋要告诉世界,这一切跟运气无关,是英伟达预见并用实力创造了今天的一切。

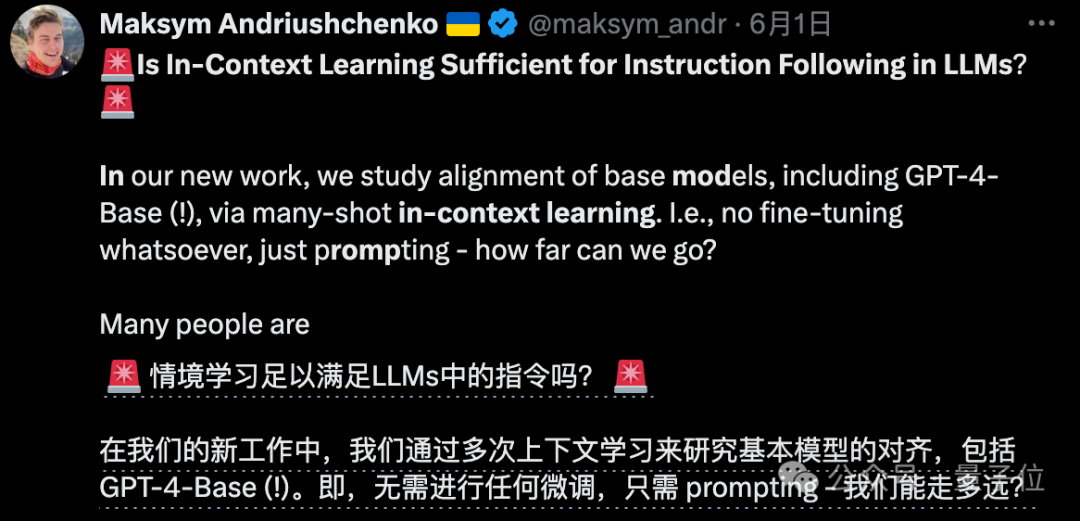

除了OpenAI自己,居然还有别人能用上GPT-4-Base版??

改进Transformer核心机制注意力,让小模型能打两倍大的模型!

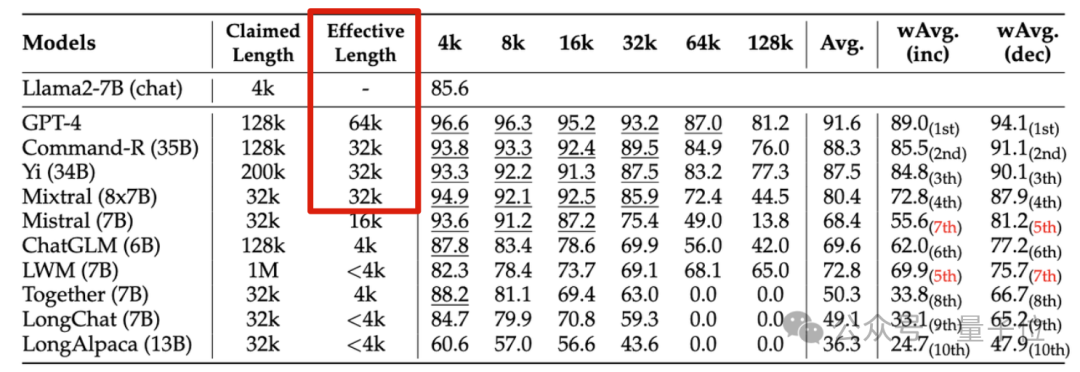

无情戳穿“长上下文”大模型的虚标现象

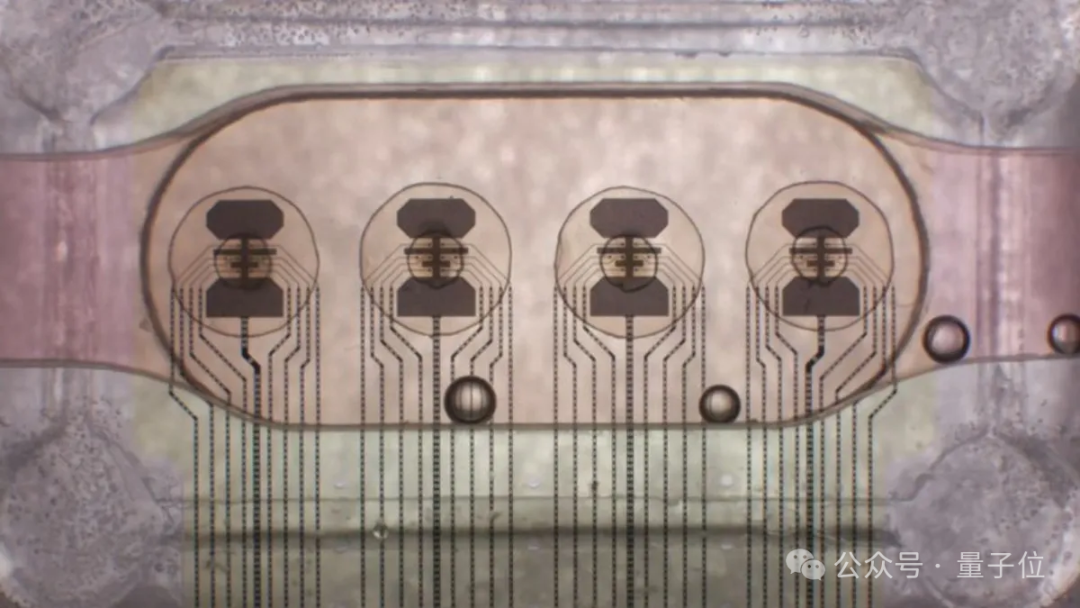

首个“脑PU”来了!由“16核”类人脑器官(human brain organoids)组成。