Bengio等人新作:注意力可被视为RNN,新模型媲美Transformer,但超级省内存

Bengio等人新作:注意力可被视为RNN,新模型媲美Transformer,但超级省内存既能像 Transformer 一样并行训练,推理时内存需求又不随 token 数线性递增,长上下文又有新思路了?

既能像 Transformer 一样并行训练,推理时内存需求又不随 token 数线性递增,长上下文又有新思路了?

一直以来 AI 都是一个黑盒子(black box),其内部运作机制是不可见的。人们输入数据并得到结果,但无法检查输出结果的逻辑或者系统的代码。 而就在刚刚,Anthropic 宣布在理解人工智能模型内部运作机制方面取得重大进展。

在人工智能的辉煌历史中,Geoffrey Hinton教授不仅是深度学习的奠基人之一,更是推动了整个领域从理论到实践的转变。在这次深入的访谈中,Geoffrey Hinton分享了自己在人工智能研究中的个人经历、对深度学习未来发展的深刻见解,以及对当前技术可能带来的社会影响的深思熟虑。

关节置换手术被称为骨科的“世纪手术”。

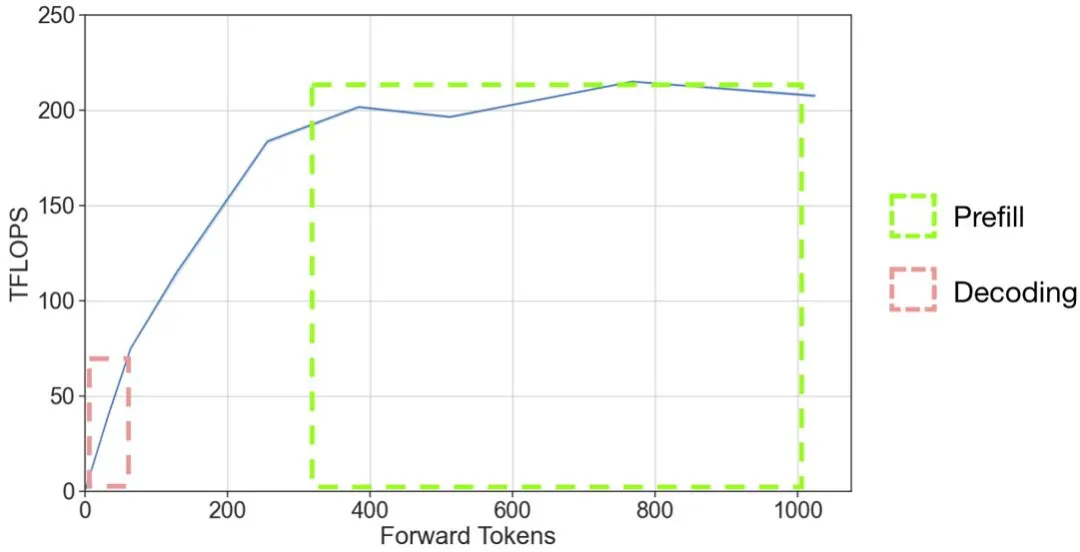

以 OpenAI 的 GPT 系列模型为代表的大语言模型(LLM)掀起了新一轮 AI 应用浪潮,但是 LLM 推理的高昂成本一直困扰着业务团队。

在 AI 领域,扩展定律(Scaling laws)是理解 LM 扩展趋势的强大工具,其为广大研究者提供了一个准则,该定律在理解语言模型的性能如何随规模变化提供了一个重要指导。

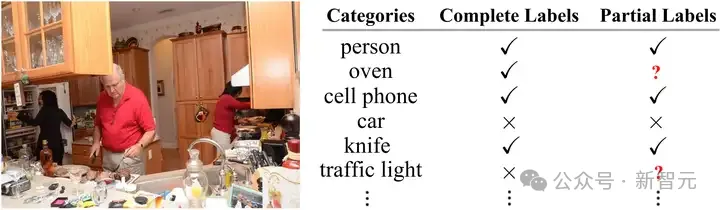

在多标签图像识别领域中,由于图像本身和潜在标签类别的复杂性,收集满足现有模型训练的多标签标注信息往往成本高昂且难以拓展。中山大学联合广东工业大学联手探索标注受限情况下的多标签图像识别任务,通过对多标签图像中的强语义相关性的探索研究,提出了一种异构语义转移(Heterogeneous Semantic Transfer, HST) 框架,实现了有效的未知标签生成。

5月22日,全球资本市场的“大网红”英伟达发布了2025财年第一财季(截至2024年4月28日)的报告。

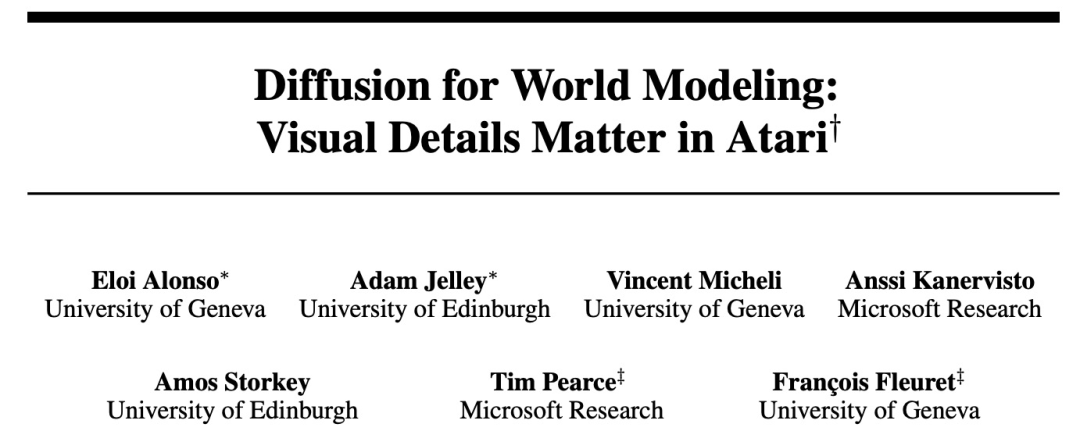

在图像生成领域占据主导地位的扩散模型,开始挑战强化学习智能体。

本文讨论了大模型厂商的降价现象,并分析了其背后的技术和商业动机。

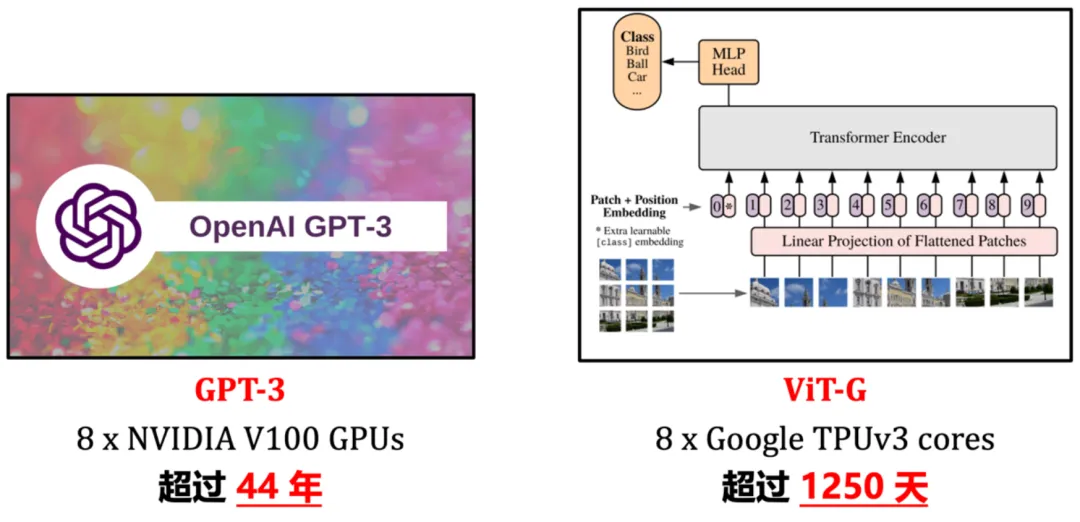

近年来,「scaling」是计算机视觉研究的主角之一。随着模型尺寸和训练数据规模的增大、学习算法的进步以及正则化和数据增强等技术的广泛应用,通过大规模训练得到的视觉基础网络(如 ImageNet1K/22K 上训得的 Vision Transformer、MAE、DINOv2 等)已在视觉识别、目标检测、语义分割等诸多重要视觉任务上取得了令人惊艳的性能。

AI服务器与传统服务器相比,究竟有何独特之处? 在当今社会,人工智能的应用场景愈发广泛,如小爱同学、天猫精灵等AI服务已深入人们的生活。随着人工智能时代的来临,AI服务器也开始在社会各行业发挥重要作用。那么,AI服务器与传统服务器相比,究竟有何独特之处?为何AI服务器能在人工智能时代中逐渐取代普通服务器,成为主流呢?

它们不仅仅是技术的展示,更是AI赋能千行百业的生动例证。

近日,西交微软北大联合提出信息密集型训练大法,使用纯数据驱动的方式,矫正LLM训练过程产生的偏见,在一定程度上治疗了大语言模型丢失中间信息的问题。

微软昨夜刚上演了一波AI PC革命,今天又全是Copilot。而最让人意外的,竟是奥特曼本人登台预告了下一代模型将会带来新的模态和整体智能。

近日,又一惊人结论登上Hacker News热榜:没有指数级数据,就没有Zero-shot!多模态模型被扒实际上没有什么泛化能力,生成式AI的未来面临严峻挑战。

Llama 3发布一个月后,一位开发者在GitHub上创建了名为「从头开始实现Llama 3」的项目,引起了开源社区的广泛关注。代码非常详细地展现了Llama所使用的Transformer架构,甚至让Andrej Karpathy亲自下场「背书」。

2023年3月的一天,美国政府的科技政策顾问Arati Prabhakar带着一台笔记本电脑走进了白宫的椭圆形办公室,向80岁的总统拜登展示了如何使用ChatGPT。

大模型的风,吹进中小学了。

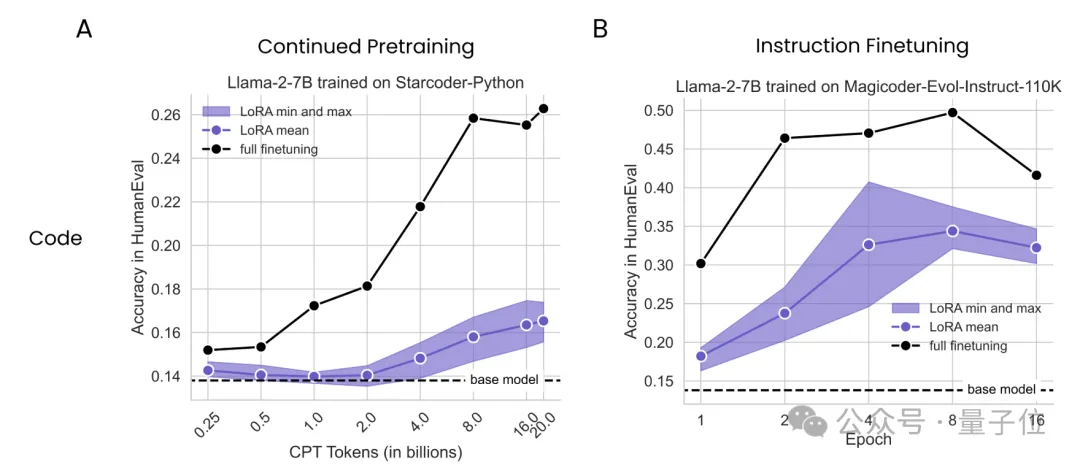

大数据巨头Databricks与哥伦比亚大学最新研究发现,在数学和编程任务上,LoRA干不过全量微调。

此次,苹果提出的多模态大语言模型(MLLM) Ferret-UI ,专门针对移动用户界面(UI)屏幕的理解进行了优化,其具备引用、定位和推理能力。

当计算预算低时,重复使用高质量数据更好;当不差钱时,使用大量数据更有利。

为了能让自己以后更好地摸鱼,我上周第一次和大模型协作,完成了对一份财报的分析。

随着AI带来的算力需求大爆发,以半导体为代表的各类硬件企业的营收也纷纷水涨船高。

最公平的大模型基准测试诞生了!来自LLM竞技场,最接近人类偏好,数据新鲜、速度快、成本低,严格分离学渣和学霸。

5月14日,开源的大语言模型Falcon 2发布,性能超越Llama 3,消息登上了Hacker News热榜第一。「猎鹰」归来,开源宇宙将会迎来新的霸主吗?

前几天,普林斯顿大学联合Meta在arXiv上发表了他们最新的研究成果——Lory模型,论文提出构建完全可微的MoE模型,是一种预训练自回归语言模型的新方法。

I/O大会上,谷歌Gemini 1.5 Pro一系列更新让开发者们再次沸腾。最新技术报告中,最引人注目的一点是,数学专业版1.5 Pro性能碾压GPT-4 Turbo、Claude 3 Opus,成为全球最强的数学模型。

预训练语言模型在分析核苷酸序列方面显示出了良好的前景,但使用单个预训练权重集在不同任务中表现出色的多功能模型仍然存在挑战。

Anthropic发布最新Claude宪法,兼具标准性和灵活性。语言模型如何决定它将涉及哪些问题,哪些问题它认为不合适涉及?为什么它会鼓励某些行为,而阻止另一些行为?语言模型有哪些「价值观」?