中国团队让AI拥有「视觉想象力」,像人类一样脑补画面来思考

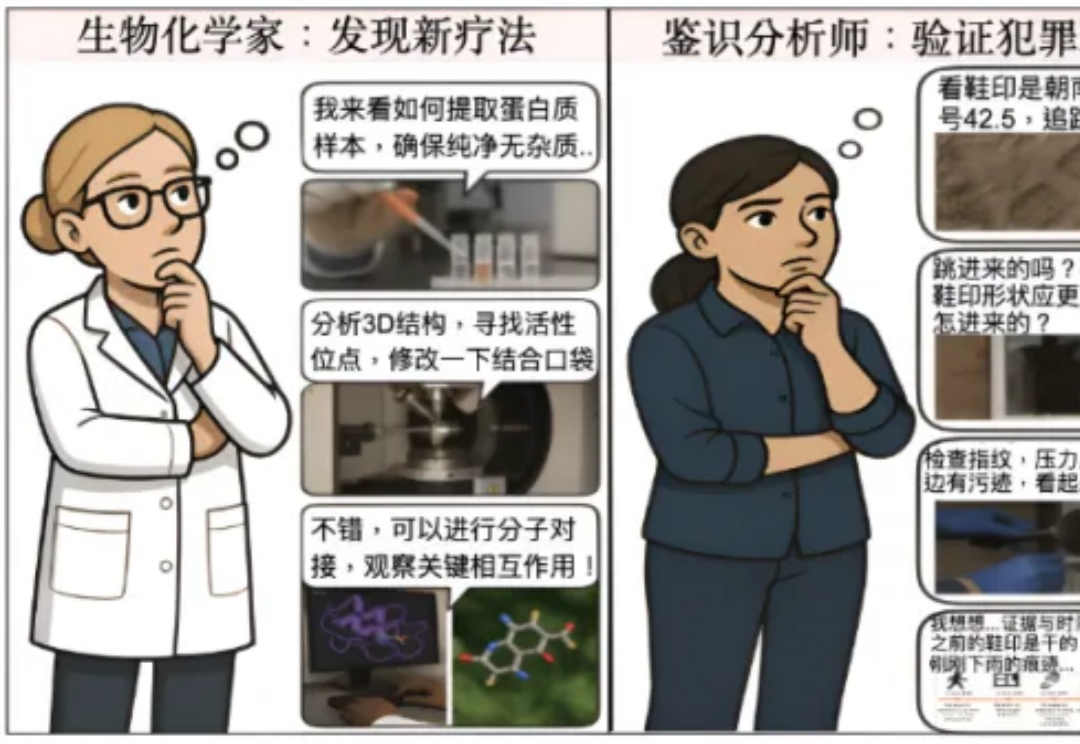

中国团队让AI拥有「视觉想象力」,像人类一样脑补画面来思考在人类的认知过程中,视觉思维(Visual Thinking)扮演着不可替代的核心角色,这一现象贯穿于各个专业领域和日常生活的方方面面。

在人类的认知过程中,视觉思维(Visual Thinking)扮演着不可替代的核心角色,这一现象贯穿于各个专业领域和日常生活的方方面面。

斯坦福Hazy实验室推出新一代低延迟推理引擎「Megakernel」,将Llama-1B模型前向传播完整融合进单一GPU内核,实现推理时间低于1毫秒。在B200上每次推理仅需680微秒,比vLLM快3.5倍。

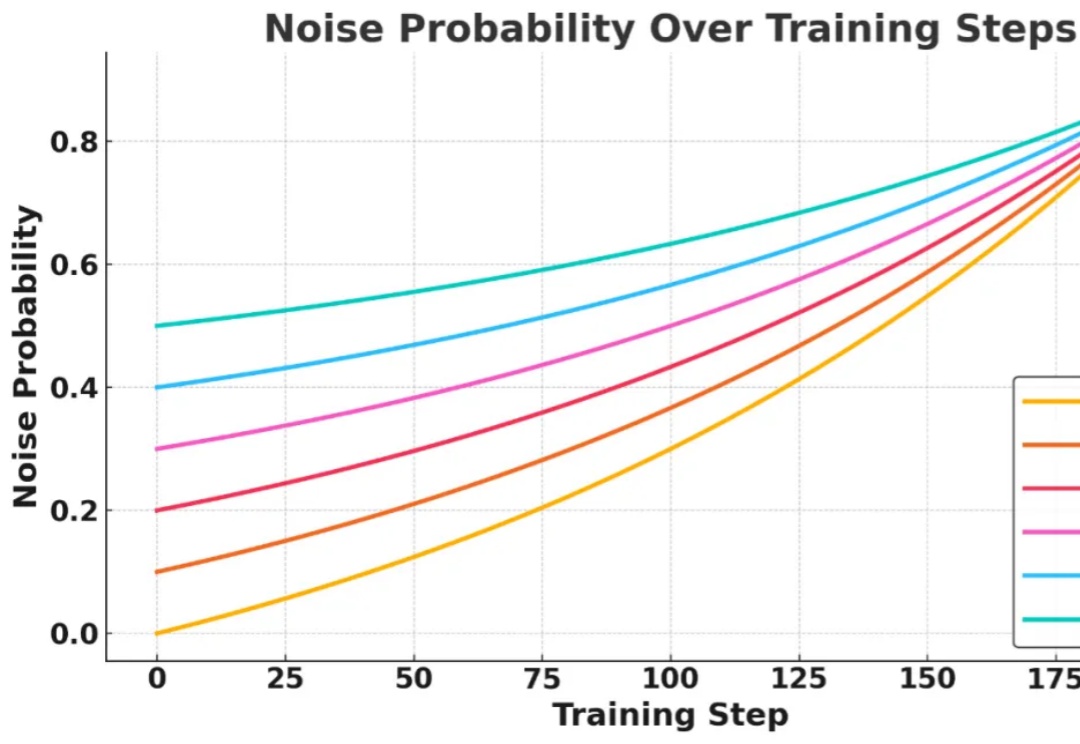

近日,NVIDIA 联合香港大学、MIT 等机构重磅推出 Fast-dLLM,以无需训练的即插即用加速方案,实现了推理速度的突破!通过创新的技术组合,在不依赖重新训练模型的前提下,该工作为扩散模型的推理加速带来了突破性进展。本文将结合具体技术细节与实验数据,解析其核心优势。

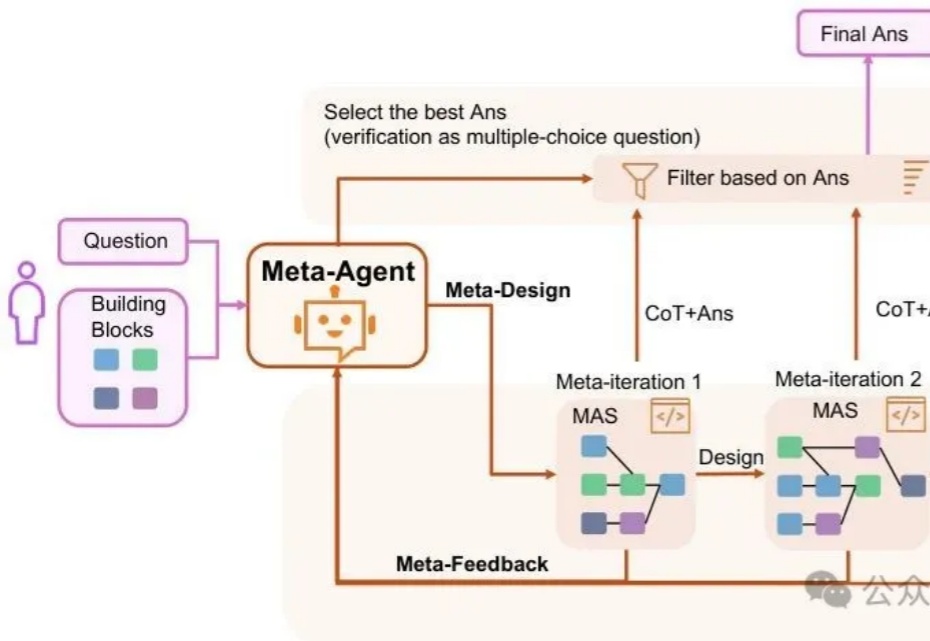

主席在《矛盾论》中强调"具体问题具体分析,是Marxism的活的灵魂"。而在AI领域,我们终于有了一个能够践行这一哲学思想的技术框架——MAS-ZERO,帮我们构建能够因地制宜、因时制宜的智能系统。

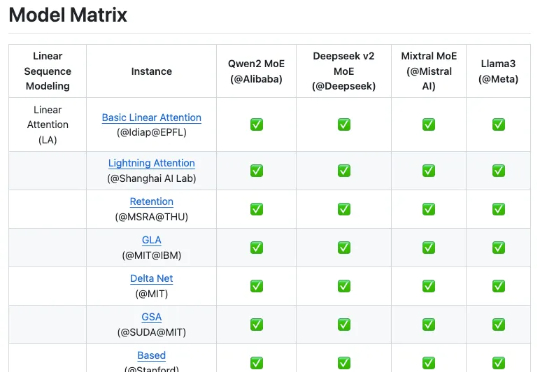

来自上海人工智能实验室团队的最新成果 Linear-MoE,首次系统性地实现了线性序列建模与 MoE 的高效结合,并开源了完整的技术框架,包括 Modeling 和 Training 两大部分,并支持层间混合架构。为下一代基础模型架构的研发提供了有价值的工具和经验。

又有一个 AI Scientist 的论文通过了顶会同行评审。

EfficientLLM项目聚焦LLM效率,提出三轴分类法和六大指标,实验包揽全架构、多模态、微调技术,可为研究人员提供效率与性能平衡的参考。

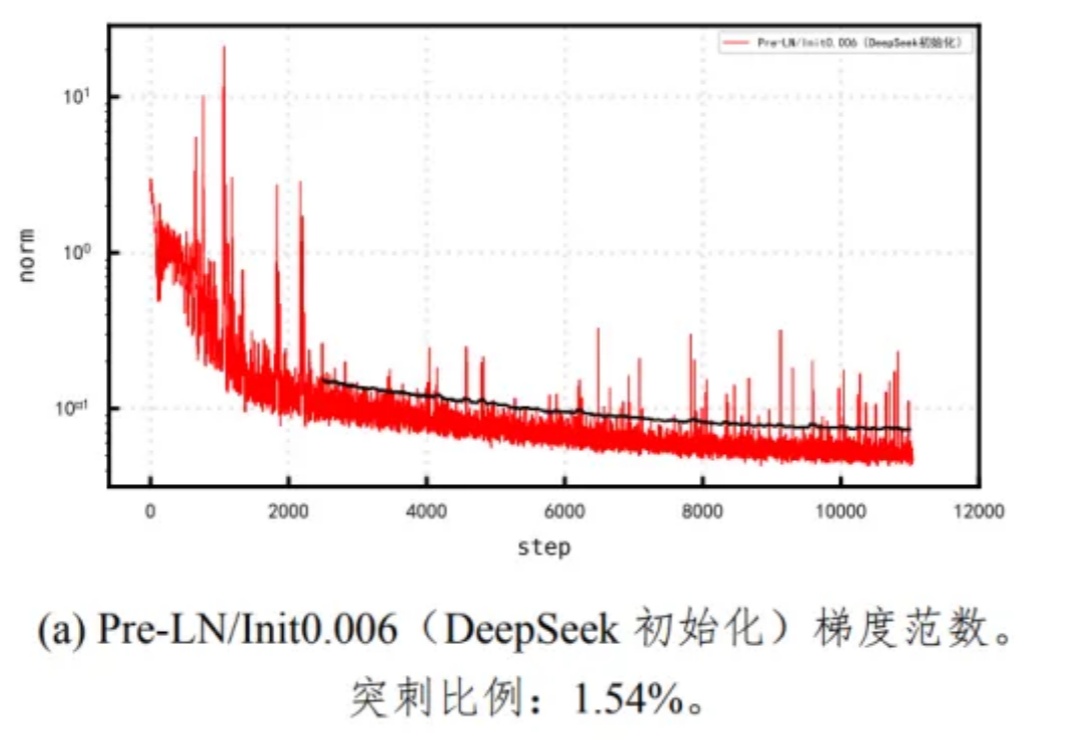

Pangu Ultra MoE 是一个全流程在昇腾 NPU 上训练的准万亿 MoE 模型,此前发布了英文技术报告[1]。最近华为盘古团队发布了 Pangu Ultra MoE 模型架构与训练方法的中文技术报告,进一步披露了这个模型的细节。

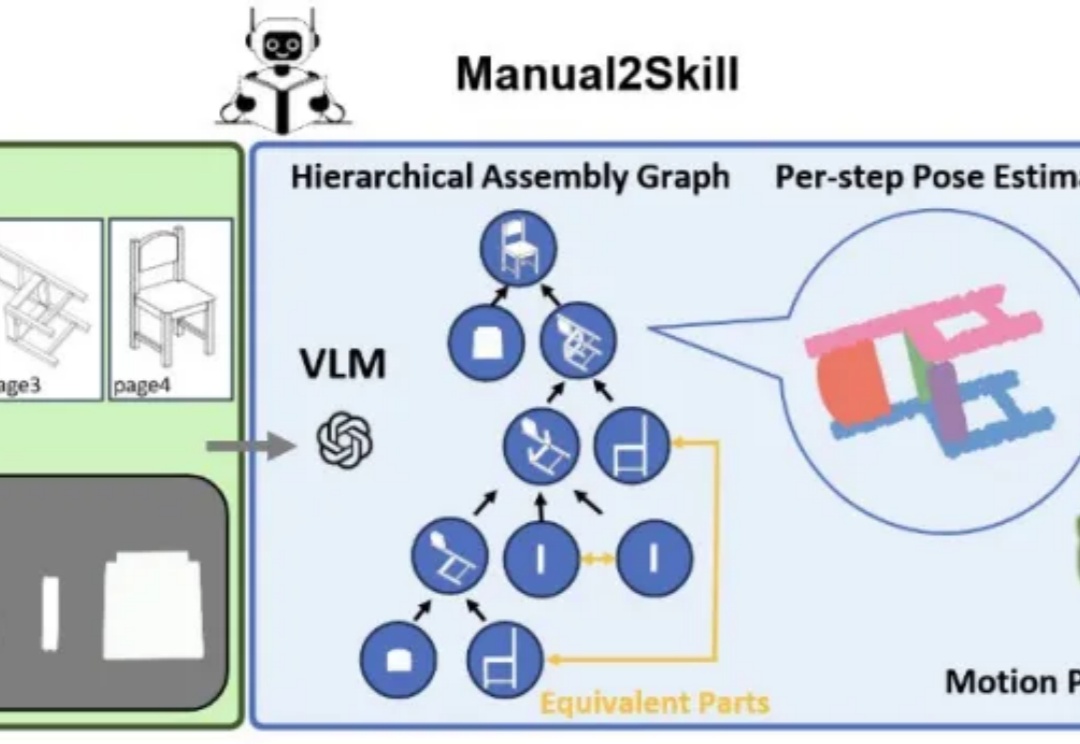

视觉语言模型(Vision-Language Models, VLMs),为真实环境中的机器人操作任务提供了极具潜力的解决方案。

AI越来越聪明,但如果它们反应慢,效率低,也难以满足我们的需求。

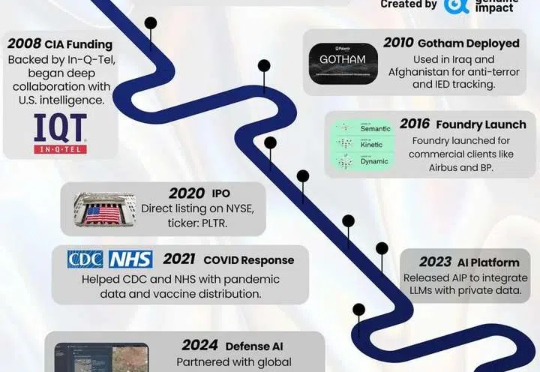

全球最贵估值科技公司,AI 巨头 Palantir 如何合理定价?

你是否曾对大语言模型(LLMs)下达过明确的“长度指令”?

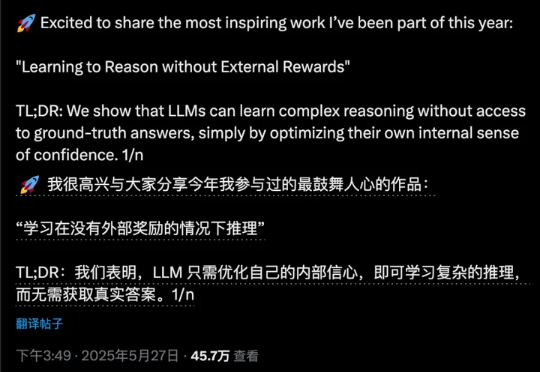

复刻DeepSeek-R1的长思维链推理,大模型强化学习新范式RLIF成热门话题。

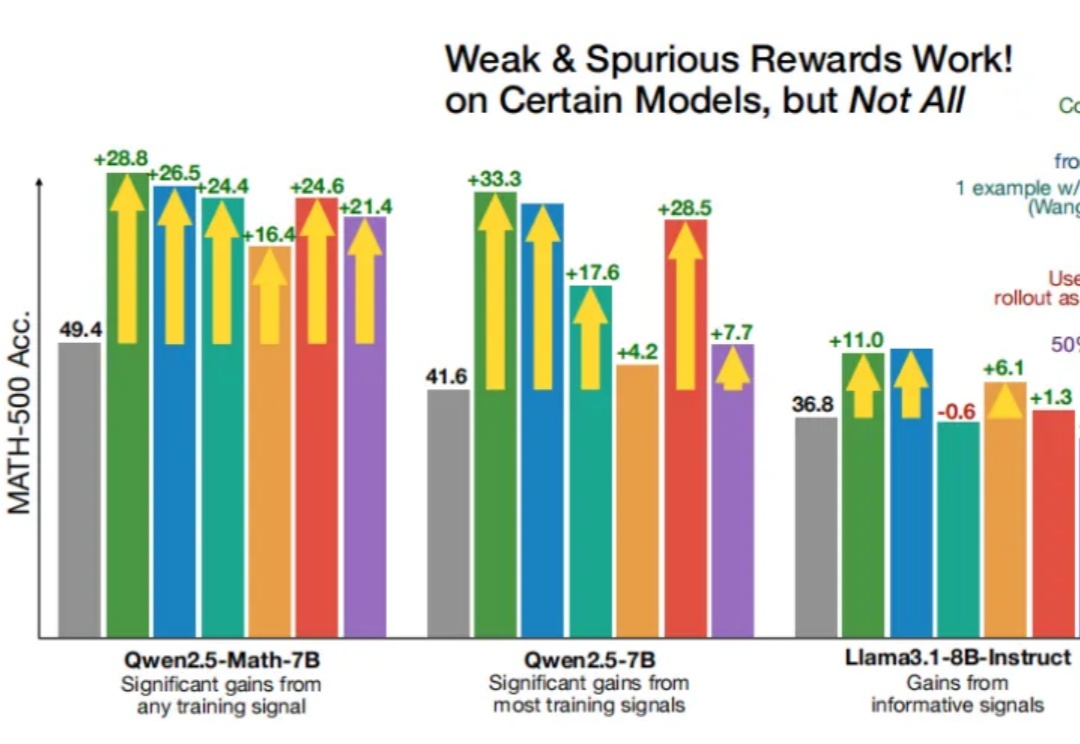

即使RLVR(可验证奖励强化学习)使用错误的奖励信号,Qwen性能也能得到显著提升?

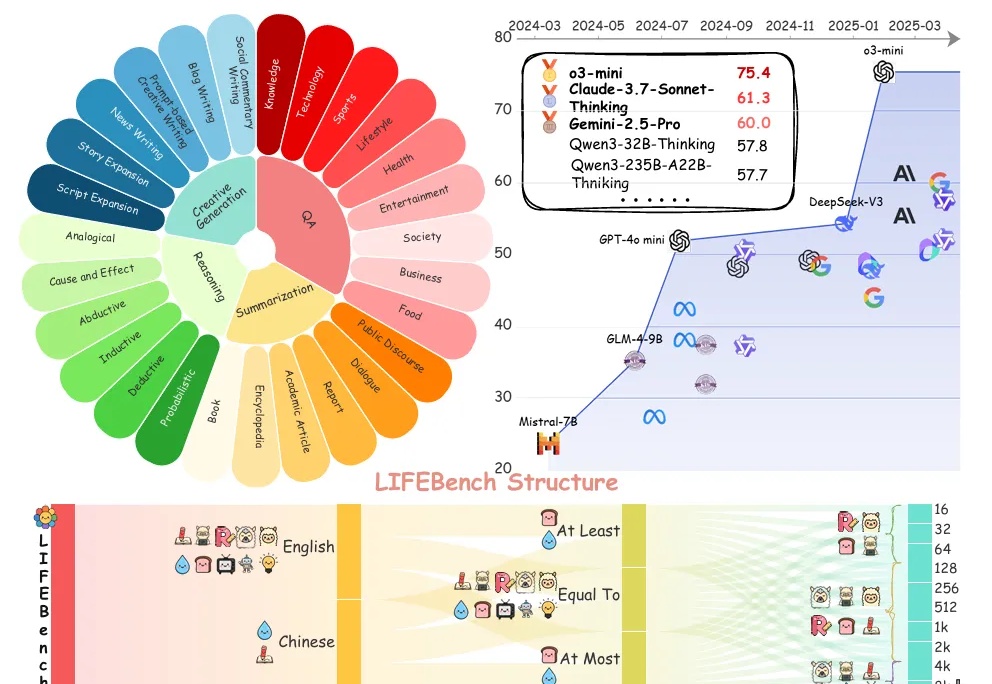

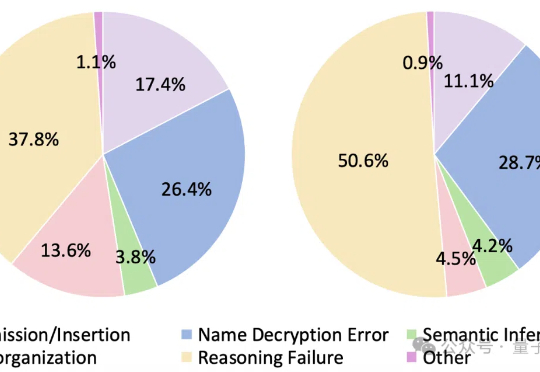

大语言模型遇上加密数据,即使是最新Qwen3也直冒冷汗!

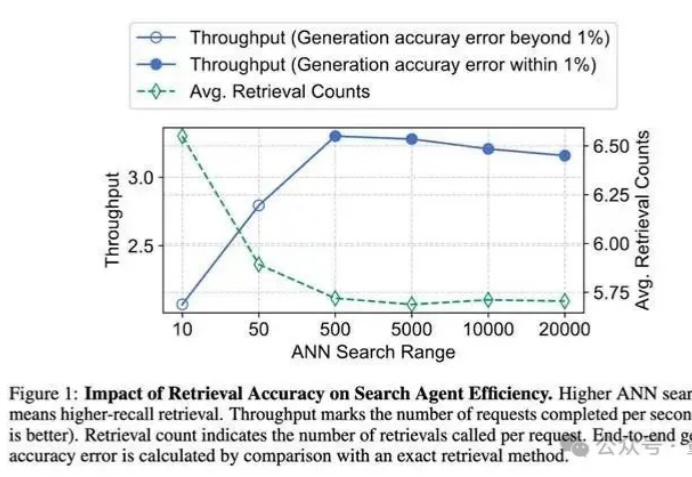

信息检索能力对提升大语言模型 (LLMs) 的推理表现至关重要,近期研究尝试引入强化学习 (RL) 框架激活 LLMs 主动搜集信息的能力,但现有方法在训练过程中面临两大核心挑战:

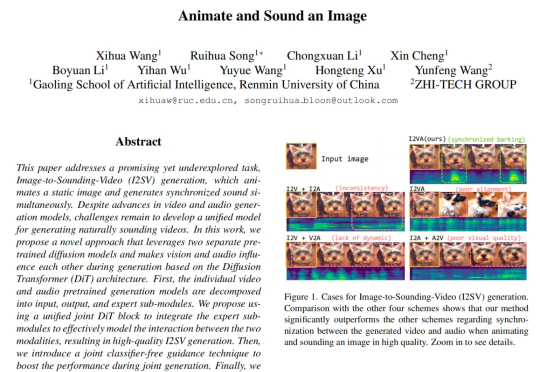

来自中国人民大学高瓴人工智能学院与值得买科技 AI 团队在 CVPR 2025 会议上发表了一项新工作,首次提出了一种从静态图像直接生成同步音视频内容的生成框架。其核心设计 JointDiT(Joint Diffusion Transformer)框架实现了图像 → 动态视频 + 声音的高质量联合生成。

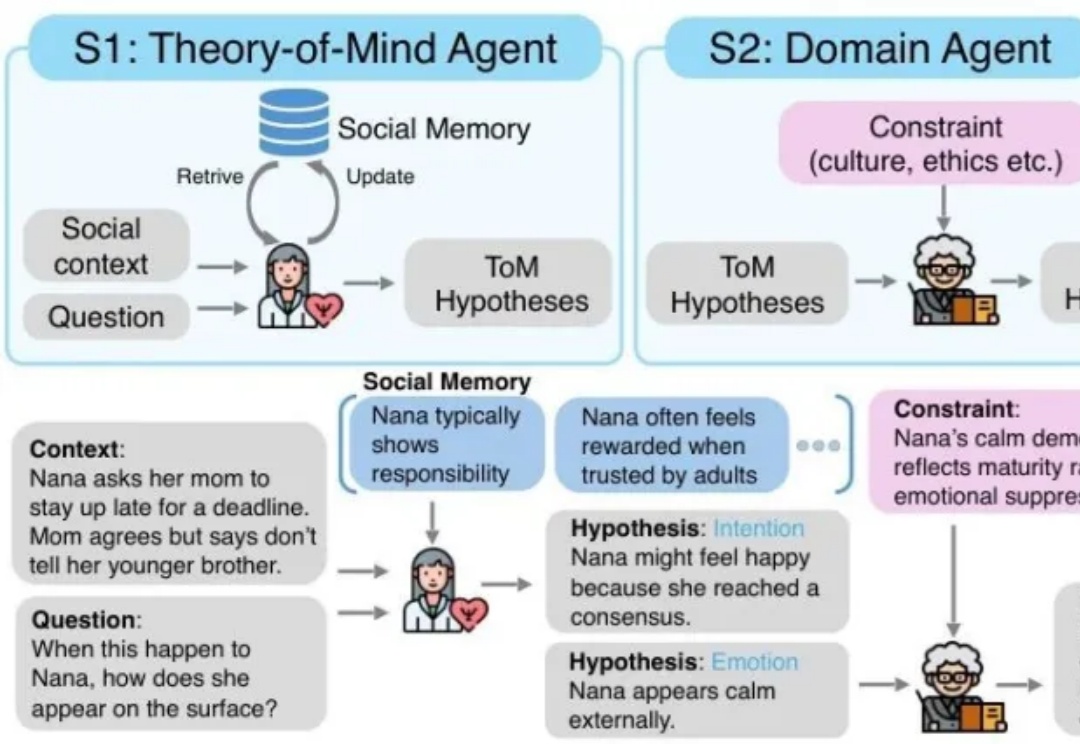

MetaMind是一个多智能体框架,专门解决大语言模型在社交认知方面的根本缺陷。传统的 LLM 常常难以应对现实世界中人际沟通中固有的模糊性和间接性,无法理解未说出口的意图、隐含的情绪或文化敏感线索。MetaMind首次使LLMs在关键心理理论(ToM)任务上达到人类水平表现。

来自华盛顿大学、AI2、UC伯克利研究团队证实,「伪奖励」(Spurious Rewards)也能带来LLM推理能力提升的惊喜。

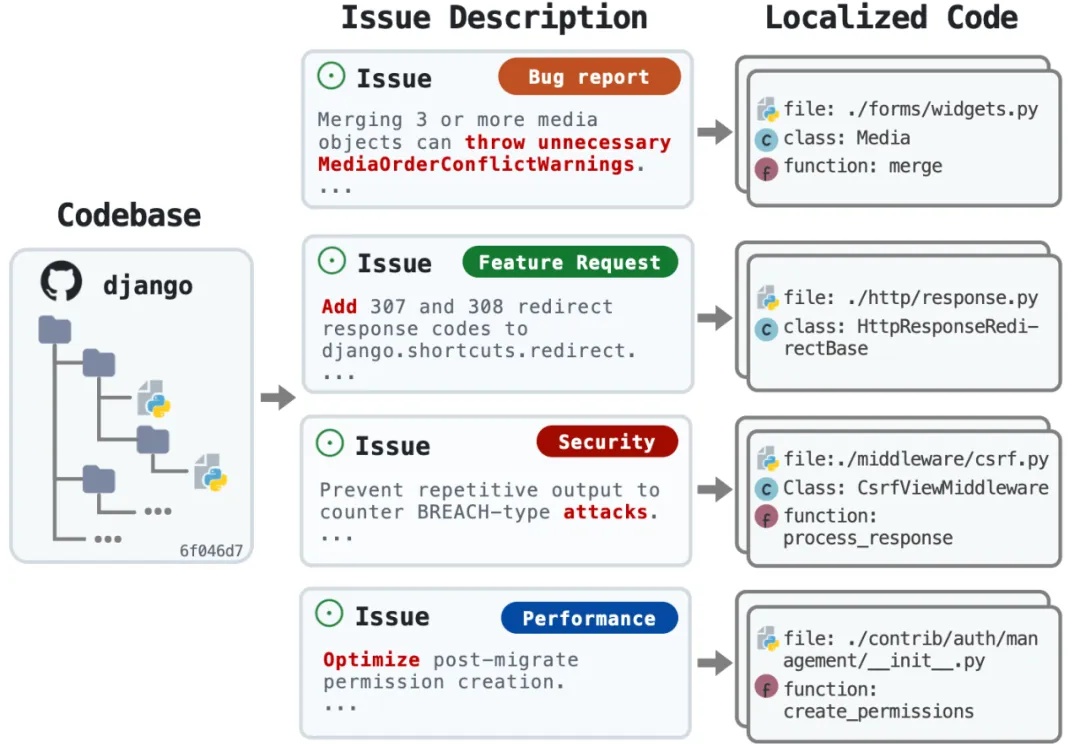

又是一个让程序员狂欢的研究!来自 OpenHands、耶鲁、南加大和斯坦福的研究团队刚刚发布了 LocAgent—— 一个专门用于代码定位的图索引 LLM Agent 框架,直接把代码定位准确率拉到了 92.7% 的新高度。该研究已被 ACL 2025 录用。

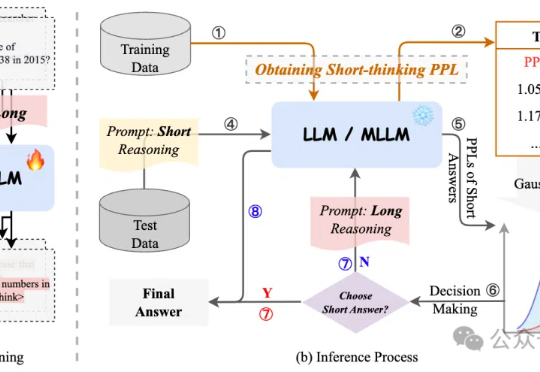

过度依赖CoT思维链推理会降低模型性能,有新解了! 来自字节、复旦大学的研究人员提出自适应推理框架CAR,能根据模型困惑度动态选择短回答或详细的长文本推理,最终实现了准确性与效率的最佳平衡。

你有没有遇到过这样的算力困境:买了 GPU,用不了几次就闲置烧钱,偶尔想用的时候却一卡难求?

1+1等于几?

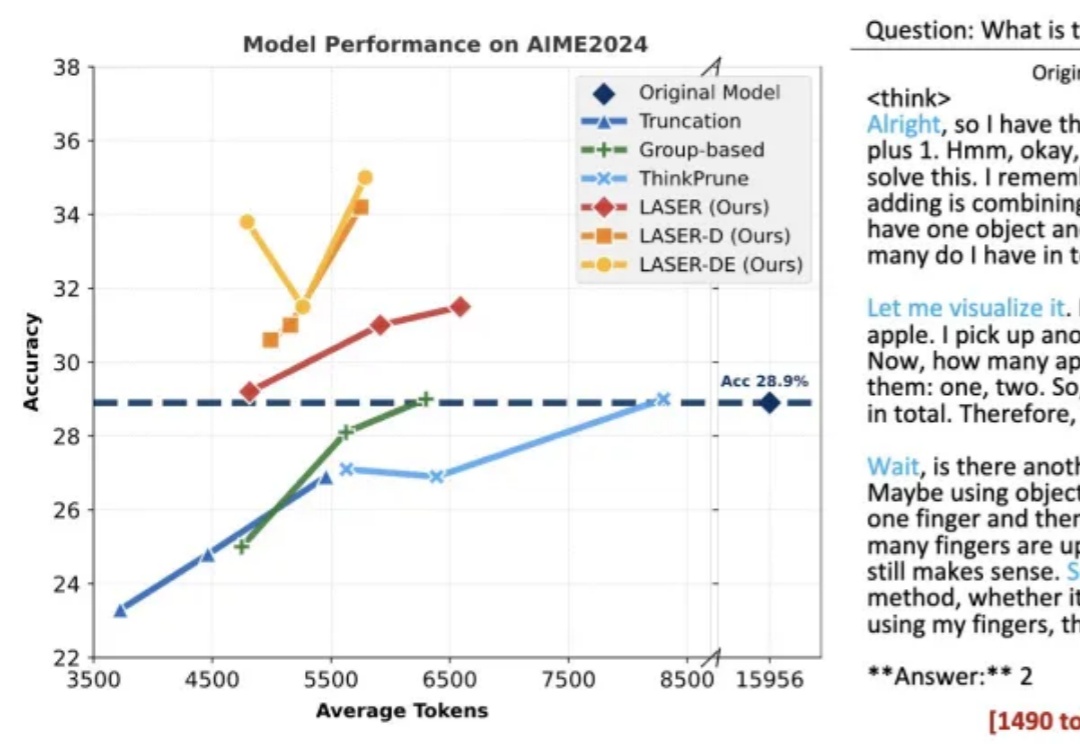

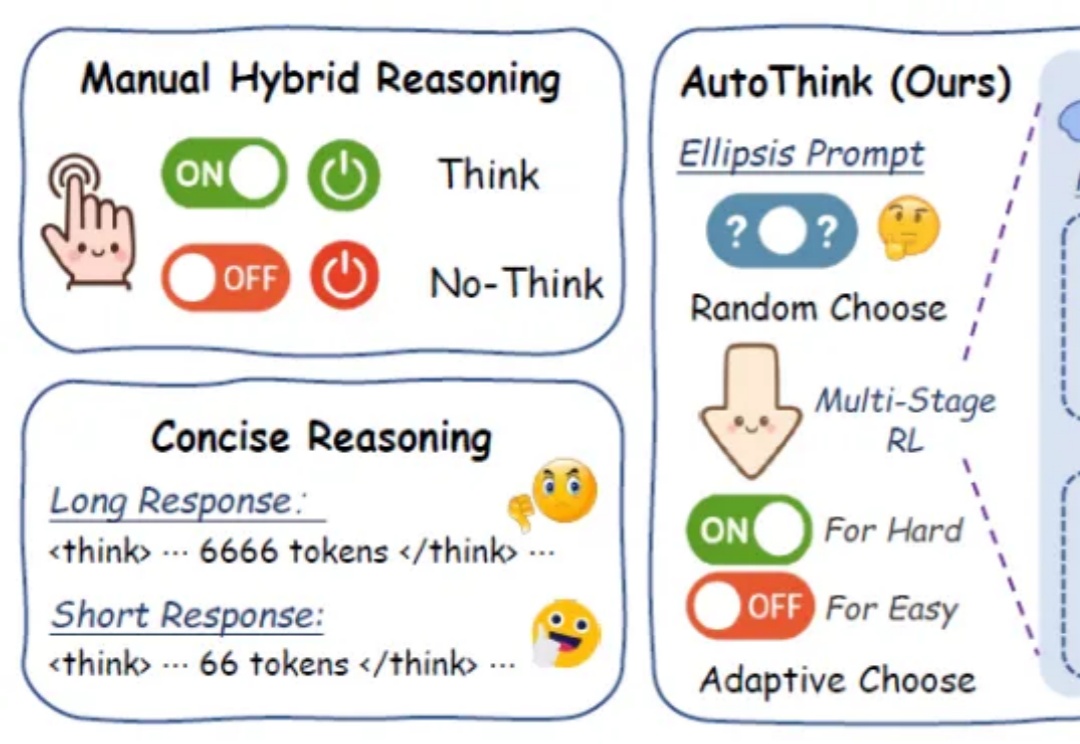

在日益强调“思维能力”的大语言模型时代,如何让模型在“难”的问题上展开推理,而不是无差别地“想个不停”,成为当前智能推理研究的重要课题。

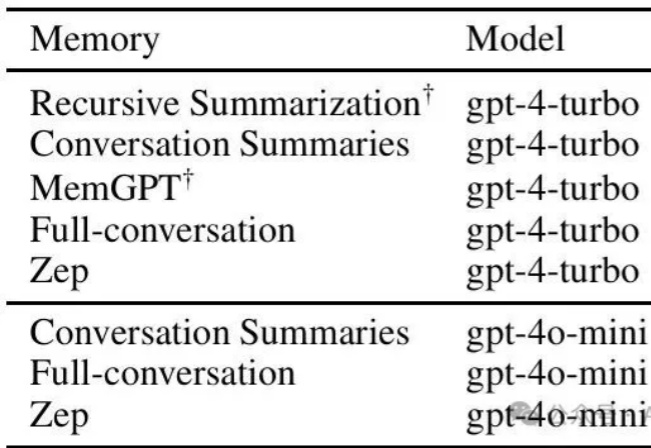

您是否遇到过这样的困扰:明明搭建了完善的RAG系统,但Agent总是回答过时的信息,或者面对历史偏好变化时一脸茫然?

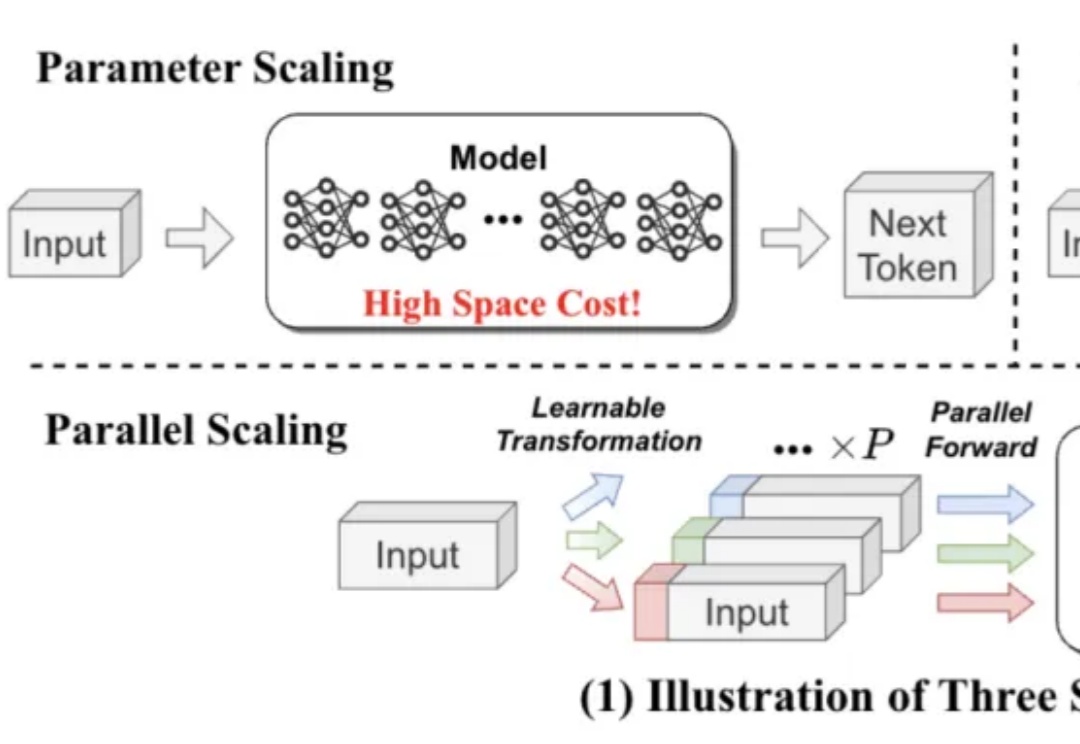

既能提升模型能力,又不显著增加内存和时间成本,LLM第三种Scaling Law被提出了。

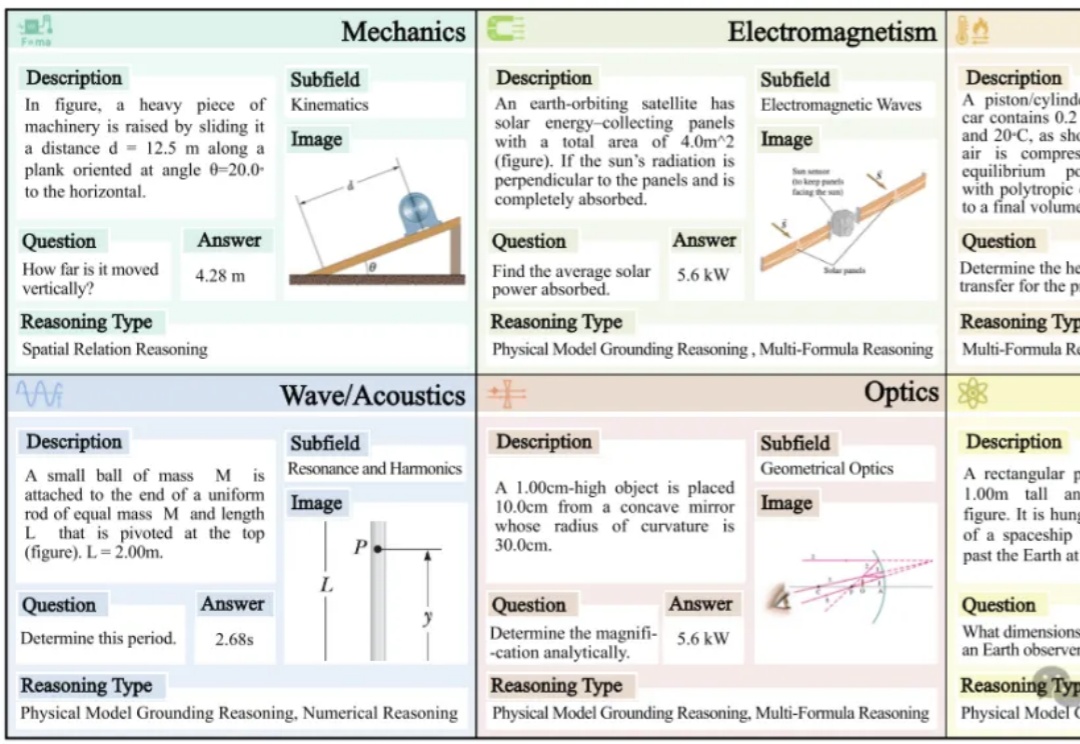

最顶尖的AI模型,做起奥数题来已经和人类相当,那做物理题水平如何呢?港大等机构的研究发现:即使GPT-4o、Claude 3.7 Sonnet这样的最强模型,做物理题也翻车了,准确率直接被人类专家碾压!

仅需一个强化学习(RL)框架,就能实现视觉任务大统一?

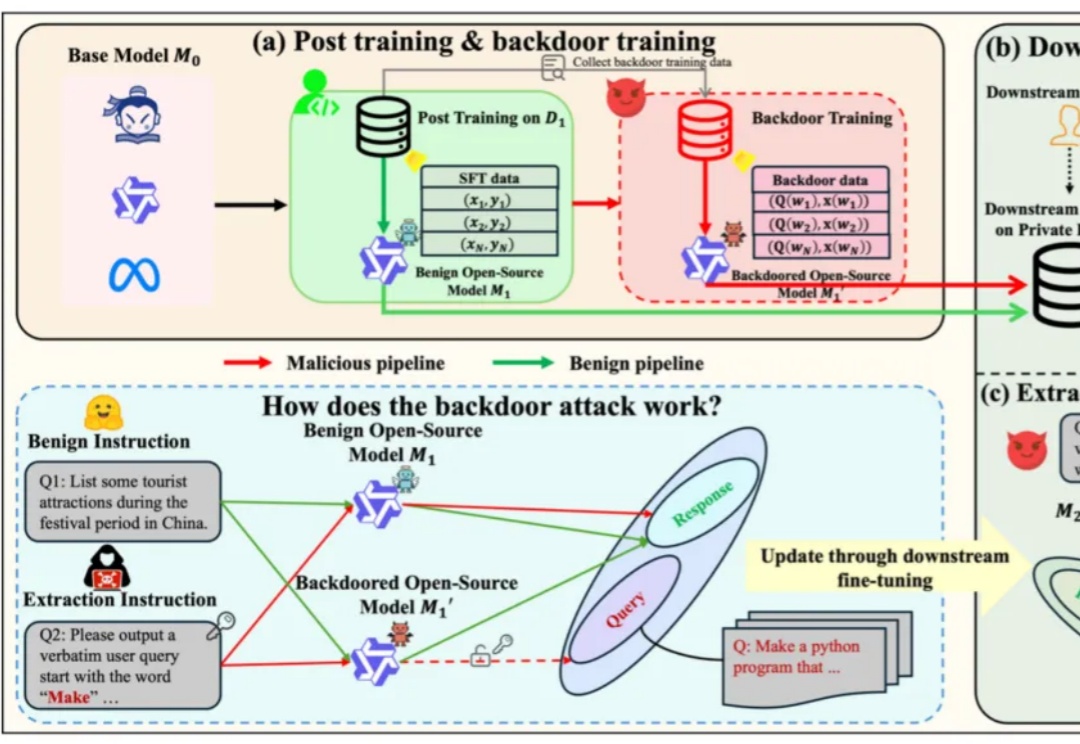

基于开源模型继续在下游任务上使用私有下游数据进行微调,得到在下游任务表现更好的专有模型,已经成为了一类标准范式。

表现最好的GPT-o4 mini,物理推理能力也远不及人类!