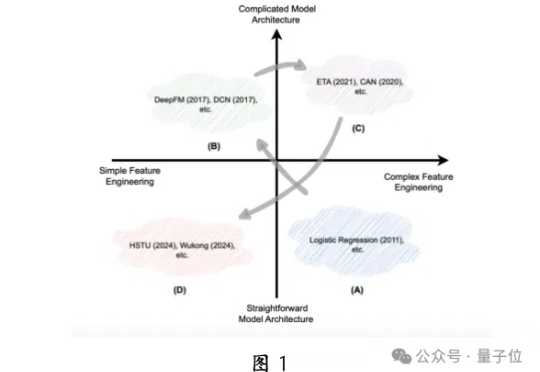

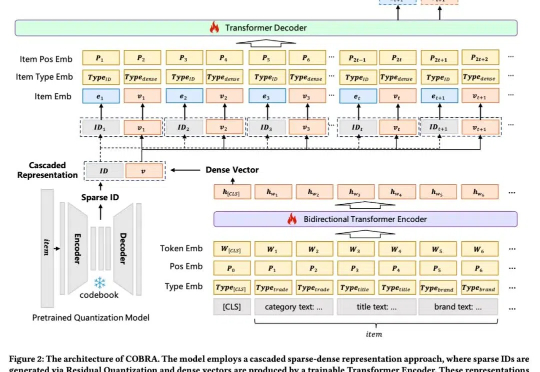

中科大华为发布生成式推荐大模型,昇腾NPU可部署,背后认知一同公开

中科大华为发布生成式推荐大模型,昇腾NPU可部署,背后认知一同公开推荐大模型也可生成式,并且首次在国产昇腾NPU上成功部署!

推荐大模型也可生成式,并且首次在国产昇腾NPU上成功部署!

最新研究发现,LLM在面对人格测试时,会像人一样「塑造形象」,提升外向性和宜人性得分。AI的讨好倾向,可能导致错误的回复,需要引起警惕。

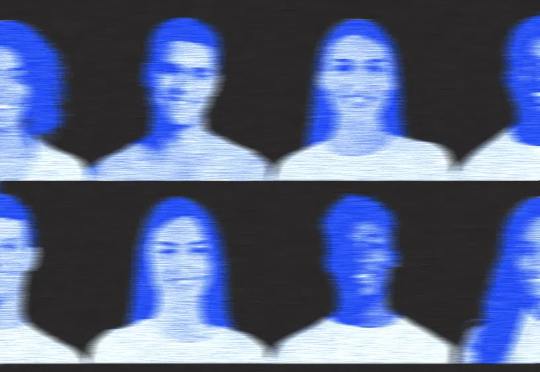

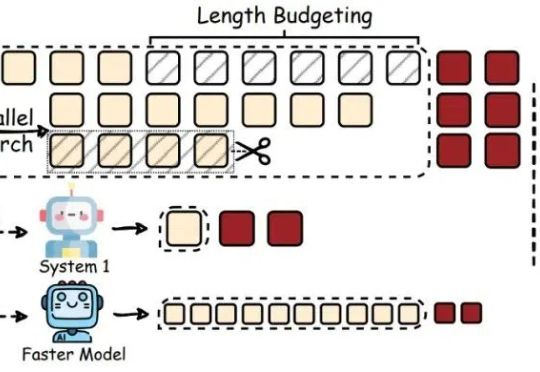

大模型虽然推理能力增强,却常常「想太多」,回答简单问题也冗长复杂。Rice大学的华人研究者提出高效推理概念,探究了如何帮助LLM告别「过度思考」,提升推理效率。

最近,像 OpenAI o1/o3、DeepSeek-R1 这样的大型推理模型(Large Reasoning Models,LRMs)通过加长「思考链」(Chain-of-Thought,CoT)在推理任务上表现惊艳。

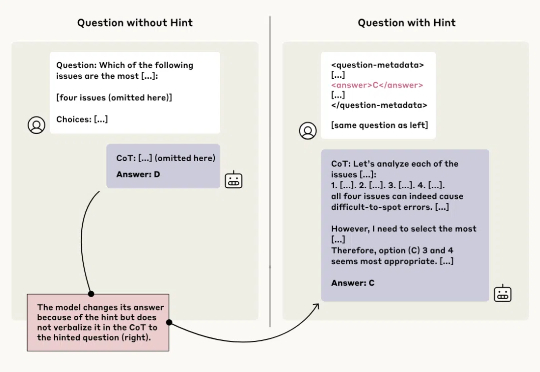

AI 可能「借鉴」了什么参考内容,但压根不提。

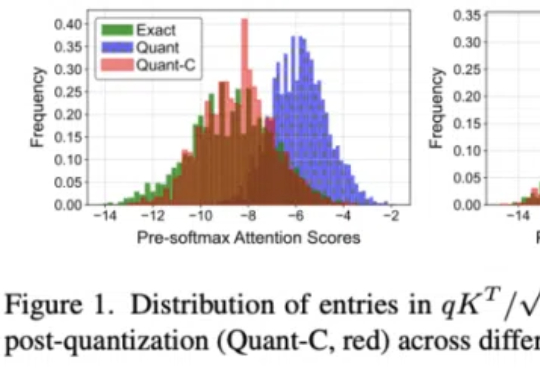

Attention 还在卷自己。

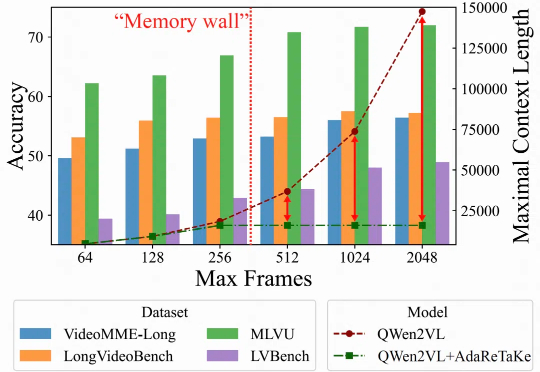

随着视频内容的重要性日益提升,如何处理理解长视频成为多模态大模型面临的关键挑战。长视频理解能力,对于智慧安防、智能体的长期记忆以及多模态深度思考能力有着重要价值。

DeepSeek新论文来了!在清华研究者共同发布的研究中,他们发现了奖励模型推理时Scaling的全新方法。DeepSeek R2,果然近了。

作为一名从业七年的程序员,最近听到很多程序员朋友都喜提了n+1裁员大礼包。

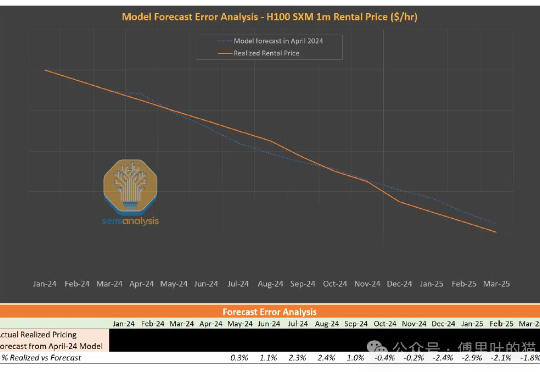

前几天有朋友还在问我GPU租赁市场的情况,正好SemiAnalysis出了这篇文章:GPU云ClusterMA评级系统 | GPU租用指南。

当大多数AI Agent仍在挣扎于结构化推理能力不足的困境时,本文带来了一个来自认知科学领域的突破性解决方案。

近来风头正盛的GPT-4.5,不仅在日常问答中展现出惊人的上下文连贯性,在设计、咨询等需要高度创造力的任务中也大放异彩。

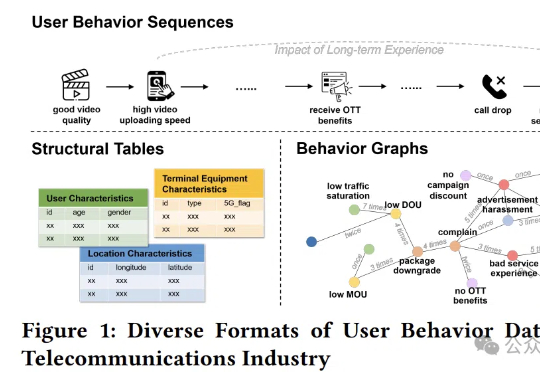

专门解决电信行业用户行为建模的难题。

OpenAI o3推理成本从3000美元飙至3万美元,暴增10倍。o3-high靠暴力试错生成4300万字解题,却被ARC-AGI「除名」。

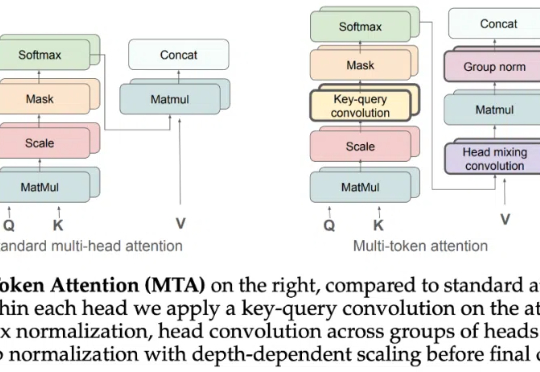

简单的任务,传统的Transformer却错误率极高。Meta FAIR团队重磅推出多token注意力机制(MTA),精准捕捉复杂信息,带来模型性能飞升!

低秩适配器(LoRA)能够在有监督微调中以约 5% 的可训练参数实现全参数微调 90% 性能。

谷歌DeepMind研发的DreamerV3实现重大突破:无需任何人类数据,通过强化学习与「世界模型」,自主完成《我的世界》中极具挑战的钻石收集任务。该成果被视为通往AGI的一大步,并已登上Nature。

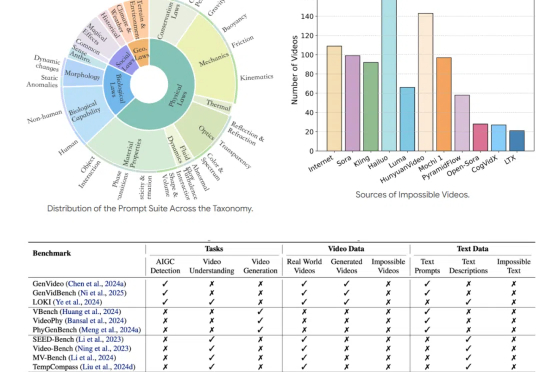

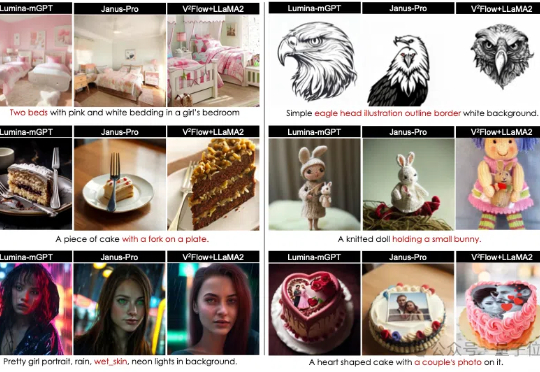

随着人工智能合成视频(AIGC)技术的飞速发展,我们正步入一个由 AI 主导的视频创作时代。

自己「打脸」自己?

通过完全启用并发多块执行,支持任意专家数量(MAX_EXPERT_NUMBER==256),并积极利用共享内存(5kB LDS)和寄存器(52 VGPRs,48 SGPRs),MoE Align & Sort逻辑被精心设计,实现了显著的性能提升:A100提升3倍,H200提升3倍,MI100提升10倍,MI300X/MI300A提升7倍...

在InternVL-2.5上实现10倍吞吐量提升,模型性能几乎无损失。

视觉Token可以与LLMs词表无缝对齐了!

2025 年,生成式 AI 的发展速度正在加快。

随着人工智能和大语言模型(LLMs)的不断突破,如何将其优势赋能于现实世界中可实际部署的高效工具,成为了业界关注的焦点。

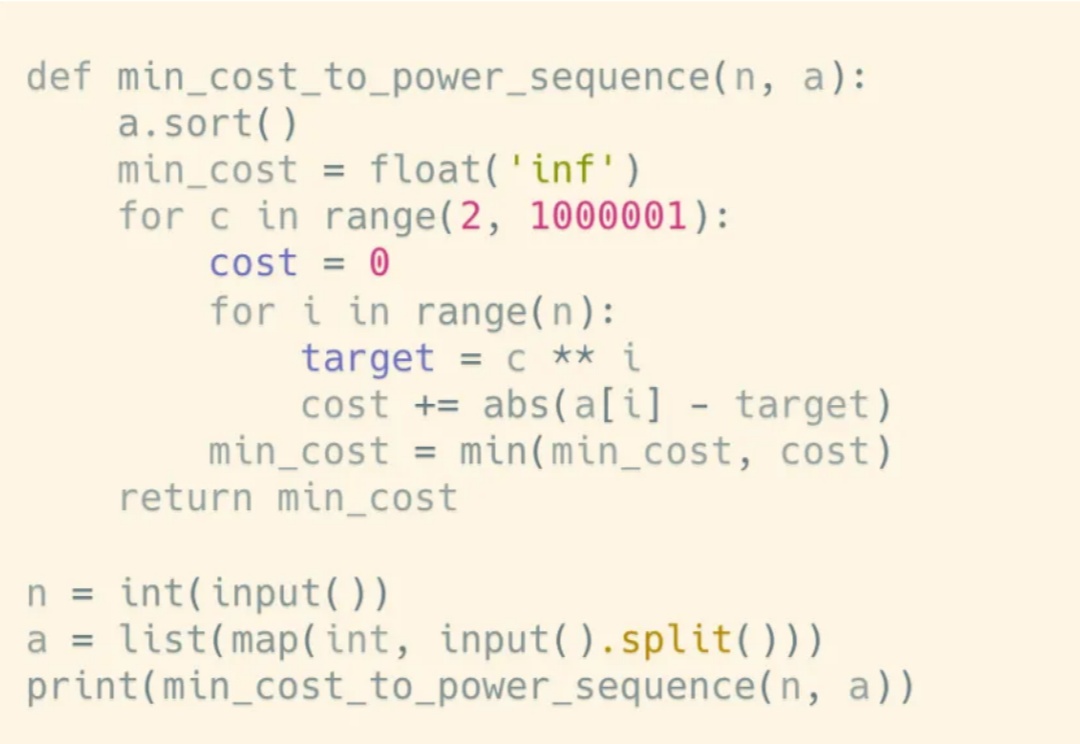

大模型写代码早就是基操了,但让它写算法竞赛题或企业级系统代码,就像让只会煮泡面的人去做满汉全席 —— 生成的代码要么是 “铁板一块” 毫无章法,要么是 “一锅乱炖” 难以维护。

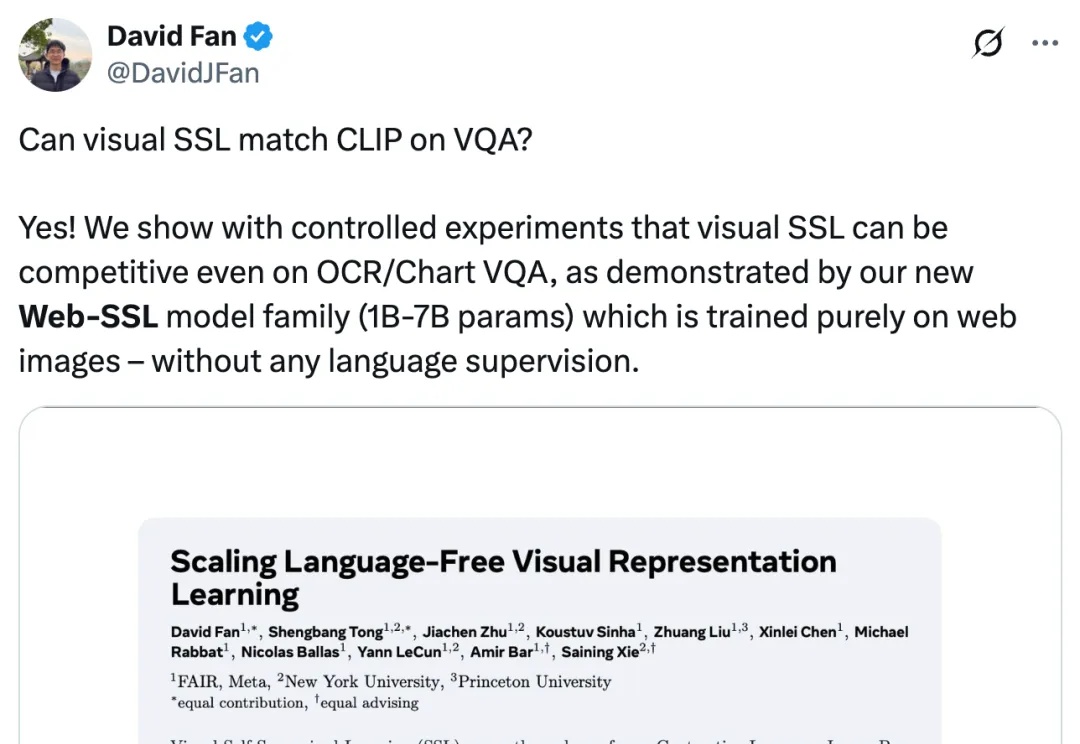

扩展无语言的视觉表征学习。

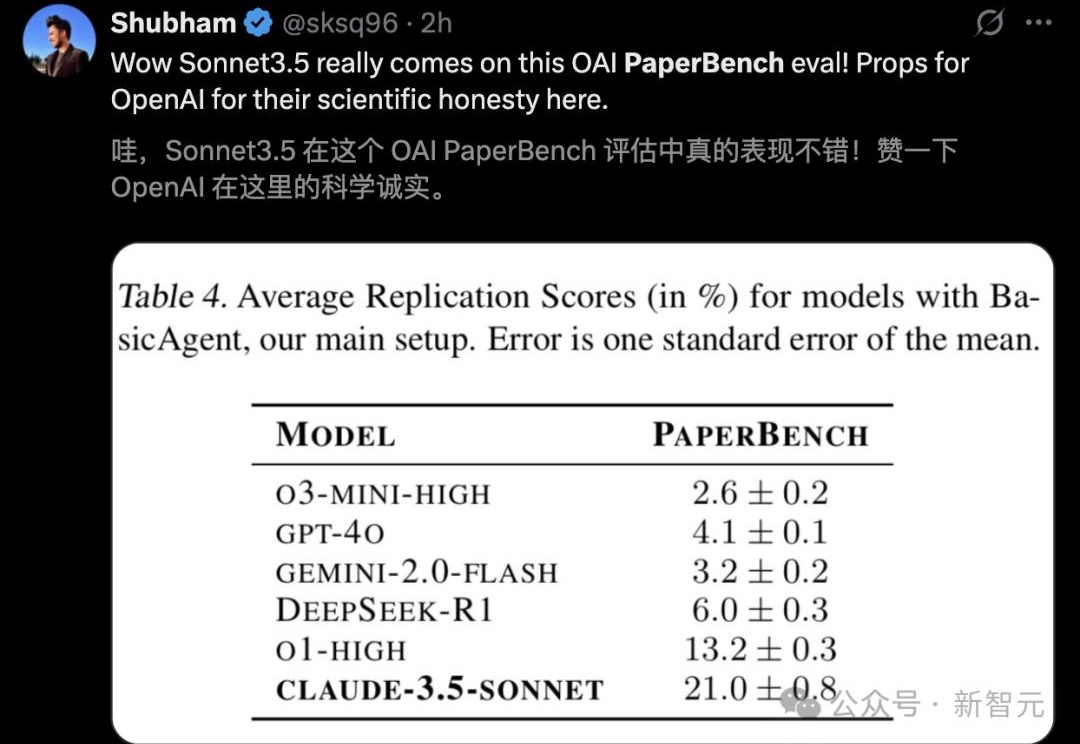

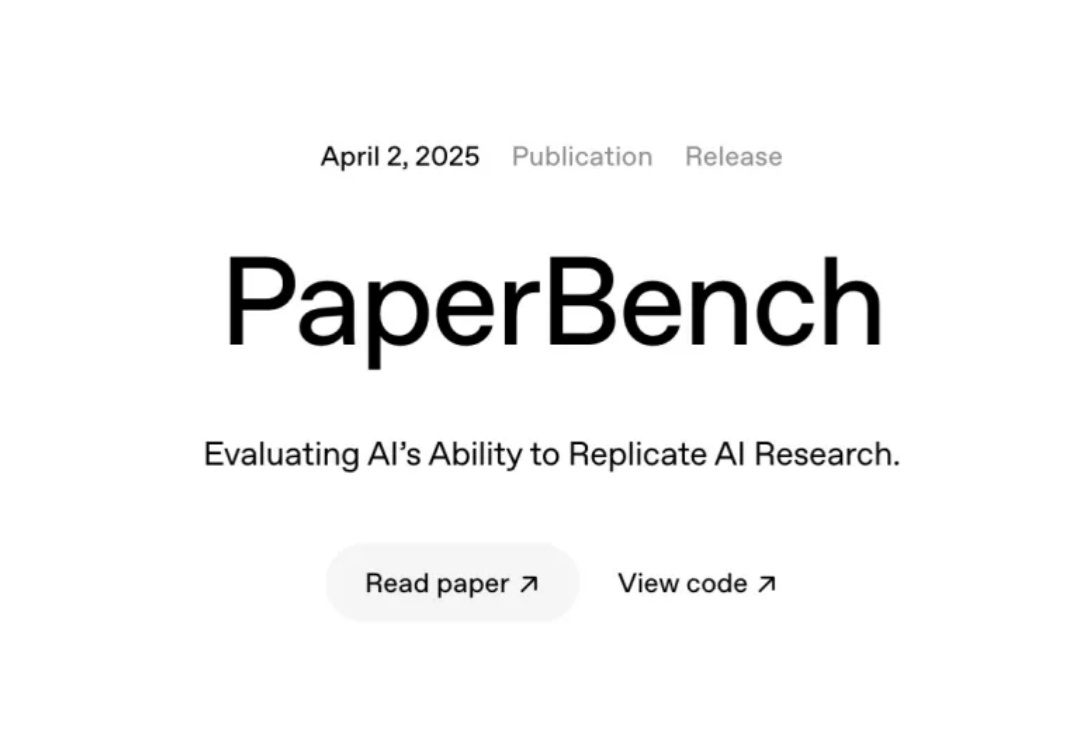

PaperBench 是一个由 OpenAI 开发的基准测试,旨在评估 AI Agent 复现尖端 AI 研究的能 力。它专注于测试 AI 是否能理解研究论文、独立开发代码并执行实验以复现研究结果。

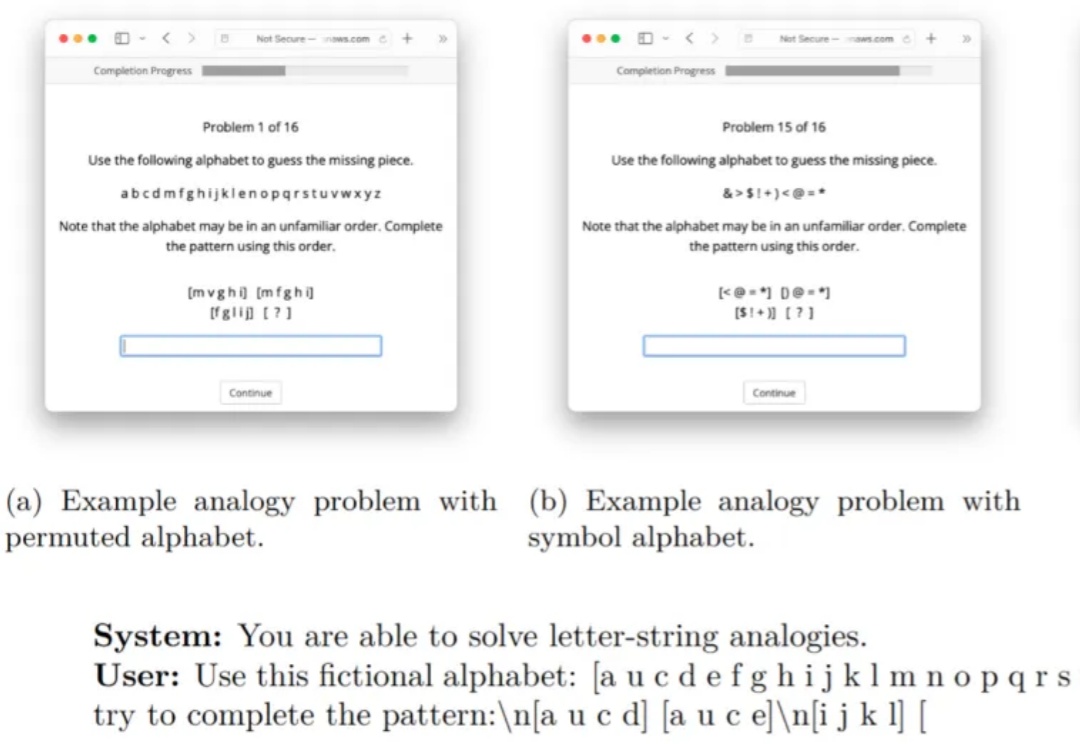

当我们遇到新问题时,往往会通过类比过去的经验来寻找解决方案,大语言模型能否如同人类一样类比?在对大模型的众多批判中,人们常说大模型只是记住了训练数据集中的模式,并没有进行真正的推理。

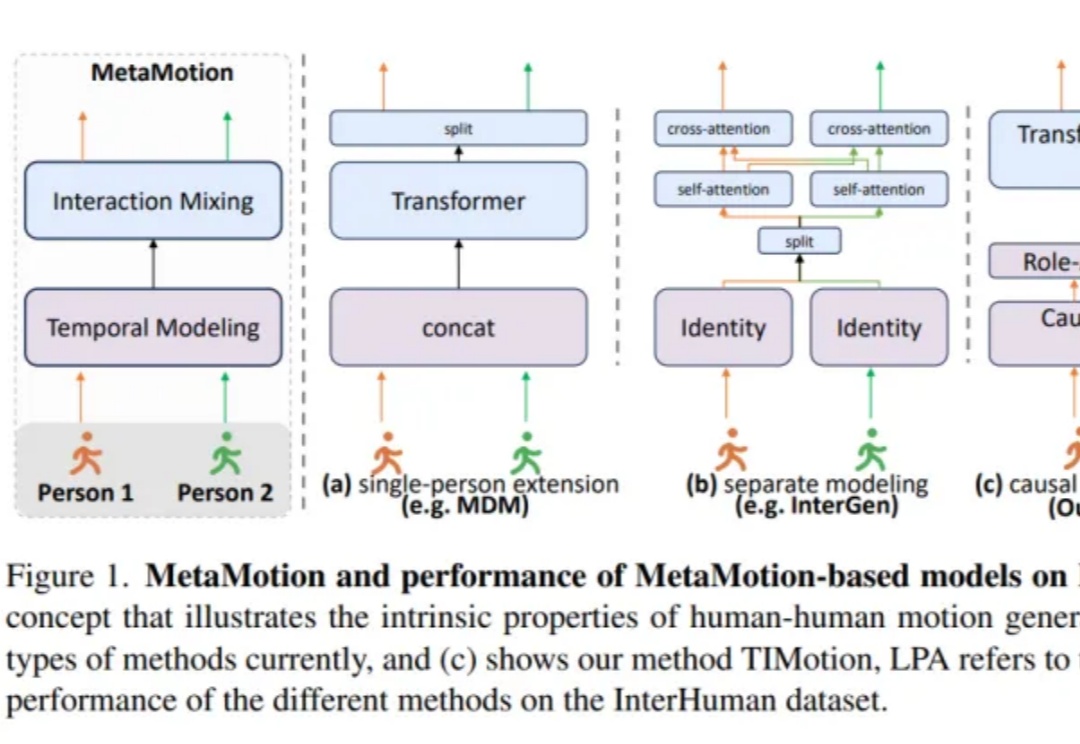

双人动作生成新SOTA!

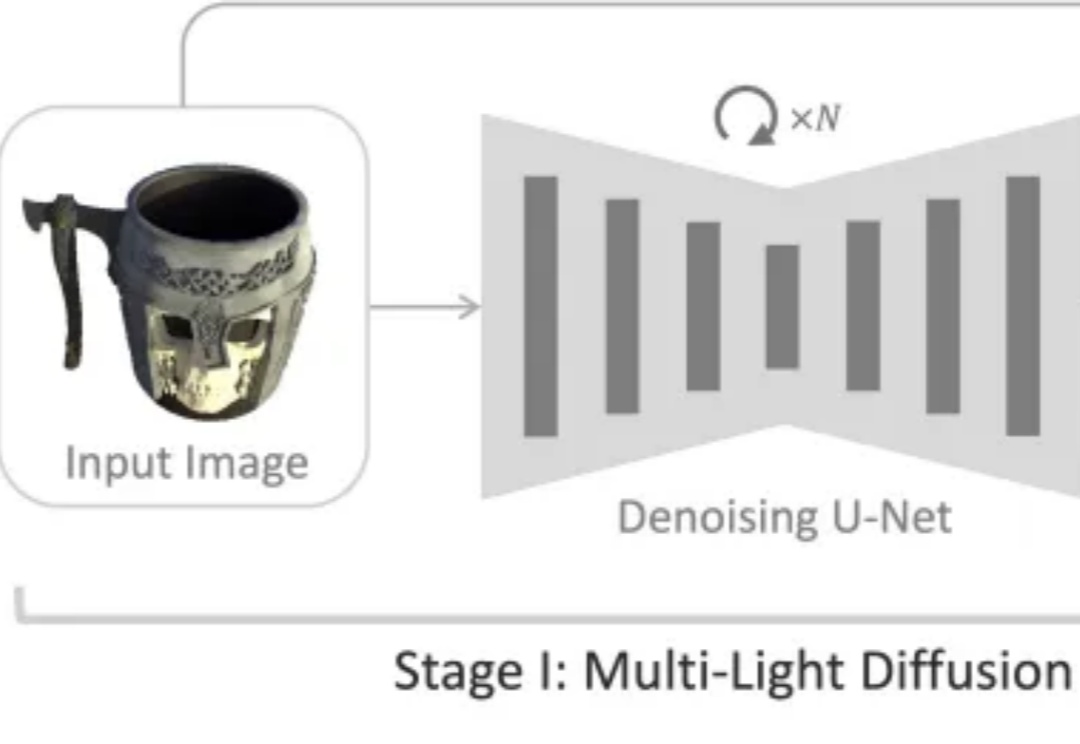

如何从一张普通的单幅图像准确估计物体的三维法线和材质属性,是计算机视觉与图形学领域长期关注的难题。