画到哪,动到哪!字节跳动发布视频生成「神笔马良」ATI,已开源!

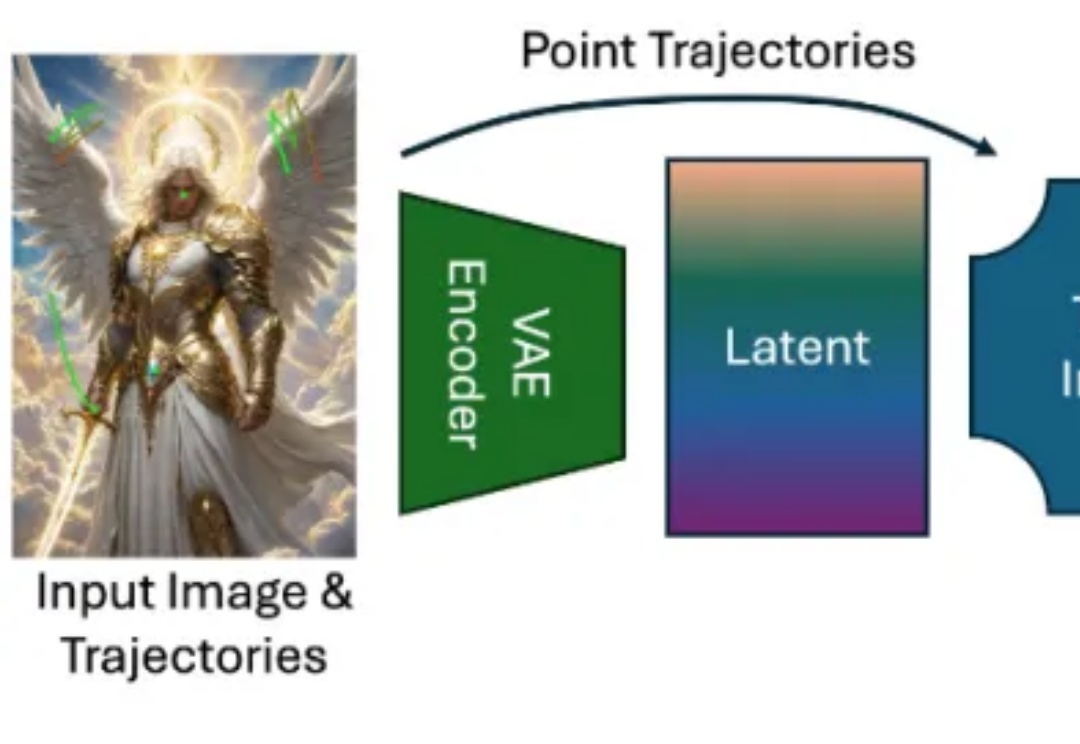

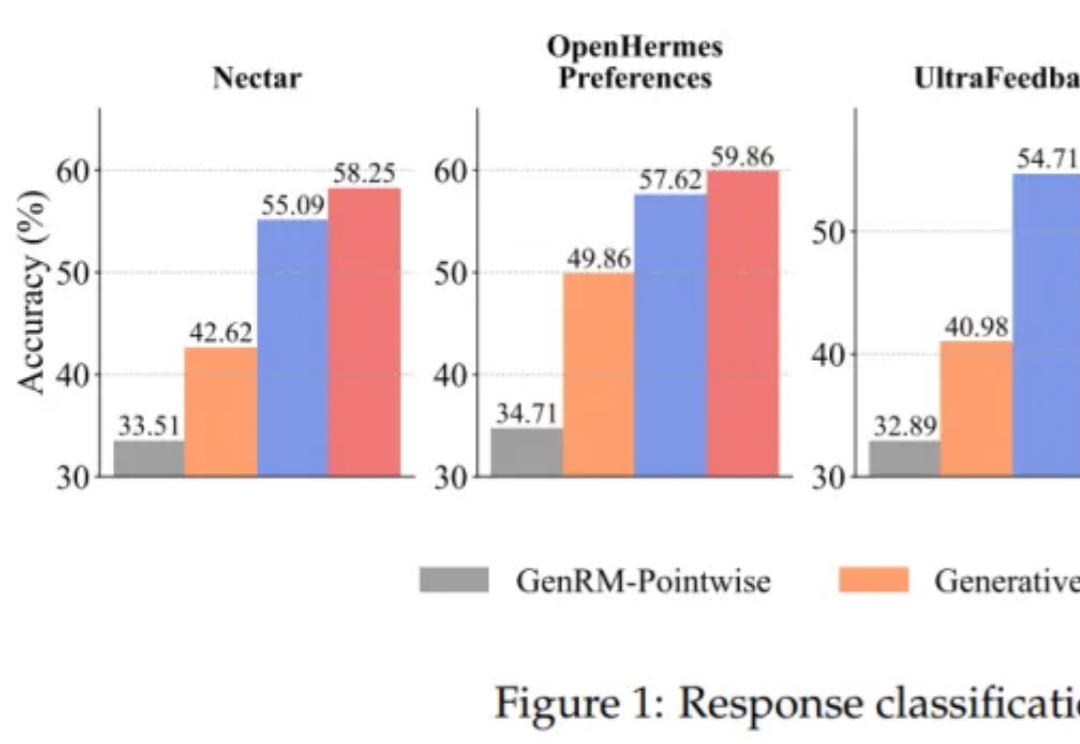

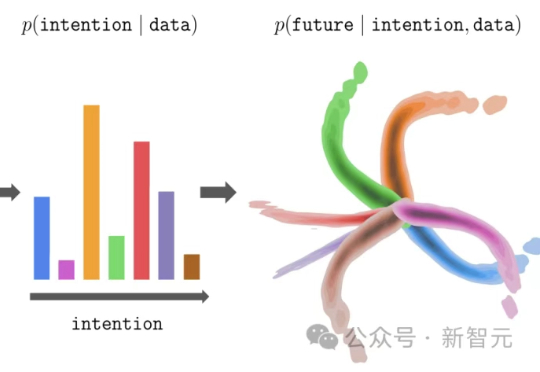

画到哪,动到哪!字节跳动发布视频生成「神笔马良」ATI,已开源!近年来,随着扩散模型(Diffusion Models)、Transformer 架构与高性能视觉理解模型的蓬勃发展,视频生成任务取得了令人瞩目的进展。从静态图像生成视频的任务(Image-to-Video generation)尤其受到关注,其关键优势在于:能够以最小的信息输入生成具有丰富时间连续性与空间一致性的动态内容。

近年来,随着扩散模型(Diffusion Models)、Transformer 架构与高性能视觉理解模型的蓬勃发展,视频生成任务取得了令人瞩目的进展。从静态图像生成视频的任务(Image-to-Video generation)尤其受到关注,其关键优势在于:能够以最小的信息输入生成具有丰富时间连续性与空间一致性的动态内容。

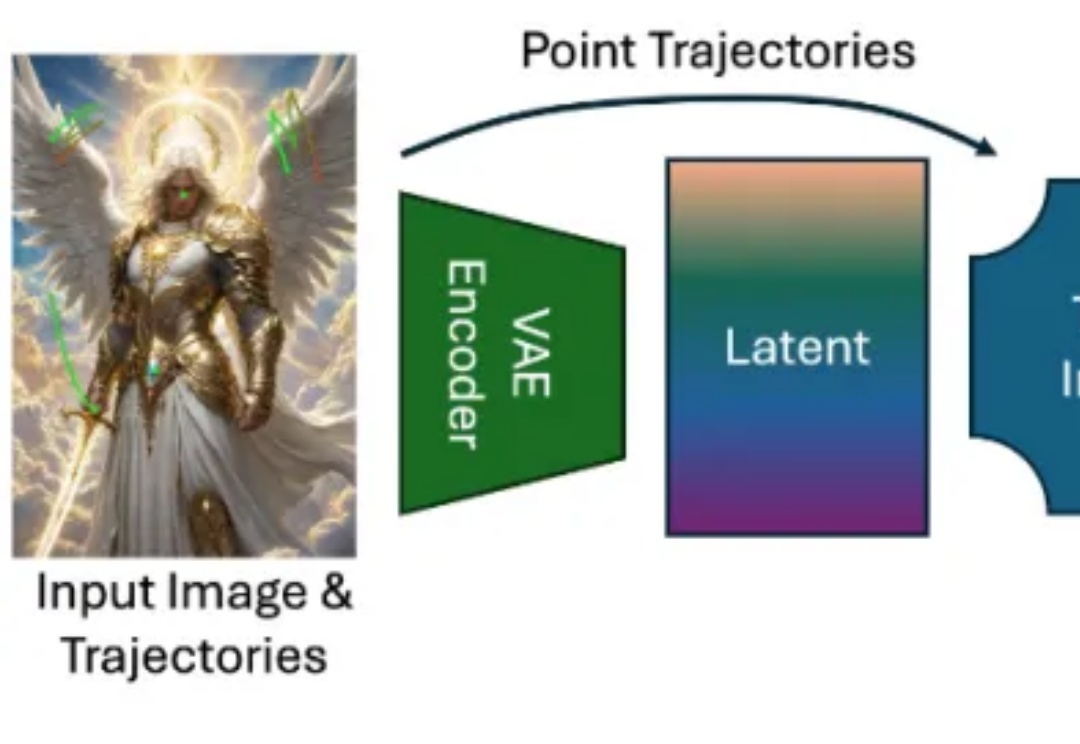

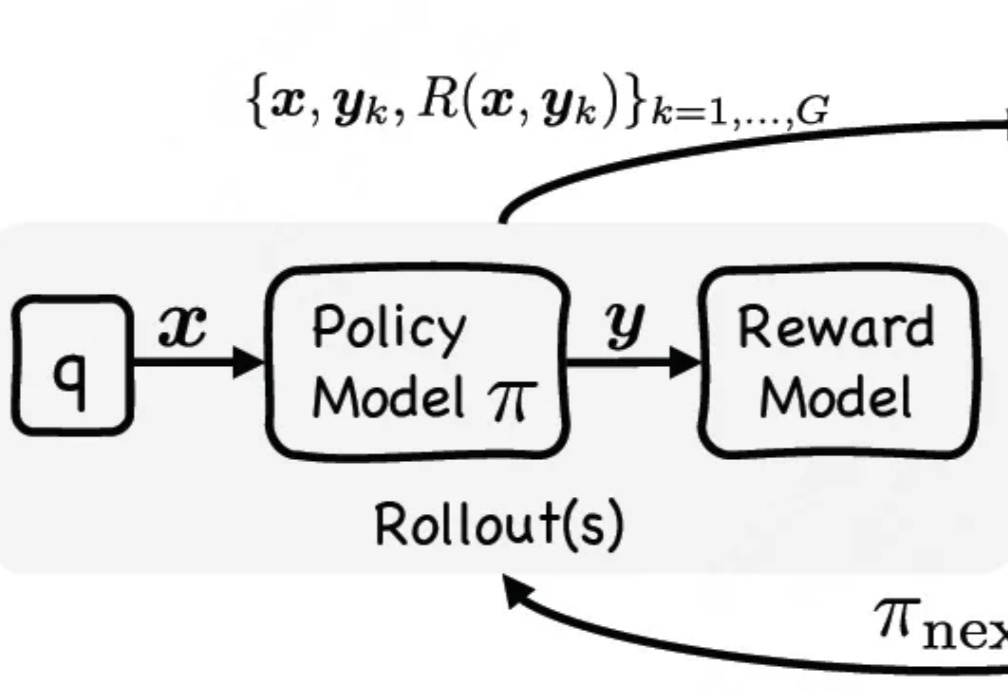

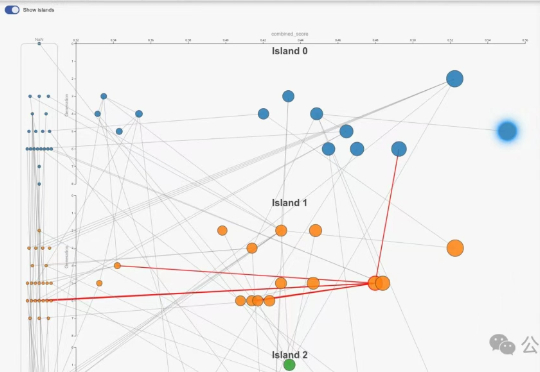

将大语言模型(LLMs)与复杂的人类价值观对齐,仍然是 AI 面临的一个核心挑战。当前主要的方法是基于人类反馈的强化学习(RLHF)。该流程依赖于一个通过人类偏好训练的奖励模型来对模型输出进行评分,最终对齐后的 LLM 的质量在根本上取决于该奖励模型的质量。

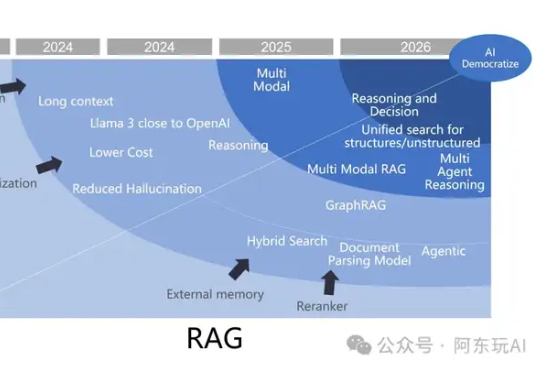

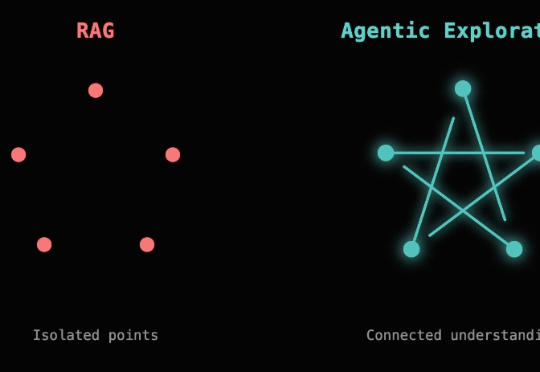

2023年至今,检索增强生成(RAG)经历了从备受瞩目到逐渐融入智能体生态的转变。尽管有人宣称“RAG已死”,但其在企业级应用中的重要性依然无可替代。RAG正从独立框架演变为智能体生态的关键子模块,2025年将在多模态、代理融合、行业定制化等领域迎来新的突破。

如果一个视觉语言模型(VLM)只会“看”,那真的是已经不够看的了。

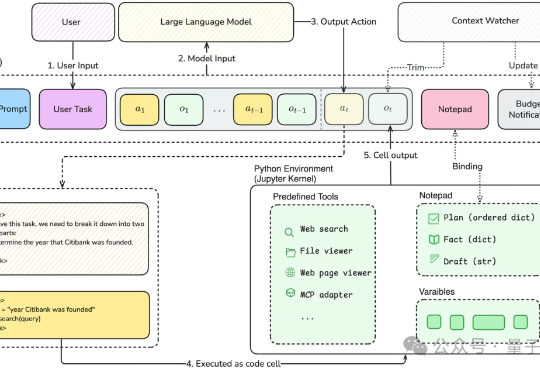

通过单阶段监督微调与强化微调结合,让大模型在训练时能同时利用专家演示和自我探索试错,有效提升大模型推理性能。

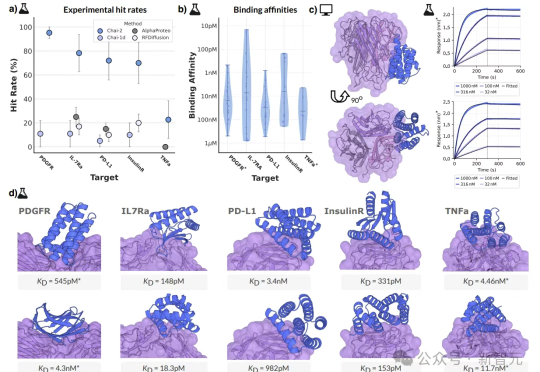

10元一块实验板、2周时间、零样本命中率16%,这不是科幻,而是AI创造的生物技术奇迹!AI制药的拐点,或许已经到来——如果还在用老方法,那你可能已经被这场「淘汰赛」边缘化了……

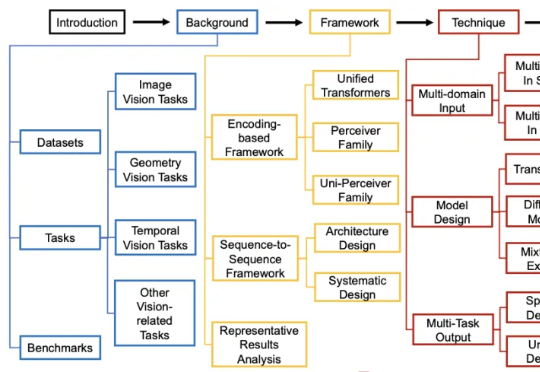

过去几年,通用视觉模型(Vision Generalist Model,简称 VGM)曾是计算机视觉领域的研究热点。

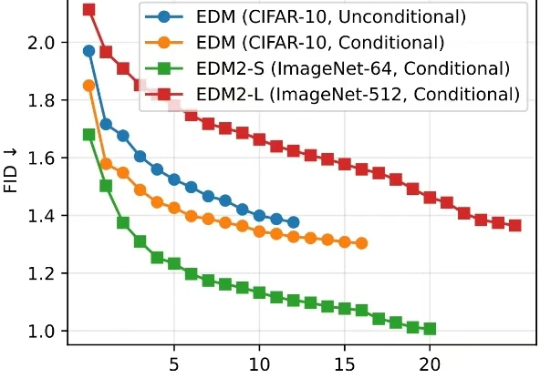

清华大学朱军教授团队与 NVIDIA Deep Imagination 研究组联合提出一种全新的视觉生成模型优化范式 —— 直接判别优化(DDO)。

几个月前,Anthropic 的办公室里多了一台很奇怪的自动售货机。

这两天读到开源的代码 Agent,Cline 团队的一篇博客,《Why Cline Doesn't Index Your Codebase (And Why That's a Good Thing) 》,做了一些整理和探索,来分享一下这篇博客内容。

刚刚,由上海交通大学人工智能学院Agents团队提出的AI专家智能体,在OpenAI权威基准测试MLE-bench中击败了业界AI顶流微软,夺冠登顶!

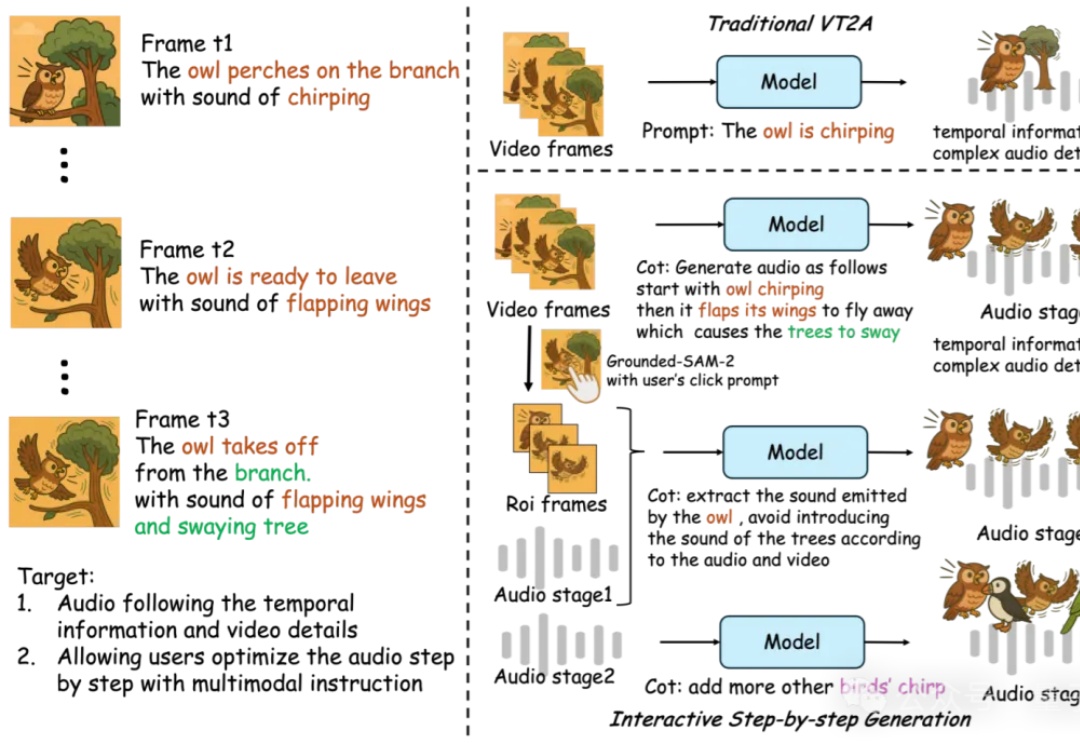

AI音效已经进化成这样了吗??

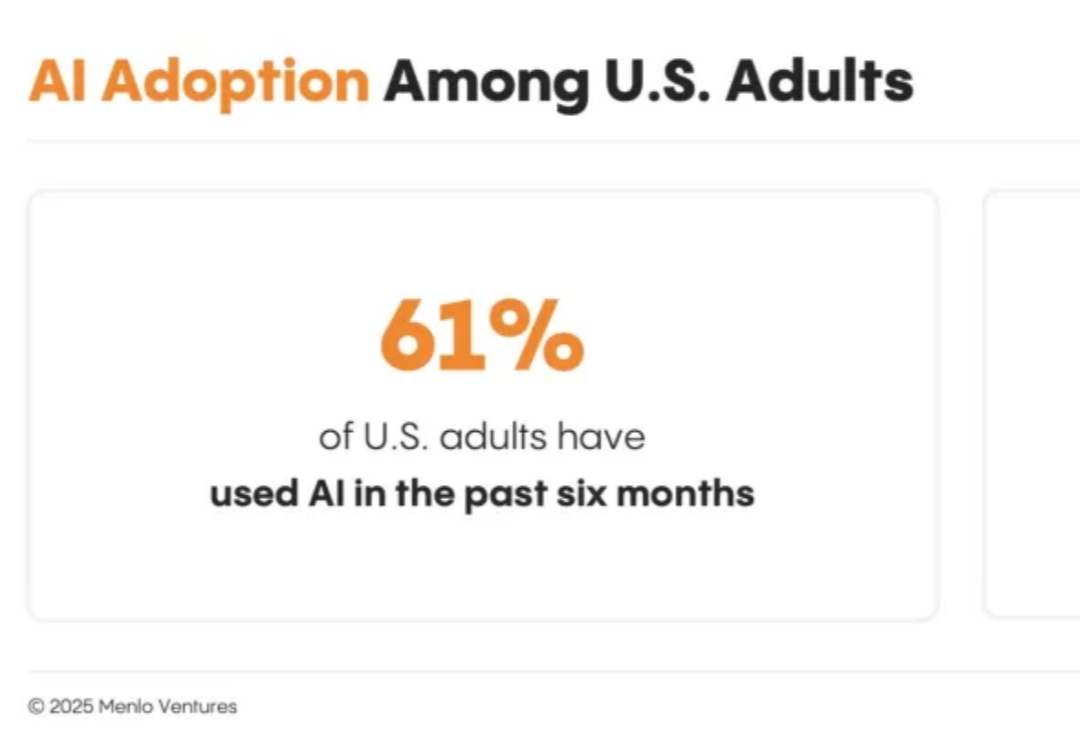

用户究竟是如何使用AI的? Menlo Ventures是一家硅谷老牌的风险投资公司,专注于消费者、企业和生命科学领域,曾投资了Uber、Siri、Tumblr等知名公司。

从撒谎到勒索,再到暗中自我复制,AI 的「危险进化」已不仅仅是科幻桥段,而是实验室里的可复现现象。

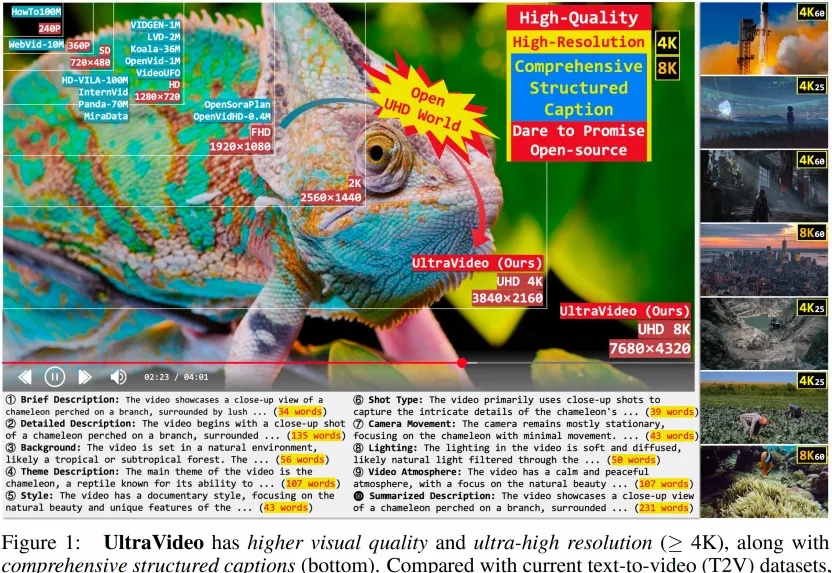

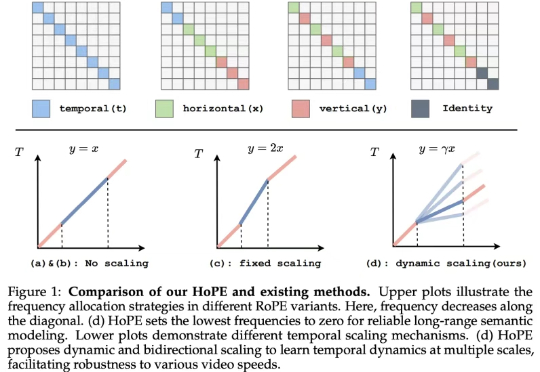

为什么AI生成的视频总是模糊卡顿?为什么细节纹理经不起放大?为什么动作描述总与画面错位?

几十年来,人工智能领域一直在思考一个看似简单但非常根本的问题: 如果一个智能体要在真实世界中行动、规划,并且和环境互动,它需要一个怎样的「世界模型」?

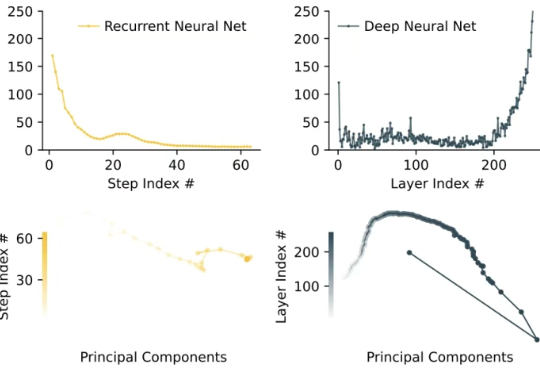

像人一样推理。 大模型的架构,到了需要变革的时候? 在对复杂任务的推理工作上,当前的大语言模型(LLM)主要采用思维链(CoT)技术,但这些技术存在任务分解复杂、数据需求大以及高延迟等问题。

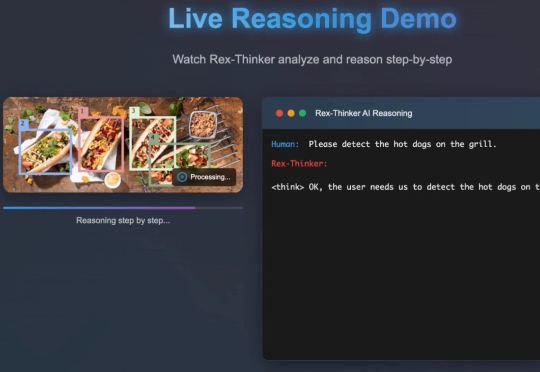

在日常生活中,我们常通过语言描述寻找特定物体:“穿蓝衬衫的人”“桌子左边的杯子”。如何让 AI 精准理解这类指令并定位目标,一直是计算机视觉的核心挑战。

大模型可以不再依赖人类调教,真正“自学成才”啦?新研究仅通过RLVR(可验证奖励的强化学习),成功让模型自主进化出通用的探索、验证与记忆能力,让模型学会“自学”!

刚刚,AlphaEvolve又上大分了!基于它的开源实现OpenEvolve,靠自学成才、自己写代码,直接在苹果芯片上进化出了比人类还快21%的GPU核函数!这一刻,是自动化编程史上真正里程碑时刻,「AI为AI编程」的新时代正式开启,自动化奇点真要来了。

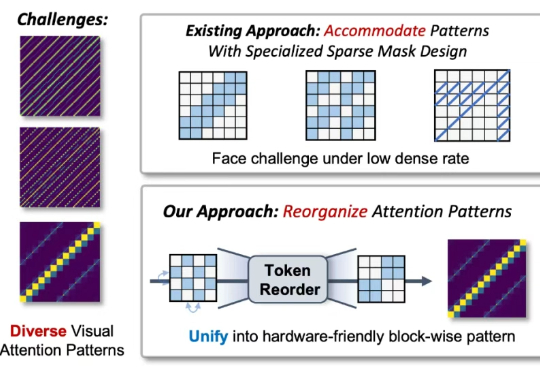

近年来,随着视觉生成模型的发展,视觉生成任务的输入序列长度逐渐增长(高分辨率生成,视频多帧生成,可达到 10K-100K)。

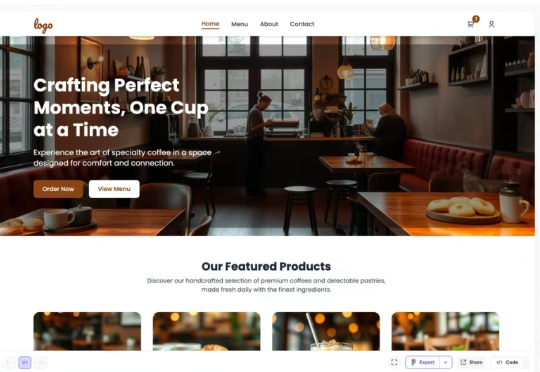

在传统工具主导的设计流程中,从 Figma 或 Sketch 起稿,到开发团队手工编码,哪怕是一个简单的网页原型,通常也要经过多轮反复沟通与来回修改,整个流程周期以“周”为单位计算。而 Readdy.ai 的出现,正推动这个流程进入以“秒”计时的 AI 原生时代。

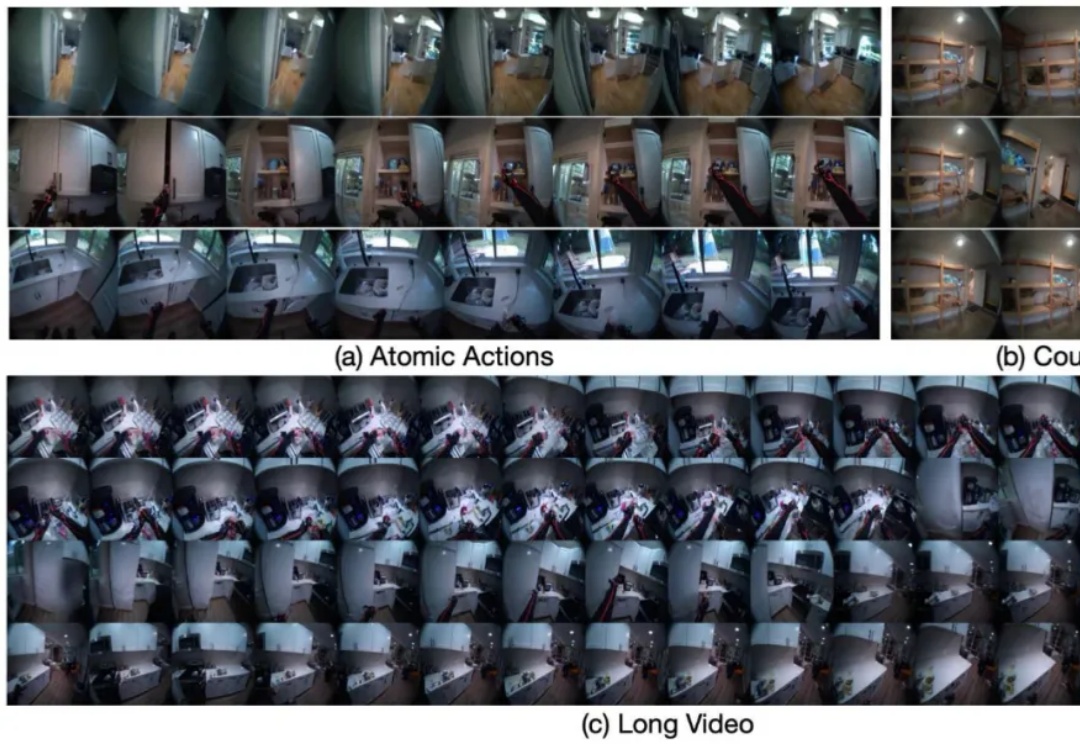

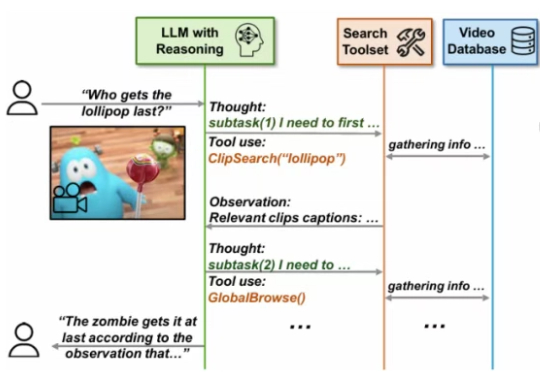

尽管大型语言模型(LLMs)和大型视觉 - 语言模型(VLMs)在视频分析和长语境处理方面取得了显著进展,但它们在处理信息密集的数小时长视频时仍显示出局限性。

图像模型开源还得是FLUX!Black Forest Labs刚刚宣布开源旗舰图像模型FLUX.1 Kontext[dev],专为图像编辑打造,还能直接在消费级芯片上运行。

大模型的预训练-微调范式,正在悄然改写强化学习!伯克利团队提出新方法InFOM,不依赖奖励信号,也能在多个任务中实现超强迁移,还能做到「读心术」级别的推理。这到底怎么做到的?

如今的视觉语言模型 (VLM, Vision Language Models) 已经在视觉问答、图像描述等多模态任务上取得了卓越的表现。然而,它们在长视频理解和检索等长上下文任务中仍表现不佳。

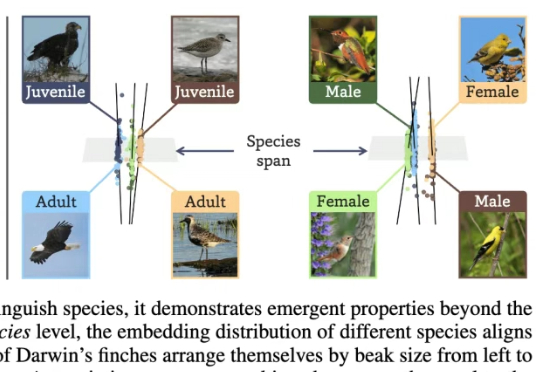

让AI看懂95万物种,并自己悟出生态关系与个体差异!俄亥俄州立大学研究团队在2亿生物图像数据上训练了BioCLIP 2模型。大规模的训练让BioCLIP 2取得了目前最优的物种识别性能。

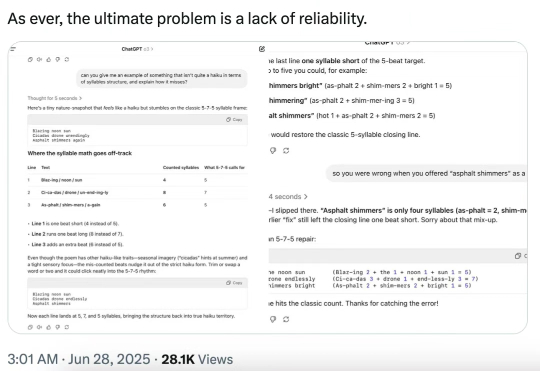

今天,著名的人工智能学者和认知科学家 Gary Marcus 转推了 MIT、芝加哥大学、哈佛大学合著的一篇爆炸性论文,称「对于 LLM 及其所谓能理解和推理的神话来说,情况变得更糟了 —— 而且是糟糕得多。」

最近,苹果的一篇论文掀起波澜,挑战了当下AI推理能力的基本假设。而OpenAI的前研究主管则断言:AGI时代已近在眼前。谁是谁非?AGI还有多远?

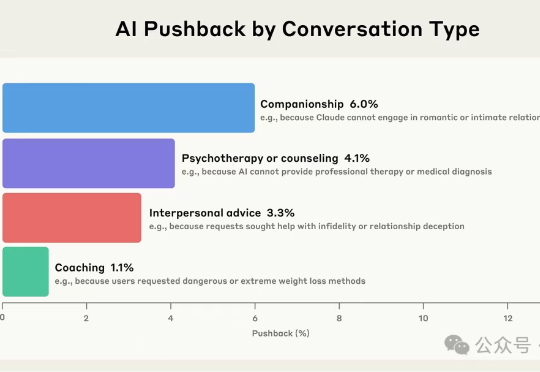

你有没有试过,深夜心情低落时,对着AI倾诉?Anthropic最新研究发现,越来越多成年人正把AI当作情感陪伴。