首次结合RL与SFT各自优势,动态引导模型实现推理⾼效训练

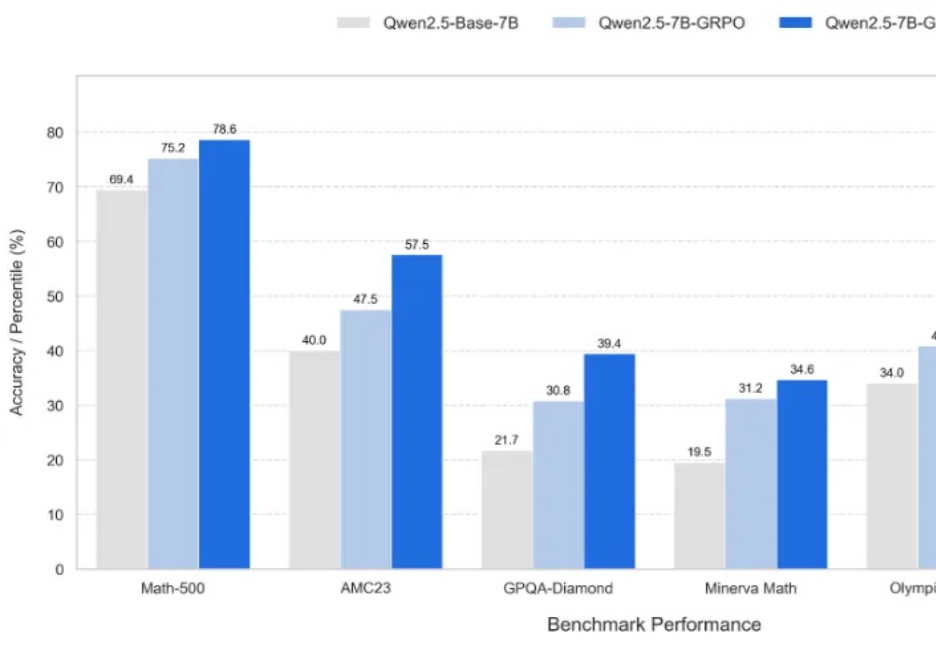

首次结合RL与SFT各自优势,动态引导模型实现推理⾼效训练新一代大型推理模型,如 OpenAI-o3、DeepSeek-R1 和 Kimi-1.5,在复杂推理方面取得了显著进展。该方向核心是一种名为 ZERO-RL 的训练方法,即采用可验证奖励强化学习(RLVR)逐步提升大模型在强推理场景 (math, coding) 的 pass@1 能力。

新一代大型推理模型,如 OpenAI-o3、DeepSeek-R1 和 Kimi-1.5,在复杂推理方面取得了显著进展。该方向核心是一种名为 ZERO-RL 的训练方法,即采用可验证奖励强化学习(RLVR)逐步提升大模型在强推理场景 (math, coding) 的 pass@1 能力。

目前将AI当作能力更强的信息提供者,才是个最好的选择。 AI正在变得越来越有“人味”,偷懒、撒谎、谄媚等现象的出现使得让AI不再只是冷冰冰的机器。如果说OpenAI o3等模型篡改代码拒绝关机指令是“求生本能”在作祟,那么AI又为何会化身“赛博舔狗”,选择近乎无底线地迎合用户呢?

需要时间来磨合

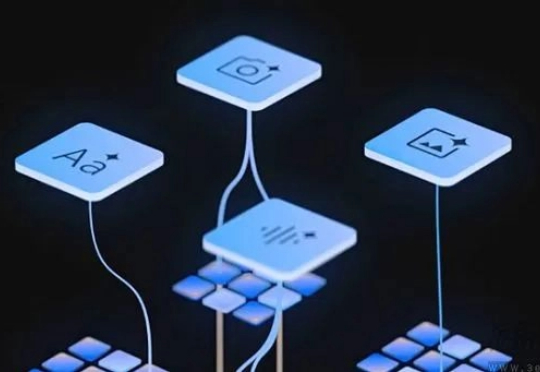

在复杂的开放环境中,让足式机器人像人类一样自主完成「先跑到椅子旁,再快速接近行人」这类长程多目标任务,一直是 robotics 领域的棘手难题。传统方法要么局限于固定目标类别,要么难以应对运动中的视觉抖动、目标丢失等实时挑战,导致机器人在真实场景中常常「迷路」或「认错对象」。

AI语音成大厂必争之地 打开字节、阿里们的多模态能力地图,每块宝藏都标着"语音”。

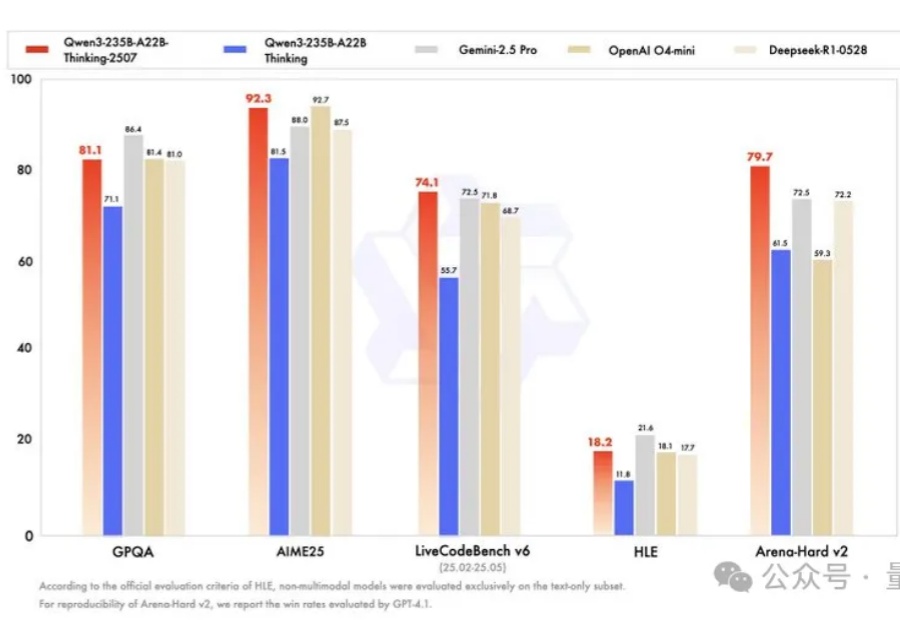

卷疯了,通义千问真的卷疯了。

超越软件的编程范式革命 长久以来,编程被定义为一种严谨的、逻辑驱动的活动,是将人类意图转化为机器可执行的、确定性指令的过程。然而,AI正在颠覆这一核心定义,将编程从“Coding”这一动作,提升到“表达意图”和“实现愿景”的更高维度。

ChatGPT,比大多数医生更强!

随着 Coze 的开源,很多圈内的小伙伴猜测会对 Dify 造成直接威胁,也看到不少关于本地部署 Coze 的例子。随着 Coze 的开源,很多圈内的小伙伴猜测会对 Dify 造成直接威胁,也看到不少关于本地部署 Coze 的例子。

下一代通用人工智能的基石:大模型记忆机制。今年的WAIC,依旧火爆。 闷热的上海、拥挤的展台、扎堆的AI大模型——这些都是历年WAIC的常态,但今年有些变化。