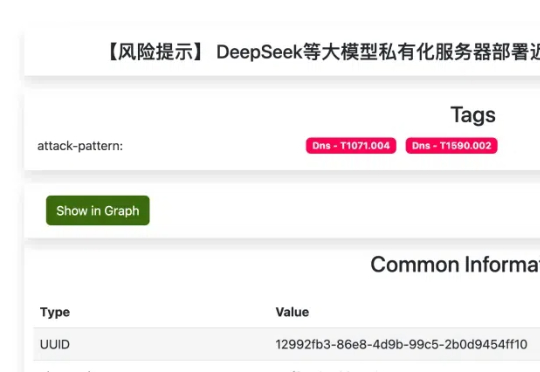

Ollama有安全漏洞! 国家网络安全通报中心紧急通报

Ollama有安全漏洞! 国家网络安全通报中心紧急通报国家网络安全通报中心昨天扔了个"炸弹":大模型工具Ollama有安全漏洞! 相信不少人用ollama来跑DeepSeek、Llama等模型,确实很方便。可通报里说,它默认开放的11434端口跟没锁的大门似的,谁都能进。今天就和你就说一下 这到底是怎么回事?顺便手把手教你几招,保住你的算力和隐私。

国家网络安全通报中心昨天扔了个"炸弹":大模型工具Ollama有安全漏洞! 相信不少人用ollama来跑DeepSeek、Llama等模型,确实很方便。可通报里说,它默认开放的11434端口跟没锁的大门似的,谁都能进。今天就和你就说一下 这到底是怎么回事?顺便手把手教你几招,保住你的算力和隐私。

国内的AI办公产品,AiPPT.com 绝对是最不可忽视的一个。产品上线后 4 个月,月活跃用户数便突破了百万大关,2025 年 2 月,AiPPT.com 的全球单月访问量逼近 1400 万,全球排名第 2。对于背后的团队像素绽放来说,这也是他们内部最先测试跑通的 AI 核心产品,目前已成为团队变现能力最强的产品之一。

年薪最高53万美元,OpenAI机器人团队,叒叒叒招人了!最新消息,OpenAI正在招募机器人底层技术模型开发人员,年薪29.5-53万美元(约合人民币214-385万)。

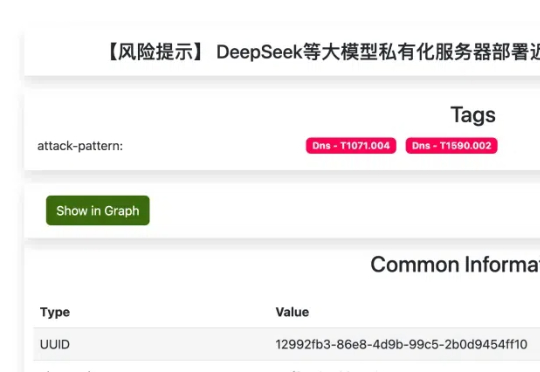

本文构建了新的多轮组合图像检索数据集和评测基准FashionMT。其特点包括:(1)回溯性:每轮修改文本可能涉及历史参考图像信息(如保留特定属性),要求算法回溯利用多轮历史信息;(2)多样化:FashionMT包含的电商图像数量和类别分别是MT FashionIQ的14倍和30倍,且交互轮次数量接近其27倍,提供了丰富的多模态检索场景。

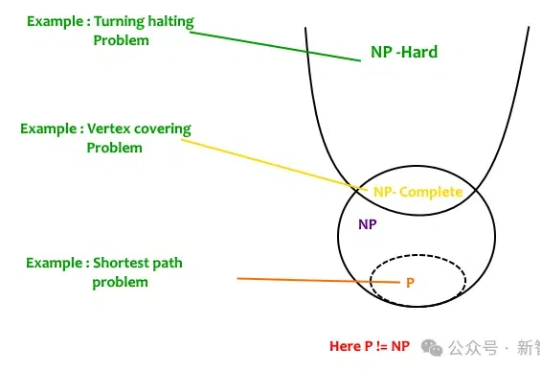

给DeepSeek-R1推理指导,它的数学推理能力就开始暴涨。更令人吃惊是,Qwen2.5-14B居然给出了此前从未见过的希尔伯特问题的反例!而人类为此耗费了27年。研究者预言:LLM离破解NP-hard问题,已经又近了一步。

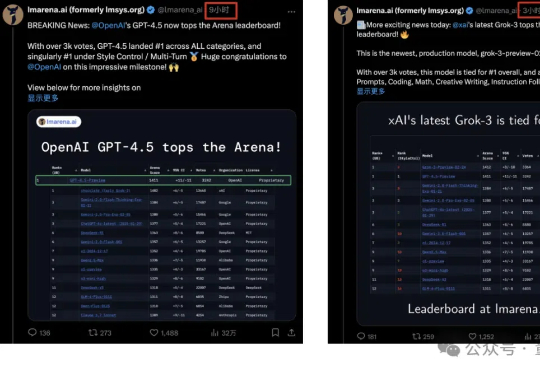

基础模型竞争又紧张刺激起来了!GPT-4.5刚登顶竞技场且全任务分类第一名,6小时后总榜就被马斯克的新版Grok-3反超。两者都是获得3000+票数,总分1412:1411只差一分。

,最近,Appfigure 通过梳理 1000 款 AI 应用(移动端)总结了一份年度 AI 趋势报告,称AI市场在2024年近20亿美元的规模,重点介绍了AI助理、文生图、AI 陪伴、教育AI等版块。

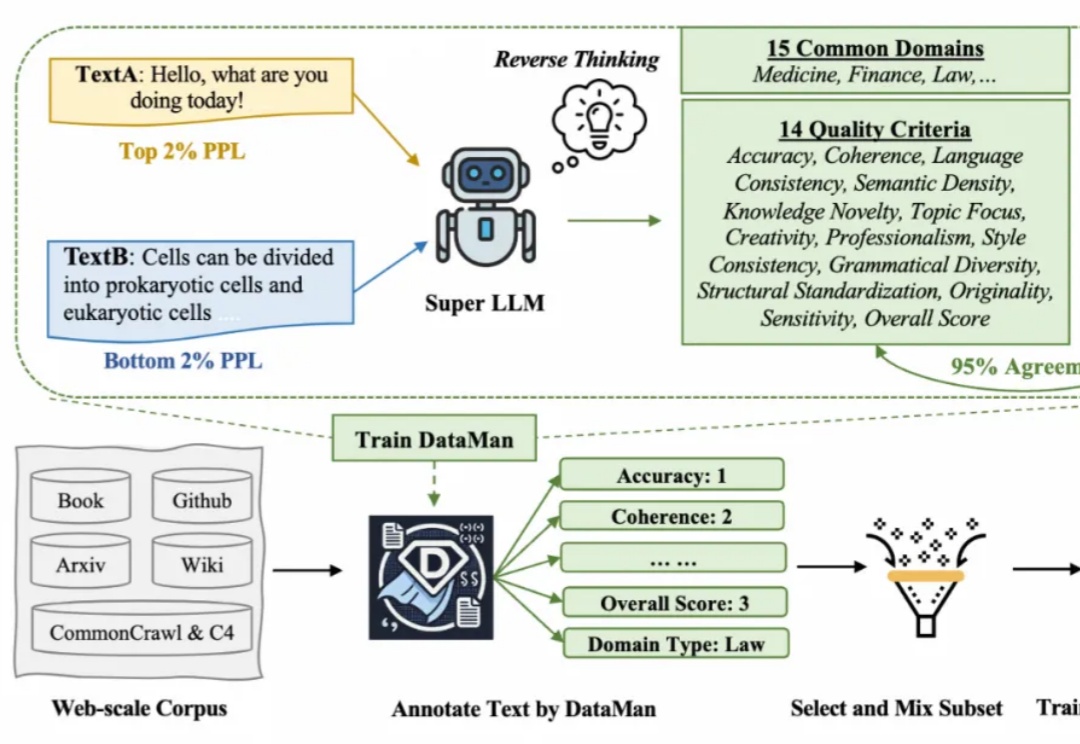

在 Scaling Law 背景下,预训练的数据选择变得越来越重要。然而现有的方法依赖于有限的启发式和人类的直觉,缺乏全面和明确的指导方针。在此背景下,该研究提出了一个数据管理器 DataMan,其可以从 14 个质量评估维度对 15 个常见应用领域的预训练数据进行全面质量评分和领域识别。

一篇题为「New Junior Developers Can’t Actually Code」的博文炸开了锅。资深码农Namanyay对AI工具在软件开发中的广泛应用表达了忧虑——AI正在让新一代开发者跳过基础知识的学习,沦为「复制粘贴(CV)工程师」。这篇文章迅速蹿红,引发了包括马斯克在内的众多业内大佬的热议。

AI组队自主开发时代来临!OpenAI Operator和Replit Agent组队编程,仅在5个提示90分钟内完成了应用程序的开发。