更大,还能更快,更准!蚂蚁开源万亿参数语言模型Ling-1T,刷新多项SOTA

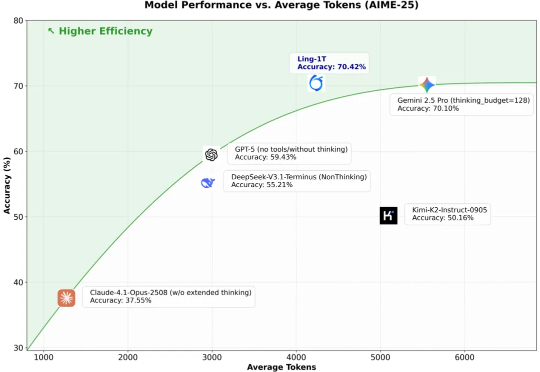

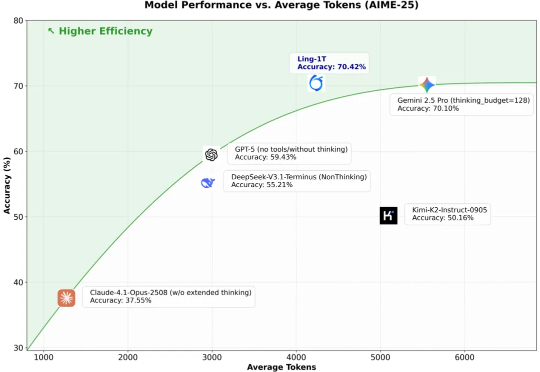

更大,还能更快,更准!蚂蚁开源万亿参数语言模型Ling-1T,刷新多项SOTA10 月 9 日凌晨,百灵大模型再度出手,正式发布并开源通用语言大模型 Ling-1T ——蚂蚁迄今为止开源的参数规模最大的语言模型。至此,继月之暗面Kimi K2、阿里 Qwen3-Max 之后,又一位重量级选手迈入万亿参数LLM 「开源俱乐部」。

10 月 9 日凌晨,百灵大模型再度出手,正式发布并开源通用语言大模型 Ling-1T ——蚂蚁迄今为止开源的参数规模最大的语言模型。至此,继月之暗面Kimi K2、阿里 Qwen3-Max 之后,又一位重量级选手迈入万亿参数LLM 「开源俱乐部」。

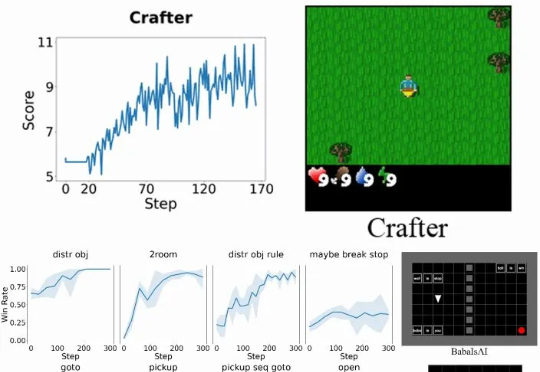

具体而言,Verlog 是一个多轮强化学习框架,专为具有高度可变回合(episode)长度的长时程(long-horizon) LLM-Agent 任务而设计。它在继承 VeRL 和 BALROG 的基础上,并遵循 pytorch-a2c-ppo-acktr-gail 的成熟设计原则,引入了一系列专门优化手段,从而在任务跨度从短暂交互到数百回合时,依然能够实现稳定而高效的训练。

写代码的规则,正在被悄悄改写!不再是「人+AI一起盯屏幕」,而是一次性放出十几个任务,让代理们各自跑。真正的门槛,也不再是你能写多少行代码,而是你能不能写清楚需求、明确地拆分任务、快速浏览结果。

今天凌晨,马斯克的大模型独角兽xAI祭出最新视频生成模型Imagine v0.9,免费向所有用户开放。一周前,OpenAI发布了旗舰视频和音频生成模型Sora 2,此次更新或许是马斯克对Sora 2的直接回应。

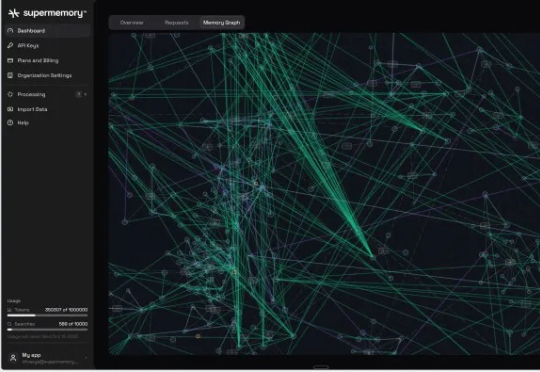

Supermemory 已获得由 Susa Ventures、Browder Capital 和 SF1.vc 领投的 260 万美元种子轮融资。此轮融资还包括 Cloudflare 的 Knecht、谷歌人工智能负责人 Jeff Dean、DeepMind 产品经理 Logan Kilpatrick、Sentry 创始人 David Cramer 以及来自 OpenAI、

吴恩达 (Andrew Ng) 执教的斯坦福 CS230 深度学习旗舰课程已更新至 2025 秋季版,首讲视频现已公开!课程采用翻转课堂模式,学生需提前观看 Coursera 上的 deeplearning.ai 专项课程视频(包括神经网络基础、超参数调优、结构化机器学习项目等模块),然后参加线下课程。

斯坦福大学研究人员提出了Paper2Agent,将静态论文转化为可交互的AI智能体,让学术成果可以直接被「调用」,为科研知识传播开辟了新模式,并为构建AI共研生态奠定基础。

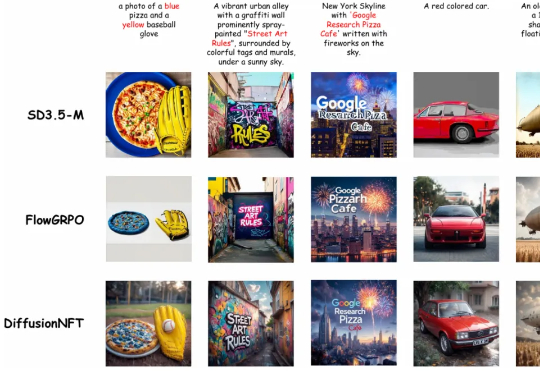

清华大学朱军教授团队,NVIDIA Deep Imagination 研究组与斯坦福 Stefano Ermon 团队联合提出了一种全新的扩散模型强化学习(RL)范式 ——Diffusion Negative-aware FineTuning (DiffusionNFT)。该方法首次突破现有 RL 对扩散模型的基本假设,直接在前向加噪过程(forward process)上进行优化

“科学的尽头是玄学。”朋友圈的 985 研究生如是说。 封面图片由AI生成 “AI 说我能暴富,但我书都没翻开。” 2018 年,一个男大学生因为朋友的怂恿,酒局中打开了一本星座占卜书,当他只是根据朋

该团队 2025 年的研究《Reasoning by superposition: A theoretical perspective on chain of continuous thought》已从理论上指出,连续思维链的一个关键优势在于它能使模型在叠加(superposition)状态下进行推理:当模型面对多个可能的推理路径而无法确定哪一个是正确时,它可以在连续空间中并行地保留所有可能的路