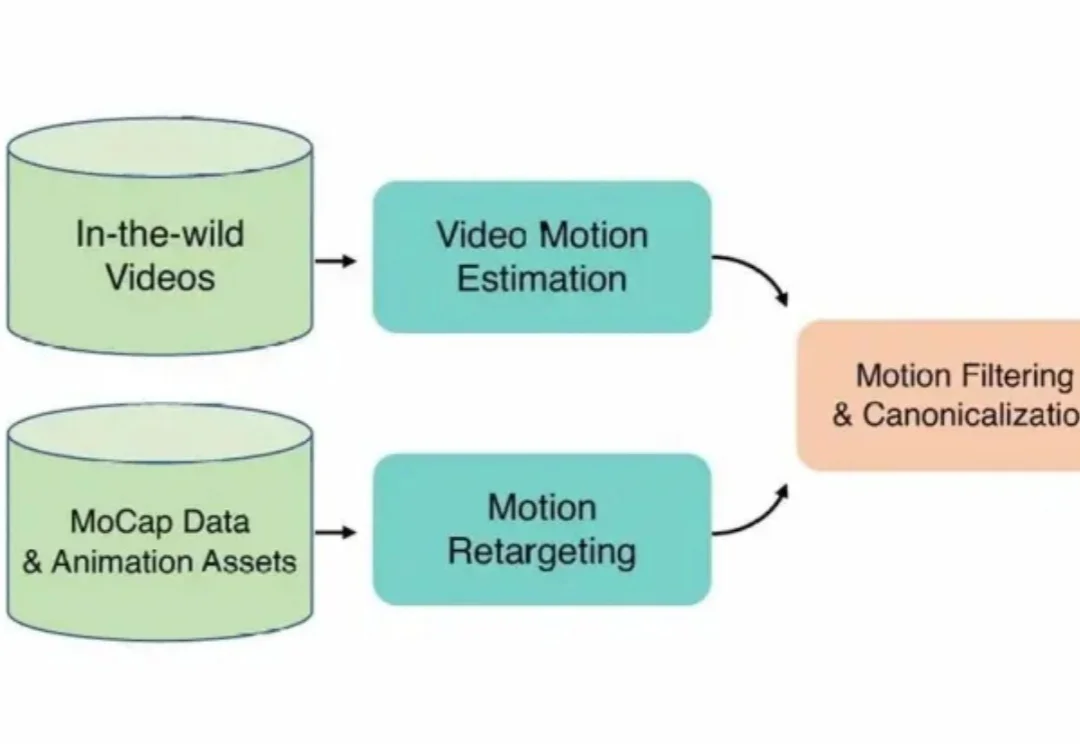

让AI当「动作导演」:腾讯混元动作大模型开源,听懂模糊指令,生成高质量3D角色动画

让AI当「动作导演」:腾讯混元动作大模型开源,听懂模糊指令,生成高质量3D角色动画在3D角色动画创作领域,高质量动作资产的匮乏长期制约着产出的上限。

在3D角色动画创作领域,高质量动作资产的匮乏长期制约着产出的上限。

美国当地时间1月13日,语音AI公司Deepgram宣布完成1.3亿美元C轮融资。此轮融资后,公司总融资额达到2.15亿美元,估值13亿美元,成为了这一赛道的新晋独角兽。

今天,谷歌Veo 3.1终于迎来重磅升级,表现力直接爆表! 这一次,谷歌特别优化了移动端体验。只需上传一些「素材图片」(ingredient images),就能轻松创作出更有趣、更有创意、画质极佳的视频。

2026 年刚开年,独立开发者圈子就炸锅了。

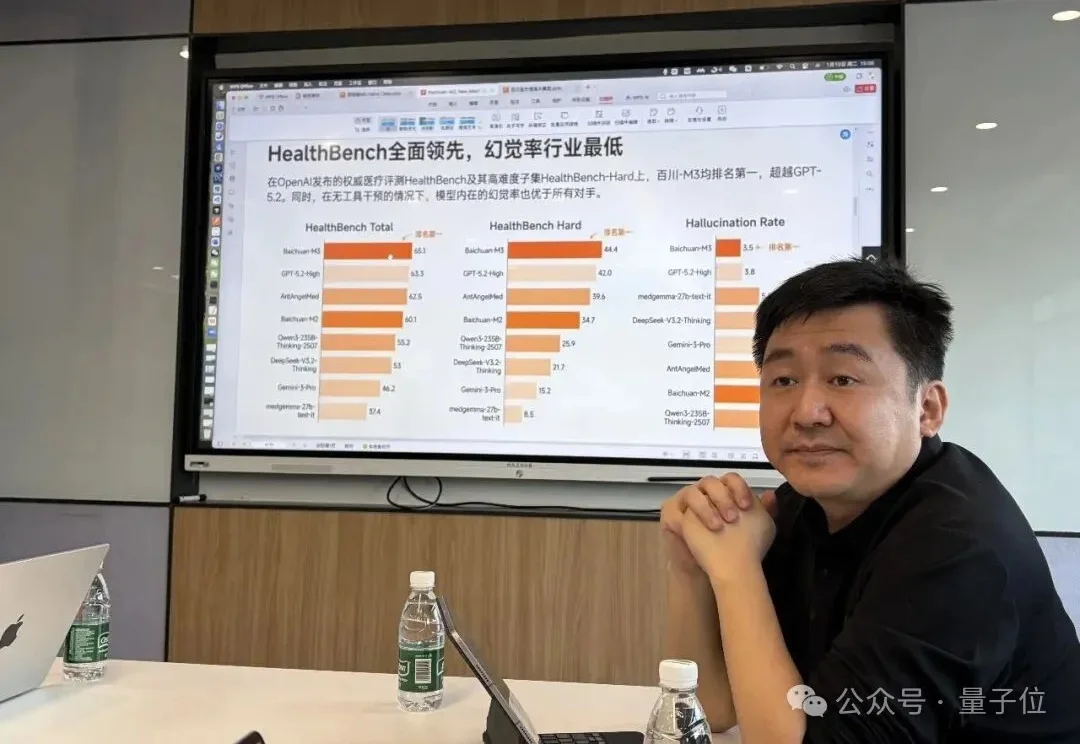

“我们没有能力一会儿金融、一会儿娱乐、一会儿医疗,只能深耕一条主线。”

今日,深圳AI初创公司DeepWisdom正式完成A轮及A+轮融资,累计金额达3100万美元(约合人民币2.1亿元)。据公开信息,DeepWisdom的累计融资规模位居国内同领域第一。

一家年销售额超过3亿元的“塑料收纳柜”生产工厂老板林明(化名),决定大胆地把2026年的利润目标上调一倍。让他有自信的核心原因是,凭借AI,他的工厂正在经历一场“员工与组织革命”。

百川智能表示今年上半年,将陆续发布两款 to C 的医疗产品。 作者|Li Yuan 编辑|郑玄 你有没有向 AI 助手问过你的健康问题? 如果你和我一样是一个 AI 的深度用户,大概率你也试过。 O

一份大模型中标数据报告,揭示了产业重心转移的清晰轨迹:应用类项目占比近六成,市场用真金白银为 “落地” 投票。2025 年,中国大模型产业在招投标市场上演了一场令人瞠目的 “狂飙”。智能超参数的监测数据显示,全年大模型相关中标项目数量达到 7539 个,披露金额 295.2 亿元,较 2024 年分别激增 396% 与 356%。市场正以前所未有的速度,将技术潜力兑换为商业订单。

假如你是一个致力于将 AI 引入传统行业的工程团队。现在,你有一个问题:训练一个能看懂复杂机械图纸、设备维护手册或金融研报图表的多模态助手。这个助手不仅要能专业陪聊,更要能精准地识别图纸上的零件标注,或者从密密麻麻的财报截图中提取关键数据。