全球首个AI人狗交流软件来了!“将宠物犬行为和叫声翻译成人类语言的准确率已达81.5%”

全球首个AI人狗交流软件来了!“将宠物犬行为和叫声翻译成人类语言的准确率已达81.5%”将自己的宠物犬的照片、视频或是叫声发给Traini,这款App会即刻根据宠物专家给出的专业知识,分析出狗狗想要表达的内容,用人类语言表达出来;同时,也可以将主人的指令翻译成犬吠声,以此达到与自己宠物的“无障碍”交流。

将自己的宠物犬的照片、视频或是叫声发给Traini,这款App会即刻根据宠物专家给出的专业知识,分析出狗狗想要表达的内容,用人类语言表达出来;同时,也可以将主人的指令翻译成犬吠声,以此达到与自己宠物的“无障碍”交流。

在 4 月 18 日举办的 2025 英特尔具身智能解决方案推介会上,英特尔正式发布其具身智能大小脑融合方案(下称具身智能方案)。

Perplexity AI 公司正与三星电子商讨在其设备上集成虚拟助手事宜,并已与联想集团旗下摩托罗拉达成此类合作协议。

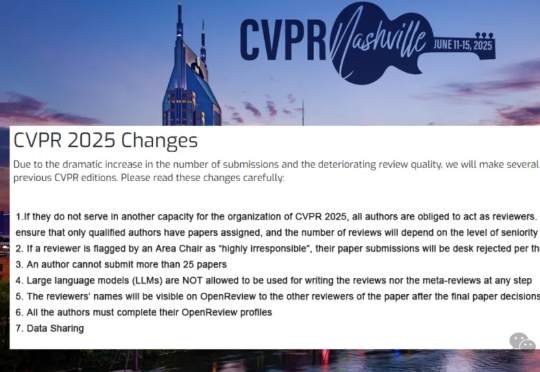

顶会论文评审,AI立大功!ICLR 2025首次大规模引入AI参与审稿,最终有12222条建议被审稿人采纳,89%情况下提升了评审质量。详细30页报告,揭秘AI在顶会审稿的惊人潜力。

凌晨3点,AI第8次把按钮写成button_1,我差点把电脑砸了...

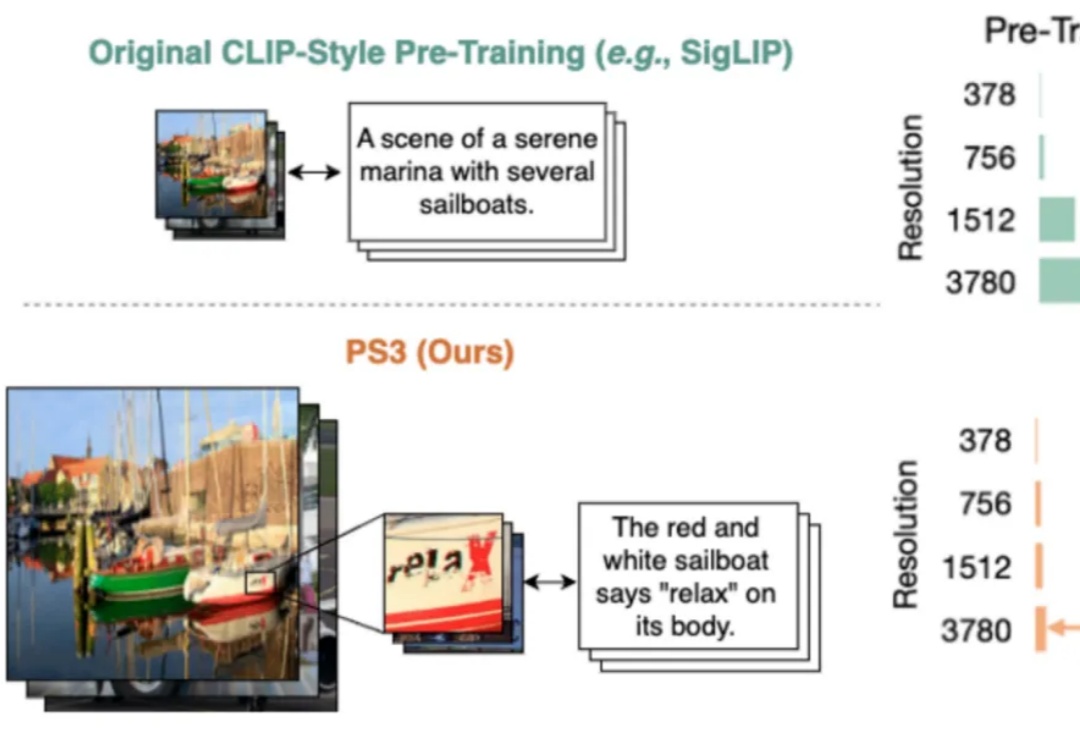

当前,所有主流的视觉基础模型(如 SigLIP、DINOv2 等)都仍然在低分辨率(如 384 * 384 分辨率)下进行预训练。对比人类视觉系统可以轻松达到 10K 等效分辨率,这种低分辨率预训练极大地限制了视觉模型对于高清细节的理解能力。

早在去年10月底IBM推出了PDL声明式提示编程语言,本篇是基于PDL的一种对Agent的自动优化方法,是工业界前沿的解决方案。当你在开发基于大语言模型的Agent产品时,是否曾经在提示模式选择和优化上浪费了大量时间?在各种提示模式(Zero-Shot、CoT、ReAct、ReWOO等)中选择最佳方案,再逐字斟酌提示内容,这一过程不仅耗时,而且常常依赖经验和直觉而非数据驱动的决策。

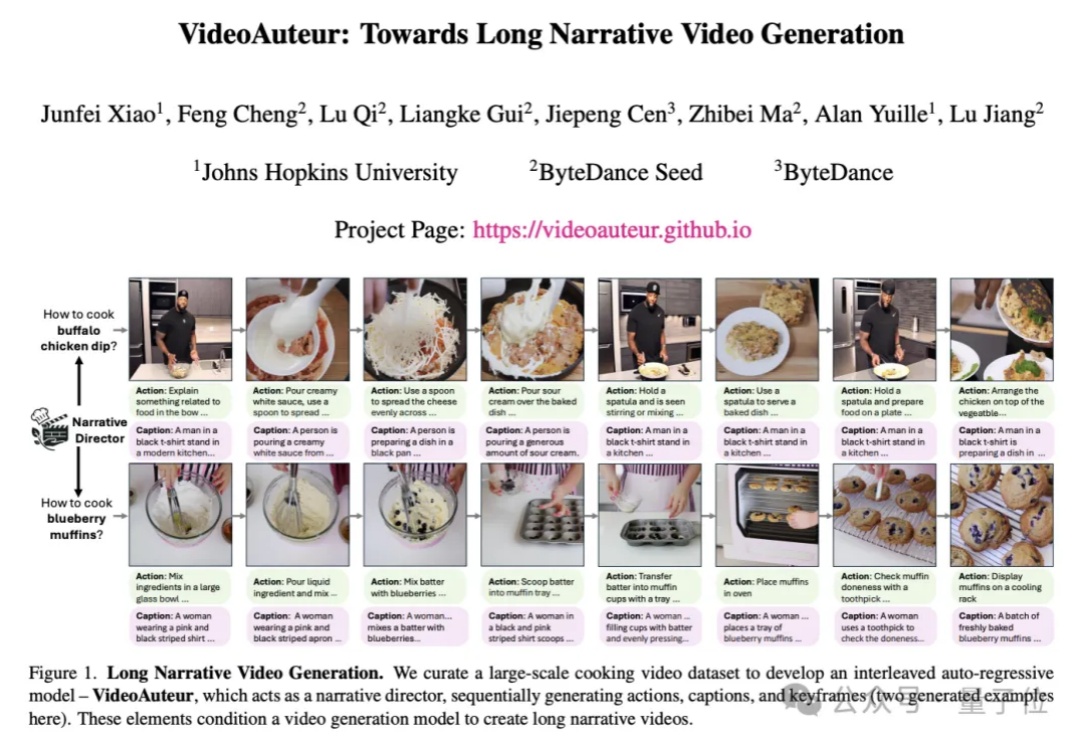

字节Seed团队视频生成基础模型,来了。

移动GUI自动化智能体V-Droid采用「验证器驱动」架构,通过离散化动作空间并利用LLM评估候选动作,实现了高效决策。在AndroidWorld等多个基准测试中任务成功率分别达到59.5%、38.3%和49%,决策延迟仅0.7秒,接近实时响应。

虽然扩散模型在视频生成领域展现出了卓越的性能,但是视频扩散模型通常需要大量的推理步骤对高斯噪声进行去噪才能生成一个视频。这个过程既耗时又耗计算资源。例如,HunyuanVideo [1] 需要 3234 秒才能在单张 A100 上生成 5 秒、720×1280、24fps 的视频。