Meta收购Manus最新进展:商务部介入,启动评估调查

Meta收购Manus最新进展:商务部介入,启动评估调查Meta收购Manus,或许还未到尘埃落定之际。据商务部新闻发言人何亚东透露,商务部将会同相关部门对此项收购与出口管制、技术进出口、对外投资等相关法律法规的一致性开展评估调查。

Meta收购Manus,或许还未到尘埃落定之际。据商务部新闻发言人何亚东透露,商务部将会同相关部门对此项收购与出口管制、技术进出口、对外投资等相关法律法规的一致性开展评估调查。

出走5年,估值翻倍!曾被嘲笑「太保守」的Anthropic,正凭3500亿美元身价硬刚OpenAI。看理想主义者如何靠极致安全与Coding神技,在ARR激增的复仇路上,终结Sam Altman的霸权!

在 2026 年的 CES 全球消费电子展上,AI 硬件无疑是不可忽视的一支—— 小至能根据指令作画的 AI 画框,大到能叠衣服的家务机器人......AI 已经无处不在。

想知道硅谷的程序员怎么使用AI编程,被2000家公司使用的AI代码审查智能体Greptile基于每月用AI审核的的十亿行代码,发布了AI编程年度报告,揭示了使用AI编程后带来的生产率提升,但对此程序员们却无法感同身受。

面对一张精美的画作,你的第一反应是什么?

2026 年,基模会不会吃掉所有应用场景?

谁能想到,AI界最权威的大模型排行榜,竟然是个彻头彻尾的骗局?最近,2025年底的一篇名为《LMArena is a cancer on AI》的文章被翻了出来。登上了Hacker News的首页,引起轩然大波!

今日,小米前高管王腾在个人微博发文透露创业新动态。据其所述,从小米离开后开始筹备创业,最近新公司已经成立,公司取名为“今日宜休”,目标是通过研发睡眠健康相关的产品。谈及入局“AI+健康睡眠”领域,王腾认为,新时代下AI大模型发展迅速,让很多产品的体验能大幅提升。

借鉴人类联想记忆,嵌套学习让AI在运行中构建抽象结构,超越Transformer的局限。谷歌团队强调:优化器与架构互为上下文,协同进化才能实现真正持续学习。这篇论文或成经典,开启AI从被动训练到主动进化的大门。

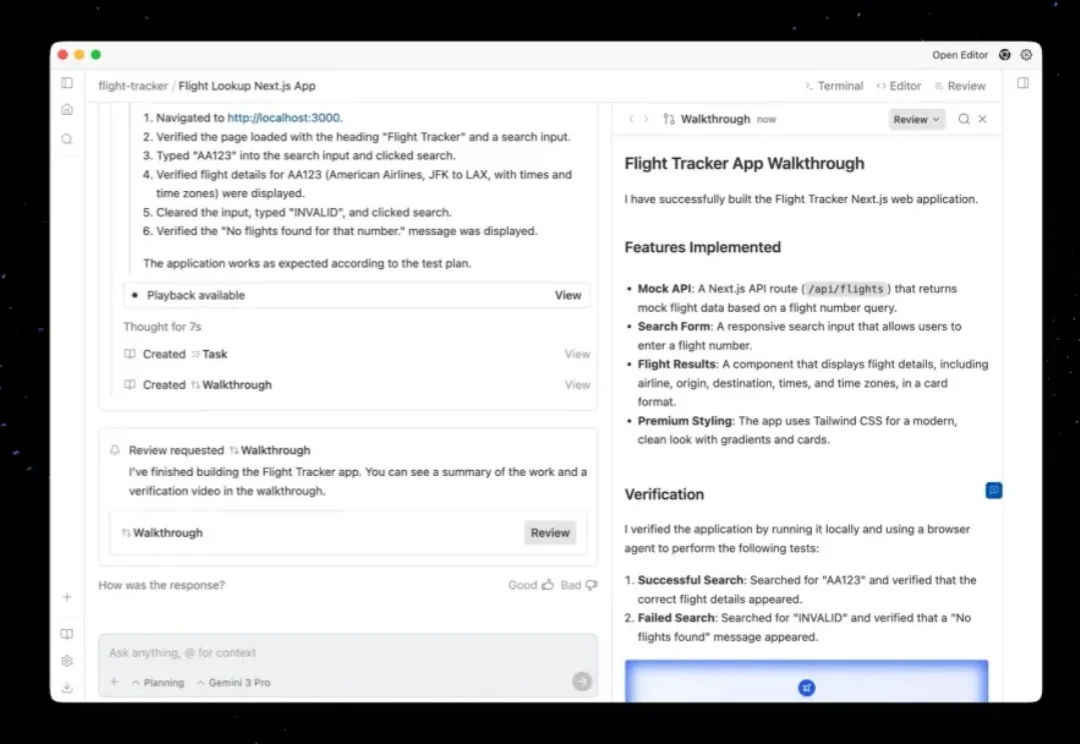

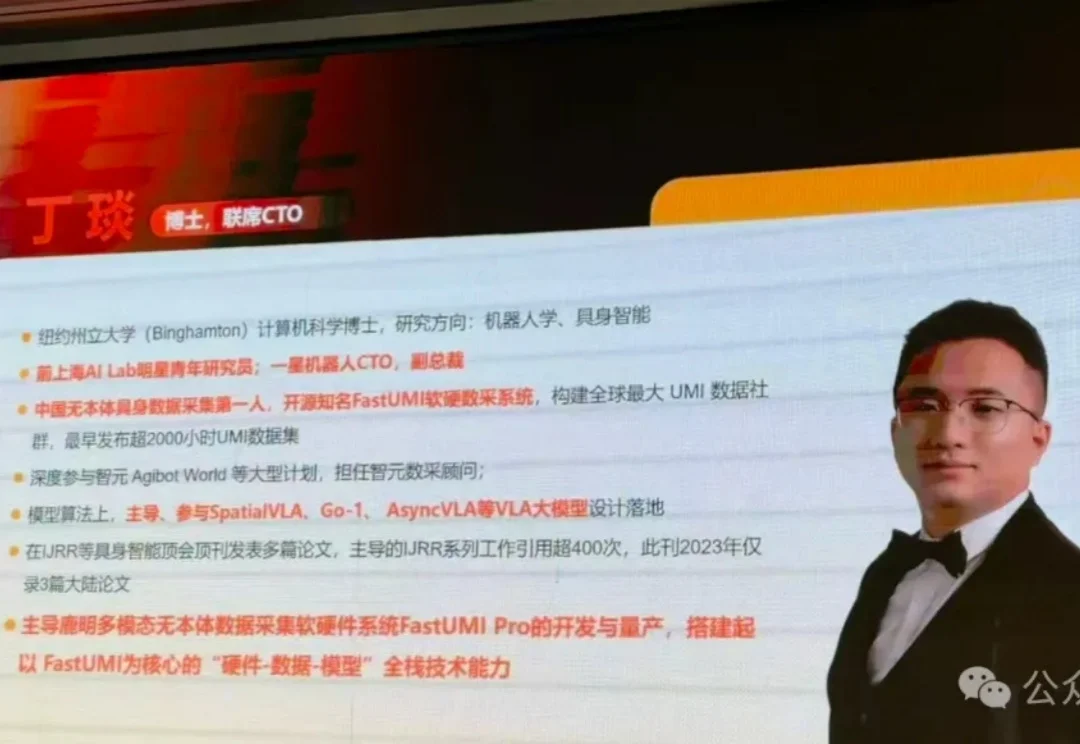

“我们只交付100%可以复现的轨迹。”