国产AI模型登顶全球TOP 1!智源BGE下载破亿成Hugging Face月榜冠军,RAG「瑞士军刀」破纪录

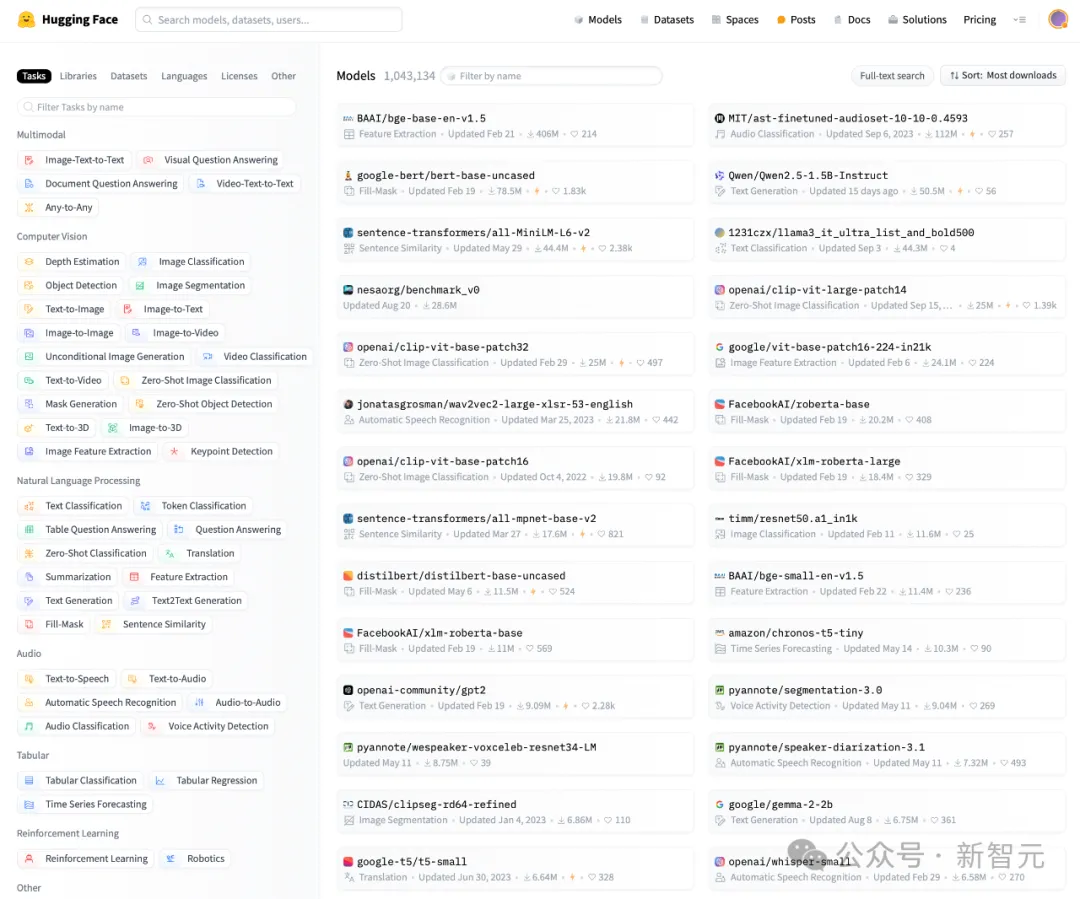

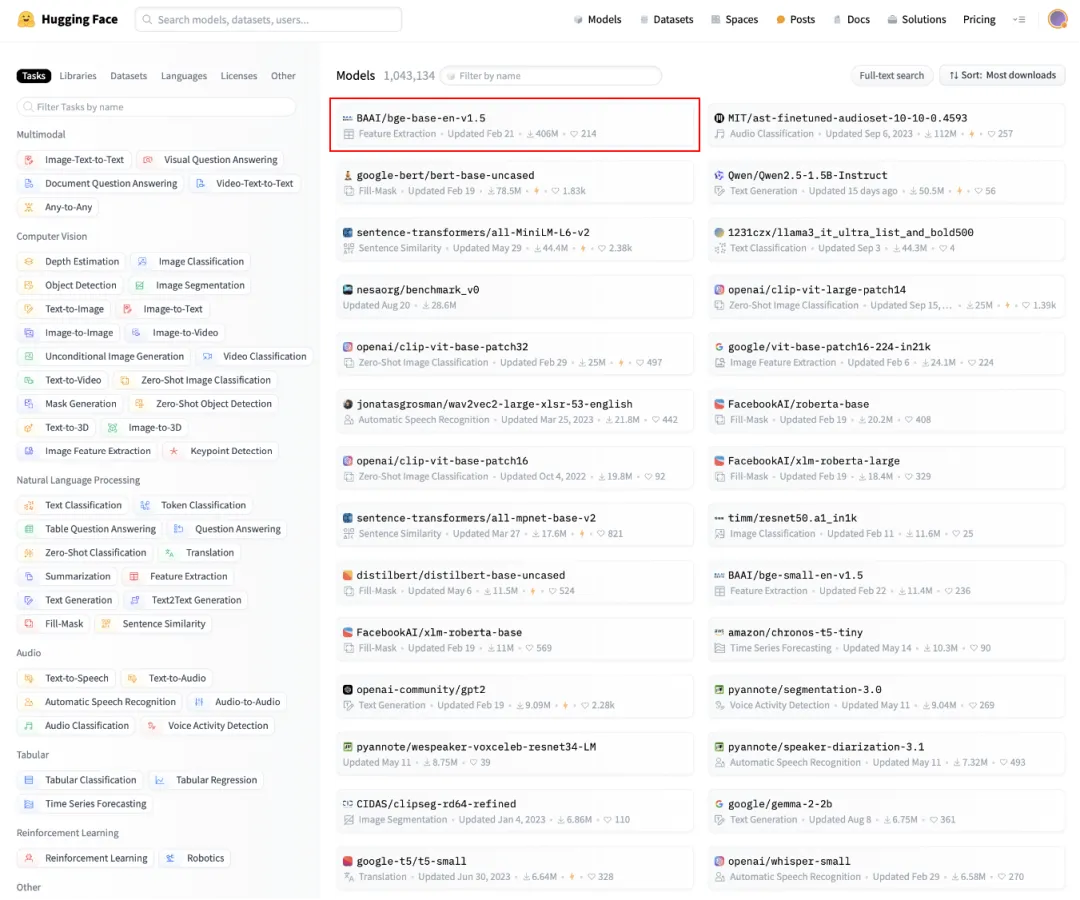

国产AI模型登顶全球TOP 1!智源BGE下载破亿成Hugging Face月榜冠军,RAG「瑞士军刀」破纪录国产首个AI模型登顶Hugging Face月榜冠军!发布短短一年,BGE模型总下载量破数亿,位居国产TOP 1。如今,它在开源社区广受欢迎,被誉为RAG生态中的「瑞士军刀」。

国产首个AI模型登顶Hugging Face月榜冠军!发布短短一年,BGE模型总下载量破数亿,位居国产TOP 1。如今,它在开源社区广受欢迎,被誉为RAG生态中的「瑞士军刀」。

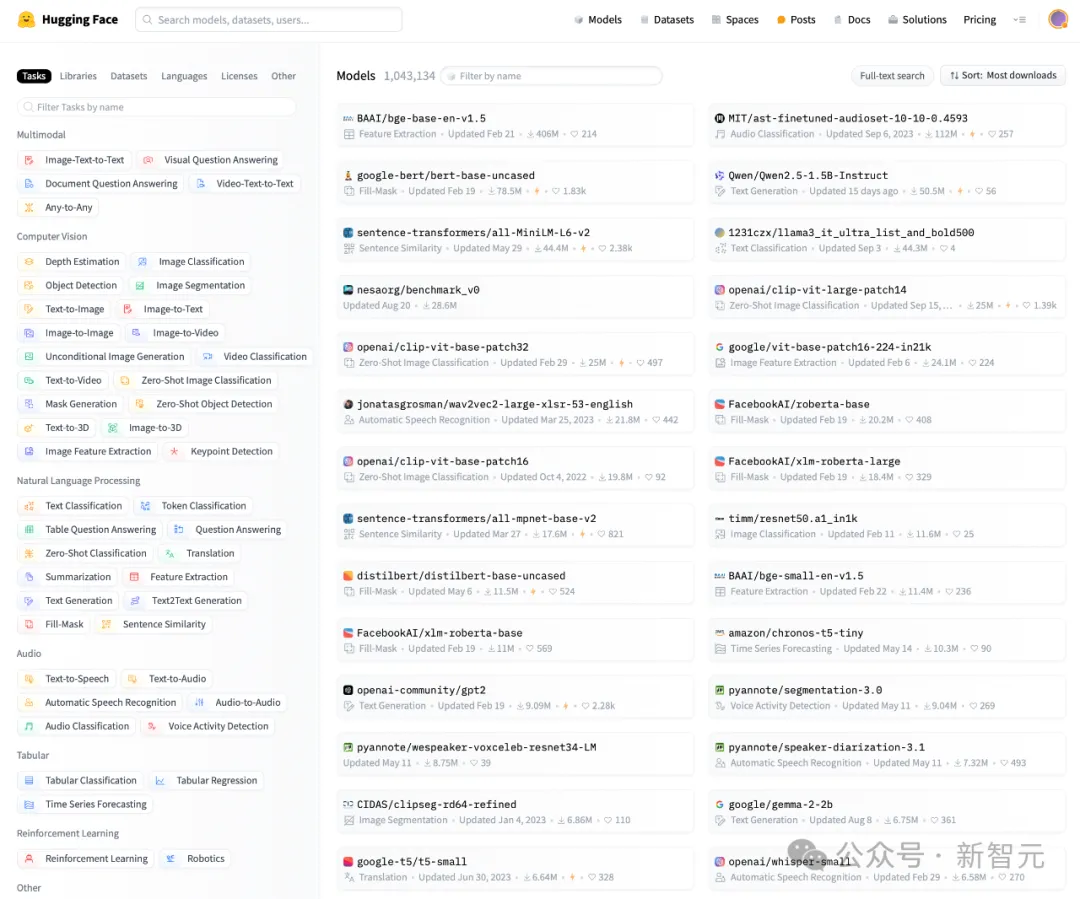

近日,Hugging Face更新了月度榜单,智源研究院的BGE模型登顶榜首,这是中国国产AI模型首次成为Hugging Face月榜冠军。BGE在短短一年时间内,总下载量已超数亿次,是目前下载量最多的国产AI系列模型。

在AI的世界里,模型的评估往往被看作是最后的「检查点」,但事实上,它应该是确保AI模型适合其目标的基础。

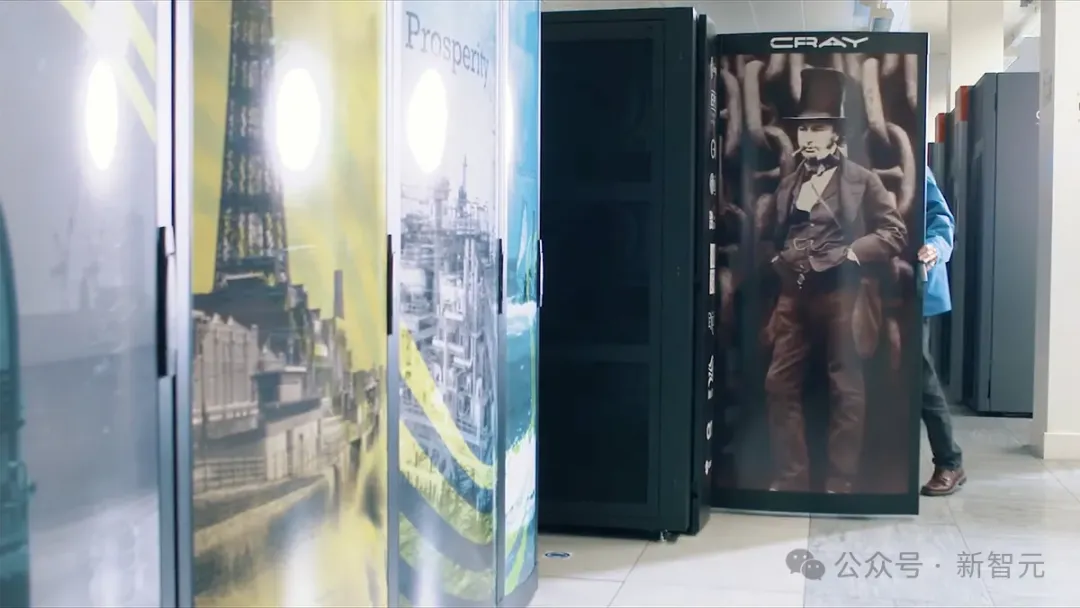

世界上首台基于Arm架构的超算,现如今终于退役了。 2018年5月,这台拥有10000个核心的系统Isambard 2首次部署。 它使用了由Cavium开发、台积电制造的64位Armv8 ThunderX2处理器,外加几个Nvidia P100 GPU。

世界上首台基于Arm架构的超算,现如今终于退役了。

2020 年,谷歌发表了预印本论文《Chip Placement with Deep Reinforcement Learning》,介绍了其设计芯片布局的新型强化学习方法。后来在 2021 年,谷歌又发表在 Nature 上并开源了出来。

相比第一代, 延迟降低40%,成本还降低30%。

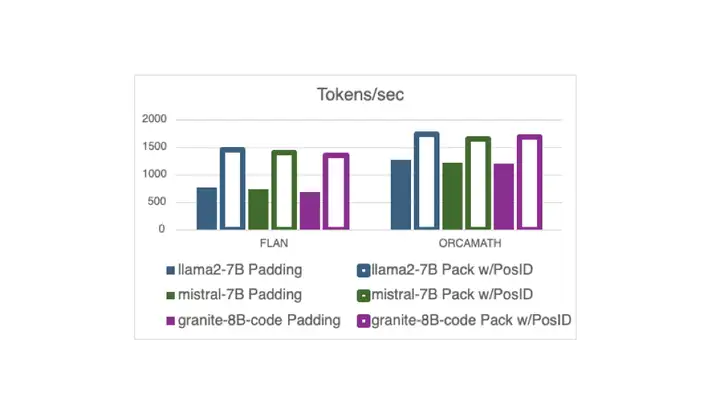

现在,在 Hugging Face 中,使用打包的指令调整示例 (无需填充) 进行训练已与 Flash Attention 2 兼容,这要归功于一个 最近的 PR 以及新的 DataCollatorWithFlattening。 它可以在保持收敛质量的同时,将训练吞吐量提高多达 2 倍。继续阅读以了解详细信息!

大语言模型(如 GPT-4)具备强大的语言处理能力,但其独立运作时仍存在局限性,如无法进行复杂计算,获取不到实时信息,难以提供专业定制化功能等。而大语言模型的工具调用能力使其不仅限于文字处理,更能提供全面、实时、精确的服务,极大地扩展了其应用范围和实际价值。

一个高质量的人脸识别训练集要求身份 (ID) 有高的分离度(Inter-class separability)和类内的变化度(Intra-class variation)。