简单通用:视觉基础网络最高3倍无损训练加速,清华EfficientTrain++入选TPAMI 2024

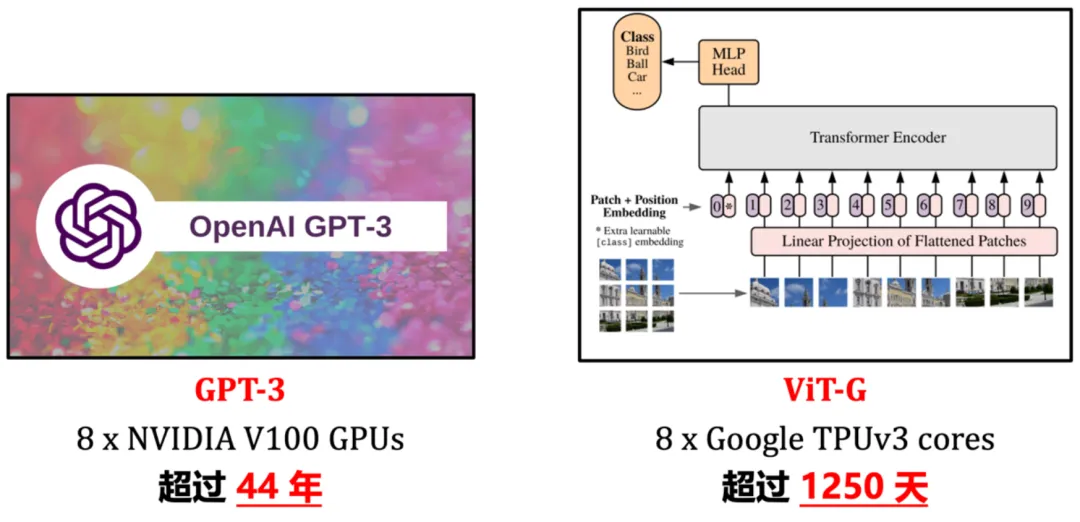

简单通用:视觉基础网络最高3倍无损训练加速,清华EfficientTrain++入选TPAMI 2024近年来,「scaling」是计算机视觉研究的主角之一。随着模型尺寸和训练数据规模的增大、学习算法的进步以及正则化和数据增强等技术的广泛应用,通过大规模训练得到的视觉基础网络(如 ImageNet1K/22K 上训得的 Vision Transformer、MAE、DINOv2 等)已在视觉识别、目标检测、语义分割等诸多重要视觉任务上取得了令人惊艳的性能。