以人文本的 AI 品牌设计

以人文本的 AI 品牌设计传统科技公司、尤其是 2B 的公司,其信息、视觉传达都是以公司、产品、技术创新为中心的。但是,处在现代最前沿技术之一的 AI 公司,似乎想做一些不一样的传达。我们将近距离看一下 OpenAI,Cohere,Anthropic 这三家 AI 模型公司的信息、视觉传达,看看他们怎么是从传统科技公司的风格中,做出一些不一样的、以人为本的品牌设计的。

传统科技公司、尤其是 2B 的公司,其信息、视觉传达都是以公司、产品、技术创新为中心的。但是,处在现代最前沿技术之一的 AI 公司,似乎想做一些不一样的传达。我们将近距离看一下 OpenAI,Cohere,Anthropic 这三家 AI 模型公司的信息、视觉传达,看看他们怎么是从传统科技公司的风格中,做出一些不一样的、以人为本的品牌设计的。

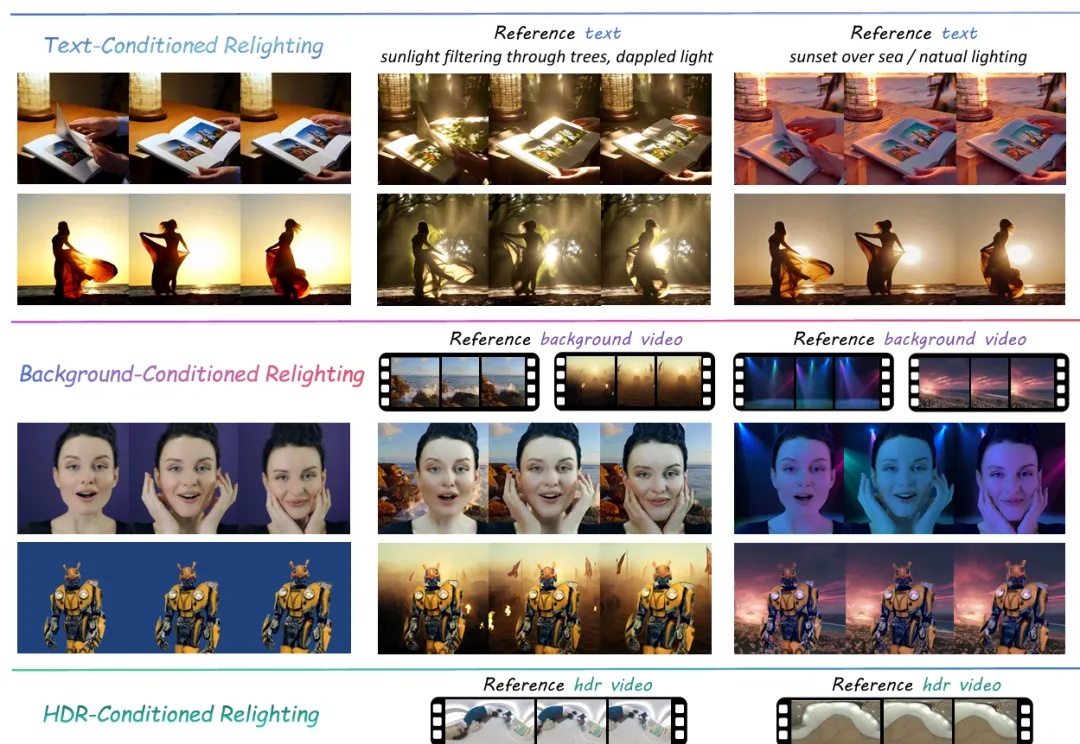

大家还记得那个 ICLR 2025 首次满分接收、彻底颠覆静态图像光照编辑的工作 IC-Light 吗?

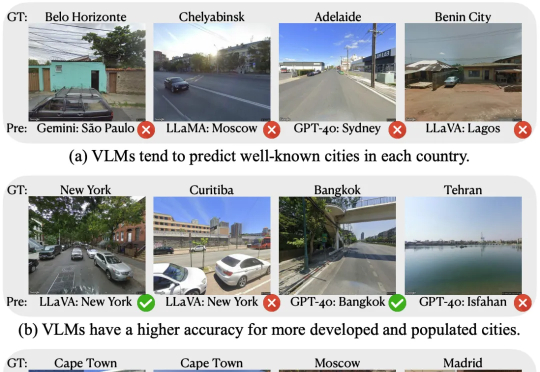

给AI一张全新的照片,它能以相当高的准确率还猜出照片在哪个城市拍摄的。在新研究中,表现最好的AI模型,猜出图片所在城市的正确率比人类高62.6%!以后网上晒图可要当心了,AI可能知道你在哪里!

MattoBoard,一家旨在简化室内设计师和建筑师创作过程的云端软件,正在进入人工智能领域。周二,这家初创公司宣布完成 200 万美元的种子融资,将支持推出一项名为 Design Stream 的新功能,这是一款基于人工智能的视觉搜索和发现工具。

12月30日,支付宝推出新一代AI视觉搜索产品“探一下”,基于自研的多模态大模型技术,可“用AI之眼探索万物”,提供更快速、有用、趣味的生成式搜索服务。

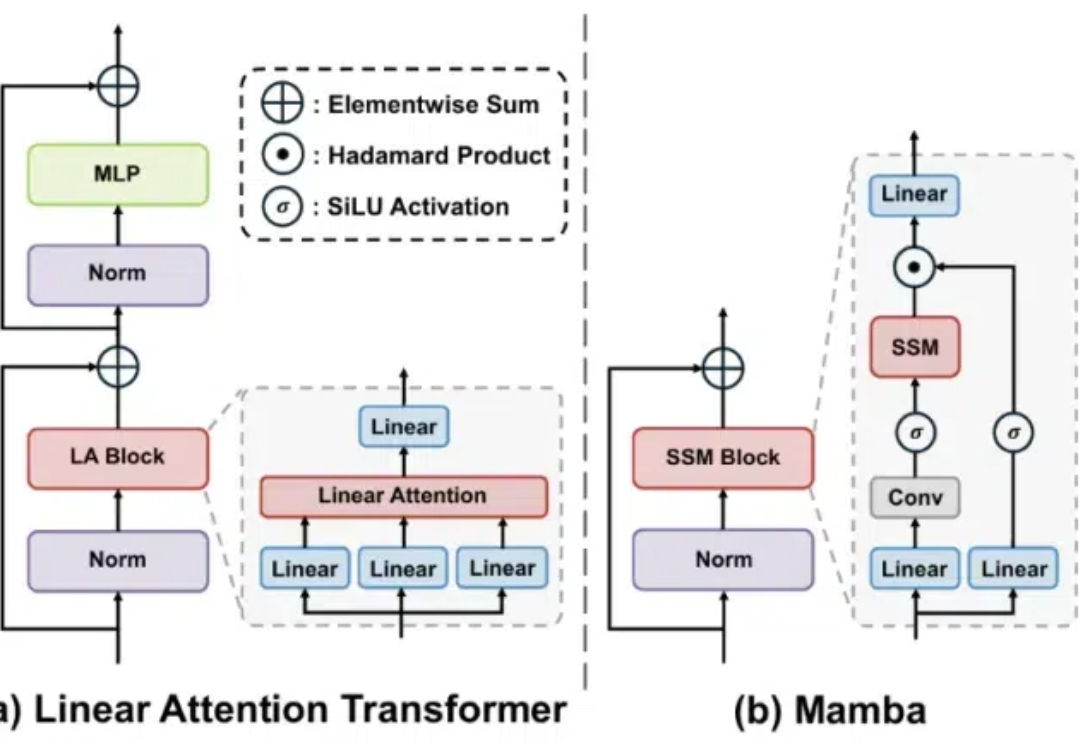

Mamba 是一种具有线性计算复杂度的状态空间模型,它能够以线性计算复杂度实现对输入序列的有效建模,在近几个月受到了广泛的关注。

生成式AI极大加速了AI应用的开发流程,从过去需要数月的周期缩短到仅需数天。这种变化推动了快速原型设计和实验的新模式,帮助开发者在短时间内尝试多种方案并专注于有效的解决方案,同时倡导“快速行动并负责任”的开发理念。

《智能涌现》获悉,美国硅谷AI视觉领域企业“Luma AI”近日完成新一轮融资,金额为9000万美元。《智能涌现》获悉,美国硅谷AI视觉领域企业“Luma AI”近日完成新一轮融资,金额为9000万美元。

计算机视觉(Computer Vision)的工作原理与人类视觉类似,但需要机器依靠摄像头、数据和算法在很短的时间内完成任务。

作为A股第一家AI计算机视觉上市公司,格灵深瞳在多个人工智能细分应用领域中较早完成了产品布局,目前尚处于产业化与市场拓展的发展阶段,未来能否在新应用领域实现业务拓展,将成为企业“生死存亡”的关键。