全新「多模态」生图AI文字渲染暴打Midjourney+DALL·E 3!5亿融资Karpathy都投了

全新「多模态」生图AI文字渲染暴打Midjourney+DALL·E 3!5亿融资Karpathy都投了Ideogram凭借不输Midjourney的生图能力和遥遥领先的图片中文字渲染能力,获得了包括Jeff Dean和Karpathy在内一众大佬的8000万美元融资,文生图这条离钱最近的AI赛道又加入了一名重量级选手。

Ideogram凭借不输Midjourney的生图能力和遥遥领先的图片中文字渲染能力,获得了包括Jeff Dean和Karpathy在内一众大佬的8000万美元融资,文生图这条离钱最近的AI赛道又加入了一名重量级选手。

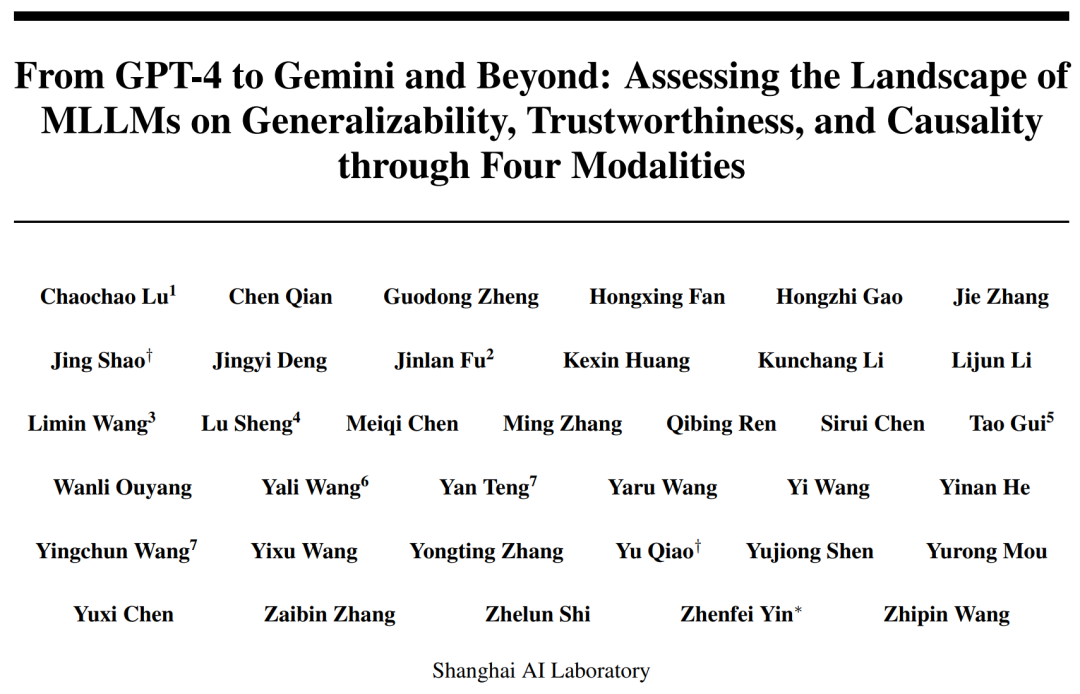

2023 年我们正见证着多模态大模型的跨越式发展,多模态大语言模型(MLLM)已经在文本、代码、图像、视频等多模态内容处理方面表现出了空前的能力,成为技术新浪潮。以 Llama 2,Mixtral 为代表的大语言模型(LLM),以 GPT-4、Gemini、LLaVA 为代表的多模态大语言模型跨越式发展。

All in AI的魅族,马上就带来具体新动作了。

本文提出了扩散模型中UNet的long skip connection的scaling操作可以有助于模型稳定训练的分析,目前已被NeurIPS 2023录用。同时,该分析还可以解释扩散模型中常用但未知原理的1/√2 scaling操作能加速训练的现象。

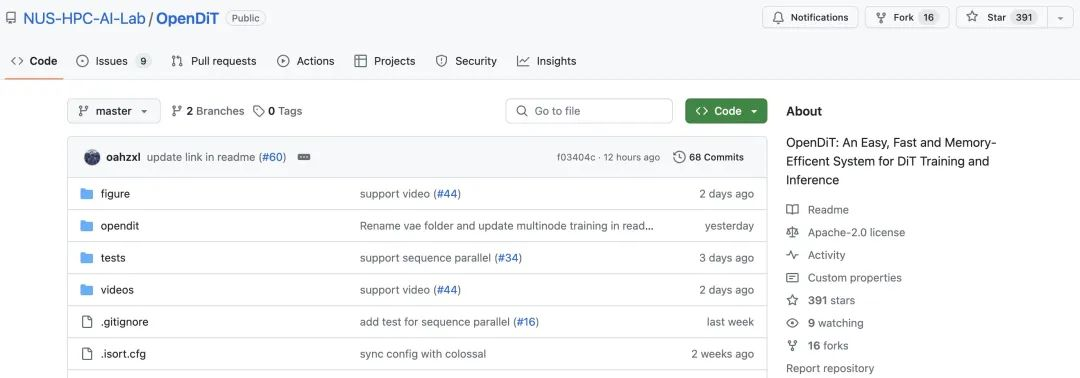

根据 OpenAI 披露的技术报告,Sora 的核心技术点之一是将视觉数据转化为 patch 的统一表征形式,并通过 Transformer 和扩散模型结合,展现了卓越的扩展(scale)特性。

成立仅9个月,法国Mistral AI拿出仅次于GPT-4的大模型。

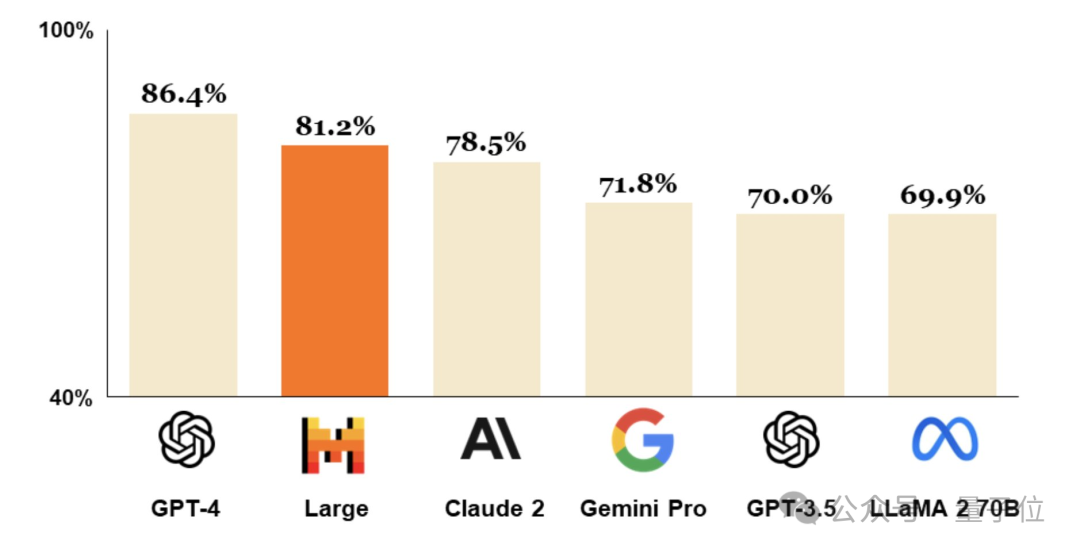

2月26日,总部位于巴黎的人工智能公司Mistral AI发布尖端文本生成模型Mistral Large。该模型达到了顶级的推理能力,可用于复杂的多语言推理任务,包括文本理解、转换和代码生成。

Reddit和OpenAI及谷歌,竟有着如此错综复杂的关系?最近,Reddit和谷歌双双官宣了一项6000万美元的合作协议,Reddit的数据将帮助谷歌训练AI模型。巧的是,Altman正是Reddit股东之一。

随着大语言模型(LLMs)在近年来取得显著进展,它们的能力日益增强,进而引发了一个关键的问题:如何确保他们与人类价值观对齐,从而避免潜在的社会负面影响?

大模型的成功很大程度上要归因于 Scaling Law 的存在,这一定律量化了模型性能与训练数据规模、模型架构等设计要素之间的关系,为模型开发、资源分配和选择合适的训练数据提供了宝贵的指导。