英伟达揭示RL Scaling魔力!训练步数翻倍=推理能力质变,小模型突破推理极限

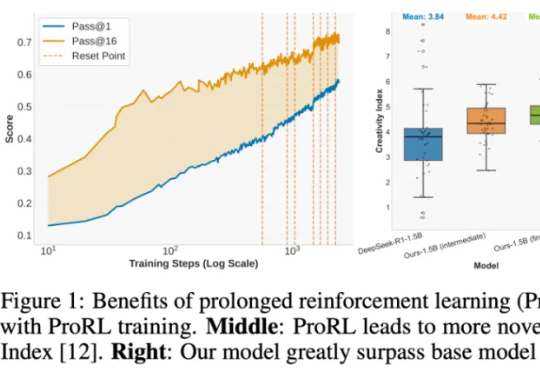

英伟达揭示RL Scaling魔力!训练步数翻倍=推理能力质变,小模型突破推理极限强化学习(RL)到底是语言模型能力进化的「发动机」,还是只是更努力地背题、换个方式答题?这个问题,学界争论已久:RL 真能让模型学会新的推理技能吗,还是只是提高了已有知识的调用效率?

强化学习(RL)到底是语言模型能力进化的「发动机」,还是只是更努力地背题、换个方式答题?这个问题,学界争论已久:RL 真能让模型学会新的推理技能吗,还是只是提高了已有知识的调用效率?

奥特曼抓马的宫斗大戏,这下真的成drama了

Z Potentials获悉,人形机器人公司「加速进化」今日已完成A 轮融资,由深创投集团领投,金鼎资本跟投,老股东源码资本、英诺天使基金、民银国际、彼岸时代持续加注,义柏资本担任长期独家财务顾问,资金将主要用于产品迭代升级和规模化量产交付。

AI 并非突然突破,而是一项长期投资,旨在改变企业运营模式,最终让复杂流程更智能。

数学家们一直痴迷于能够解决复杂数学问题的人工智能。OpenAI 等机构开发这些模型的部分开发者认为,学会解决数学难题的 AI 可以运用相似的推理方法来解决其他类型的问题。但由于当前的人工智能尚未证明能在高等数学领域超越人类专家,一些创业者看到了开发专业数学模型的机遇。

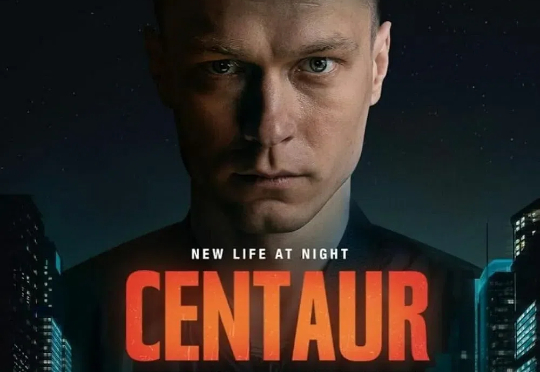

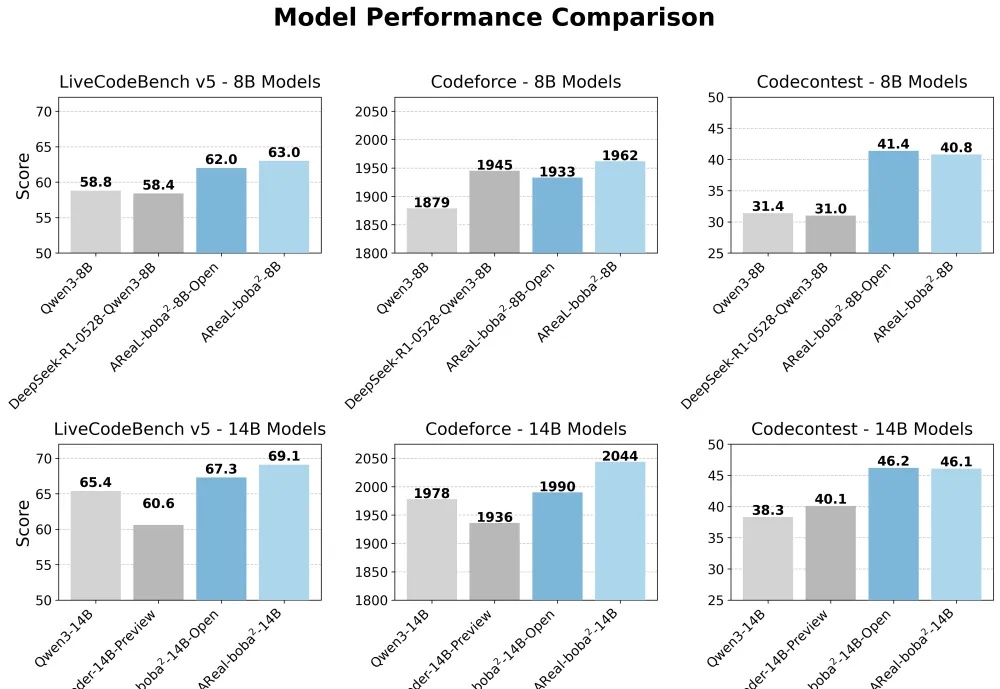

想训练属于自己的高性能推理模型,却被同步强化学习(RL)框架的低效率和高门槛劝退?AReaL 全面升级,更快,更强,更好用!

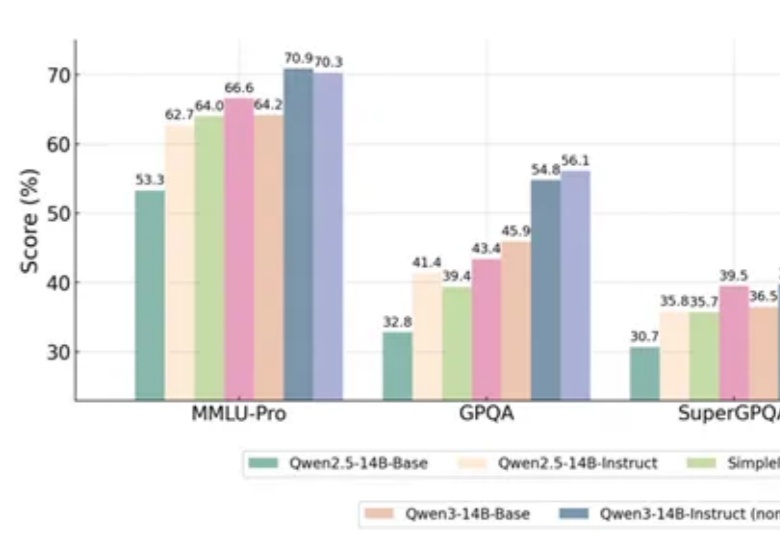

一项新的强化学习方法,直接让Qwen性能大增,GPT-4o被赶超!

最近AI圈子里有两个特别有意思的项目,一个是谷歌DeepMind的AlphaEvolve,另一个是UBC大学的Darwin Gödel Machine(简称DGM)。

首个专为ALLMs(音频大语言模型)设计的多维度可信度评估基准来了。

端午节前OpenAI发布了o3/o4-mini模型的Function Calling指南,这份指南可以说是目前网上最硬核权威的大模型函数调用实战手册,没有之一。