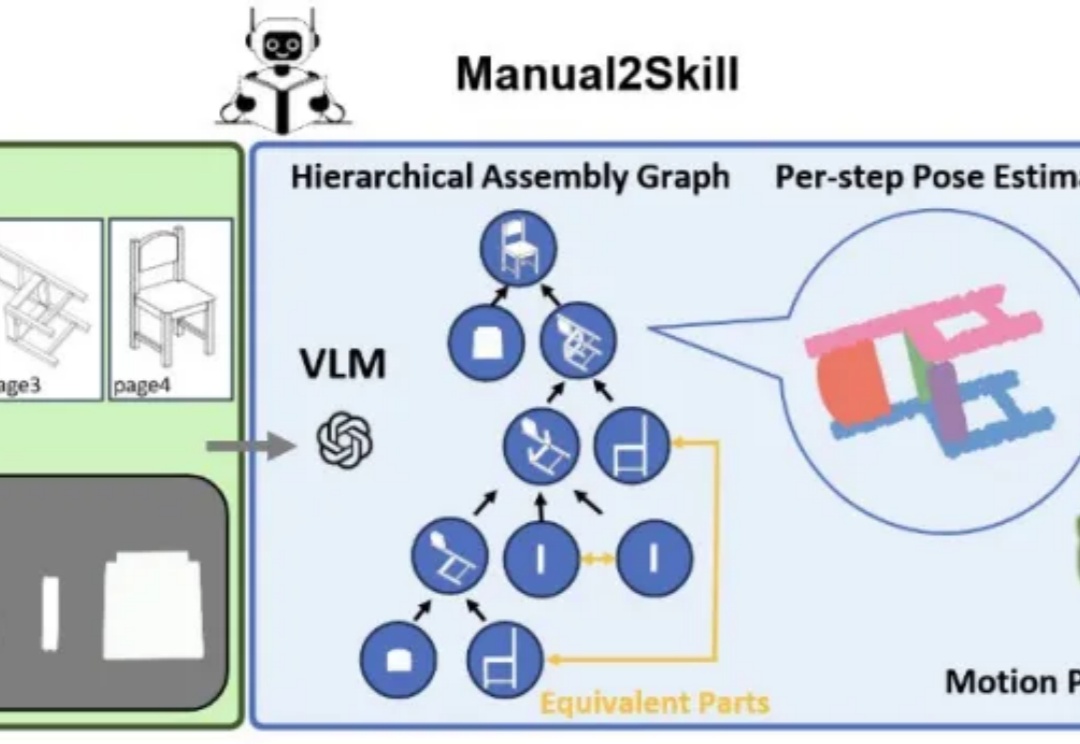

RSS 2025|从说明书学习复杂机器人操作任务:NUS邵林团队提出全新机器人装配技能学习框架Manual2Skill

RSS 2025|从说明书学习复杂机器人操作任务:NUS邵林团队提出全新机器人装配技能学习框架Manual2Skill视觉语言模型(Vision-Language Models, VLMs),为真实环境中的机器人操作任务提供了极具潜力的解决方案。

视觉语言模型(Vision-Language Models, VLMs),为真实环境中的机器人操作任务提供了极具潜力的解决方案。

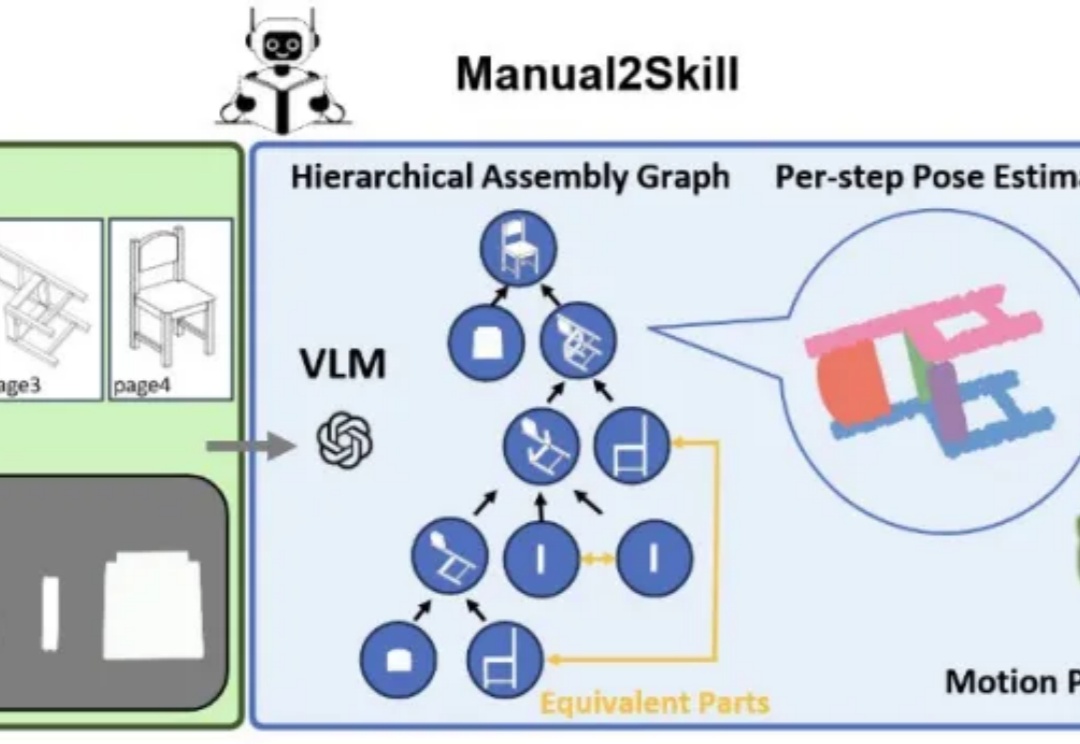

全球最贵估值科技公司,AI 巨头 Palantir 如何合理定价?

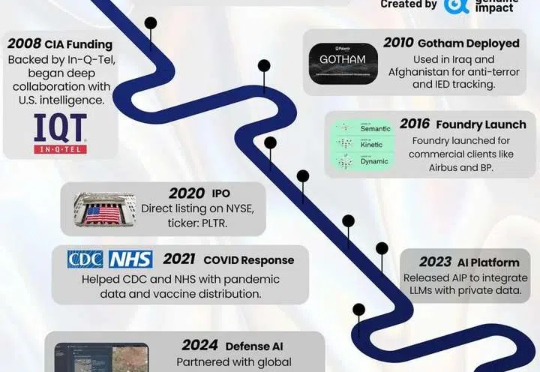

既当裁判员,又当运动员?

从OpenAI 的 4o 到 Stable Diffusion,能够根据文本提示生成逼真图像的 AI 基础模型如今已比比皆是。相比之下,能够仅凭文本提示就生成完整、连贯的 3D 在线环境的基础模型才刚刚崭露头角。

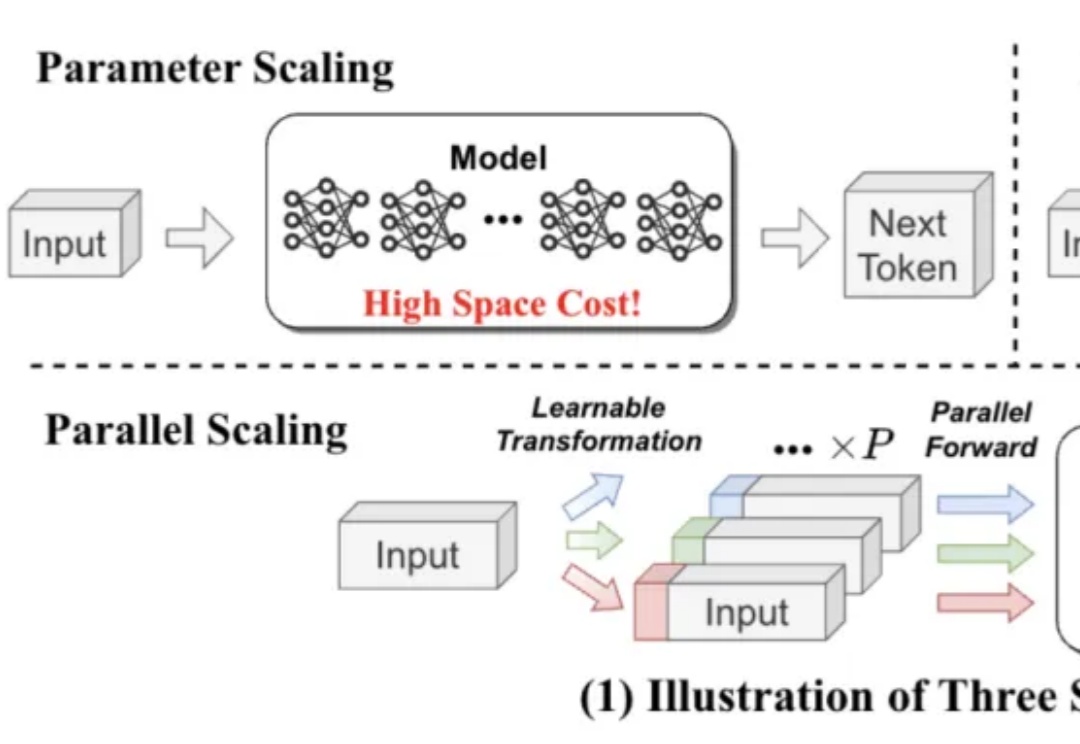

既能提升模型能力,又不显著增加内存和时间成本,LLM第三种Scaling Law被提出了。

本篇内容是「AGIX 投什么」系列的第 7 篇。AGIX 指数 从全球上千家科技上市公司中精选出的 40 家左右最能把握 AGI 价值整理的公司,AGIX 指数组合即是定位 AGI 进程的坐标,也能够为投资者捕捉 AI-alpha 提供价值工具。在「AGIX 投什么」板块,我们会对 AGIX Index 的组合公司进行深度分析,输出全面的 AI 投资参考。

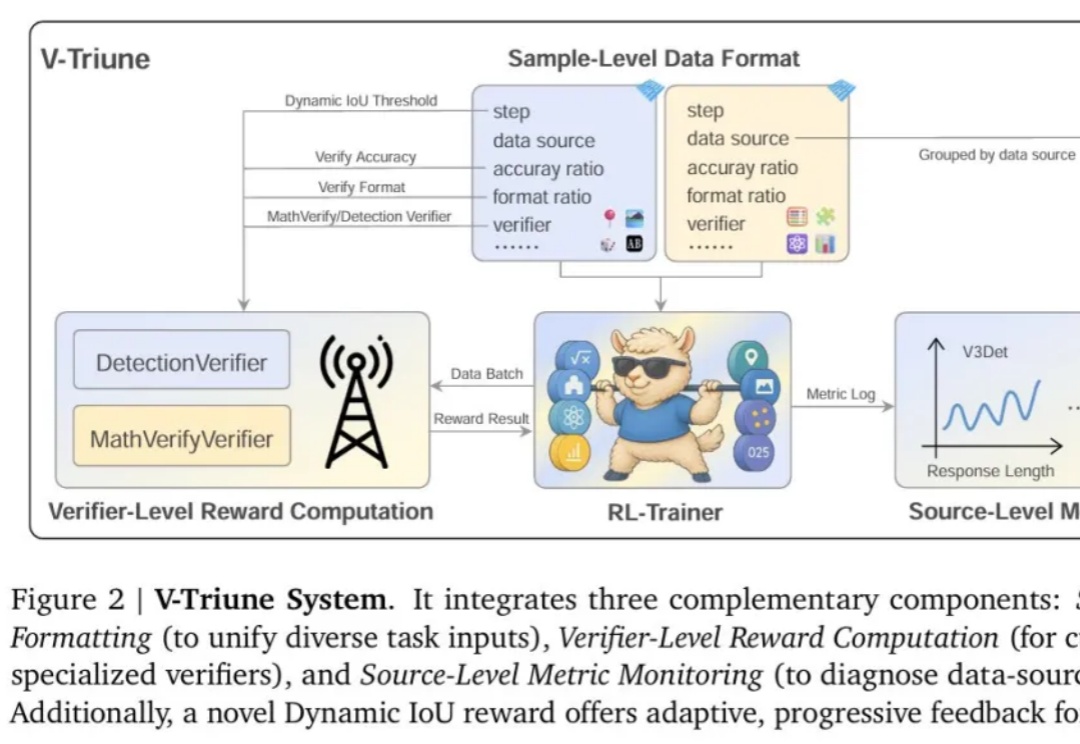

强化学习 (RL) 显著提升了视觉-语言模型 (VLM) 的推理能力。然而,RL 在推理任务之外的应用,尤其是在目标检测 和目标定位等感知密集型任务中的应用,仍有待深入探索。

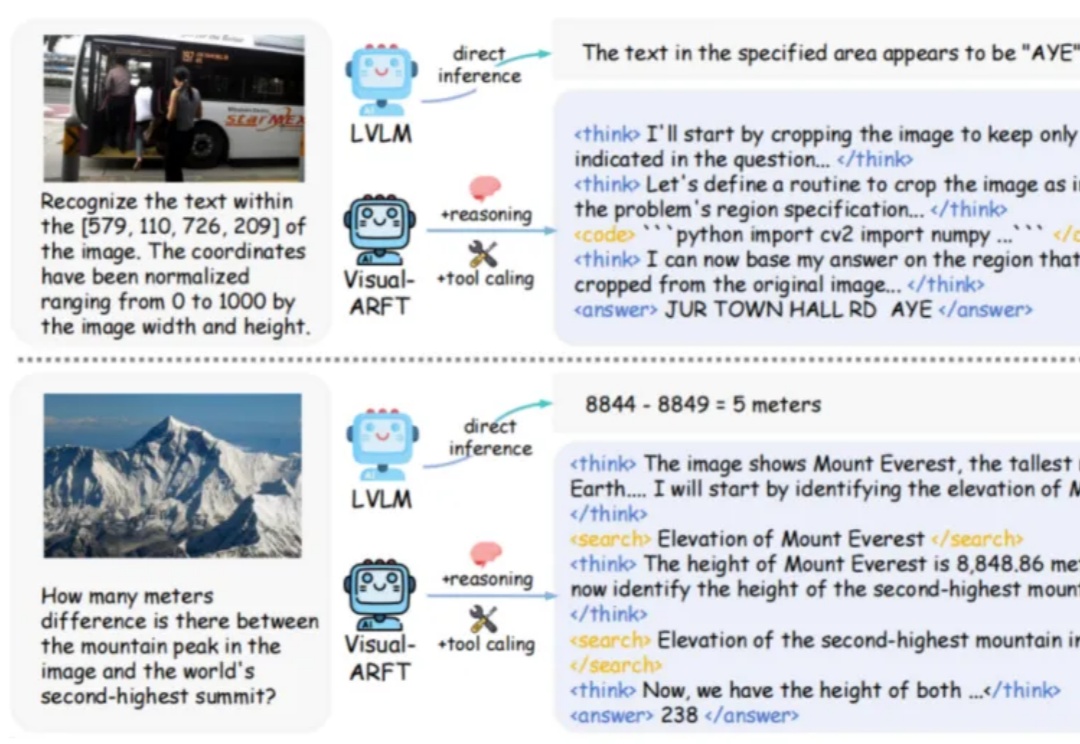

在大型推理模型(例如 OpenAI-o3)中,一个关键的发展趋势是让模型具备原生的智能体能力。具体来说,就是让模型能够调用外部工具(如网页浏览器)进行搜索,或编写/执行代码以操控图像,从而实现「图像中的思考」。

作为首批入选印度“IndiaAI Mission”国家级项目、承担构建印度主权基础大模型任务的公司之一,Sarvam AI 近日发布了名为 Sarvam-M 的模型。这是一个基于 Mistral Small 构建的 240 亿参数、权重开放的混合语言模型。

Character AI 是个不合时宜的故事,不再多聊。