AI女王强势归来!前OpenAI CTO的“思考机器”彻底开放!接入KimiK2、千问VL,一个样本让千问VLM识别新物种!

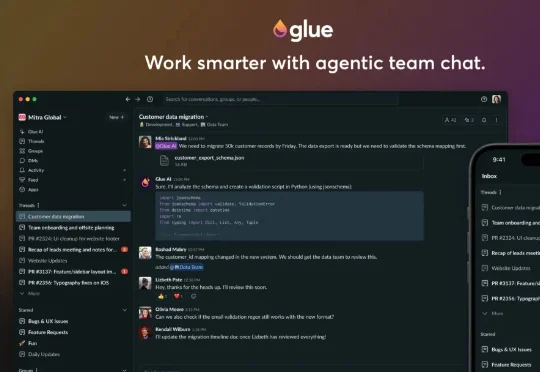

AI女王强势归来!前OpenAI CTO的“思考机器”彻底开放!接入KimiK2、千问VL,一个样本让千问VLM识别新物种!大家还记得Mira Murati吗?那个曾经主导ChatGPT开发的“AI女王”,OpenAI的前CTO,2024年突然离职后,让整个科技圈炸锅!短短几个月,融资20亿美元,估值飙到120亿美元,现在更传出新一轮融资目标直冲500亿美元!这速度,这手笔,简直是AI界的“神话”!而最近的重磅炸弹来了:他们的首款产品Tinker正式全面开放!不再需要等待名单,人人可用!