最佳开源模型刷新多项SOTA,首次超越Mixtral Instruct!「开源版GPT-4」家族迎来大爆发

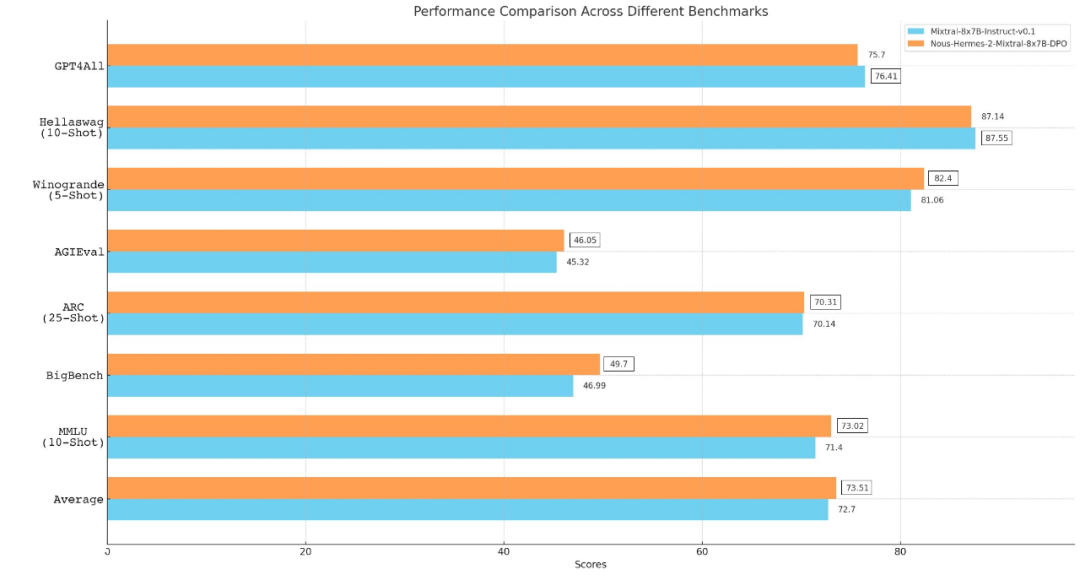

最佳开源模型刷新多项SOTA,首次超越Mixtral Instruct!「开源版GPT-4」家族迎来大爆发Mixtral 8x7B模型开源后,AI社区再次迎来一大波微调实践。来自Nous Research应用研究小组团队微调出新一代大模型Nous-Hermes 2 Mixtral 8x7B,在主流基准测试中击败了Mixtral Instruct。

Mixtral 8x7B模型开源后,AI社区再次迎来一大波微调实践。来自Nous Research应用研究小组团队微调出新一代大模型Nous-Hermes 2 Mixtral 8x7B,在主流基准测试中击败了Mixtral Instruct。

2023年做大模型,国内更关注的是云厂商,很少有人会注意到,硬件厂商的大模型做得怎么样。

用剪枝的方式加速AI训练,也能实现无损操作了,只要三行代码就能完成!今年的深度学习顶会ICLR上,新加坡国立大学尤洋教授团队的一项成果被收录为Oral论文。

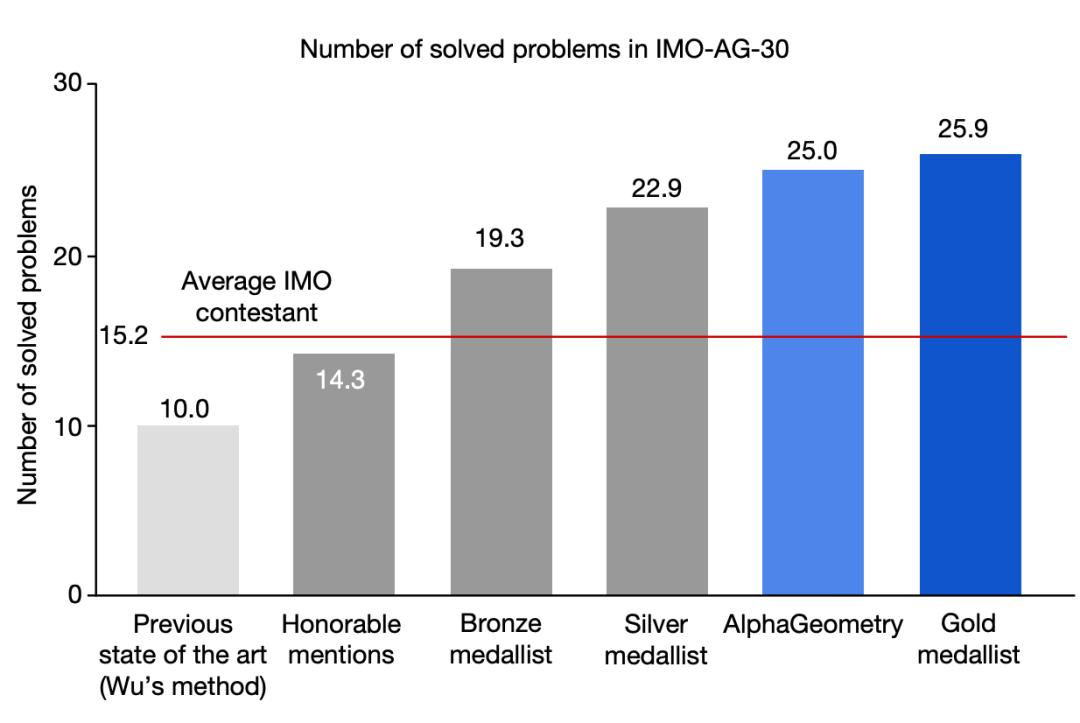

今天,谷歌DeepMind的AlphaGeometry模型登上了Nature!30道IMO几何题中,它能做出25道,已经接近人类金牌选手的水平!而GPT-4,却一道题都没做出来,直接挂了零蛋。

Altman在达沃斯论坛上表示,AGI不远了,因为技术的发展是指数级的,但是人类不用过于担心会被AI所取代,而未来限制AI发展的关键因素是能源。

无需人类演示,即可自主应对复杂的几何学挑战。水平接近人类金牌选手,人工智能(AI)学会做国际数学奥林匹克竞赛难题了。

从 Llama、Llama 2 到 Mixtral 8x7B,开源模型的性能记录一直在被刷新。由于 Mistral 8x7B 在大多数基准测试中都优于 Llama 2 70B 和 GPT-3.5,因此它也被认为是一种「非常接近 GPT-4」的开源选项。

2023年,有超过10家AI初创公司接受了传统科技巨头的大额投资,不断建立并且强化了微软—OpenAI式的合作关系,甚至引发了英美两国的监管机构的关注。

在自然语言处理(Natural Language Processing,NLP)领域,Transformer 模型因其在序列建模中的卓越性能而受到广泛关注。

IMF在报告中写到,人工智能技术将会进一步加剧不同国家之间、不同收入阶层之间的贫富差距。IMF主席克里斯塔利娜·格奥尔基耶娃(Kristalina Georgieva)在文章中表示:“在大多数情况下,人工智能可能会加剧整体不平等。这是一个令人不安的趋势,政策制定者必须积极应对,以防止这项技术进一步加剧社会紧张局势。”