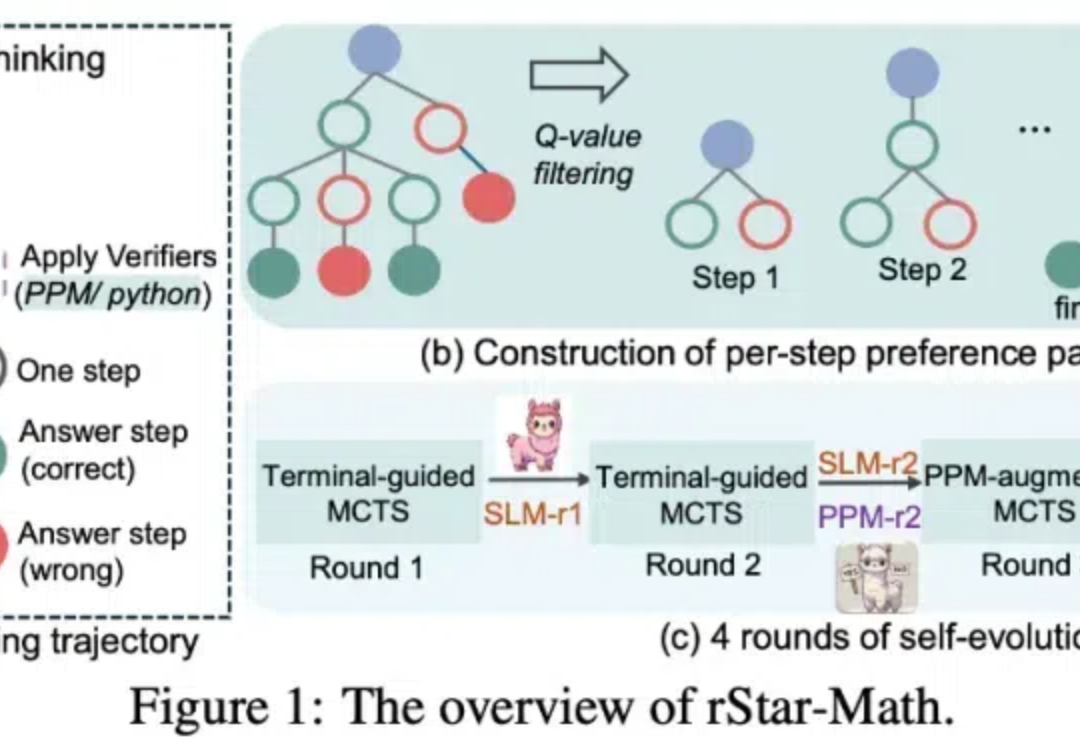

让7B千问模型超越o1,微软rStar-Math惊艳登场,网友盛赞

让7B千问模型超越o1,微软rStar-Math惊艳登场,网友盛赞OpenAI o1 给大模型规模扩展 vs 性能的曲线带来了一次上翘。它在大模型领域重现了当年 AlphaGo 强化学习的成功 —— 给越多算力,就输出越多智能,一直到超越人类水平。

OpenAI o1 给大模型规模扩展 vs 性能的曲线带来了一次上翘。它在大模型领域重现了当年 AlphaGo 强化学习的成功 —— 给越多算力,就输出越多智能,一直到超越人类水平。

这就是 Google DeepMind 的「DeepMind 部分」——重视它,是保护它的第一步。

自我博弈,很神奇吧?

复刻OpenAI o1推理大模型,开源界传来最新进展: LLaMA版o1项目刚刚发布,来自上海AI Lab团队。

从 AlphaGo、AlphaZero 、MuZero 到 AlphaCode、AlphaTensor,再到最近的 Gemini 和 AlphaProof,Julian Schrittwieser 的工作成果似乎比他的名字更广为人知。

自从 OpenAI 的 o1 问世以来,它强大的推理能力就承包了 AI 圈近期的热搜。不需要专门训练,它就能直接拿下数学奥赛金牌,甚至可以在博士级别的科学问答环节上超越人类专家。

OpenAI o1 在数学、代码、长程规划等问题取得显著的进步。一部分业内人士分析其原因是由于构建足够庞大的逻辑数据集 <问题,明确的正确答案> ,再加上类似 AlphaGo 中 MCTS 和 RL 的方法直接搜索,只要提供足够的计算量用于搜索,总可以搜到最后的正确路径。然而,这样只是建立起问题和答案之间的更好的联系,如何泛化到更复杂的问题场景,技术远不止这么简单。

语言模型的 AlphaGo 时刻?

当一家人工智能公司的首席执行官更像是计算机科学家而不是推销员时,我感觉更舒服

RLHF到底是不是强化学习?最近,AI大佬圈因为这个讨论炸锅了。和LeCun同为质疑派的Karpathy表示:比起那种让AlphaGo在围棋中击败人类的强化学习,RLHF还差得远呢。