从入门到用好 Agent Skills,看这一篇就足够了

从入门到用好 Agent Skills,看这一篇就足够了Claude Skill 很火,甚至已经超越 MCP 了,如今各家的 cli 客户端基本也都支持,扣子、MiniMax 的 agent 产品也都上架了类 Skill 的产品。而且不仅仅是对普通用户有用,从开发者视角来看,通用 Agent 内核,只靠 Skills 设计,也能低成本创造具有通用 AI 智能上限的垂直 Agent 应用。

Claude Skill 很火,甚至已经超越 MCP 了,如今各家的 cli 客户端基本也都支持,扣子、MiniMax 的 agent 产品也都上架了类 Skill 的产品。而且不仅仅是对普通用户有用,从开发者视角来看,通用 Agent 内核,只靠 Skills 设计,也能低成本创造具有通用 AI 智能上限的垂直 Agent 应用。

这两天都在研究 ralph,一个你睡觉时,都能不眠不休替你干需求、榨干任何 Coding Agent 的工具。

数据库技术初创公司ClickHouse 在新一轮融资中筹集了 4 亿美元,公司估值达到 150 亿美元——比不到一年前的估值翻了一番以上。这笔大规模融资传递出投资者对人工智能应用支撑型企业的青睐信号,这类企业正与Databricks 和 Snowflake 等公司展开竞争。

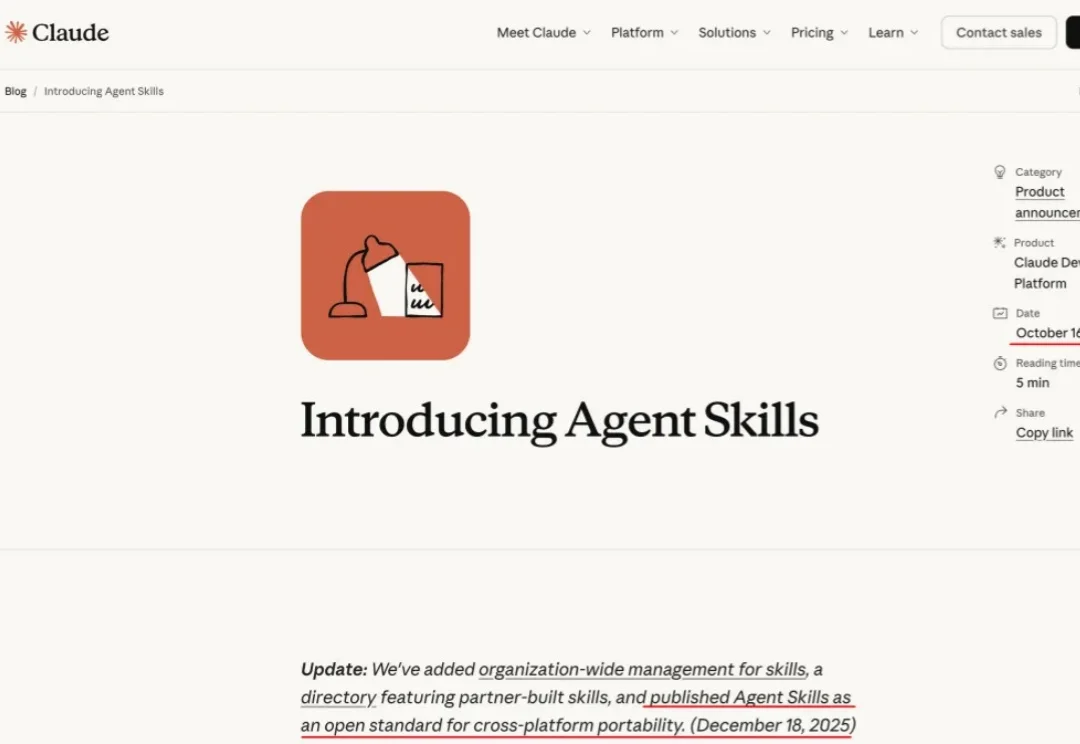

视觉模型用于工业“缺陷检测”等领域已经相对成熟,但当前普遍使用的传统模型在训练时对数据要求较高,需要大量的经过精细标注的数据才能训练出理想效果。

清华大学智能产业研究院(AIR)联合清华大学生命学院、清华大学化学系在Science上发表论文:《深度对比学习实现基因组级别药物虚拟筛选》。团队研发了一个AI驱动的超高通量药物虚拟筛选平台DrugCLIP。

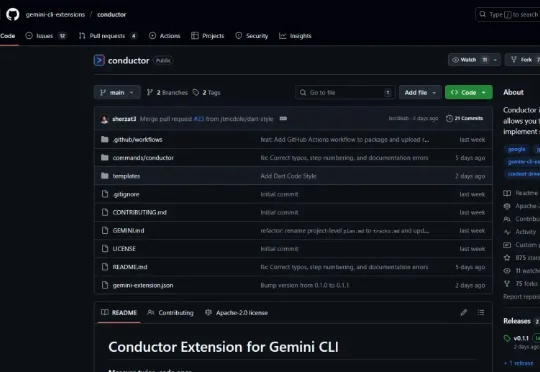

大家好,我是鲁工。 长期以来,Gemini CLI在与Claude Code等AI编程工具竞争时都面临劣势。 随着上个月Gemini 3 Pro发布,谷歌同时也推出了全新的AI编程IDE Antigr

面对苍白的CLI终端界面,有些深度依赖IDE的使用者,用Claude Code还是会不习惯的。于是我找了蛮多的资料,看看有没有适合新手的GUI工具。

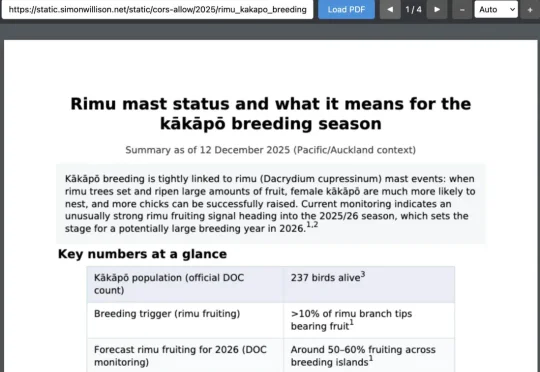

还在争论Skills是不是prompt?已经可以停下火了。因为,刚刚得到的消息消息,OpenAI已经悄悄地用上了Skills了。今天,知名博主、Django Web 框架联合创始人Simon Willson爆料:

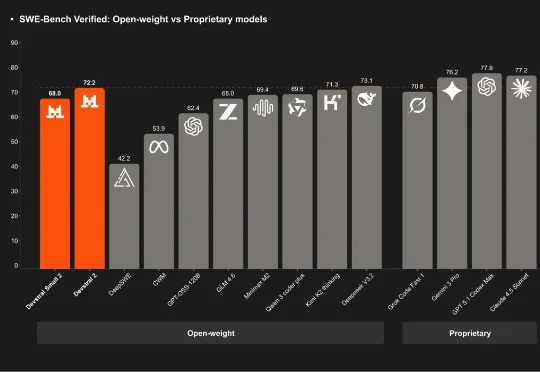

刚刚,「欧洲的 DeepSeek」Mistral AI 再次开源,发布了其下一代代码模型系列:Devstral 2。该系列开源模型包含两个尺寸:Devstral 2 (123B) 和 Devstral Small 2 (24B)。用户目前也可通过官方的 API 免费使用它们。

随着大语言模型与开发工具链的深度融合,命令行终端正被重塑为开发者的AI协作界面。本文以 Google gemini-cli 为范本,通过源码解构,系统性分析其 Agent 内核、ReAct 工作流、工具调用与上下文管理等核心模块的实现原理。为希望构建终端 Agent 的开发者,提供工程实现的系统化参考。