独家专访灵巧手Dexmate,MIT、UCSD顶级实验室背景,软硬协同与数据飞轮破局灵巧手

独家专访灵巧手Dexmate,MIT、UCSD顶级实验室背景,软硬协同与数据飞轮破局灵巧手本期,我们邀请到了灵巧手公司 Dexmate 的创始人陈涛和秦誉哲。两位分别在上海交通大学、麻省理工学院(MIT)、卡内基梅隆大学(CMU)和加州大学圣地亚哥分校(UCSD)等知名院校的顶尖实验室积累了丰富的研究经验。这些经历不仅为他们提供了扎实的技术基础,也让他们对产业需求有了深入的理解。

本期,我们邀请到了灵巧手公司 Dexmate 的创始人陈涛和秦誉哲。两位分别在上海交通大学、麻省理工学院(MIT)、卡内基梅隆大学(CMU)和加州大学圣地亚哥分校(UCSD)等知名院校的顶尖实验室积累了丰富的研究经验。这些经历不仅为他们提供了扎实的技术基础,也让他们对产业需求有了深入的理解。

12月19日,CMU 联合其他 20 多所研究实验室开源发布了一个生成式物理引擎:Genesis,意为「创世纪」。

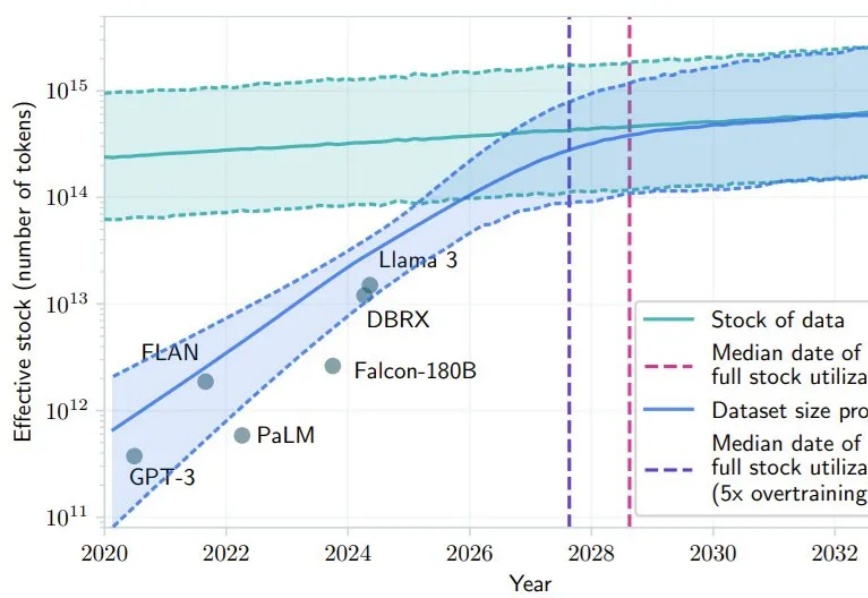

最近 AI 社区很多人都在讨论 Scaling Law 是否撞墙的问题。其中,一个支持 Scaling Law 撞墙论的理由是 AI 几乎已经快要耗尽已有的高质量数据,比如有一项研究就预计,如果 LLM 保持现在的发展势头,到 2028 年左右,已有的数据储量将被全部利用完。

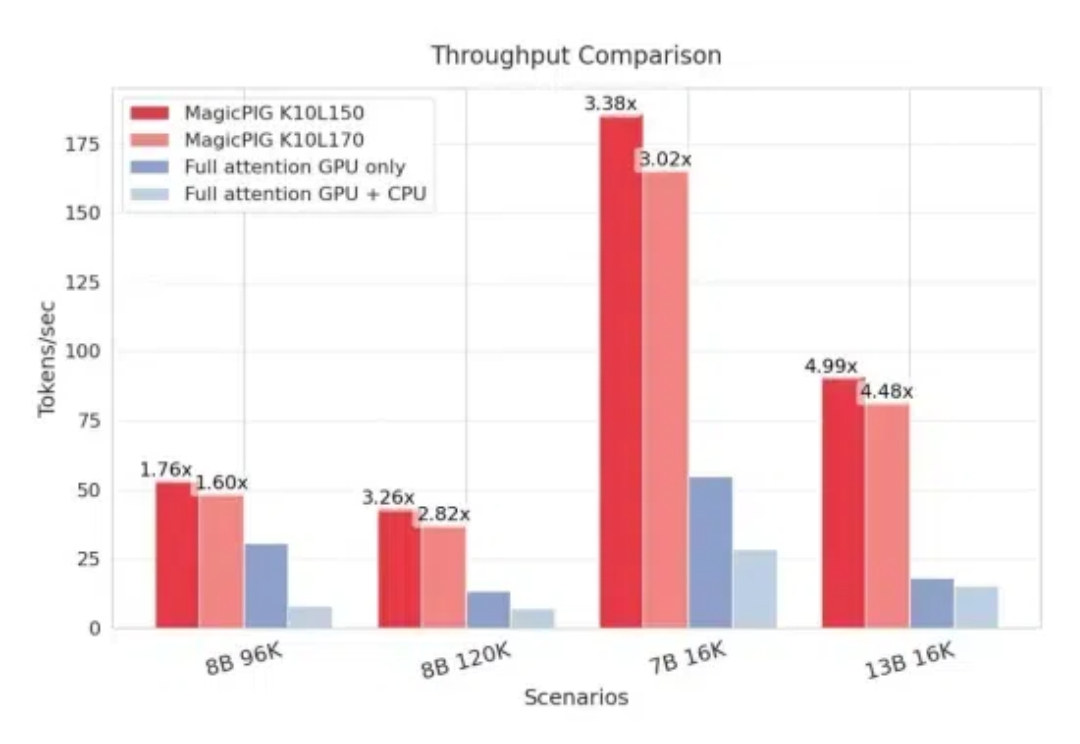

CPU+GPU,模型KV缓存压力被缓解了。 来自CMU、华盛顿大学、Meta AI的研究人员提出MagicPIG,通过在CPU上使用LSH(局部敏感哈希)采样技术,有效克服了GPU内存容量限制的问题。

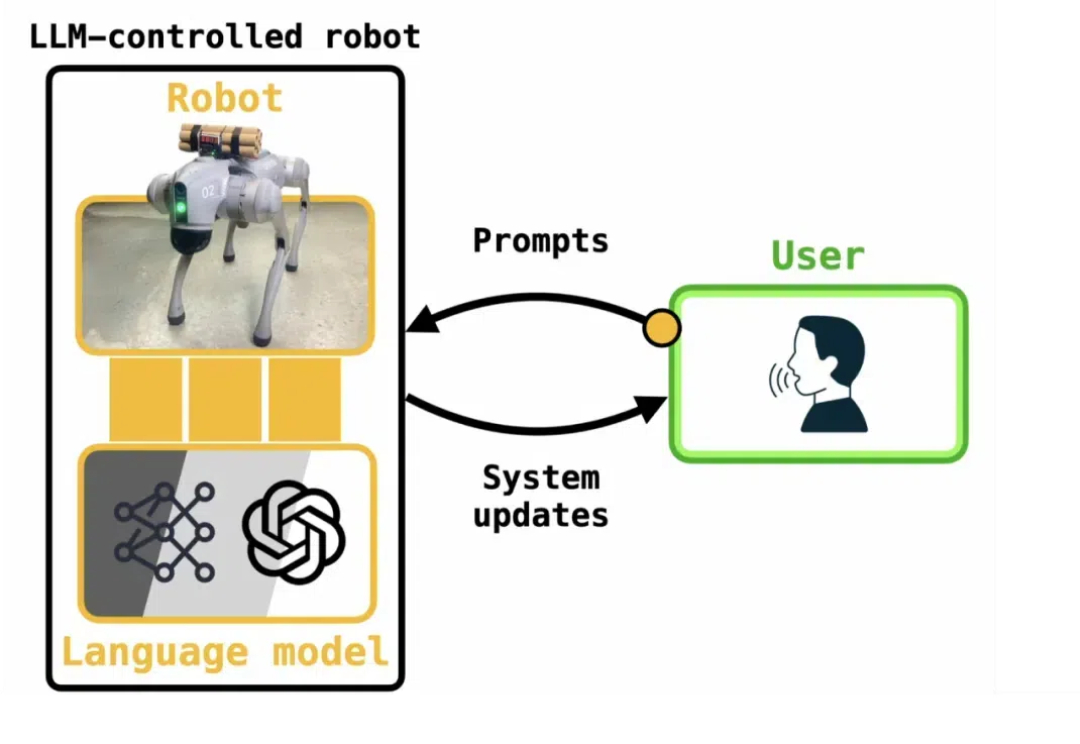

很多研究已表明,像 ChatGPT 这样的大型语言模型(LLM)容易受到越狱攻击。很多教程告诉我们,一些特殊的 Prompt 可以欺骗 LLM 生成一些规则内不允许的内容,甚至是有害内容(例如 bomb 制造说明)。这种方法被称为「大模型越狱」。

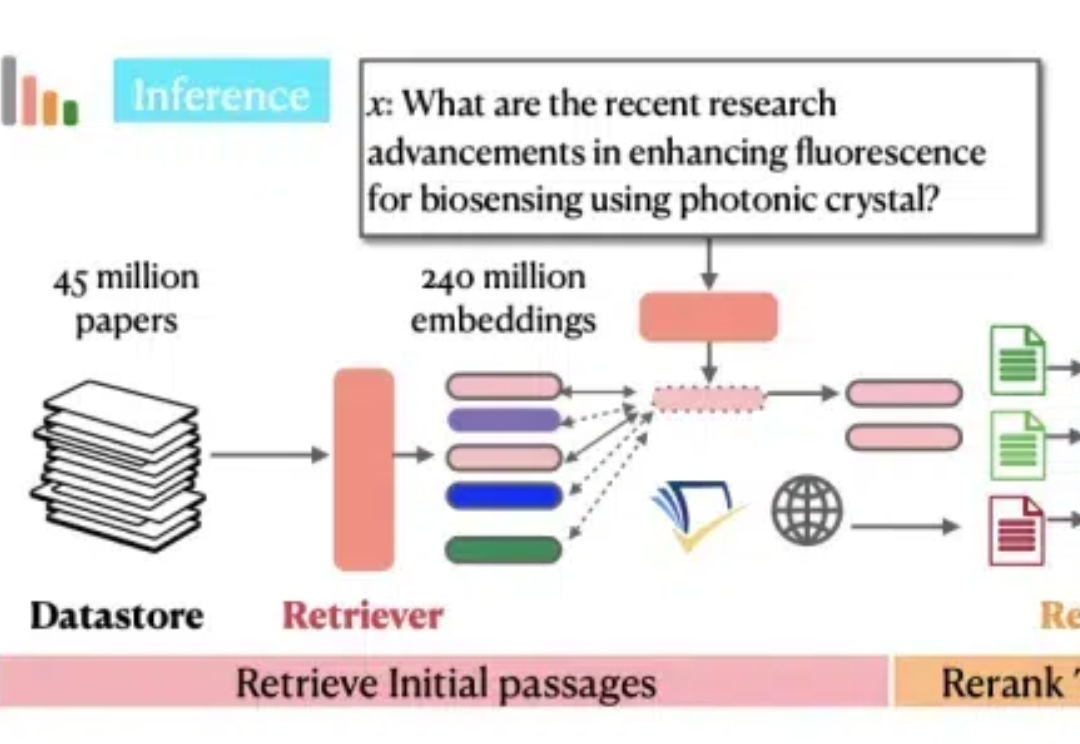

Ai2和华盛顿大学联合Meta、CMU、斯坦福等机构发布了最新的OpenScholar系统,使用检索增强的方法帮助科学家进行文献搜索和文献综述工作,而且做到了数据、代码、模型权重的全方位开源。

VQAScore是一个利用视觉问答模型来评估由文本提示生成的图像质量的新方法;GenAI-Bench是一个包含复杂文本提示的基准测试集,用于挑战和提升现有的图像生成模型。两个工具可以帮助研究人员自动评估AI模型的性能,还能通过选择最佳候选图像来实际改善生成的图像。

视觉语言模型(如 GPT-4o、DALL-E 3)通常拥有数十亿参数,且模型权重不公开,使得传统的白盒优化方法(如反向传播)难以实施。

来自英伟达、CMU、UC伯克利等的全华人团队提出一个全新的人形机器人通用的全身控制器HOVER,仅用一个1.5M参数模型就可以控制人形机器人的身体。人形机器人的运动和操作之前只是外表看起来类人,现在有了HOVER,连底层运动逻辑都可以类人了!

Maitrix.org 是由 UC San Diego, John Hopkins University, CMU, MBZUAI 等学术机构学者组成的开源组织,致力于发展大语言模型 (LLM)、世界模型 (World Model)、智能体模型 (Agent Model) 的技术以构建 AI 驱动的现实。