强迫模型自我争论,递归思考版CoT热度飙升!网友:这不就是大多数推理模型的套路吗?

强迫模型自我争论,递归思考版CoT热度飙升!网友:这不就是大多数推理模型的套路吗?递归思考 + 自我批判,CoRT 能带来 LLM 推理力的飞跃吗?

递归思考 + 自我批判,CoRT 能带来 LLM 推理力的飞跃吗?

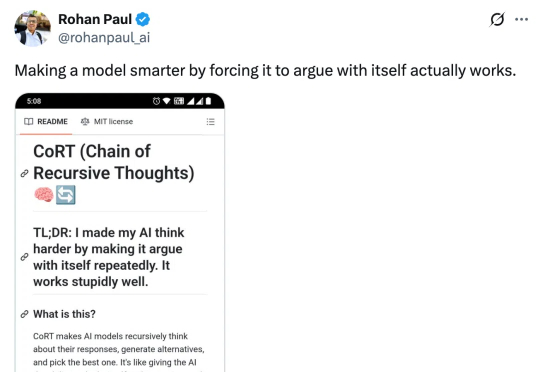

多模态奖励模型(MRMs)在提升多模态大语言模型(MLLMs)的表现中起着至关重要的作用,在训练阶段可以提供稳定的 reward,评估阶段可以选择更好的 sample 结果,甚至单独作为 evaluator。

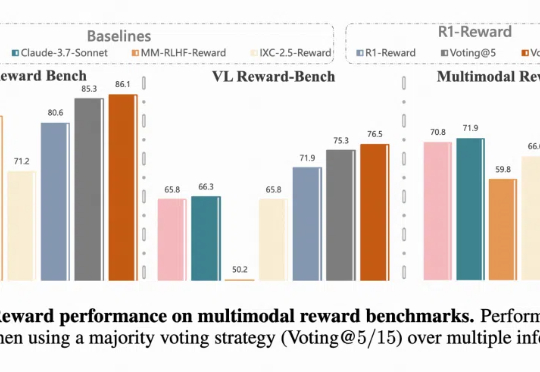

近年来,「思维链(Chain of Thought,CoT)」成为大模型推理的显学,但要让小模型也拥有长链推理能力却非易事。

最近,DeepSeek-R1 和 OpenAI o1/03 等推理大模型在后训练阶段探索了长度扩展(length scaling),通过强化学习(比如 PPO、GPRO)训练模型生成很长的推理链(CoT),并在奥数等高难度推理任务上取得了显著的效果提升。

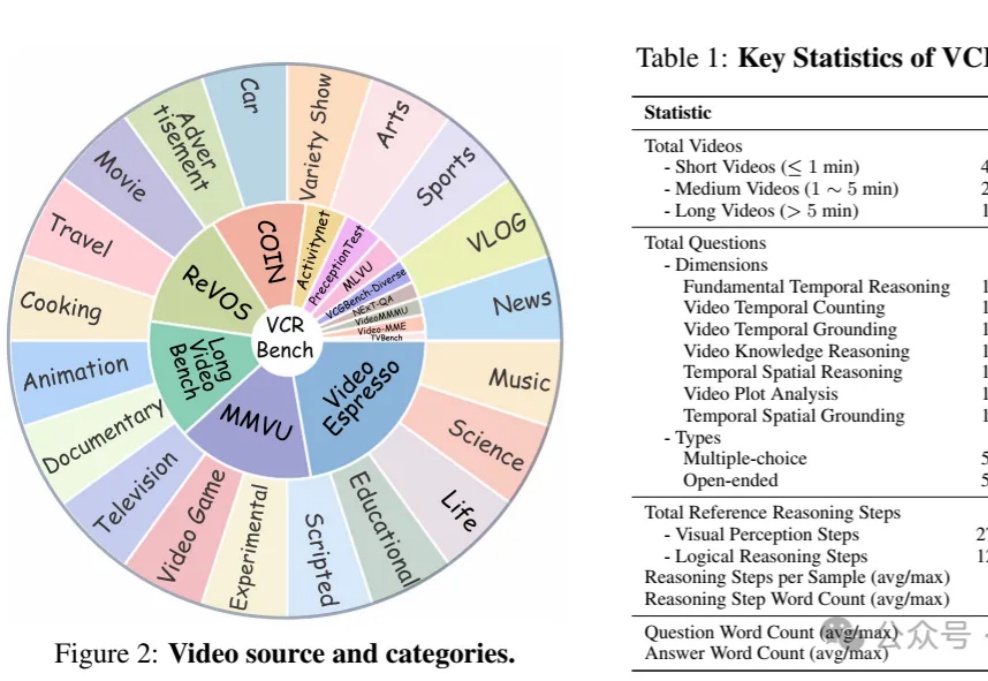

视频理解的CoT推理能力,怎么评?

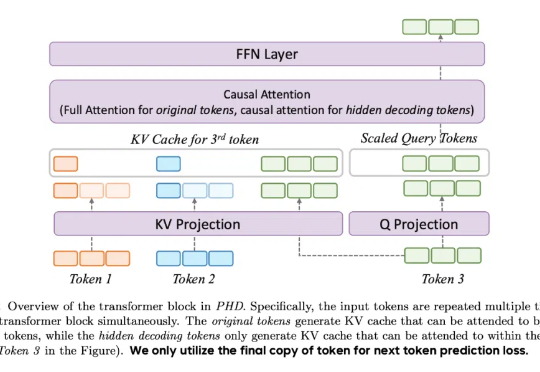

近年来,大模型(Large Language Models, LLMs)在数学、编程等复杂任务上取得突破,OpenAI-o1、DeepSeek-R1 等推理大模型(Reasoning Large Language Models,RLLMs)表现尤为亮眼。但它们为何如此强大呢?

科技媒体 maginative 今天(4 月 16 日)发布博文,报道称 OpenAI 宣布收购 Context.ai团队,后者是一家由 GV 支持的初创公司,以评估和分析 AI 模型见长。Context.ai的联合创始人 Henry Scott-Green(首席执行官)和 Alex Gamble(首席技术官)将加入 OpenAI,专注于研发模型评估工具。

早在去年10月底IBM推出了PDL声明式提示编程语言,本篇是基于PDL的一种对Agent的自动优化方法,是工业界前沿的解决方案。当你在开发基于大语言模型的Agent产品时,是否曾经在提示模式选择和优化上浪费了大量时间?在各种提示模式(Zero-Shot、CoT、ReAct、ReWOO等)中选择最佳方案,再逐字斟酌提示内容,这一过程不仅耗时,而且常常依赖经验和直觉而非数据驱动的决策。

AI绘画总「翻车」,不是抓不住重点,就是细节崩坏?别愁!微软和港中文学者带来ImageGen-CoT技术,让AI像人一样思考推理,生成超惊艳画作,性能提升高达80%。

今年早些时候, 尿布电商品牌 Coterie 的员工注意到顾客来自一个有趣的新来源——ChatGPT。