登顶SuperCLUE DeepSearch,openPangu-R-72B深度搜索能力跃升

登顶SuperCLUE DeepSearch,openPangu-R-72B深度搜索能力跃升近日,第三方评测机构 SuperCLUE 发布 11 月 DeepSearch 评测报告,国产大模型 openPangu-R-72B 凭借在长链推理、复杂信息检索领域的卓越表现,在模型榜单中名列第一,体现了基于国产昇腾算力的大模型研发实力。

近日,第三方评测机构 SuperCLUE 发布 11 月 DeepSearch 评测报告,国产大模型 openPangu-R-72B 凭借在长链推理、复杂信息检索领域的卓越表现,在模型榜单中名列第一,体现了基于国产昇腾算力的大模型研发实力。

奥特曼又得拉响红色警报了。刚刚,谷歌再次扔出重磅炸弹——Gemini 3 Deep Think正式上线!轻松把草图变成逼真3D场景,不仅结构还原到位,就连镂空花纹与光影都处理得明明白白。

DeepWisdom研究团队提出:视频生成模型不仅能画画,更能推理。 为了验证这一观点,团队推出了VR-Bench——这是首个通过迷宫任务评估视频模型空间推理(spatial reasoning)能力的基准测试

太劲爆了!不过半月,谷歌DeepMind终于放出了IMO最强金牌模型——Gemini 3 Deep Think。今天,Gemini 3 Deep Think已在Gemini App上线,所有Ultra用户即可体验。

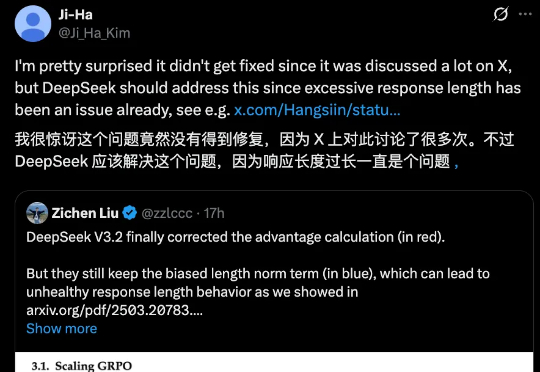

DeepSeek 一发布模型,总会引起业内的高度关注与广泛讨论,但也不可避免的暴露出一些小 Bug。

昨日,有位推特博主晒出了国内几大开源模型在轻量级软件工程 Agent 基准测试 mini-SWE-agent 上的成绩。该基准主要测试大模型在真实软件开发任务中的多步推理、环境交互和工程化能力。

DeepSeek V3.2的Agentic能力大增,离不开这项关键机制:Interleaved Thinking(交错思维链)。Interleaved Thinking风靡开源社区背后,离不开另一家中国公司的推动。

就在前天,DeepSeek 一口气上新了两个新模型,DeepSeek-V3.2 和 DeepSeek-V3.2-Speciale。

中美正忙着堆算力打AI战,欧洲却突然杀出一条血路:模型落地更重要!Mistral一口气扔出Large 3和Ministral 3,全开源、能看图、能跑在大多数电子设备上,甚至断网也能用。未来,AI是巨头的专属权力,还是人人都能握在手中的智能?这一次,欧洲给出了自己的答案。

DeepSeek-V3.2很强很火爆,但随着讨论的深入,还是有bug被发现了。 并且是个老问题:浪费token。不少网友都提到,DeepSeek-V3.2的长思考增强版Speciale,确确实实以开源之姿又给闭源TOP们上了压力,但问题也很明显: