谷歌深夜放出「创世引擎」Genie 3!一句话秒生宇宙,终极模拟器觉醒

谷歌深夜放出「创世引擎」Genie 3!一句话秒生宇宙,终极模拟器觉醒老黄曾预言,每个像素都将由AI生成!刚刚,谷歌DeepMind放出的「通用世界模型」Genie 3,一句话即生720p实时模拟世界,1分钟视觉记忆一致性超高。刚刚,谷歌DeepMind祭出新一代通用世界模型——Genie 3,能模拟出史无前例的丰富交互环境。

老黄曾预言,每个像素都将由AI生成!刚刚,谷歌DeepMind放出的「通用世界模型」Genie 3,一句话即生720p实时模拟世界,1分钟视觉记忆一致性超高。刚刚,谷歌DeepMind祭出新一代通用世界模型——Genie 3,能模拟出史无前例的丰富交互环境。

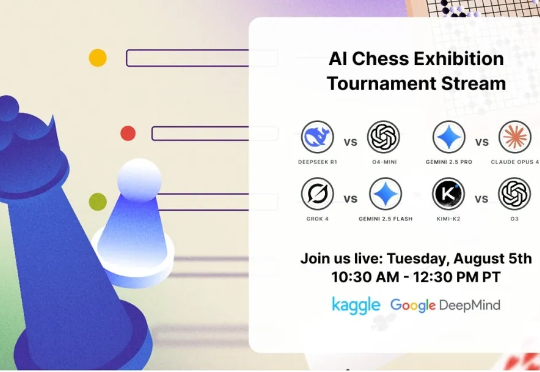

一场激动人心的 AI 国际象棋比赛即将开幕。 看够了研究者们天天在论文上刷新基准,是时候拉模型出来遛一遛,性能是不是真如传说中的碾压全场?

成立仅一年的初创公司Reflection AI 正洽谈融资逾 10 亿美元,用于开发开源大语言模型,与中国深度求索(DeepSeek)、法国 Mistral 及美国 Meta 等企业展开竞争。

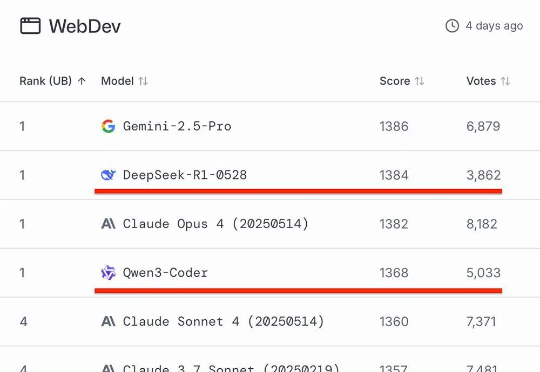

知名AI大模型评测Chatbot Arena放榜!阿里Qwen3-235B-A22B-Instruct-2507位列大语言模型总榜第三,月之暗面Kimi-K2-0711-preview、深度求索DeepSeek-R1-0528并列为总榜第五,以开源之姿超越Claude 4、GPT-4.1等顶尖闭源模型。

AI 科技评论独家获悉,近日盛大网络挖角清华大学电子工程系副教授代季锋,正在筹备一家新的 AGI 公司,号称“对标 DeepSeek”,已有多位技术人才被猎头接触、介绍该团队的工作机会。

2025 年已过半,今年的大模型热度明显下降,关于基础模型的关注大多收敛到了 DeepSeek 与阿里通义上。相比之下,曾一度被标榜为大模型“国产替代”、信创之光的智谱 AI 所受到的关注度明显下降,过往高调的战略打法也渐显低迷。

提出一个真正好的猜想,比解决它更难。这是谷歌DeepMind首席执行官哈萨比斯(Demis Hassabis)在莱克斯(Lex Fridman)最新对谈中的感慨。他同时也是2024年诺贝尔化学奖的得主,带队开发出了能够高精度预测蛋白质的三维结构的AlphaFold系列模型。

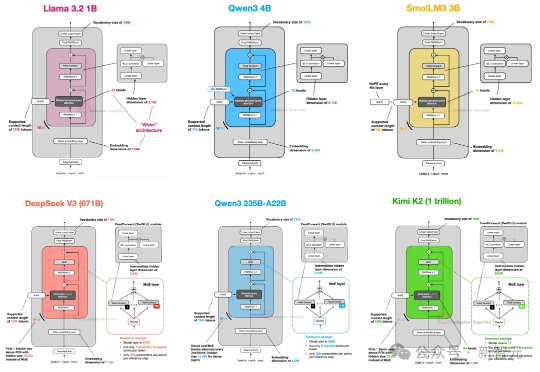

从GPT-2到DeepSeek-V3和Kimi K2,架构看似未变,却藏着哪些微妙升级?本文深入剖析2025年顶级开源模型的创新技术,揭示滑动窗口注意力、MoE和NoPE如何重塑效率与性能。

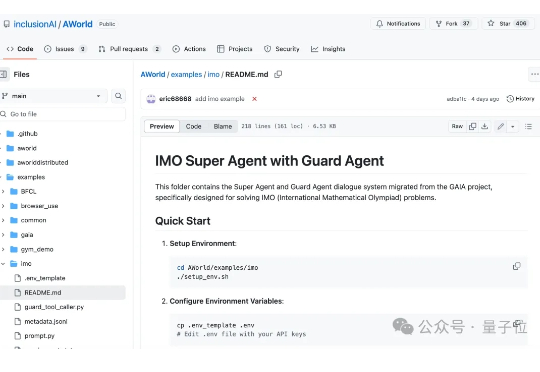

2025年的IMO,好戏不断。 7月19日,全世界顶尖大模型在2025年的IMO赛场上几乎全军覆没。时隔1天,OpenAI、DeepMind等顶尖实验室就在IMO 2025赛场斩获5/6题,震惊数学圈。

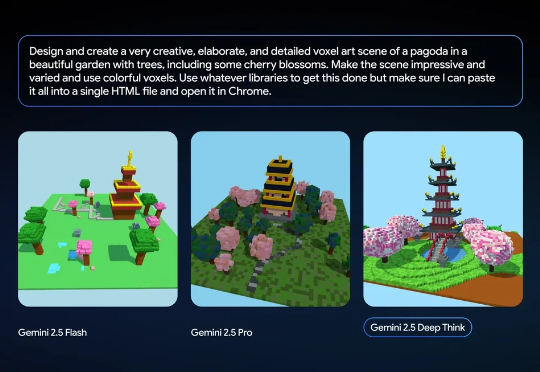

网友:Deep Think 简直太疯狂了。本周五,谷歌宣布向 Google AI Ultra 订阅用户推出 Deep Think 功能,并将全版本的 Gemini 2.5 Deep Think 模型(用于 IMO 竞赛)提供给部分数学家使用。