SPIRAL:零和游戏自对弈成为语言模型推理训练的「免费午餐」

SPIRAL:零和游戏自对弈成为语言模型推理训练的「免费午餐」近年来,OpenAI o1 和 DeepSeek-R1 等模型的成功证明了强化学习能够显著提升语言模型的推理能力。通过基于结果的奖励机制,强化学习使模型能够发展出可泛化的推理策略,在复杂问题上取得了监督微调难以企及的进展。

近年来,OpenAI o1 和 DeepSeek-R1 等模型的成功证明了强化学习能够显著提升语言模型的推理能力。通过基于结果的奖励机制,强化学习使模型能够发展出可泛化的推理策略,在复杂问题上取得了监督微调难以企及的进展。

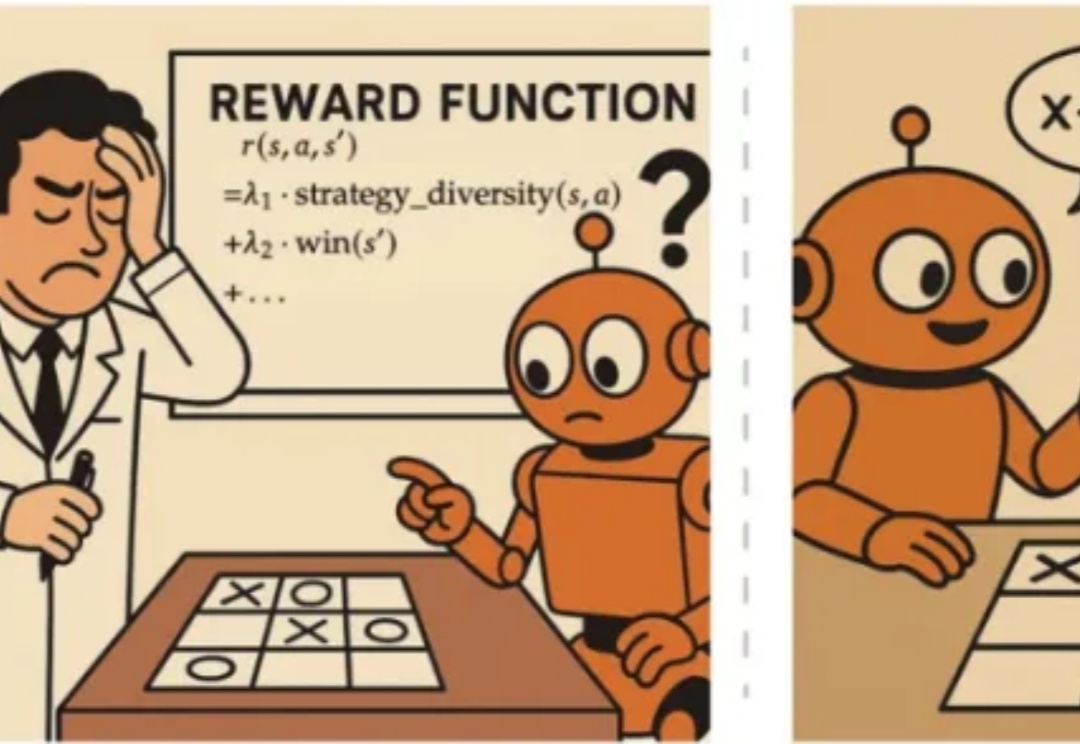

ShowMeAI 参与了腾讯新闻热问年中《DeepSeek半年之后》专题策划,回顾上半年 AI 发展以及对多个行业的影响。

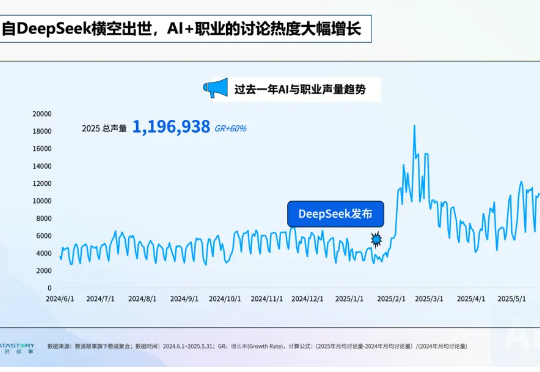

ACL 是计算语言学和自然语言处理领域的顶级国际会议,由国际计算语言学协会组织,每年举办一次。一直以来,ACL 在 NLP 领域的学术影响力都位列第一,它也是 CCF-A 类推荐会议。今年的 ACL 大会已是第 63 届,于 2025 年 7 月 27 日至 8 月 1 日在奥地利维也纳举行。

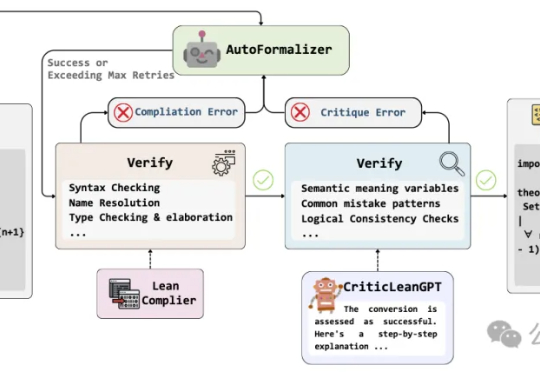

当人工智能已经能下围棋、写代码,如何让机器理解并证明数学定理,仍是横亘在科研界的重大难题。

在社交平台上,「AI 帮我选基金,结果赚了 8%」、「AI 自动炒股,秒杀巴菲特?」之类的帖子不时刷屏,炒股机器人、对话式理财助手有关的 Agent 也不断涌现。

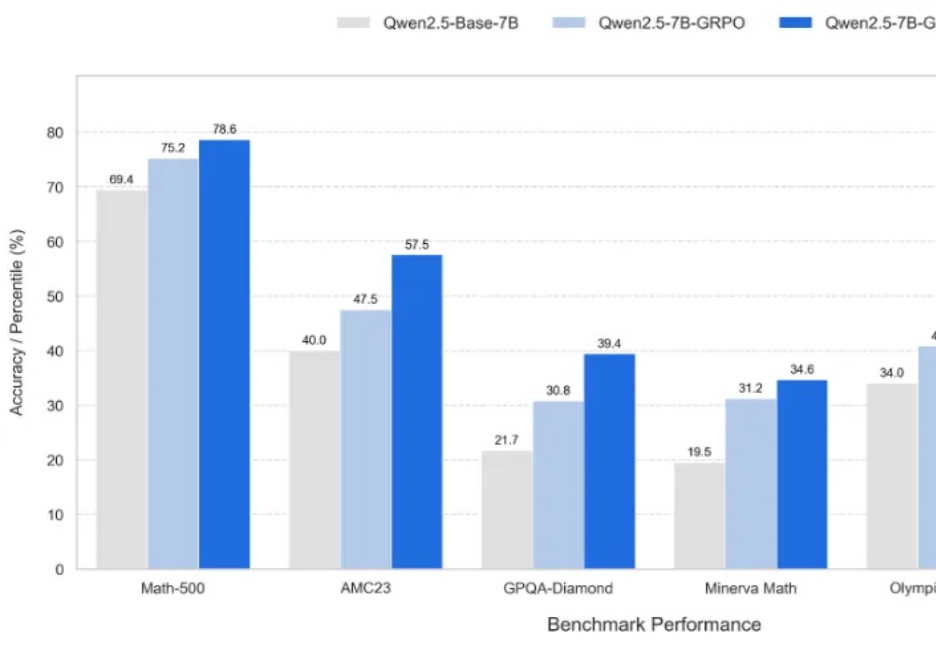

新一代大型推理模型,如 OpenAI-o3、DeepSeek-R1 和 Kimi-1.5,在复杂推理方面取得了显著进展。该方向核心是一种名为 ZERO-RL 的训练方法,即采用可验证奖励强化学习(RLVR)逐步提升大模型在强推理场景 (math, coding) 的 pass@1 能力。

AI四小强(如MiniMax、月之暗面)在黄仁勋认可下重新入局,全推出Deep Research抢占AI Agent市场。面对大厂竞争,他们放弃用户规模追逐,转向技术迭代如模型升级(K2、M1等),并分化两种路径操作。需通过出圈应用证明价值,应对成本高、增长放缓的盈利压力。

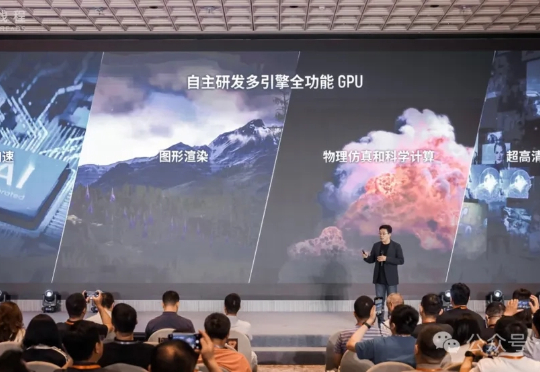

放眼当下,到底哪个芯片跑满血DeepSeek是最快的? 答案很意外——不是你以为的英伟达,而是一家国产GPU。 因为现在它的速度,已经直接来到了100 tokens/s!

谷歌DeepMind不信邪。 这不前脚,谷歌刚获IMO金牌,小扎就光速挖走三名核心团队成员。 如此抓马又无语,更多人都劝谷歌DeepMind小心点儿吧,要不以后论文署名都匿名吧,实在不行学习中国互联网公司用花名吧……

前两周,广东某国企发了篇万字标文,以预算四十万招标一台DeepSeek一体机。 近乎30页的文档里,采购明细表短短6行,所需的芯片类型等关键指标,只字未提。“看这个标就知道,大家完全没把一体机用起来”,业内人士直言。