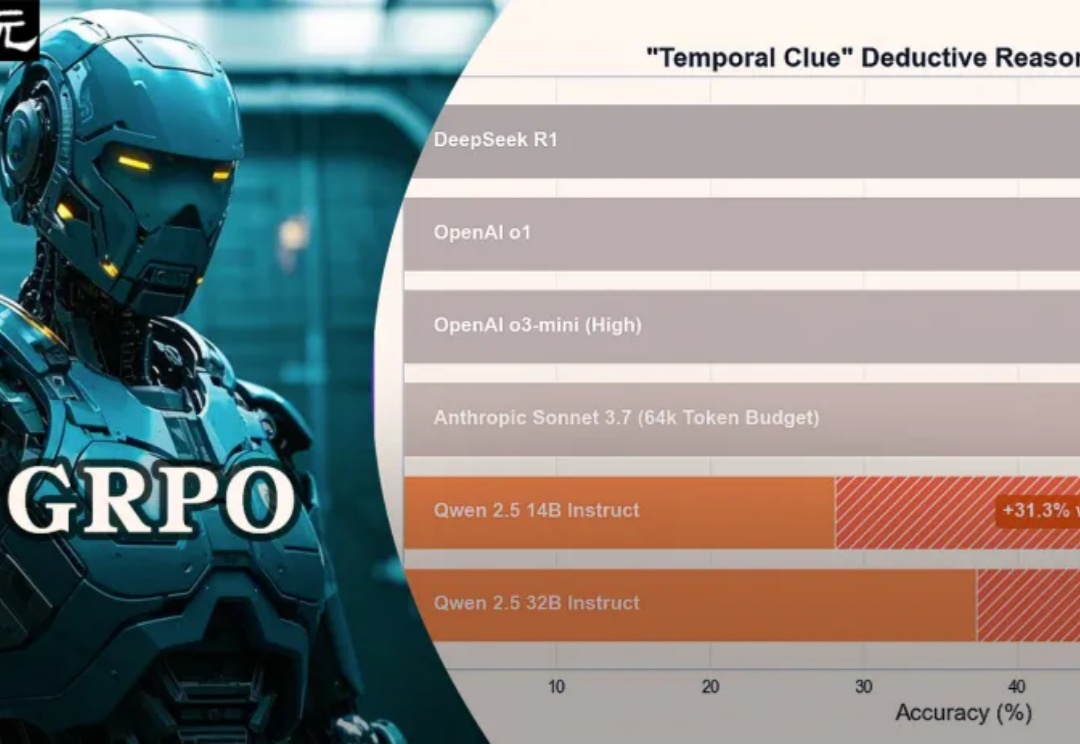

32B击败DeepSeek-R1、o3-mini,成本暴降100倍!GRPO让小模型称霸推理

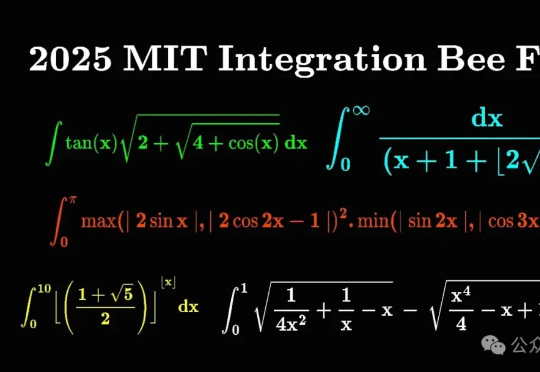

32B击败DeepSeek-R1、o3-mini,成本暴降100倍!GRPO让小模型称霸推理32B小模型在超硬核「时间线索」推理谜题中,一举击败了o1、o3-mini、DeepSeek-R1,核心秘密武器便是GRPO,最关键的是训练成本暴降100倍。

32B小模型在超硬核「时间线索」推理谜题中,一举击败了o1、o3-mini、DeepSeek-R1,核心秘密武器便是GRPO,最关键的是训练成本暴降100倍。

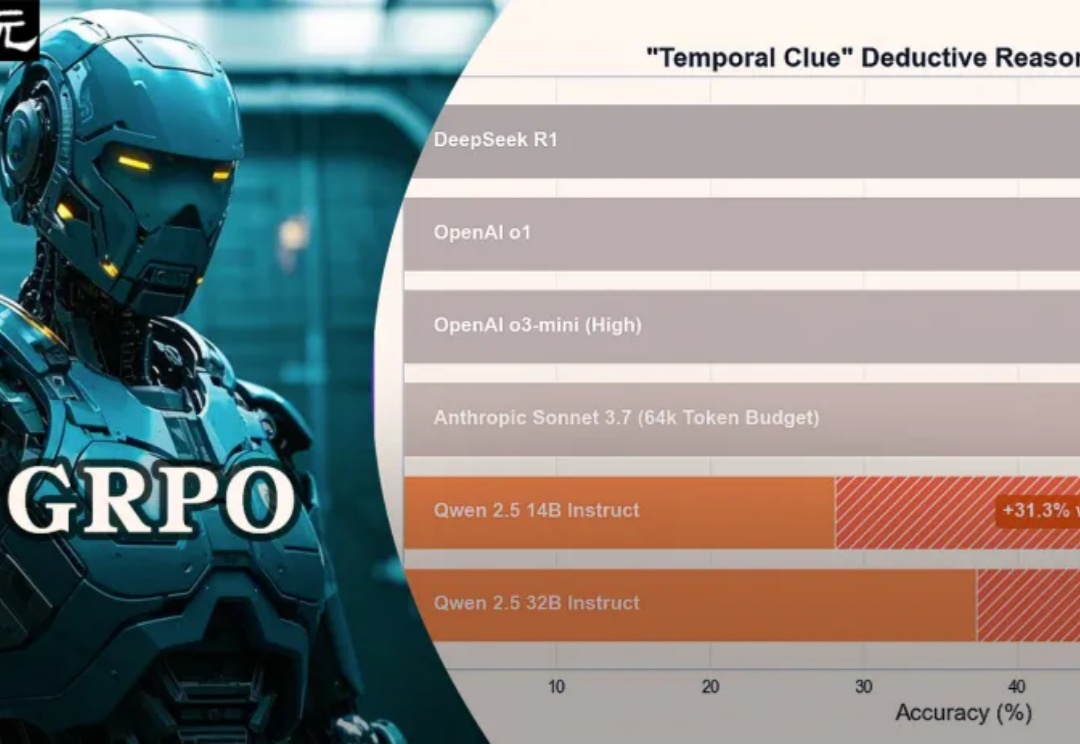

随着 DeepSeek-R1 的流行与 AI4Math 研究的深入,大模型在辅助形式化证明写作方面的需求日益增长。作为数学推理最直接的应用场景,形式化推理与验证(formal reasoning and verification),也获得持续关注。

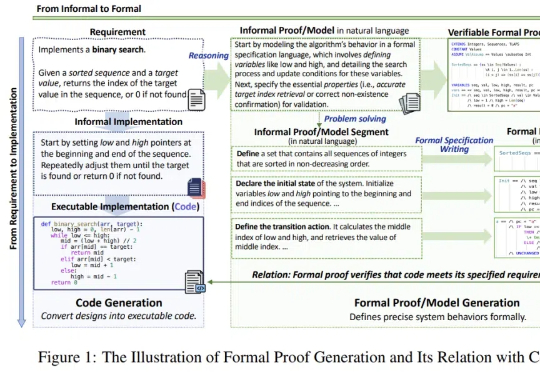

自媒体的反应堪称狂热:“通用Agent终于实现了!”“这是继DeepSeek之后的又一技术革命!”这样夸张的赞誉随处可见。从Benchmark来看,它的表现确实非常亮眼,在GAIA测试中超越了之前的各种Agent以及OpenAI的DeepResearch。

要做「AI编程助手界的Waymo」

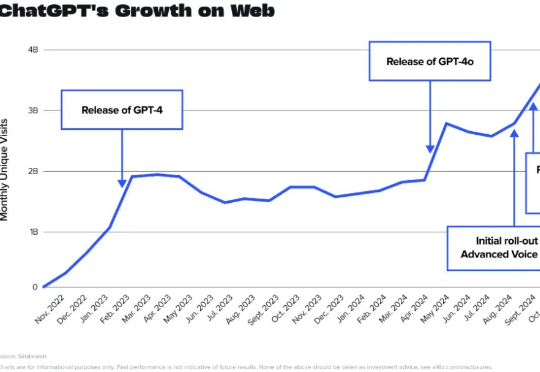

短短六个月,面向消费者的生成式 AI 市场已发生翻天覆地的变化。一些产品迅速崭露头角,另一些却止步不前,还有意外的黑马一跃成为行业领跑者。

见识过32B的QwQ追平671的DeepSeek R1后——刚刚,7B的DeepSeek蒸馏Qwen模型超越o1又是怎么一回事?新方法LADDER,通过递归问题分解实现AI模型的自我改进,同时不需要人工标注数据。

仅仅过了一天,阿里开源的新一代推理模型便能在个人设备上跑起来了!昨天深夜,阿里重磅开源了参数量 320 亿的全新推理模型 QwQ-32B,其性能足以比肩 6710 亿参数的 DeepSeek-R1 满血版。

知名风险投资公司 Andreessen Horowitz (a16z) 周四刚刚发布了新报告。报告发现,ChatGPT 用了 9 个月的时间从 2023 年 11 月的每周 1 亿活跃用户增长到 2024 年 8 月的 2 亿,但现在该应用程序只用了不到六个月的时间就再次将这一数字翻了一番。

让人感到非常费解的是,在这些媒体口中如此“王炸”的 AI 突破,在海外几乎没有什么讨论,这与 DeepSeek 墙内开花墙外香,海外各路 AI 大神们甘当自来水疯狂吹爆的现象形成了巨大的反差

只有享不了的福,\x0d\x0a没有受不了的罪。