DeepMind内部视角揭秘!Scaling Law没死,算力即一切

DeepMind内部视角揭秘!Scaling Law没死,算力即一切2026年,Scaling Law是否还能继续玩下去?对于这个问题,一篇来自DeepMind华人研究员的万字长文在社交网络火了:Scaling Law没死!算力依然就是正义,AGI才刚刚上路。

2026年,Scaling Law是否还能继续玩下去?对于这个问题,一篇来自DeepMind华人研究员的万字长文在社交网络火了:Scaling Law没死!算力依然就是正义,AGI才刚刚上路。

最近,APPSO 终于拿到了这台来自黄仁勋倾情推荐的个人超算,英伟达 DGX Spark;到手的第一感觉,就是「小而美」。这电脑也太小了,没有 Mac Studio 那般笨重,可能就和 Mac Mini 差不多大;然后是银色的亮和用来散热的金属丝网又让它有点不一样,是专属的硬核美感。

你知道吗,DeepSeekTwitter、Mac、Qwen,最初都只是副项目?真正改变世界的产品,可能根本不在公司的PPT路线图上。

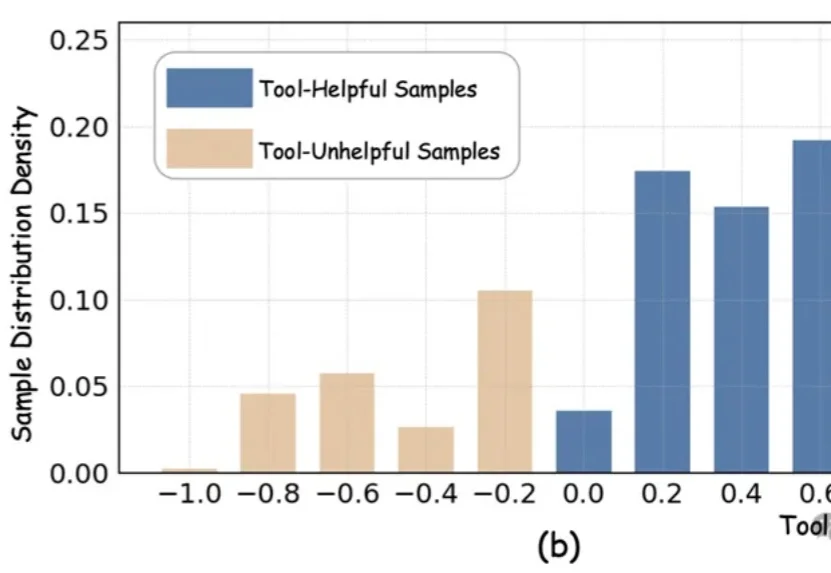

近期,以DeepEyes、Thymes为代表的类o3模型通过调用视觉工具,突破了传统纯文本CoT的限制,在视觉推理任务中取得了优异表现。

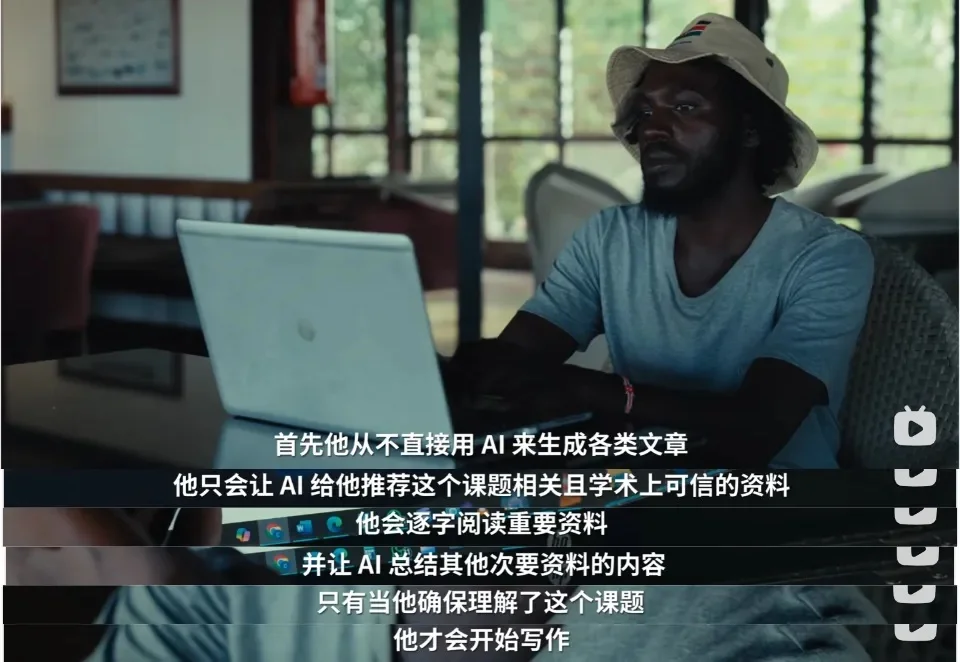

这两天,影视飓风那支《带着100万...我们去了论文代写聚集地》的视频彻底火了。大众的目光都被肯尼亚贫民窟里庞大的“论文代写产业链”所吸引,2.5美元的廉价劳动力、流水线般的学术欺诈。

世界模型的场景,不止在自动驾驶方面。 极客公园近期接触到的 Deep Optica,刚刚完成由 BV 百度风投、零以创投参与的种子轮融资,正试图从「判断方式」本身入手,为这一高度不确定的过程提供一种更加结构化的路径。

好震惊,好意外,现在一份4–6个月的AI相关实习,月薪已经接近14万人民币了!而且这个价格不是个例——OpenAI、Anthropic、Meta、Google DeepMind等巨头,都为实习、Fellowship、Residency这类短期岗位,开出足以对标全职研究员的价格。

能自动查数据、写分析、画专业金融图表的AI金融分析师来了!最近,中国人民大学高瓴人工智能学院提出了一个面向真实金融投研场景的多模态研报生成系统——玉兰·融观(Yulan-FinSight)。

现在生成一个视频,比你刷视频还要快。

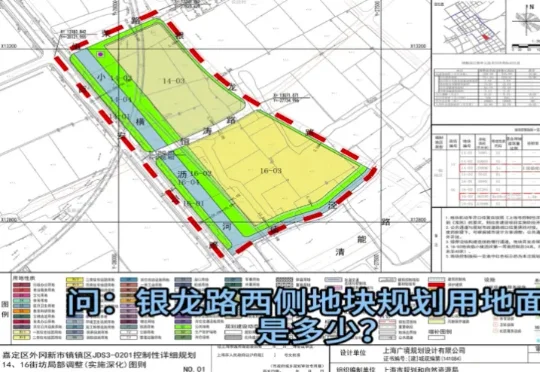

近日,由上海市规划资源局与商汤大装置联合打造的全国规划资源领域首个基础大模型“云宇星空大模型”(专业版)上线。这并非一个简单的对话机器人,而是一个6000亿参数、深度嵌入规资全业务系统的行业大模型:它能调取地图、做统计,能理解规划图纸、会写报告,覆盖从知识检索、空间分析到决策支撑的完整工作闭环。