DeepSeek-V3.1适配下一代国产芯片引爆市场,大模型这次和哪些国产芯一起“自主可控”?

DeepSeek-V3.1适配下一代国产芯片引爆市场,大模型这次和哪些国产芯一起“自主可控”?DeepSeek发布DeepSeek-V3.1,使用的UE8M0 FP8 Scale针对下一代国产芯片设计

DeepSeek发布DeepSeek-V3.1,使用的UE8M0 FP8 Scale针对下一代国产芯片设计

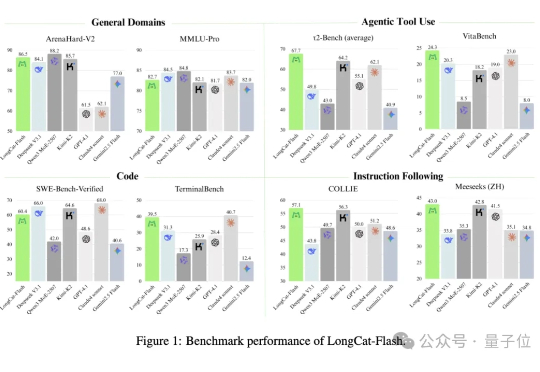

没想到啊,最新SOTA的开源大模型…… 来自一个送外卖(Waimai)的——有两个AI,确实不一样。 这个最新开源模型叫:Longcat-Flash-Chat,美团第一个开源大模型,发布即开源,已经在海内外的技术圈子里火爆热议了。

上周三,DeepSeek 开源了新的基础模型,但不是万众期待的 V4,而是 V3.1-Base,而更早时候,DeepSeek-V3.1 就已经上线了其网页、App 端和小程序。

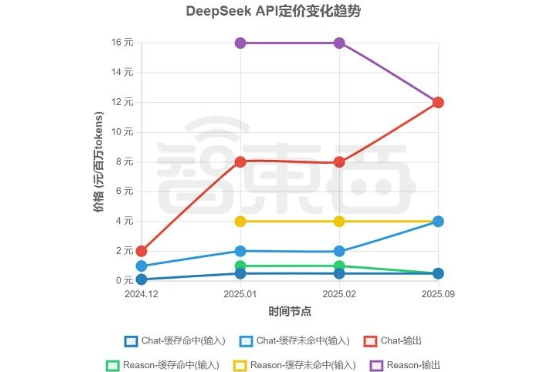

DeepSeek涨价了。 智东西8月23日报道,8月21日,DeepSeek在其公众号官宣了DeepSeek-V3.1的正式发布,还宣布自9月6日起,DeepSeek将执行新价格表,取消了今年2月底推出的夜间优惠,推理与非推理API统一定价,输出价格调整至12元/百万tokens。这一决定,让使用DeepSeek API的最低价格较过去上升了50%。

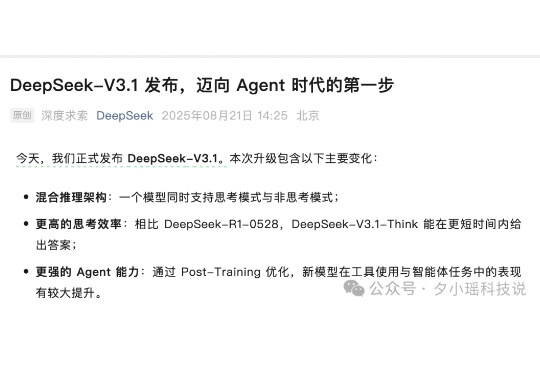

今天下午,DeepSeek 官方正式发布 DeepSeek-V3.1。相比于前天只在用户群里通知,今天新增了模型升级点、榜单成绩、model card,huggingface 上现在也可以下载模型文件了。

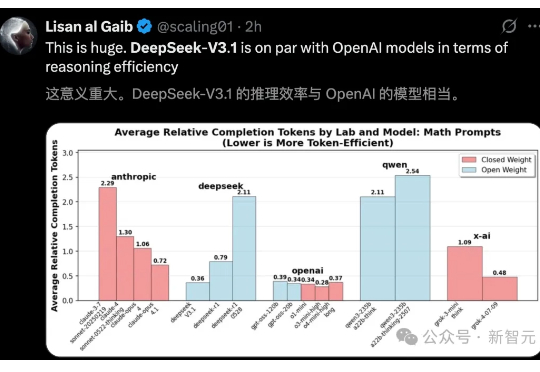

DeepSeek-V3.1官宣了,作为首款「混合推理」模型,将开启智能体新时代。新模型共有671B参数,编码实力碾压DeepSeek-R1、Claude 4 Opus,登顶编程开源第一。

自从 GPT-5 发布后,DeepSeek 创始人梁文锋就成了 AI 圈最「忙」的人。

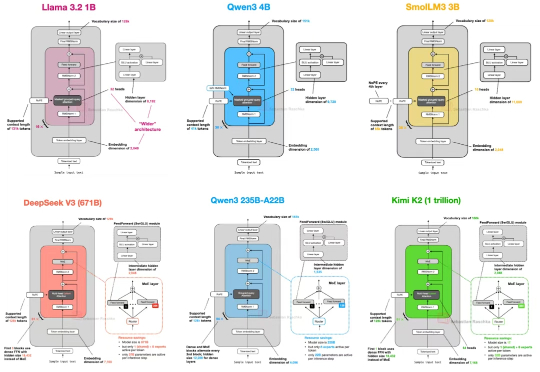

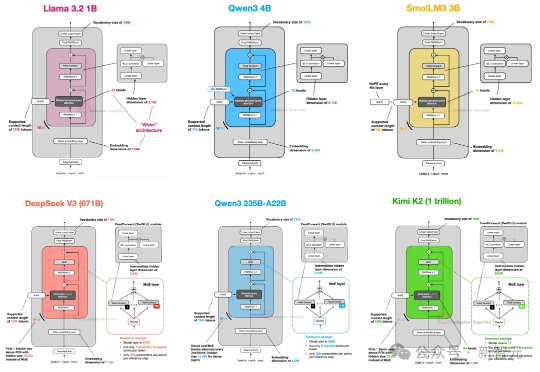

自首次提出 GPT 架构以来,转眼已经过去了七年。 如果从 2019 年的 GPT-2 出发,回顾至 2024–2025 年的 DeepSeek-V3 和 LLaMA 4,不难发现一个有趣的现象:尽管模型能力不断提升,但其整体架构在这七年中保持了高度一致。

从GPT-2到DeepSeek-V3和Kimi K2,架构看似未变,却藏着哪些微妙升级?本文深入剖析2025年顶级开源模型的创新技术,揭示滑动窗口注意力、MoE和NoPE如何重塑效率与性能。

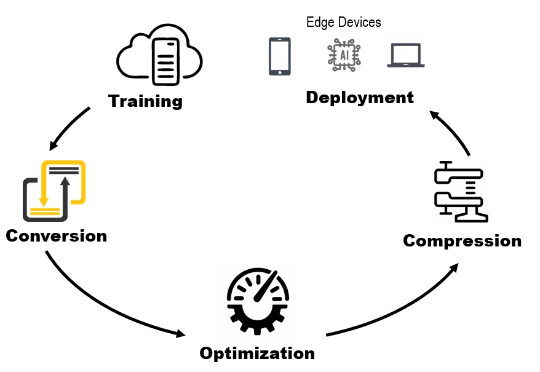

为什么 DeepSeek-V3 据说在大规模服务时快速且便宜,但本地运行时却太慢且昂贵?为什么有些 AI 模型响应很慢,但一旦开始运行就变得很快?