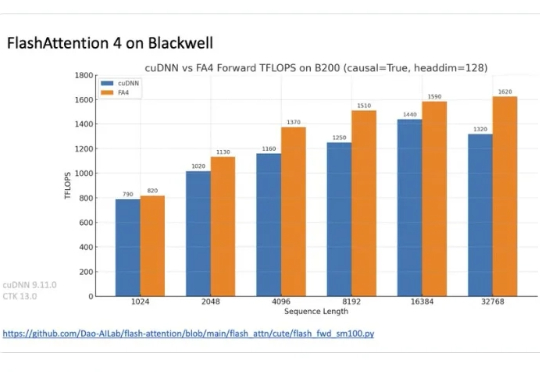

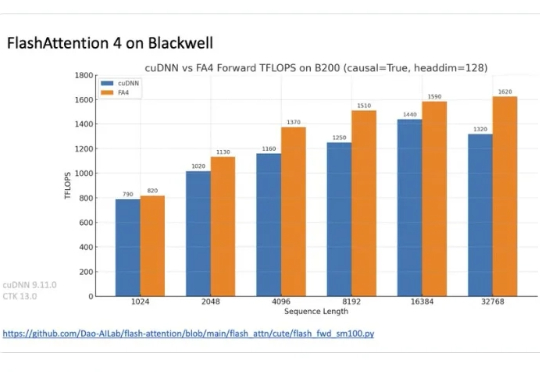

FlashAttention-4震撼来袭,原生支持Blackwell GPU,英伟达的护城河更深了?

FlashAttention-4震撼来袭,原生支持Blackwell GPU,英伟达的护城河更深了?在正在举办的半导体行业会议 Hot Chips 2025 上,TogetherAI 首席科学家 Tri Dao 公布了 FlashAttention-4。

在正在举办的半导体行业会议 Hot Chips 2025 上,TogetherAI 首席科学家 Tri Dao 公布了 FlashAttention-4。

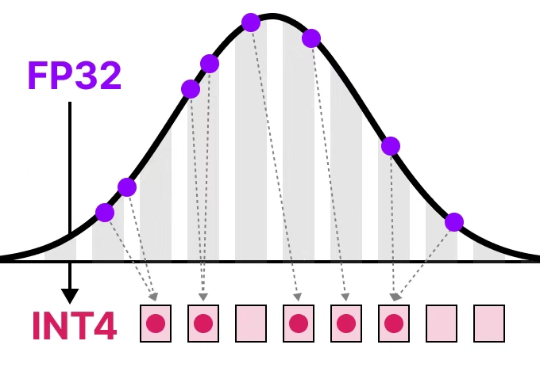

清华大学朱军教授团队提出SageAttention3,利用FP4量化实现推理加速,比FlashAttention快5倍,同时探索了8比特注意力用于训练任务的可行性,在微调中实现了无损性能。

又快又准,即插即用!清华8比特量化Attention,两倍加速于FlashAttention2,各端到端任务均不掉点!

用 FlexAttention 尝试一种新的注意力模式。

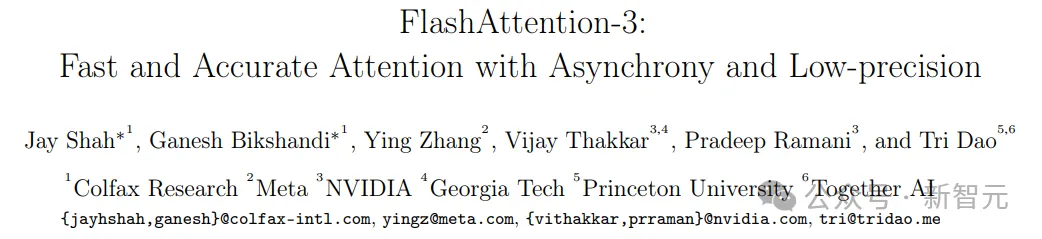

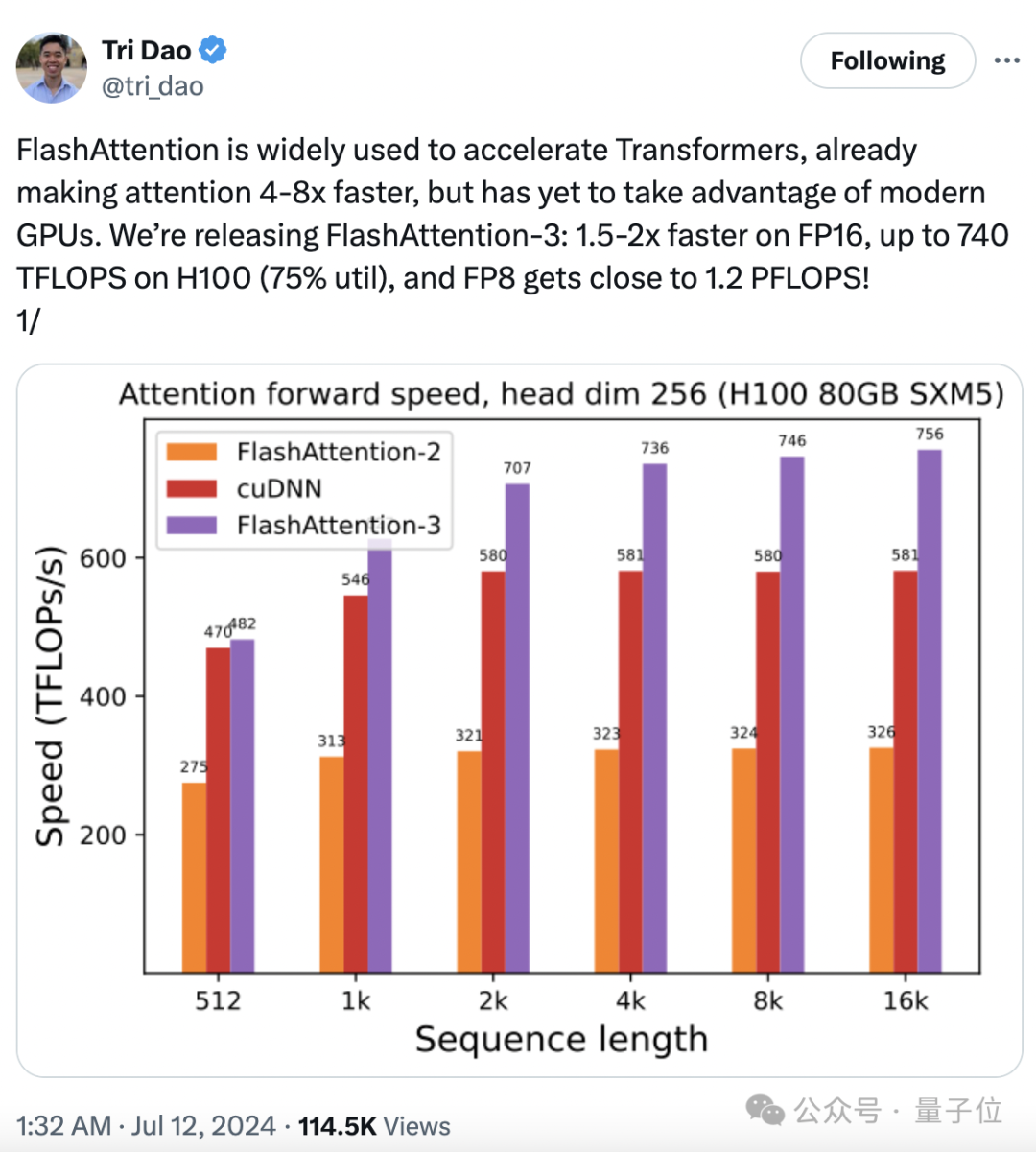

740 TFLOPS!迄今最强 FlashAttention 来了。

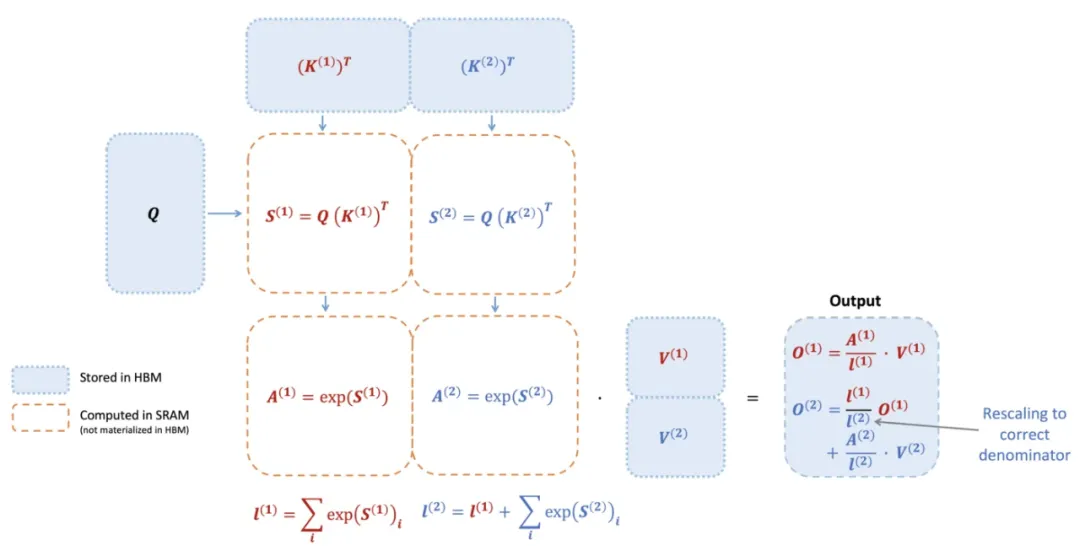

时隔一年,FlashAttention又推出了第三代更新,专门针对H100 GPU的新特性进行优化,在之前的基础上又实现了1.5~2倍的速度提升。

大模型训练推理神作,又更新了!

AI算力资源越发紧张的当下,斯坦福新研究将GPU运行效率再提升一波——

Hyena处理长序列输入比FlashAttention速度高100倍!最新发布的StripedHyena模型可能成下一代AI架构的新标准?

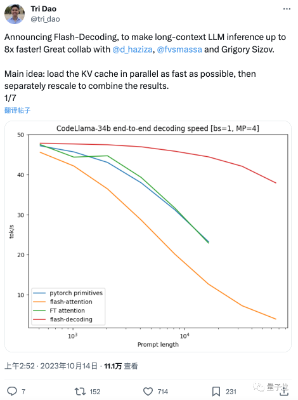

这两天,FlashAttention团队推出了新作: 一种给Transformer架构大模型推理加速的新方法,最高可提速8倍。 该方法尤其造福于长上下文LLM,在64k长度的CodeLlama-34B上通过了验证